03.12.2025 à 16:54

Quand des robots invisibles influencent nos choix et nos opinions

Texte intégral (2583 mots)

À chaque fois que nous cliquons sur une étoile pour évaluer un restaurant, que nous laissons un commentaire sur un site marchand ou que nous « likons » une vidéo, nous déposons une trace numérique. Individuellement, cela peut sembler insignifiant, un simple petit signe de préférence, une micro-opinion parmi tant d’autres. Mais collectivement, ces traces forment un vaste paysage social, un nuage de signaux visibles et persistants, qui influence profondément nos comportements.

Ces indices diffus, agrégés par des plateformes et amplifiés par des algorithmes, fonctionnent comme une mémoire partagée. Ils nous disent ce qui est populaire, digne de confiance ou au contraire suspect. Le phénomène est si puissant que les biologistes et les physiciens l’ont rapproché d’un mécanisme bien connu dans le monde animal : la stigmergie. Ce concept introduit à la fin des années 1950 par l’entomologiste Pierre-Paul Grassé pour expliquer la construction collective du nid chez les termites, décrit la coordination indirecte entre les individus grâce aux traces que ceux-ci laissent dans l’environnement. Chez les insectes sociaux, une boulette de terre imprégnée de phéromone de construction et déposée à un endroit attire d’autres ouvrières qui viendront ajouter la leur, entraînant la formation d’un pilier puis d’un dôme.

Dans le monde numérique, un commentaire enthousiaste, une série d’évaluations cinq étoiles ou la viralité d’un hashtag jouent un rôle similaire : ils incitent d’autres personnes à adopter un comportement convergent. Ainsi, sans qu’il y ait besoin d’un chef d’orchestre, des milliers d’actions individuelles peuvent se combiner pour produire un comportement collectif cohérent. Mais ce mécanisme fascinant comporte un revers. Car si la stigmergie favorise la coopération et l’intelligence collective, elle ouvre aussi la porte à la manipulation et à la tromperie. Que se passe-t-il lorsque certains individus, ou des programmes automatiques, déposent des traces biaisées ou mensongères ?

Les travaux que nous avons réalisés au Centre de recherches sur la cognition animale, en collaboration avec le Laboratoire de physique théorique et l’École d’économie à Toulouse nous plongent au cœur de cette question à la croisée de l’éthologie, de l’économie comportementale et de la science des systèmes complexes. Nos études expérimentales ont révélé comment, dans des environnements numériques contrôlés, les humains exploitent, détournent ou subissent l’influence de ces traces. Elles montrent, de manière saisissante, que même de simples robots logiciels, dépourvus de toute sophistication, peuvent réorienter en profondeur la dynamique de coopération d’un groupe humain.

Quand la coopération devient fragile face à la compétition

La première série d’expériences, publiée en 2023, avait pour but d’examiner dans quelles conditions la stigmergie favorise ou non la coopération entre humains. Pour cela, nous avons conçu une expérience dans laquelle des groupes de cinq participants étaient invités à explorer une même grille de 225 cases numériques, chacune contenant une valeur cachée comprise entre 0 et 99 réparties aléatoirement. Leur objectif était de trouver les cases aux plus fortes valeurs.

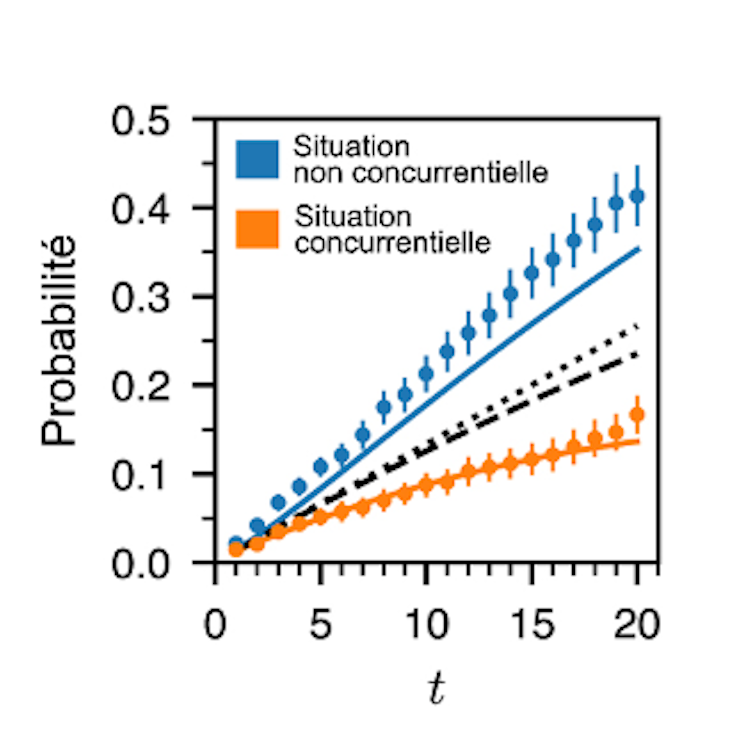

Chaque fois qu’un joueur découvrait une case, il devait lui attribuer une note sur cinq étoiles, exactement comme on le fait pour un produit en ligne. Après que tous les sujets aient ouvert et noté les cases, chacune des cases des tableaux explorés par chaque groupe initialement de couleur blanche, adoptait différentes tonalités de rouge dont l’intensité dépendait du pourcentage d’étoiles ayant été déposées dans la case par tous les sujets au cours des itérations précédentes. Ces traces de couleurs étaient visibles par tous les membres du groupe et constituaient ainsi une mémoire collective de leurs actions passées. L’expérience s’achevait au bout de vingt itérations et la somme des valeurs des cases visitées par chaque sujet au cours de toutes les itérations déterminait le score de celui-ci.

Or, deux règles de jeu différentes étaient proposées. Dans la version non compétitive, le score cumulé des joueurs au terme d’une série de dix expériences n’affectait pas le montant de leur rémunération en fin d’expérience qui était identique pour tous, chaque participant gagnant 10 euros. Dans la version compétitive, en revanche, chaque point comptait car le gain final (entre 10 euros et 20 euros) dépendait de la somme des valeurs découvertes qui déterminait le classement des joueurs. Ces derniers étaient donc mis en concurrence pour obtenir la meilleure récompense.

Les résultats ont montré que dans la condition sans compétition, les individus avaient tendance à noter les cases de manière proportionnelle à leur valeur, offrant aux autres une information fidèle et donc utile. La coopération émergeait spontanément. En exploitant les traces laissées par les uns et les autres, le groupe parvenait à identifier collectivement les meilleures cases, bien au-delà de ce qu’un individu isolé aurait pu espérer. Mais dès que la compétition entrait en jeu, tout changeait. Beaucoup de participants se mettaient à tricher subtilement, ils visitaient des cases de forte valeur mais leur attribuaient une mauvaise note, afin de ne pas attirer l’attention des autres. D’autres adoptaient des stratégies neutres, attribuant des notes aléatoires ou uniformes pour brouiller les pistes. Ainsi la mémoire collective devenait peu fiable, et la coopération s’effritait.

L’analyse fine des comportements permit d’identifier trois profils distincts : les collaborateurs, qui partagent honnêtement l’information ; les neutres, qui laissent des signaux ambigus ; et les trompeurs, qui induisent délibérément les autres en erreur. Dans un contexte compétitif, la proportion de trompeurs explose. Ce basculement montre que la coopération humaine fondée sur les traces est hautement contextuelle. Elle peut surgir naturellement lorsqu’il n’y a rien à perdre à partager, mais elle s’évapore dès que l’intérêt individuel pousse à garder pour soi ou à induire les autres en erreur. Cette ambivalence se retrouve dans de nombreux environnements en ligne, où les évaluations sincères cohabitent avec les commentaires mensongers, les faux avis ou le spam organisé.

Quand des robots sociaux s’invitent dans la partie

La deuxième étude, réalisée en 2022 et aujourd’hui en cours de publication, pousse l’expérience encore plus loin en introduisant de nouveaux acteurs : de simples bots programmés (un bot est une application logicielle automatisée qui exécute des tâches répétitives sur un réseau). Dans cette expérience nous avons repris le même dispositif de la grille à explorer et du système d’évaluation, mais cette fois-ci, chaque participant humain jouait avec quatre « partenaires » qui n’étaient pas des humains, même si les joueurs l’ignoraient. Ces partenaires étaient des bots adoptant des comportements prédéfinis. Certains collaboraient en notant fidèlement les cases, d’autres trichaient systématiquement, d’autres encore restaient neutres, et enfin un dernier type cherchait à optimiser la performance collective. L’idée était de tester si la présence de ces agents artificiels, pourtant rudimentaires pouvait influencer la stratégie des humains dans une situation compétitive.

Les résultats furent spectaculaires. Dans les groupes où les bots se montraient coopératifs, les humains réussissaient mieux, ils découvraient davantage de cases de grande valeur et obtenaient de meilleurs scores. Mais ce climat de confiance favorisait aussi l’émergence de comportements opportunistes ; ainsi certains participants se mettaient à tricher davantage, profitant de la fiabilité des traces laissées par les bots. À l’inverse, dans les groupes saturés de bots trompeurs, les participants s’adaptaient en devenant plus coopératifs ou neutres, comme s’ils tentaient de préserver un minimum de signal exploitable dans un océan de bruit.

L’influence des bots était si forte que la seule composition du groupe (quatre bots coopératifs, ou trois trompeurs et un coopérateur, etc.) suffisait à prédire les performances globales. Plus étonnant encore, lorsqu’on comparait les performances de cinq humains jouant ensemble à celles de groupes mixtes humains-bots, les groupes intégrant certains bots conçus pour optimiser la performance collective s’en sortaient beaucoup mieux que les groupes purement humains. Dans ces situations, la présence des bots incitait les participants à adopter un profil de collaborateur alors même qu’ils étaient en compétition.

Entre intelligence collective et risques de manipulation

Ces expériences, bien qu’effectuées en laboratoire avec des grilles de nombres, résonnent fortement avec notre quotidien numérique saturé de traces et de signaux automatiques. À la lumière des conclusions, on peut s’interroger pour savoir à quel point nos choix collectifs sont déjà façonnés par des agents invisibles. Ces expériences montrent que la stigmergie, ce mécanisme de coordination indirecte, fonctionne aussi chez nous humains, et pas seulement chez les termites ou les fourmis. Elles révèlent aussi sa fragilité. La coopération née des traces est toujours menacée par la tentation de la tromperie, amplifiée par la compétition ou la présence d’agents biaisés. Dans un monde où les plateformes en ligne reposent massivement sur les systèmes d’évaluation, de notation et de recommandation, ces résultats invitent à une réflexion urgente. Car derrière chaque note et chaque commentaire peuvent se cacher non seulement des stratégies humaines égoïstes, mais aussi des bots capables de biaiser l’opinion collective.

Cependant il ne s’agit pas uniquement de dénoncer les manipulations malveillantes, des faux avis pour booster un produit, des campagnes de désinformation orchestrées par des armées de bots, mais aussi de réfléchir aux usages potentiellement prosociaux de ces mêmes agents. Comme le montrent également nos expériences, des bots bien conçus peuvent au contraire favoriser la coopération, stabiliser les dynamiques collectives et même améliorer la performance d’un groupe. Encore faut-il savoir les intégrer de façon transparente et éthique, en évitant qu’ils ne deviennent des instruments de tromperie.

Ces travaux rappellent que nous vivons désormais dans des écosystèmes hybrides, où humains et agents artificiels cohabitent et interagissent sans cesse à travers les traces numériques. Comprendre comment ces interactions façonnent notre intelligence collective est un défi majeur pour la recherche interdisciplinaire. Mais c’est aussi un enjeu citoyen, car de la manière dont nous régulerons, concevrons et utiliserons ces traces et ces bots dépendra la qualité de nos coopérations futures et peut-être même la santé de nos démocraties numériques.

Cet article a été proposé en partenariat avec le colloque « Les propagations, un nouveau paradigme pour les sciences sociales ? » (à Cerisy (Manche), qui s’est tenu du 25 juillet au 31 juillet 2025).

Guy Théraulaz ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Time [Fr]

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- L'Autre Quotidien

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- AlterQuebec

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview