12.01.2026 à 15:53

La Terre du Milieu de Tolkien, un lieu imaginaire pour repenser notre rapport à la nature

Texte intégral (2841 mots)

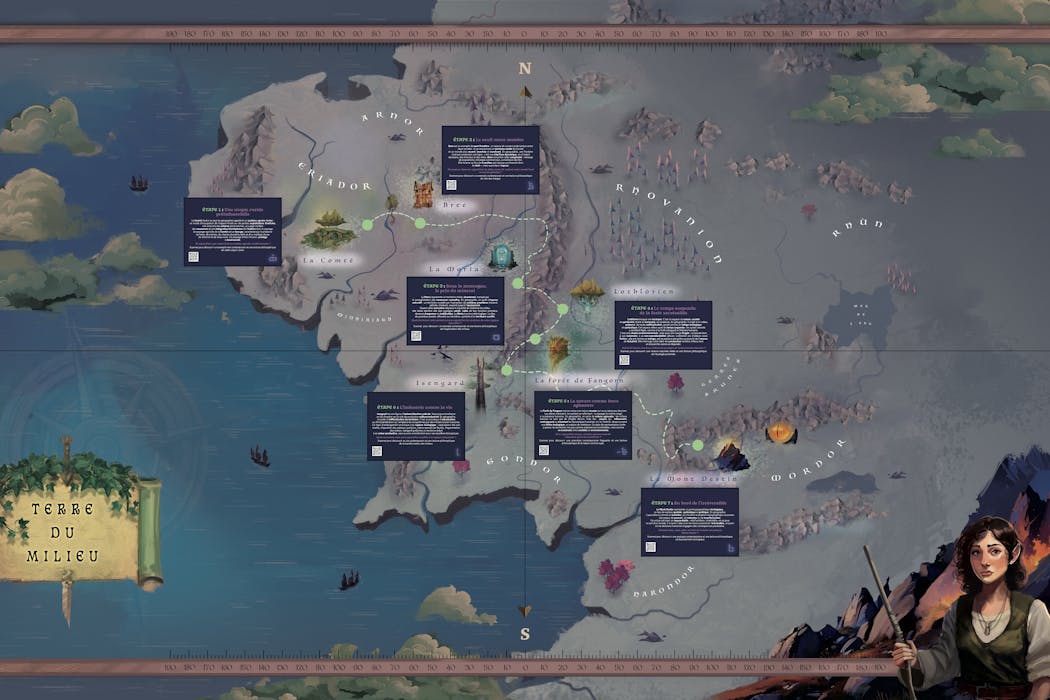

L’écrivain anglais J. R. R. Tolkien (1892-1973) était un cartographe de l’imaginaire. Dans le Seigneur des anneaux (1954-1955), il invente un monde dans lequel la frontière entre humanité et animalité est floue. Ses cartes de la Terre du Milieu construisent la cohérence spatiale et la densité narrative de la quête de la Communauté de l’anneau. Montagnes, forêts, rivières y constituent tantôt des épreuves spatiales, tantôt des espaces protecteurs ou de refuge. La géographie y structure le récit et façonne la fiction.

Les mondes imaginaires sont performatifs. Ils se nourrissent du réel dans une projection fictionnelle tout en l’interrogeant. Le Seigneur des anneaux n’y fait pas exception, nous invitant à réfléchir à nos liens avec la nature, à reconnaître sa valeur intrinsèque et à dépasser une conception dualiste opposant nature et culture, ne lui accordant qu’une valeur d’usage ou de ressource, à nous engager dans une éthique environnementale.

En suivant la Communauté, métissée, sur les chemins, parfois de traverse, les menant vers le mont Destin, nous sommes confrontés à différentes manières d’habiter et de transformer la nature : utopies rurales, zones industrieuses, refuges écologiques et lieux symboliques où des choix engagent l’avenir du monde. La fiction devient un outil pour questionner le réel, interroger nos pratiques et réfléchir aux enjeux environnementaux contemporains dans une ère désormais anthropocénique.

Habiter (avec) le monde : utopies rurales et résistance

La Comté repose sur un système agraire vivrier de polycultures fondé sur de petites exploitations familiales où le tabac réputé n’est que peu exporté. Les Hobbits vivent en autarcie et habitent littéralement une nature jardinée, dans des terriers. Le bocage, les prairies forment un maillage qui limite l’érosion et protège la biodiversité et organisent un territoire où nature et société coexistent harmonieusement. Cet idéal préindustriel s’éteint peu à peu dans le monde occidental moderne où une agriculture intensive et centralisée s’est imposée pour devenir norme sur un territoire remembré.

La forêt de Fangorn, elle, représente une nature qui résiste à la manière d’une zone à défendre (ZAD). Les Ents, gestionnaires du peuplement forestier, incarnent des arbres doués de parole, capables de révolte. Ils refusent la domination humaine fermant les sentiers d’accès avant de s’engager dans une guerre contre l’industrialisation menée par Saroumane en Isengard. Le chantier stoppé de l’autoroute A69 témoigne de la façon dont la nature peut parfois aujourd’hui par elle-même poser des limites aux projets d’aménagement voulus par l’humain.

La Lothlórien, enfin, symbolise une écotopie, un espace préservé du temps et des pressions humaines, où nature, société et spiritualité vivent en harmonie. La réserve intégrale de la forêt de la Massane, les forêts « sacrées » d’Afrique de l’Ouest ou celles du nord de la Grèce (massif du Pindes) font écho à cet idéal. Pensées comme des écosystèmes dont les dynamiques naturelles sont respectées et où l’intervention humaine contrôlée se fait discrète, elles permettent d’observer et de suivre les espèces, la régénération spontanée des habitats et leur résilience. Mais à l’image de la Lothlórien, un tel système de gestion reste spatialement rare, fragile. Il nécessite de construire la nature comme bien commun dont l’accès et l’usage sont acceptés par les communautés qui cohabitent avec ces espaces forestiers.

Ces trois types de territoires montrent qu’habiter le monde n’est pas simplement occuper, encore moins s’approprier, un espace de nature mais engager un dialogue avec lui, considérer qu’il a une valeur par lui-même, juste parce qu’il existe, et pas uniquement en tant que ressource. Il s’agit alors de cohabiter dans des interactions où chaque existant prend soin de l’autre.

Exploiter une nature ressource : de l’artificialisation à la destruction

La transformation des espaces de nature, comme le montre Tolkien, peut aussi répondre à une logique d’exploitation intensive, la nature offrant des ressources permettant d’asseoir la domination des humains sur la nature comme sur d’autres humains. Il ne s’agit plus d’envisager une cohabitation être humain/nature mais d’asservir la nature par la technique.

Isengard, le territoire de Saroumane au sud des monts Brumeux, contrôlé par la tour d’Orthanc, incarne la transformation radicale du milieu par et pour l’industrie ; une industrie dont la production d’Orques hybrides, sorte de transhumanisme appliqué à la sauvagerie, vise à renforcer le pouvoir de Saroumane et construire son armée pour prendre le contrôle d’autres territoires. La forêt est rasée, les fleuves détournés, le paysage mécanisé, dans l’unique but d’alimenter l’industrie. Les champs d’exploitation des schistes bitumineux en Amérique du Nord montrent à quel point l’exploitation de la nature peut détruire des paysages, polluer une nature qui devient impropre et dont les fonctions et services écosystémiques sont détruits).

La Moria, ancien royaume florissant du peuple Nain, est l’exemple de l’issue létale de la surexploitation d’une ressource naturelle. Si le mithril, minerai rare de très grande valeur a construit la puissance du royaume Nain, son exploitation sans cesse plus intense, vidant les profondeurs de la terre, va conduire à l’effondrement de la civilisation et à l’abandon de la Moria. Ce territoire minier en déshérence fait écho aux paysages des régions du Donbass par exemple, qui conservent aujourd’hui encore les traces visibles de décennies d’extraction charbonnière : galeries effondrées, sols instables et villes partiellement abandonnées.

Lieux de rupture et enjeux planétaires

On trouve enfin chez Tolkien une mise en scène d’espaces qui représentent des lieux de bascule pour l’intrigue et l’avenir du monde, en l’occurrence la Terre du Milieu.

Le « bourg-pont » de Bree, zone frontière matérialisée par une large rivière, marque la limite entre l’univers encore protégé, presque fermé, de la Comté et les territoires marchands de l’est, ouverts et instables. Mais Bree est aussi un carrefour dynamique, lieu d’échanges où circulent et se rencontrent des personnes, des biens et des récits. Un carrefour et une frontière où toutefois la tension et la surveillance de toutes les mobilités sont fortes.

Lieu de transition, symbolisant à la fois ouverture et fermeture territoriales, Bree est un point de bascule dans le récit où convergent et se confrontent des personnages clés de l’intrigue (les Hobbits, Aragorn, les cavaliers noirs de Sauron), les figures du Bien et du Mal autour desquelles vont se jouer l’avenir de la Terre du Milieu. Comme Bree, Calais est un point de friction entre un espace fermé (les frontières britanniques) et un espace ouvert où s’entremêlent société locale, logiques nationales et transnationales, mais où les circulations sont de plus en plus contrôlées.

Enfin, la montagne du Destin, volcan actif, incarne le lieu de rupture ultime, celui où le choix d’un individu, garder l’anneau pour lui seul dans un désir de pouvoir total ou accepter de le détruire, a des conséquences majeures pour toute la Terre du Milieu. Certains espaces jouent un rôle similaire sur notre terre. La fonte du permafrost sibérien ou de l’inlandsis antarctique pourrait libérer d’immenses quantités de carbone pour l’un, d’eau douce pour l’autre, accélérant le dérèglement climatique et la submersion de terres habitées.

Ces lieux où des actions localisées peuvent déclencher des effets systémiques globaux, au-delà de tout contrôle, concentrent ainsi des enjeux critiques, écologiques, géopolitiques ou symboliques.

La fiction constitue un puissant vecteur de réflexion quant à notre responsabilité collective dans la gestion de la nature, quant à nos choix éthiques et politiques dans la manière d’habiter la Terre en tant que bien commun et ainsi éviter d’atteindre un point de bascule qui sera celui d’un non-retour.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

11.01.2026 à 15:41

Après l’abattage de milliers de chevaux sauvages, le parc australien du Kosciuszko retrouve peu à peu ses paysages

Texte intégral (3521 mots)

Dans le parc national du Kosciuszko, la diminution de la population de brumbies, les chevaux sauvages, ouvre une chance de restauration pour les écosystèmes fragiles du massif. Celles et ceux qui parcourent le parc au quotidien en voient déjà les premiers effets.

Dans le parc national du Kosciuszko, en pleines Alpes australiennes, le paysage évolue lentement. Des zones de végétation, autrefois rasées par les chevaux, repoussent. Les berges de ruisseaux, longtemps érodées, paraissent moins tassées sur les bords. Les visiteurs croisent aussi moins de chevaux immobiles sur les routes, ce qui représentait un réel danger pour la circulation.

En 2023, en effet, la Nouvelle-Galles du Sud a autorisé l’abattage aérien de chevaux sauvages dans le parc national du Kosciuszko. Et fin novembre, le gouvernement a adopté un projet de loi abrogeant le texte qui reconnaissait aux brumbies ou chevaux sauvages un « statut patrimonial » dans le parc (NDT : ces chevaux, arrivés d’Angleterre avec les premiers colons ont été au centre d’une bataille culturelle culturelle ces dernières années).

Ce changement a supprimé les protections juridiques dont bénéficiaient les chevaux dans le parc, qui les distinguaient des autres espèces introduites comme les cerfs, les porcs, les renards et les lapins. Désormais, ils sont traités en Australie de la même manière que les autres espèces invasives, rétablissant une cohérence dans la gestion de leur impact sur les paysages.

La dernière enquête estime qu’environ 3 000 chevaux subsistent dans le parc national du Kosciuszko, contre quelque 17 000 il y a un an. Plus de 9 000 chevaux ont été abattus depuis 2021.

Le plan de gestion actuellement en vigueur prévoit de conserver 3 000 de ces chevaux, un compromis entre protection des écosystèmes et sauvegarde de la valeur patrimoniale de ces animaux. Il doit s’appliquer jusqu’à la mi-2027.

Quels sont les effets environnementaux de la réduction du nombre de chevaux à Kosciuszko ? Et à quoi le parc pourrait-il ressembler à l’avenir ?

Les dégâts

Depuis des décennies, les chevaux sauvages constituent une source majeure de dégradations écologiques dans les paysages alpins du Kosciuszko. Leur impact dans ces milieux d’altitude fragiles s’est particulièrement accru au cours de la dernière décennie, période pendant laquelle leur population a augmenté de manière incontrôlée.

Des études empiriques et des analyses d’images satellites montrent que les brumbies réduisent la couverture végétale, dégradent la structure des sols et endommagent les berges des cours d’eau, les tourbières et les marais alpins – des sols riches en carbone formés sur des dizaines de milliers d’années.

Une partie de ces dégâts résulte de leur alimentation, fondée sur des graminées et des plantes herbacées alpines à croissance lente. Un cheval consomme généralement l’équivalent de 2 % de sa masse corporelle par jour, soit environ 8 kilogrammes quotidiens. À titre de comparaison, le plus grand herbivore indigène des hauts plateaux, le kangourou gris de l’Est, consomme environ 600 grammes par jour, c’est 13 fois moins.

Mais l’essentiel des dégâts est causé par leurs sabots. Les chevaux sauvages parcourent jusqu’à 50 kilomètres par jour, et leurs sabots durs écrasent les couches de mousses à sphaignes, compactant en profondeur les sols tourbeux. Ces plantes et ces sols fonctionnent normalement comme des éponges à restitution lente, stockant l’eau de fonte des neiges et alimentant les cours d’eau tout au long de l’été. Et contrairement aux wombats, aux kangourous et à d’autres espèces indigènes, les chevaux sauvages se déplacent en file indienne, traçant de profonds sentiers qui quadrillent les prairies alpines et les assèchent.

Ces transformations affectent l’ensemble de l’écosystème. Les scinques alpins, les rats à dents larges, les grenouilles corroboree, les phalangers pygmées des montagnes et les poissons indigènes dépendent tous d’une végétation dense, de tapis de mousse intacts ou de cours d’eau exempts de sédiments – soit précisément les éléments que les chevaux dégradent.

Les cours d’eau ont été particulièrement touchés. Les Alpes australiennes fournissent près d’un tiers des eaux de surface qui alimentent le bassin Murray-Darling (NDT : le plus vaste bassin hydrographique d’Australie), mais le piétinement des chevaux le long des cours d’eau trouble des rivières jusque-là limpides et déstabilise les apports lents et réguliers dont dépendent ces bassins versants.

Ces impacts ne se limitent pas au parc. Ces dernières années, de nombreux chevaux ont gagné des zones voisines, notamment des forêts domaniales, où leurs perturbations s’ajoutent aux effets de l’exploitation forestière commerciale et mettent en danger les visiteurs et les campeurs.

Si l’attention s’est surtout concentrée sur les effets des brumbies au Kosciuszko et, plus largement, dans les écosystèmes alpins, près d’un demi-million de chevaux sauvages affectent les paysages à l’échelle de toute l’Australie, les forêts tropicales claires et les zones semi-arides étant les plus durement touchées.

Ce que nous avons observé jusqu’à présent

Nous avons passé beaucoup de temps dans le parc au cours de l’année écoulée et avons commencé à remarquer de petits changements dans les hauts plateaux, cohérents avec ce que l’on pourrait attendre du programme de contrôle des animaux sauvages.

Nous voyons moins de chevaux lors de nos journées sur le terrain. Dans les zones régulièrement piétinées, de petites poches de végétation réapparaissent sur les surfaces dénudées. Même certaines berges, érodées de longue date, paraissent plus souples sur les bords.

Ces observations restent strictement anecdotiques et ne constituent pas des preuves formelles. Mais elles suggèrent un paysage qui commence à se « réoxygéner » à mesure que la pression diminue. Il y a aussi un aspect sécuritaire. Quiconque circule sur les routes alpines connaît la surprise, au sortir d’un virage dans les eucalyptus, de se retrouver nez à nez avec un cheval, voire un troupeau, sur le bitume. Moins de chevaux signifie moins de ces rencontres dangereuses pour les chercheurs, le personnel des parcs nationaux et les visiteurs.

Le retour progressif

Avec beaucoup moins de chevaux dans les hauts plateaux, la pression commence à diminuer. À mesure que le piétinement diminue, les tourbières et les marais devraient commencer à se régénérer et à retenir l’eau plus longtemps. Les tapis de mousse repousseront et d’autres plantes productrices de tourbe pourront s’implanter à nouveau dans des sols qui ne sont plus constamment compactés et surpâturés.

Moins de pâturage signifie également que les herbes alpines, les carex et les graminées des neiges retrouveront de l’espace pour se développer. Les sols nus vont se stabiliser, les berges des cours d’eau se rétablir et les lits des ruisseaux commencer à se dégager.

Ces améliorations se répercutent sur l’ensemble de l’écosystème : des sols plus stables et une végétation plus dense créent un habitat plus favorable aux grenouilles, aux scinques, aux petits mammifères et aux invertébrés qui dépendent d’environnements alpins frais, humides et structurés.

La récupération prendra du temps – des décennies, et non des mois. Des études empiriques à long terme seront indispensables pour suivre les changements et identifier les zones du parc où des efforts de restauration ciblés seront nécessaires pour accélérer le rétablissement.

Enfin, une vraie chance

Rien de tout cela ne se produira en un claquement de doigts. Les écosystèmes alpins se régénèrent lentement, et des décennies de dégâts ne peuvent pas être effacées du jour au lendemain. Les courtes saisons de croissance font que les plantes repoussent progressivement, et non par à-coups. De nombreuses pentes et berges de ruisseaux portent encore les cicatrices du pâturage bovin plus de 60 ans après le départ du bétail. Les perturbations perdurent ici pendant des générations.

La diminution du nombre de chevaux n’est qu’un début, mais c’est une étape essentielle. Et désormais – avec moins de chevaux sur le terrain et la suppression des barrières légales – le parc du Kosciuszko dispose enfin d’une voie réaliste vers la restauration. La prochaine décennie déterminera combien de son fragile patrimoine alpin pourra finalement être retrouvé.

David M. Watson reçoit des financements de recherche du gouvernement fédéral (via l’ARC, le DAFF, le DCCEEW) et siège aux conseils d’administration du Holbrook Landcare Network et des Great Eastern Ranges. Il a exercé deux mandats au sein du Comité scientifique des espèces menacées de la Nouvelle-Galles du Sud, avant de démissionner lorsque la Wild Horse Heritage Act est entrée en vigueur en juin 2018.

Patrick Finnerty est actuellement directeur pour les carrières émergentes en écologie à l’Ecological Society of Australia, coordinateur des jeunes chercheurs à l’Australasian Wildlife Management Society, et membre du conseil de la Royal Zoological Society of NSW. Il reçoit des financements de l’Australian Research Council.

09.01.2026 à 16:45

Manger sain et durable avec la règle des 4V

Texte intégral (3094 mots)

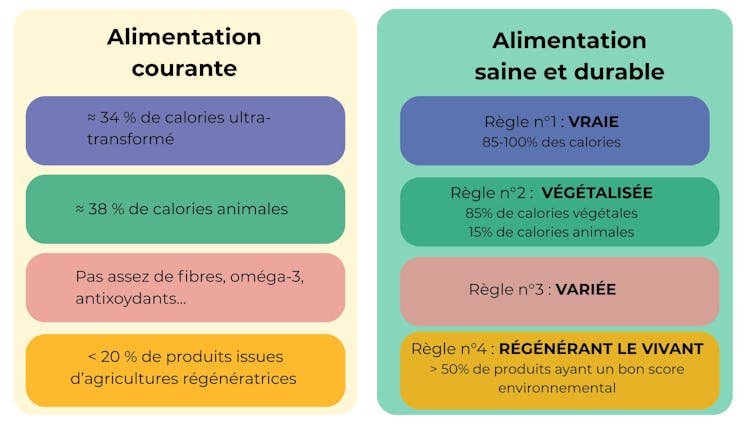

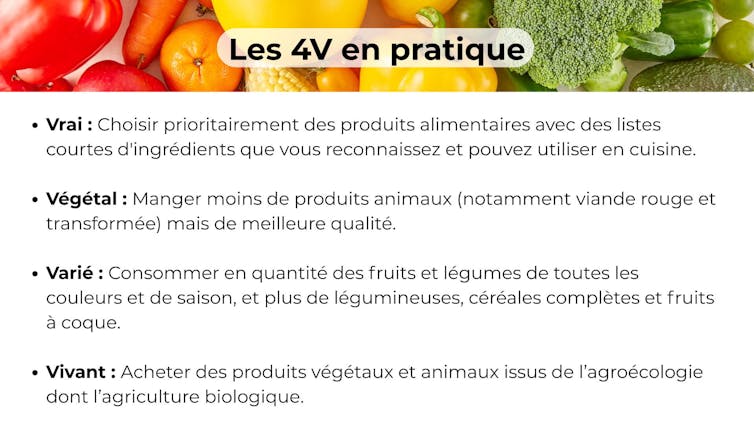

Manger végétal, vrai et varié et consommer plus de produits issus d’une agriculture régénérant le vivant. Ces quatre objectifs permettent de concilier une alimentation bénéfique pour notre santé comme pour celle des écosystèmes.

Faire ses courses ressemble souvent à un casse-tête. On souhaiterait trouver des produits bon pour la santé, si possible ne venant pas du bout du monde, pas ultratransformés ni cultivés avec force pesticides et engrais chimiques, tout en étant à un prix abordable.

Mais ces enjeux peuvent parfois entrer en contradiction : des produits considérés comme sains ne sont pas toujours issus d’une agriculture de qualité, et inversement. En outre, de bons produits pour la santé et l’environnement ne permettent pas nécessairement d’avoir un régime alimentaire équilibré.

Alors comment sortir de ces dilemmes et aiguiller le consommateur ?

Nous proposons la règle simple des 4V, qui tient compte des modes de production agricoles et de la composition de l’assiette en invitant à une alimentation vraie, végétale, variée et régénérant le vivant.

La règle des 4V

Manger vrai permet de fait de réduire le risque de nombreuses maladies chroniques (obésité, cancers, diabète de type 2, dépression, maladies cardiovasculaires…). Par précaution, cela consiste à limiter les aliments ultratransformés à 10-15 % des apports caloriques quotidiens, au lieu de 34 % actuellement en moyenne ; soit déjà les diviser par deux au minimum.

Manger plus végétal est également meilleur pour la santé. Cela permet aussi une réduction importante de plusieurs impacts environnementaux : réduction de l’empreinte carbone de notre alimentation, car moins d’émissions de gaz à effet de serre (GES) en agriculture ; moindre consommation de ressources (terres, énergie, eau).

Réduire la production et la consommation de produits animaux permet aussi d’abaisser les émissions d’azote réactif qui polluent l’air, les sols et les nappes phréatiques et produisent du protoxyde d’azote (N₂O), un puissant gaz à effet de serre. Ce deuxième V permet ainsi de diviser par deux les émissions de GES et d’azote dans l’environnement.

Outre la réduction de notre consommation de protéines qui excède en moyenne de 40 % les recommandations, il est proposé de ramener la part des protéines animales à moins de 50 % de l’apport protéique, au lieu de 65 % actuellement. Au final, cela revient à diviser par deux la consommation de viande et un peu celle des produits laitiers, notamment le fromage. L’augmentation de la consommation de protéines végétales provient alors surtout des légumineuses. La végétalisation de l’assiette passe aussi par une consommation accrue de fruits et de légumes peu transformés, de céréales complètes et de fruits à coque.

À lire aussi : Les légumineuses : bonnes pour notre santé et celle de la planète

Manger varié est un atout pour la santé, notamment pour l’équilibre nutritionnel afin d’éviter les déficiences. Cela suppose de diversifier fruits, légumes, céréales complètes, légumineuses et fruits à coque qui sont une source importante de fibres, minéraux, vitamines, oligo-éléments, anti-oxydants et autres phytonutriments bioactifs protecteurs.

Pour cela, il faudrait idéalement consommer de tous les groupes d’aliments tout en variant dans chaque groupe : par exemple, blé, maïs et riz complets pour les céréales. Manger les différents morceaux de viande – en particulier des bovins (par exemple des entrecôtes et pas seulement du steak haché) – est aussi important pour ne pas déstabiliser les filières.

Manger des produits issus d’une agriculture régénérant le vivant permet d’améliorer la densité nutritionnelle des aliments, de réduire l’empreinte environnementale de l’assiette, notamment pour les émissions de GES et d’azote, et aussi d’augmenter les services fournis à la société (séquestration de carbone, épuration de l’eau…).

La regénération du vivant désigne l’ensemble des actions visant à restaurer ou renouveler la fertilité des sols, les cycles de l’eau et de l’azote, la diversité des espèces et la résilience face aux changements climatiques, tout en consommant avec parcimonie les ressources non renouvelables (le gaz qui sert à fabriquer les engrais, le phosphore…). Ainsi, au-delà de la production de nourriture, l’agriculture régénératrice vise à fournir des services à la société, tels que la séquestration du carbone dans les sols, l’augmentation de la densité nutritionnelle des produits.

Manger des produits issus d’une agriculture régénérant le vivant consisterait par exemple à choisir 50 % de produits ayant un bon score environnemental alors que les modes de production contribuant à la régénération du vivant ne dépassent pas 25 % de l’offre.

Types d’agriculture contribuant à la régénération du vivant

L’agriculture conventionnelle, qui vise l’intensification durable en utilisant les technologies pour réduire ses impacts, ne peut cependant pas régénérer le vivant, car elle porte toujours sur des systèmes simplifiés avec un nombre limité de cultures, des sols souvent pauvres en matières organiques, peu d’infrastructures écologiques et de très grandes parcelles.

Cependant, caractériser les modes de culture et d’élevage pour leurs impacts négatifs, mais aussi pour les services qu’ils rendent (séquestration du carbone, densité nutritionnelle des produits) permet d’aller au-delà de la dichotomie usuelle bio/conventionnel.

Les pratiques associées à la régénération du vivant reposent sur la diversification des cultures et des modes d’alimentation des animaux. Elles permettraient de réduire les émissions de GES de 15 % environ, et aussi de séquestrer entre 15 et 20 % des émissions de GES de l’agriculture. Elles permettraient aussi de réduire de moitié insecticides et fongicides. En revanche, une réduction forte de l’utilisation des herbicides est plus difficile et nécessite de combiner plusieurs mesures sans forcément exclure un travail du sol occasionnel.

L’élevage est critiqué, car il introduit une compétition entre feed (nourrir les animaux) et food (nourrir les humains). Cette compétition est bien plus faible pour les vaches, qui mangent de l’herbe, que pour les porcs et les volailles, qui sont nourris avec des graines. Elle est aussi d’autant plus faible que les élevages sont autonomes pour l’énergie et les protéines. Des exemples d’élevage contribuant à la régénération du vivant sont les élevages herbagers et biologiques, dont l’alimentation provient surtout des prairies, ainsi que les élevages Bleu Blanc Cœur pour lesquels l’ajout de lin, graine riche en oméga-3, dans la ration des animaux, a des effets positifs sur leur santé, la nôtre et la planète puisqu’il y a une réduction des émissions de GES en comparaison à des élevages courants.

Il s’agit d’agricultures agroécologiques, telles que l’agriculture biologique, l’agriculture de conservation des sols, s’il y a une réduction effective des pesticides, voire l’agroforesterie.

À lire aussi : Les sept familles de l’agriculture durable

Des initiatives sont en cours pour évaluer l’impact environnemental des produits agricoles et alimentaires. Elles permettent de qualifier les modes de culture et d’élevage en termes d’impacts sur le climat, la biodiversité, en mobilisant la base de données Agribalyse. Elles tiennent compte aussi des services fournis comme la séquestration du carbone, la contribution à la pollinisation des cultures, comme le montre la recherche scientifique.

À ce jour, deux initiatives diffèrent par la manière de prendre en compte les services et de quantifier les impacts. La méthode à retenir dépendra de leur validation scientifique et opérationnelle.

Des bienfaits conjugués

Suivre ces 4V permet de pallier les failles de notre système alimentaire tant pour la santé que pour l’environnement. L’alimentation de type occidental est de fait un facteur de risque important pour le développement de la plupart des maladies chroniques non transmissibles. Les facteurs qui en sont à l’origine sont nombreux : excès de consommation d’aliments ultratransformés, de viandes transformées, de gras/sel/sucres ajoutés, de glucides rapides, manque de fibres, d’oméga-3, d’anti-oxydants, et une exposition trop importante aux résidus de pesticides. Ces maladies sont en augmentation dans de nombreux pays, y compris en France.

Par ailleurs, les modes de production en agriculture sont très dépendants des intrants de synthèse (énergie, engrais, pesticides) dont les excès dégradent la qualité des sols, de l’eau, de l’air, la biodiversité ainsi que la densité nutritionnelle en certains micronutriments.

Nous sommes parvenus à un point où nos modes d’alimentation ainsi que les modes de production agricole qui leur sont associés génèrent des coûts cachés estimés à 170 milliards d’euros pour la France. La nécessité de refonder notre système alimentaire est maintenant reconnue par les politiques publiques.

Un cercle vertueux bon pour la santé et l’environnement

Manger varié encourage la diversification des cultures et le soutien aux filières correspondantes. Il en est de même pour manger vrai, car les industriels qui fabriquent des aliments ultratransformés n’ont pas besoin d’une diversité de cultures dans un territoire. Dit autrement, moins on mange vrai, moins on stimule l’agriculture contribuant à régénérer le vivant. Manger varié est également meilleur pour la santé mais aussi pour le vivant.

Par ailleurs, les pratiques agricoles régénératives permettent généralement d’avoir des produits de plus grande densité nutritionnelle. Même si le mode de production de l’agriculture biologique émet souvent plus de GES par kilo de produit que le mode conventionnel, il suffit de consommer un peu moins de viande pour compenser cet effet.

La règle des 4V (Figure 2) permet donc d’embarquer tous les acteurs du système alimentaire, du champ à l’assiette, ainsi que les acteurs de la santé. Ainsi, adhérer simultanément à vrai, végétal, varié a récemment été associé à une réduction de 27 % du risque de cancer colorectal.

Quant au concept de régénération du vivant, il demeure parlant pour tous les maillons de la chaîne. Vivant, varié et végétal s’adressent aux agriculteurs ; vrai concerne les transformateurs et, in fine, le distributeur qui peut offrir ou non du 4V aux consommateurs. Cette règle des 4V permet ainsi de sensibiliser les acteurs du système alimentaire et les consommateurs aux facteurs à l’origine des coûts cachés de l’alimentation, tant pour la santé que l’environnement.

Enfin, un tel indicateur qualitatif et holistique est facile d’appropriation par le plus grand nombre, notamment les consommateurs, tout en constituant un outil d’éducation et de sensibilisation au concept « Une seule santé » pour l’alimentation, comblant le fossé entre sachants et non-sachants.

Anthony Fardet est membre des comités scientifiques/experts de MiamNutrition, The Regenerative Society Foundation, Centre européen d'excellence ERASME Jean Monnet pour la durabilité, Projet Alimentaire Territorial Grand Clermont-PNR Livradois Forez et l'Association Alimentation Durable. Il a été membre du comité scientifique de Siga entre 2017 et 2022.

Michel Duru est membre du conseil scientifique de PADV (Pour une Agriculture Du Vivant)

08.01.2026 à 17:19

Dermatose nodulaire contagieuse : les vétérinaires victimes d’une épidémie de désinformation

Texte intégral (2448 mots)

Arrivée en France en juin 2025, la dermatose nodulaire contagieuse (DNC) a rapidement fait l’objet de mesures sanitaires qui ont permis d’éradiquer le virus dans certaines régions. Mais la crise agricole qui a suivi a vu émerger une contestation inédite, nourrie par des fausses informations et des remises en cause du rôle des vétérinaires. Dans ce texte, la profession appelle à un « droit de véto » contre la désinformation.

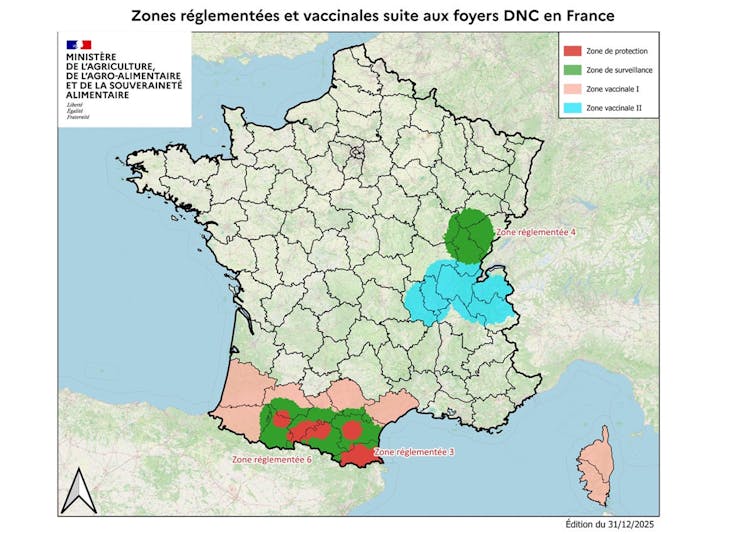

La dermatose nodulaire contagieuse (DNC) a atteint la France en Savoie le 29 juin 2025 à la suite de l’introduction d’un bovin infecté venant d’Italie. La France métropolitaine étant alors indemne de la DNC, la réglementation européenne prévue (dépeuplement total, vaccination d’urgence au sein des zones réglementées (ZR) – instaurées par arrêté préfectoral, limitation des mouvements des bovins…] a été mise en place, ce qui a permis d’éliminer le virus dans la région dès le 21 août.

Les contaminations ultérieures qui ont suivi en France, notamment en Occitanie, sont en réalité le résultat de déplacements illicites de bovins contagieux à partir de la zone réglementée couvrant une partie de l’Ain, de la Savoie et de la Haute-Savoie (zone vaccinale II sur la carte ci-dessous).

La forte médiatisation de la DNC associée aux dénonciations de « hold-up politique » par certains éleveurs rappelle de précédentes crises sanitaires (vache folle, grippe aviaire, Covid-19…). Mais à l’époque, la parole des « sachants » n’avait pas été remise en cause dans les mêmes proportions qu’aujourd’hui. Des membres de la profession vétérinaire font l’objet d’insultes, voire de menaces gravissimes, dans certains cas même de menaces de mort.

Cette situation est non seulement surprenante, mais également choquante. Les vétérinaires ont toujours été associés et solidaires avec les éleveurs. Dans le même temps, de fausses informations au sujet de la DNC se propagent dans l’espace médiatique.

À lire aussi : Dermatose nodulaire : comprendre les raisons de la mobilisation agricole

Un déferlement inédit de « fake news »

Parmi les fausses informations que des experts autoproclamés (parmi lesquels on a pu retrouver tant des personnes ayant endossé une posture « antivax » lors de la pandémie de Covid-19 que des scientifiques ou cliniciens méconnaissant la DNC) ont diffusées, non seulement sur les réseaux sociaux mais également dans les médias :

- « La maladie peut être traitée par des antibiotiques/par l’ivermectine. »

C’est faux. Les antibiotiques ou les antiparasitaires tels que l’ivermectine ne sont pas actifs sur une maladie virale comme la DNC, causée par un Capripoxvirus (Lumpy skin disease virus).

- « L’Espagne et l’Italie n’ont pas appliqué le dépeuplement total. »

C’est faux. Les autres pays européens confrontés à la DNC, comme l’Espagne et l’Italie, appliquent eux aussi la stratégie d’abattage de tous les bovins présents dans un foyer confirmé de DNC, comme le confirme le ministère de l’agriculture.

- « La Suisse pratique l’abattage partiel. »

Il n’y a pour l’instant pas eu de cas de DNC confirmé en Suisse, donc pas d’abattage.

- « Il est inadmissible d’abattre tout un troupeau lorsqu’il y a seulement un animal malade. »

Si un seul animal présente des lésions cutanées, il y a de fortes chances qu’au moins 50 % des animaux soient infectés dans le troupeau. En effet, il est difficile de connaître précisément la date d’infection du bovin. Si celle-ci est antérieure à l’acquisition de la protection vaccinale, alors plusieurs animaux sont potentiellement infectés au sein du troupeau, ce que les tests sanguins ne permettent pas de détecter.

- « Il faut avoir un troupeau témoin pour surveiller l’évolution de la maladie dans un foyer infecté. »

Ce troupeau « témoin » a existé dès le 6e foyer de DNC déclaré le 7 juillet en France, du fait du recours d’un jeune éleveur de Savoie refusant le dépeuplement de son troupeau. Treize jours plus tard, le recours a été refusé et d’autres cas de DNC se sont déclarés dans son élevage. La forte contagiosité de la DNC pourrait en partie expliquer le grand nombre de foyers de DNC déclarés deux semaines plus tard dans les élevages voisins.

- La DNC relève de la catégorie A du droit européen, comme la fièvre aphteuse, or « pour la fièvre aphteuse, de nouveaux textes préconisent l’abattage partiel ».

C’est faux. La catégorie A correspond en médecine vétérinaire à une maladie soumise une réglementation sanitaire très stricte lorsqu’il s’agit d’une maladie hautement contagieuse émergent dans un pays indemne. Les conséquences économiques et sanitaires justifient une éradication immédiate dès son apparition.

- « Le vaccin n’est pas efficace car certains bovins vaccinés ont présenté la maladie malgré tout »

La vaccination en urgence n’est pas une vaccinothérapie. Elle nécessite au moins trois semaines pour installer une protection immunitaire. Elle a pu être réalisée chez des animaux déjà infectés avant ou peu après l’injection vaccinale.

- « La désinsectisation de l’élevage est la méthode la plus efficace pour éviter la contamination ».

Ce sont certes des insectes hématophages qui sont les vecteurs de la DNC, mais les traitements insecticides ne sont jamais efficaces à 100 %. Il n’existe pas de mesure parfaite permettant d’éradiquer tous les insectes d’un élevage.

- « 70 vétérinaires ont été radiés de l’Ordre des vétérinaires pour avoir refusé l’abattage du troupeau de l’Ariège ».

C’est faux. Le conseil national de l’ordre des vétérinaires confirme qu’aucun vétérinaire n’a été radié pour avoir refusé un abattage.

- « Le vaccin est dangereux pour les animaux et l’humain ».

C’est faux, le vaccin est un vaccin dit « vivant atténué » qui ne présente aucun danger ni pour les animaux ni pour l’humain. De plus, la DNC n’est pas une zoonose (maladie animale transmissible à l’humain et réciproquement), mais une épizootie.

- « Il y a encore des cas de DNC en Savoie ».

Dans cette zone désormais considérée comme indemne de la DNC, il peut s’agir de la pseudo dermatose nodulaire contagieuse (PDNC), due à un herpèsvirus qui évolue très rapidement (en 3 semaines) vers la guérison.

- « La fédération des vétérinaires européens (FVE) préconise plutôt la vaccination que l’abattage dans la DNC ».

C’est faux : la note de la FVE de novembre 2025 présente une revue générale sur le bénéfice des vaccinations en médecine vétérinaire sans remettre en cause la réglementation européenne concernant les maladies classées dans la catégorie A comme la DNC.

- « L’EFSA (European Food Safety Autority) avait préconisé un abattage partiel en 2016 lors des premiers foyers de DNC en Europe ».

Cette recommandation de l’EFSA en 2016 correspondait à une évaluation mathématique des moyens à mettre en œuvre dans les pays où la DNC était déjà installée (virus endémique), en l’occurrence les Balkans. Elle ne s’applique pas pour les pays indemnes de DNC soumis à la réglementation européenne, comme c’est le cas en France.

- « Lors de l’épizootie de DNC observée dans l’île de La Réunion en 1991-1992, il n’y a pas eu de dépeuplement total ».

La flambée de DNC sur l’île de la Réunion a été la conséquence de l’importation de zébus malgaches. Le contexte sur cette île qui n’exportait pas de bovins était toutefois différent de la situation actuelle de la DNC en France métropolitaine. Il y a d’abord eu un retard considérable de plusieurs mois pour identifier formellement la maladie. Le premier vaccin, qui était celui utilisé pour la variole ovine, était peu efficace pour les 18 000 bovins vaccinés (sur les 21 000 bovins recensés sur l’île). La vaccination avec le vaccin bovin sud-africain, bien plus efficace, a été réalisée avec un an de retard. Au total, 511 exploitations ont été atteintes avec 10 % de mortalité.

Les conditions de la sortie de crise

En France, la situation est actuellement sous contrôle dans le Sud-Est, mais elle est encore évolutive en Occitanie, où de rares cas peuvent encore apparaître à la fin de cette épizootie. Ce sera le cas de bovins en incubation, car voisins d’un foyer déclaré et dont l’immunité vaccinale n’est pas encore installée pour le protéger.

Deux autres risques ne peuvent pas être évalués pour prédire la fin de cette épizootie de DNC :

un déplacement illicite à partir des ZR actuelles d’animaux apparemment sains, mais qui sont de véritables « bombes virales » à retardement ;

la non-déclaration d’un cas de suspicion de DNC par un éleveur (comme un représentant syndical a osé le recommander), alors qu’il convient d’éviter la contamination des élevages voisins.

La principale revendication des agriculteurs, répétée inlassablement dans les médias, est un abattage partiel lors de DNC. Elle témoigne d’une méconnaissance de cette maladie. En effet, on l’a vu plus haut, ce serait mettre en danger les troupeaux indemnes et par-delà, tout le cheptel bovin français. Nous espérons qu’il n’y aura plus de foyers de DNC à partir de mi-janvier 2026, comme ce fut le cas dans les Savoie après la vaccination.

La profession vétérinaire a toujours été proche des agriculteurs. Rappelons que les premières écoles vétérinaires au monde ont été créées en France au XVIIIe siècle pour « lutter contre les maladies des bestiaux ». Ainsi, en unissant nos forces nous avons pu éradiquer de la surface de la Terre en 2001 une autre maladie virale : la peste bovine.

Jean-Yves Gauchot est docteur vétérinaire et président de la Féderation des syndicats vétérinaires de France

Jeanne Brugère-Picoux ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

08.01.2026 à 11:45

La marche, premier mode de déplacement en France : ce que disent vraiment les statistiques de mobilité

Texte intégral (2744 mots)

Les statistiques de mobilité orientent les politiques publiques. Or en France, la manière de les présenter, héritée des années du tout automobile, minore la part de la marche, ce qui pénalise le développement des mobilités actives. Et si on s’inspirait des approches statistiques déjà déployées ailleurs, par exemple en Suisse, pour mieux comptabiliser le temps passé à marcher ?

Les statistiques ne sont jamais neutres : elles sont le reflet de choix politiques répondant à un contexte historique spécifique. La manière de présenter les résultats des enquêtes statistiques sur la mobilité des personnes en France, qui a déjà 50 ans, n’échappe pas à cette règle. Elle conduit à sous-estimer fortement les déplacements à pied, au risque de continuer à favoriser des politiques en faveur des modes de déplacement motorisés.

Il est grand temps de réformer cet usage, comme l’a fait la Suisse il y a déjà 30 ans, si l’on souhaite redonner aujourd’hui davantage de place aux mobilités actives, tant pour des raisons sociales, économiques qu’environnementales.

Pour rappel, la marche est le mode de déplacement le plus inclusif, le plus démocratique et le moins nuisible à l’environnement, et pas seulement dans le cœur des grandes villes.

À lire aussi : Atteindre les objectifs climatiques améliorera aussi la santé publique

Ce que disent les statistiques sur la mobilité

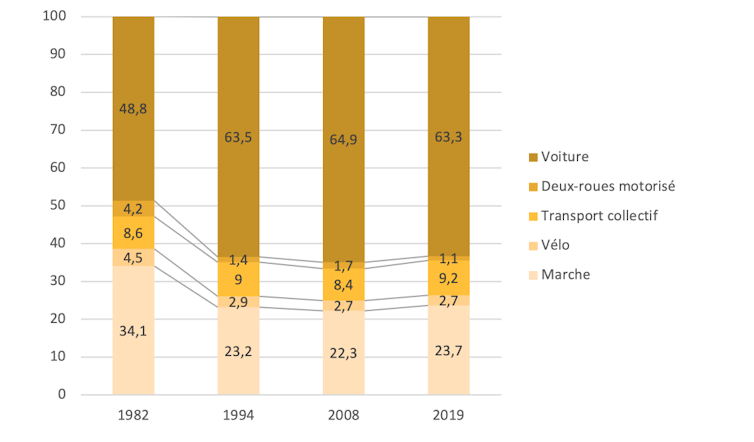

En France, depuis la standardisation des enquêtes sur la mobilité des personnes en 1976, les déplacements sont généralement présentés sous forme de « parts modales ». Il s’agit des parts, sur l’ensemble des déplacements comptabilisés, réalisées avec chaque mode de déplacement : voiture, deux-roues motorisé, transports collectifs, vélo, marche…

Dans les présentations classiques des données recueillies, la part modale de la marche apparaît très inférieure à celle de la voiture. Pourtant, quand on regarde l’autre grande source statistique que représentent les enquêtes sur la mobilité réalisées dans les grandes villes, les déplacements à pied dominent dans les centres-villes, et parfois également dans les banlieues denses de la proche périphérie. Mais partout ailleurs, c’est largement le contraire et le triomphe de la voiture apparaît ainsi incontestable.

En conséquence, pour qui découvre ces statistiques ainsi présentées , dans la plupart des territoires, il paraît nécessaire de s’occuper en priorité des voitures, de leur accorder davantage de place pour circuler et stationner, même si cela doit se faire au détriment des espaces publics, des trottoirs, des places publiques et autres terre-pleins.

Ce qu’oublient de préciser ces représentations

Examinons ces chiffres de plus près. En réalité, ce qu'on nomme habituellement la « part modale de la marche » ne concerne que la « marche exclusive », c’est-à-dire les déplacements entièrement faits à pied, par les résidents, sur l’espace public et hors du temps de travail.

Par convention, on oublie ainsi :

la marche intermodale, c’est-à-dire les déplacements à pied pour rejoindre ou quitter un transport public ou une place de stationnement pour voiture, vélo ou deux-roues motorisé,

la marche effectuée dans des espaces privés ouverts au public, comme les centres commerciaux ou les gares,

la promenade ou la randonnée,

la marche pendant le travail, y compris quand elle est effectuée sur l’espace public, qui est pourtant très importante dans certaines professions,

la marche au domicile pour effectuer toutes sortes d’activités : du ménage au jardinage, en passant par le bricolage, etc.,

enfin, la marche réalisée par les visiteurs (touristes et autres non-résidents) du territoire.

À lire aussi : Mobilité : et si on remettait le piéton au milieu du village ?

Comment expliquer une approche si restrictive ?

Les conventions statistiques sur la mobilité ont été élaborées dans les années 1960-1970 à l’époque du « tout automobile », puis des premiers efforts réalisés pour relancer les transports publics. Dans ce contexte, il fallait avant tout prévoir et dimensionner la voirie pour absorber un trafic motorisé fortement croissant, les piétons étant très peu considérés et les cyclistes censés disparaître.

Par convention dans les enquêtes sur la mobilité, un déplacement, c’est une personne qui va d’un lieu d'origine à un lieu de destination, avec un ou plusieurs modes et pour un motif particulier. Les modes sont hiérarchisés avec priorité aux plus lourds : d’abord les transports publics, puis la voiture, puis les deux-roues et enfin la marche.

Autrement dit, si une personne se rend à pied à un arrêt de bus, prend le bus, puis termine son trajet à pied, le déplacement est considéré comme ayant été fait en transport public et la part de marche est tout simplement ignorée. Dans cette approche, la marche devient un « résidu » statistique, c’est-à-dire ce qui reste une fois qu’on a pris en compte tous les autres modes de déplacement. Pourtant, les usagers des transports publics passent environ la moitié de leur temps à pied à marcher ou à attendre.

À lire aussi : Réduire l’empreinte carbone des transports : Quand les progrès techniques ne suffisent pas

Ces pays qui comptabilisent les déplacements différemment

Or, cette représentation des statistiques de déplacement en France est loin d’être la seule possible.

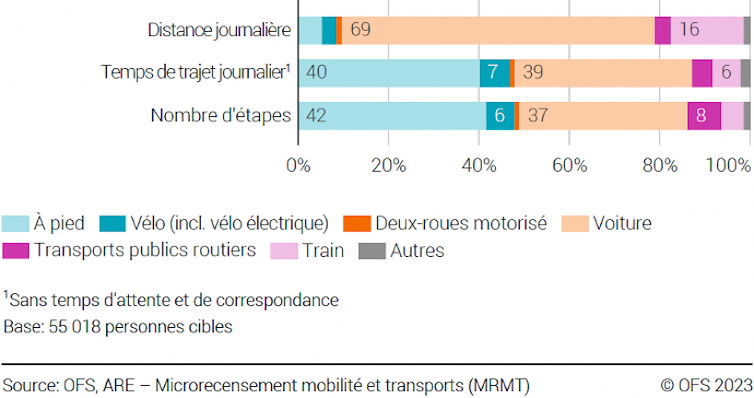

En Suisse par exemple, depuis une réforme des statistiques de la mobilité introduite en 1994, les résultats des enquêtes de mobilité sont présentés sous trois angles différents : les distances parcourues, le temps de trajet et le nombre d’étapes.

Par étape, on entend ici les segments d’un déplacement effectués à l’aide d’un seul mode de transport. Un déplacement en transport public, par exemple, compte le plus souvent une première étape à pied, puis une deuxième en transport public et une troisième à nouveau à pied : on parle de marche intermodale.

Ainsi, en 2021, en ne tenant compte que de la marche exclusive et de la marche intermodale, les Suisses ont passé chaque jour plus de temps à pied qu’en voiture.

Ailleurs, on réfléchit aussi à d’autres manières de présenter les résultats des enquêtes sur la mobilité, comme en Belgique ou au Royaume-Uni.

En réalité, 100 % de nos déplacements intègrent au moins une part de marche, même minimale lorsqu’il s’agit par exemple de simplement sortir de sa voiture sur le parking de son lieu de travail. La marche est à l'origine de toutes les autres formes de mobilité et les autres modes ne sont que des « relais du piéton ». Parce que nous sommes des bipèdes, la marche est évidemment notre premier mode de déplacement.

Vers une nouvelle approche en France ?

La France peut-elle changer sa façon de présenter les statistiques de mobilité, dans le sillage de ce que propose la Suisse ?

Pour prendre conscience de l’importance journalière de la marche, il convient de l’aborder en temps de déplacement total à pied. Une récente étude de l’Ademe révèle que nous passons chaque jour une heure et douze minutes à pied, soit beaucoup plus que la durée moyenne passée en voiture chaque jour, qui est de 37 minutes.

Ces résultats montrent aussi que la prise en compte de la marche intermodale augmente de 75 % la durée de la seule marche exclusive (dite « déplacements locaux intégralement à pied » dans le graphique ci-après). En tenant compte de tous les temps consacrés à se déplacer, la marche est sans conteste le premier mode de déplacement, loin devant la voiture.

Cette étude repose sur l’utilisation de deux enquêtes existantes mais sous-exploitées (l’enquête mobilité des personnes et l’enquête emploi du temps des Français) et en adoptant plusieurs hypothèses prudentes.

En quelques centaines de milliers d’années d’évolution humaine, la bipédie s’est hautement perfectionnée. Elle a permis de libérer nos mains, nous a rendus très endurants à la course et a contribué à développer notre cerveau. Puis, en 150 ans seulement avec l’avènement du transport motorisé, la marche utilitaire quotidienne s’est effondrée.

Pourtant, de par notre constitution, marcher régulièrement est essentiel pour rester en bonne santé, pour bien grandir, vivre mieux et bien vieillir. C’est un enjeu de santé publique. C’est pourquoi, il convient de réaliser des espaces publics confortables, de libérer les trottoirs du stationnement sauvage et autres obstacles, de ménager des traversées piétonnes sécurisées et de calmer la circulation automobile, sa vitesse et son volume. Pour appuyer de telles politiques, encore faudrait-il revoir notre manière de représenter la marche dans les résultats des enquêtes de mobilité.

Frédéric Héran est membre du conseil d’administration de l'association et groupe de réflexion Rue de l’Avenir

08.01.2026 à 11:45

Peut-on encourager le covoiturage avec des subventions locales ?

Texte intégral (1743 mots)

Le covoiturage est souvent perçu comme une des façons les plus simples de baisser les émissions de gaz à effet de serre des transports. Si le premier bilan des subventions locales visant à généraliser cette pratique est encourageant, il masque en vérité plusieurs aspects.

Face à l’urgence climatique et aux embouteillages chroniques des métropoles françaises, les pouvoirs publics cherchent des solutions pour réduire l’usage de la voiture individuelle. Les automobiles des particuliers sont la principale source des émissions de gaz à effet de serre du transport en France. Elles sont également émettrices de particules fines qui dégradent la qualité de l’air et augmentent les risques de maladies respiratoires et cardiovasculaires.

Face à cette réalité, le covoiturage est une piste qui suscite beaucoup d’espoir, car elle ne nécessite pas d’infrastructures lourdes supplémentaires, s’appuyant sur des ressources existantes de véhicules et de conducteurs. Parmi les solutions incitatives, les aides financières locales au covoiturage, notamment via des plateformes numériques, se développent depuis 2019. Mais ces subventions encouragent-elles vraiment plus de covoiturage ? Et quels sont les gains environnementaux dus à ces subventions ?

Des résultats probants, mais variables selon les territoires

La loi d’orientation des mobilités (LOM), promulguée en 2019, autorise les autorités organisatrices de mobilité à verser une incitation financière aux conducteurs et passagers d’un trajet en covoiturage. Le versement de cette subvention s’effectue principalement via des plateformes numériques qui organisent le covoiturage. La subvention moyenne pour un déplacement en covoiturage de 22 kilomètres s’élève à 1,60 euros.

Pour voir si ce levier est efficace, un jeu de données est précieux : celui du registre de preuve de covoiturage. Il centralise les données de trajets transmises par les plateformes partenaires. Notre étude récente utilise ces données pour mesurer la pratique du covoiturage organisé via plateforme dans 1 123 collectivités locales françaises entre 2019 et 2024.

Elle révèle que ce levier est effectivement puissant. En moyenne, l’introduction d’une subvention locale attribuée pour chaque déplacement augmente d’environ 5 trajets mensuels le nombre de trajets de covoiturage à courte distance (inférieurs à 80 kilomètres) sur plateforme pour 1 000 habitants concernés. Chaque euro de subvention supplémentaire par déplacement génère près de 4 trajets mensuels additionnels par 1 000 habitants. Autrement dit, les finances publiques locales, investies dans ce type d’incitation, produisent un effet tangible et mesurable sur le terrain.

Ce résultat masque cependant une forte diversité. L’effet des subventions est nettement plus marqué dans les zones urbaines denses et peuplées. À l’inverse, dans les territoires peu denses et ruraux, la subvention n’a quasiment aucun effet, traduisant les difficultés du covoiturage à s’implanter sans une masse critique d’usagers. Cette disparité met en lumière le rôle central des effets de réseau propres aux plateformes numériques : plus il y a d’utilisateurs, plus elles deviennent utiles, ce qui amplifie l’impact des subventions.

D’autres réalités doivent également être soulevées pour comprendre l’efficacité ou non de ces subventions, notamment du point de vue environnemental.

L’effet d’aubaine : inciter ceux qui viendraient de toute façon

L’effet d’aubaine se produit lorsque des utilisateurs auraient covoituré via la plateforme même en l’absence de toute subvention. Par exemple, un salarié habitué à organiser son covoiturage quotidien sur une application continue simplement à le faire, mais touche désormais une prime financière.

Ici, la dépense publique n’a donc pas changé son choix ni augmenté le nombre total de trajets partagés, ce qui dilue l’efficacité de la politique.

L’effet d’opportunité : attirer les covoitureurs informels sans créer de nouveaux trajets

L’effet d’opportunité correspond lui aux covoitureurs qui, sans subvention, auraient continué à partager leurs trajets en dehors des plateformes numériques (par exemple via le bouche-à-oreille ou des groupes privés). Lorsque la subvention est instaurée, ils transfèrent leur pratique sur la plateforme pour bénéficier des aides. Ainsi, le volume de trajets enregistrés croit artificiellement, sans que la part réelle du covoiturage dans la mobilité globale n’augmente. Par exemple, deux voisins qui organisaient ensemble leur trajet en voiture hors plateforme rejoignent l’application pour percevoir la prime, sans modification de leur habitude de déplacement. Une enquête du Centre d’études et d’expertise sur les risques, l’environnement, la mobilité et l’aménagement (Cerema) montre qu’un tiers des nouveaux covoitureurs attirés par les dispositifs d’incitation financière covoituraient déjà avant la mise en place de l’incitation.

Le report modal : comprendre d’où viennent les nouveaux passagers

Le facteur le plus décisif concerne cependant les sources du report modal : il s’agit d’identifier le mode de transport qu’un passager du covoiturage aurait utilisé si la subvention n’existait pas. Contrairement à l’idée reçue, une grande partie des nouveaux passagers du covoiturage issu de la subvention ne sont pas d’anciens automobilistes solo, mais d’anciens usagers du transport collectif (bus, train) ou parfois des modes actifs (comme le vélo ou la marche).

Prenons l’exemple d’une passagère qui renonce au TER pour un trajet covoituré subventionné : cela ne retire pas une voiture de la circulation, et les bénéfices pour la réduction des émissions sont nettement moindres que si elle avait quitté la voiture solo.

D’après l’enquête nationale sur le covoiturage pilotée par l’Agence de l’environnement et de la maîtrise de l’énergie (Ademe), 35 % des passagers du covoiturage courte distance via plateforme faisaient le déplacement en transports en commun avant de pratiquer le covoiturage, 11 % utilisaient un mode actif et 10 % ne faisaient pas ce trajet. Ce constat est valable tant pour le covoiturage court que longue distance, freinant fortement l’effet net de la politique sur les émissions de gaz à effet de serre.

Combien coûte réellement la tonne de CO₂ évitée ?

Pour obtenir une mesure de l’impact net des subventions, il est donc indispensable de corriger les chiffres bruts du nombre de trajets en tenant compte de ces trois effets. Selon notre étude, ces phénomènes expliquent qu’entre un tiers et la moitié de l’augmentation observée n’est pas associée à une réelle réduction de l’autosolisme ou des émissions.

Une manière de mesurer l’efficacité d’une politique de réduction des émissions de gaz à effet de serre, et de la comparer à d’autres politiques, est de calculer le montant nécessaire pour éviter l’émission d’une tonne de CO2. Dans le cas du covoiturage, chaque tonne de CO2 évitée coûte à la collectivité entre 1 000 et 1 300 euros en subventions.

Ce chiffre se situe dans la fourchette haute des instruments de politique climatique en Europe, ce qui dénote une efficacité très relative. À titre de comparaison, le dispositif d’encouragement de l’adoption de la motorisation électrique a un coût pour les finances publiques de l’ordre de 600 euros par tonne de CO₂ évitée.

Vers une stratégie de long terme, ciblée et combinée

Ces résultats montrent bien la nécessité de concevoir des politiques qui ciblent précisément les changements de comportement les plus à même de réduire les émissions de CO2. Ces politiques seront d’autant plus efficaces qu’elles convainquent des autosolistes d’abandonner leur voiture pour covoiturer en tant que passager. Pour cela, des stratégies combinées seront nécessaires : incitations financières, infrastructures adaptées comme les voies réservées, développement de l’intermodalité…

Enfin, l’effet des subventions croissant dans le temps et le développement de la pratique du covoiturage invitent à une vision de long terme, loin des mesures ponctuelles d’effet d’annonce.

Guillaume Monchambert est membre du conseil scientifique de la Société des Grands Projets (SGP). Il a reçu des financements de la Région Auvergne-Rhône-Alpes (Projet Covoit’AURA) et de la BPI (projet Mobipart). Il a effectué des activités de conseil pour SNCF Réseau et SNCF Voyageurs.

07.01.2026 à 17:56

Microcapteurs pour suivre la qualité de l’air : gadgets ou véritables outils de suivi ?

Texte intégral (2994 mots)

Le suivi de la qualité de l’air s’est grandement démocratisé grâce à l’essor de microcapteurs électroniques accessibles à tout un chacun. Ces dispositifs sont-ils performants, et à quelles conditions peuvent-ils fournir une information utilisable ? État des lieux.

La pollution de l’air extérieur peut être liée au trafic routier, au chauffage au bois, aux activités industrielles ou encore aux feux de forêt et aux éruptions volcaniques. La diversité des particules qui en résulte illustre bien la nature diffuse et mobile de cette pollution. Celle-ci a des conséquences graves en termes d'effets sur la santé, allant des troubles respiratoires immédiats à des maladies chroniques incurables.

Selon l’Organisation mondiale de la santé (OMS), la pollution de l’air, tous polluants confondus, est responsable de 7,4 millions de décès par an dans le monde dont 4,2 millions liés à l’air extérieur et 3,2 millions à l’air intérieur. En France, le fardeau sanitaire des particules fines entraînerait à lui seul 40 000 décès chaque année, et est associés à un coût socio-économique estimé à 13 milliards d’euros.

Aujourd’hui, suivre la qualité de l’air auquel chacun est exposé n’a jamais été aussi simple. En quelques clics, il devient possible d’acheter des microcapteurs, d’accéder à des cartes en ligne ou de télécharger des applications mobiles fournissant un accès à ces données en temps réel. Tout comme la météo guide le choix de prendre un parapluie, cet accès offre aujourd’hui aux citoyens et aux décideurs un outil pratique pour orienter leurs actions.

Pourtant, derrière cette démocratisation, se pose la question de la performance de ces microcapteurs opto-électroniques. S’agit-il vraiment de sentinelles de confiance ? Faisons le point.

À lire aussi : Le potentiel oxydant : un nouvel indice pour mesurer la pollution atmosphérique

Des microcapteurs dans l’air du temps

Commençons par rappeler comment est menée la surveillance réglementaire de la qualité de l’air en France. Elle est coordonnée par le Laboratoire central de surveillance de la qualité de l’air (LCSQA) et mise en œuvre au niveau régional par les associations agréées pour la surveillance de la qualité de l’air (AASQA). Les données, librement accessibles grâce au site régional des AASQA, sont produites selon des protocoles normés afin de s’assurer qu’elles soient comparables d’une station de mesure à l’autre et d’une région à l’autre.

Toutefois, le nombre de stations de mesure mises en place résulte d’un compromis entre couverture géographique et coûts. La modélisation, basée sur les modèles Chimere ou Sirane par exemple, permet d’extrapoler la qualité de l’air sur un territoire donné, mais elle reste dépendante de la qualité et du nombre des mesures locales.

Afin de renforcer la couverture sans augmenter les coûts, la directive européenne, dont la réglementation française découle, autorise les réseaux de surveillance réglementaire à procéder à des mesures indicatives, pour lesquelles les exigences de qualité sont plus souples. Ce cadre favorise l’intégration des microcapteurs de 10 à 100 fois moins coûteux que les équipements utilisés pour les stations de référence, tant à l'achat qu’en fonctionnement.

Ce marché a le vent en poupe. En 2023, il pesait plus de 6 milliards d’euros, marché qui pourrait s’élever en 2032 à 13,5 milliards. En 2022, l’Agence nationale de sécurité sanitaire de l’alimentation, de l’environnement et du travail (Anses) dénombrait 60 000 références produits disponibles sur les plateformes de vente en ligne.

On y retrouve donc des microcapteurs à bas coût prêts à l’emploi capables de collecter et de transmettre les données en temps réel. Le prix des composants se limite à quelques dizaines d’euros, tandis que le coût total du dispositif varie d’environ une centaine à plusieurs milliers d’euros selon les fonctionnalités.

Une mesure facile, mais une interprétation parfois délicate

Que valent ces différents types de microcapteurs ? Pour le savoir, il faut d’abord définir ce que l’on souhaite mesurer lorsqu’on parle de particules fines. Loin d’être un mélange défini, les particules dans l’air forment un ensemble hétérogène et variable par leur forme, leur taille et leur état.

Trois catégories se distinguent :

les hydrométéores (pluie, neige, brouillard),

les aérosols (suie, poussières, embruns, composés organiques…)

et les bioaérosols (pollens, bactéries, virus, spores…).

Par convention, la matière particulaire en suspension (ou Particulate Matter, PM) est décrite en fonction de la taille de ses constituants, dans lesquels les hydrométéores doivent être exempts. Ainsi, par convention, les particules grossières PM10, les particules fines PM2,5 et les particules ultrafines PM0,1 représentent respectivement des ensembles hétérogènes de taille inférieure ou égale à 10, 2,5 et 0,1 micromètre (µm).

Plus les particules sont petites, plus elles sont susceptibles de pénétrer profondément dans les voies respiratoires. Les PM1,0 peuvent être également suivies par des microcapteurs et des équipements de référence, mais elles ne font pas l’objet d’une réglementation spécifique ni ne sont associées à des seuils sanitaires!

À lire aussi : Freinage et particules fines : une pollution routière oubliée des évolutions réglementaires ?

Or, les microcapteurs bas coût pour le suivi des particules, dont la mesure est basée sur leur comptage grâce à un principe optique, sont sensibles aux conditions environnementales et aux caractéristiques des particules, ce qui fragilise les performances. Leur fonctionnement repose sur la diffusion de la lumière par le passage d’une particule à travers un faisceau laser. Il s’agit du même principe qui rend visible un rayon lumineux dans la fumée. L’intensité détectée dans une direction donnée dépend de la taille, de la forme, de la composition et de l’orientation des particules.

Il faut également noter que ces microcapteurs sont calibrés avec des particules de polystyrène, loin de refléter l’hétérogénéité réelle de la pollution de l’air extérieur. S’ajoutent à cela leur encrassement et leur vieillissement, qui dégradent les performances dans le temps. L’interprétation des données exige donc une connaissance fine de ces limites.

Des données précieuses… mais sous conditions

Pour autant, les microcapteurs ne sont pas à exclure. En effet, en cas d’épisode de pollution, ils détectent les mêmes tendances que les stations réglementaires, justifiant leur usage pour des mesures indicatives.

Pour s’y retrouver, les organismes pour la surveillance de la qualité de l’air ont mené des évaluations en confrontant les microcapteurs aux équipements réglementaires. Accessibles en ligne, les résultats du challenge Airlab (Airparif, France) et de l’AQ-SPEC (South Coast AQMD, États-Unis) révèlent des corrélations satisfaisantes entre microcapteurs et ces équipements pour les PM1,0 et PM2,5. En revanche, elles sont moins bonnes pour les PM10 , car la conception des microcapteurs et le principe de la mesure ne permettent pas de bien les détecter.

Ces microcapteurs peuvent être achetés autant par des citoyens, des collectivités, des industriels, des associations ou des chercheurs. Tous ces acteurs peuvent publier leurs données sur des cartes interactives, ou y contribuer ponctuellement.

Il existe des cartes qui affichent les mesures de leurs propres microcapteurs, comme des projets associatifs et locaux tels que OpenSenseMap, Sensor.community ou SmartCitizen, ainsi que systèmes commerciaux déployés à plus grande échelle tels que AirCasting, AirGradient, Atmotube, ou Purple Air.

D’autres services, comme le World Air Quality Index ou IQAir, agrègent les données autant de microcapteurs que des réseaux réglementaires.

Contrairement aux cartes des AASQA, qui sont comparables entre elles grâce à des protocoles stricts, chaque plateforme adopte sa propre présentation.

Il est donc essentiel de bien comprendre l’information affichée : les points de mesure peuvent fournir une information visuelle qui représente une concentration (Atmotube par exemple) ou un indice de qualité de l’air (IQAir par exemple) avec un jeu de couleurs propre aux plate-formes comme des données chiffrées sans repère pour interpréter la donnée (OpenSenseMap par exemple). De plus, selon les plateformes, une même carte peut afficher tout un ensemble d’indicateurs de pollution de l’air, pas seulement ceux liés à un polluant spécifique comme les particules.

Par ailleurs, peu de plateformes précisent si les mesures sont faites en intérieur, en extérieur, en mobilité ou en point fixe. De plus, une donnée en temps réel et une donnée moyennée sur une période donnée ne sont pas comparables. De ce fait, pour une même zone géographique, la qualité de l’air affichée peut varier d’une plateforme à l’autre, selon l’emplacement de la mesure, l’indicateur utilisé et la période considérée. En France, les données des AASQA restent la référence pour une information de confiance.

Les microcapteurs n’en restent pas moins des sentinelles utilisables sous réserve d’une excellente maîtrise de leurs limites. L’utilisation individuelle de microcapteurs par le grand public peut être encadrée par un protocole rigoureux pour assurer la qualité des données et accompagner leur interprétation. Le projet d’OpenRadiation, qui porte sur la mesure de la radioactivité, en est un exemple : lorsqu’une mesure faite par l’utilisateur d’un microcapteur apparaît inhabituelle sur la carte, un gestionnaire contacte alors ce contributeur pour comprendre l’origine de cette déviation. La cartographie de la qualité de l'air s'appuie sur une plus grande quantité de microcapteurs, ce qui rend plus difficile un suivi individualisé. Néanmoins, une validation des données à l’instar de ce qui est réalisé pour le suivi réglementaire pourrait être envisagée à l’aide d’un traitement adapté, avec un filtrage par exemple.

Ainsi, comme en témoignent la Captothèque (Atmo Auvergne-Rhône-Alpes) ou Ambassad’air (Rennes), programmes de sciences participatives basés sur la mesure citoyenne de la qualité de l’air, les microcapteurs peuvent non seulement fournir des indications, mais aussi contribuer à l’engagement citoyen pour l’observation environnementale.

À lire aussi : Ces citoyens qui mesurent la radioactivité de leur environnement

Marie Bellugue Duclos a reçu des financements du CNRS pour sa thèse. Elle utilise des micro-capteurs pour ses recherches.

Denis Machon a reçu des financements du CNRS et de l'ANR (France), du CRSNG (Canada) et du FRQ (Québec).

Michael Canva a reçu des financements du CNRS et de l’ANR (France), du CRSNG (Canada) et du FRQ (Québec).

07.01.2026 à 11:39

Une proposition de loi veut supprimer l’obligation d’utiliser un cercueil et relancer le débat sur la liberté des funérailles

Texte intégral (1249 mots)

Une proposition de loi déposée à la toute fin 2025 entend rouvrir un débat ancien mais de plus en plus actuel : celui du choix réel des modalités de disposition du corps après la mort, au-delà du seul face-à-face entre inhumation et crémation.

L’actualité du droit funéraire est très vivante ces dernières années et cela n’est pas prêt de s’arrêter. Pour preuve, une proposition de loi a été déposée le 23 décembre 2025, proposition visant à rendre effective la liberté des funérailles à travers le développement d’alternatives à l’inhumation et à la crémation et s’inscrivant dans la lignée d’une proposition précédente visant à développer l’humusation, un sujet qui reste dans l’actualité depuis 2023 malgré une certaine instabilité politique.

Quel est l’objet de cette nouvelle proposition de loi ?

La proposition de loi no 2297 portée par le député LFI François Piquemal (4ᵉ circonscription de Haute-Garonne) vise « à rendre effective la liberté des funérailles ». Autrement dit, l’enjeu de ce texte n’est pas de promouvoir une alternative en particulier à l’inhumation et à la crémation mais d’offrir une plus grande marge de manœuvre aux citoyennes et citoyens français quant au choix de leurs funérailles. Pour rappel, il s’agit normalement d’une liberté déjà inscrite dans la loi de 1887 sur la liberté des funérailles mais qui est souvent interprétée comme une liberté « contrainte » puisque cantonnée au choix entre inhumation ou crémation avec obligation de recourir à un cercueil dans les deux cas.

Ainsi, le texte propose de renforcer cette liberté par une mesure forte : l’abrogation de l’obligation d’utiliser un cercueil au profit d’une liberté de choix de l’enveloppe mortuaire (article 2), suivie d’une invitation à la reconnaissance légale d’alternatives à l’inhumation et la crémation (la terramation, l’humusation et l’aquamation sont ainsi nommées dans l’article 3 de la proposition).

Là est la différence majeure entre cette proposition de loi et celle de 2023 citée en introduction : la liberté de choix de l’enveloppe mortuaire. Autant les alternatives à l’inhumation et à la crémation commencent à être connues, autant il s’agit là d’une mesure totalement inédite qui vient porter un coup à plus de 200 ans de tradition juridique, l’obligation légale d’utiliser un cercueil datant d’un arrêté du préfet de Paris de 1801 pour des raisons d’hygiène.

Enfin, là où cette nouvelle proposition de loi rejoint la précédente, c’est sur la technique légistique de l’expérimentation. Les deux propositions proposent de passer par la voie de l’expérimentation avec un délai plus crédible pour la nouvelle proposition (5 ans) contre 6 mois seulement dans celle de 2023.

Une proposition inspirée par l’actualité internationale du droit funéraire

Cette nouvelle proposition de loi n’est pas une initiative isolée. Cela commence à faire plusieurs années que nous entendons parler de reconnaissances légales d’alternatives à l’inhumation et à la crémation. C’est le cas notamment aux États-Unis, en Allemagne et peut-être bientôt en Suisse.

Ce mouvement de légalisation dans le monde témoigne d’une nouvelle sensibilité écologique et de l’aspiration de nos concitoyens à davantage de liberté dans l’organisation des funérailles.

La France n’est d’ailleurs pas le seul pays à réfléchir à l’abrogation de l’obligation légale d’utiliser un cercueil. En région bruxelloise (Belgique) il est ainsi permis depuis janvier 2019 de s’affranchir du cercueil au profit d’un linceul. On reconnait ici la théorie défendue par Alexandre Flückiger, légisticien, selon laquelle « le droit d’un État voisin est susceptible de déployer des effets d’ordre recommandationnel sur un territoire limitrophe. Le droit étranger déploie dans ce contexte un effet symbolique qui agirait sur les comportements au même titre qu’une recommandation très implicite. »

La situation en France

Enfin, en dehors de la proposition de loi, il est possible de trouver plusieurs indicateurs sur le sol français qui démontrent un vif intérêt pour une plus grande liberté des funérailles et pour l’abrogation de l’obligation légale du cercueil.

À défaut de pouvoir supprimer le cercueil, certains réfléchissent à le rendre plus vert. À Saint-Étienne, la jeune entreprise Pivert Funéraire a ainsi créé un modèle pour crémation fabriqué à partir de déchet des industries sylvicoles et oléicoles.

D’autres organisent des colloques académiques sur le sujet. C’est l’exemple du colloque récent « Cercueil(s) & droit(s) », qui s’est tenu à l’Université Toulouse Capitole, le 28 novembre 2025.

D’autres encore mènent des expériences effectives sur le déploiement d’alternatives à l’inhumation et la crémation. C’est l’exemple de l’expérimentation sur des brebis qui a lieu dans l’Essonne à travers le projet ANR F-Compost.

En somme, les acteurs de la recherche et des pompes funèbres préparent le terrain pour que des projets, comme celui porté par cette proposition de loi, puissent voir le jour. Si une réserve pouvait être émise il y a quelques années sur l’intérêt du Parlement pour ces questions, il est permis de penser qu’à plus de cent ans la loi sur la liberté des funérailles pourrait bientôt connaître une nouvelle vie…

Jordy Bony a travaillé avec le comité de recherche de l'association Humo Sapiens, pour une mort régénérative qui œuvre pour promouvoir et expérimenter la terramation en France.

06.01.2026 à 16:53

Du sauveur à l’éboueur : comment les lycéens perçoivent leurs éco-délégués

Texte intégral (3207 mots)

Voilà cinq ans que les élèves du secondaire ont l’obligation d’élire des éco-délégués dans chaque classe. Dans les faits cependant, cette intention n’est pas toujours respectée, et les perceptions quant à leur rôle varient fortement d’un établissement à l’autre.

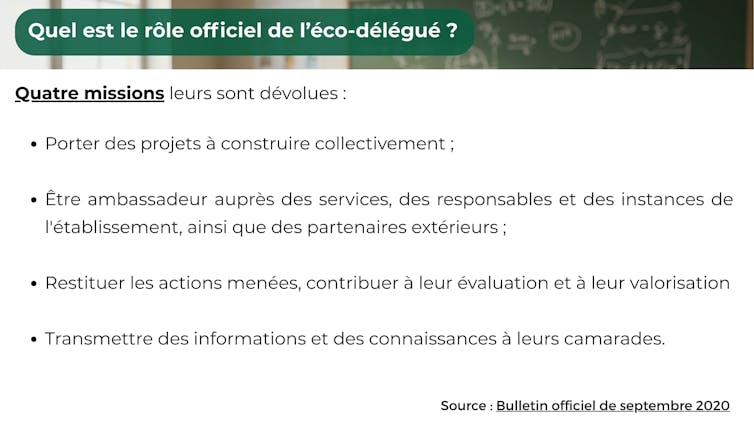

À quoi servent les éco-délégués ? « Je ne sais pas », « aucune idée », « on n’a pas d’infos », ont répondu la moitié des 380 lycéens interrogés au sujet de leur expérience de l’éducation au développement durable dans leur lycée. Pourtant, chaque établissement scolaire a l’obligation d’organiser l’élection d’au moins un éco-délégué par classe, et ce depuis 2020.

Considérés comme les « pivots du développement durable dans les établissements », l’État les exhorte à devenir les « acteurs du changement » au sein d’un « peuple de colibris », à travers la voix de Jean-Michel Blanquer, alors ministre de l’éducation nationale.

Cinq ans après cette mise en place obligatoire des éco-délégués, « la tension entre ces injonctions et les réalités du terrain » déjà évoquée en 2023 par les chercheuses Évelyne Bois, Aurélie Zwang et Mandarine Hugon, est toujours palpable.

À lire aussi : Être éco-délégués au collège ou au lycée : quels moyens d’action ?

Un bilan difficile à dresser en l’absence de données officielles

Le ministère de l’éducation nationale affiche certes l’ambition de 250 000 éco-délégués et promeut des ressources et dispositifs d’appui (guides pratiques, prix de l’action de l’éco-délégué, etc.). Cependant, aucun recensement officiel n’est disponible, ni à l’échelle de la direction de l’évaluation, de la prospective et de la performance (DEPP), ni à celle des académies, ni même parfois à celle des établissements. Il est donc compliqué de savoir si chaque classe compte actuellement une ou un éco-délégué. Le travail de terrain nous permet toutefois de déceler que cette obligation n’est pas toujours suivie dans les faits.

Pour tenter de comprendre malgré tout le rôle effectif des éco-délégués, plusieurs ressources sont néanmoins disponibles :

une enquête menée en 2023-2024 en région Bretagne auprès d’établissements engagés dans des projets d’éducation au développement durable (EDD), relevant de l’éducation nationale ou de l’enseignement agricole, du secteur public ou privé, de la voie générale ou professionnelle.

les quelques travaux existants en science de l’éducation sur l’engagement des éco-délégués.

un discret et polémique rapport parlementaire portant sur l’animation des éco-délégués.

À la rencontre des éco-délégués

Des 380 répondants au questionnaire administré auprès de lycéens de Bretagne, 85 % indiquent la présence d’éco-délégués dans leur établissement, même au sein d’un lycée n’ayant pas encore mis en place le dispositif. Moins de 5 % déclarent être eux-mêmes éco-délégué au moment de l’enquête.

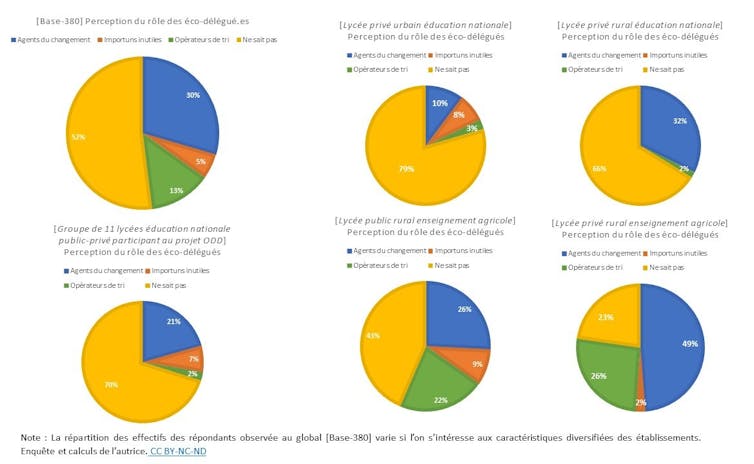

À la question « Quelles sont les activités menées par les éco-délégué·es ? », la réponse la plus fréquente (52 %) est donc « Je ne sais pas » ou sans réponse. La question étant ouverte, nous avons pu classer les réponses détaillées des 173 élèves ayant une idée des activités menées. Trois catégories d’acteurs peuvent alors se distinguer dans leurs perceptions du rôle des éco-délégués.

- Les « agents du changement » (30 %) : les éco-délégués sont avant tout perçus comme les prescripteurs des éco-gestes : ils « trouvent des activités sympas pour insister à ne pas polluer », note une lycéenne. Ils développent, souvent à l’aide de prestataires extérieurs, des nudges inspirés des théories du comportement, pour inciter à la préservation des ressources : une « affiche pour éteindre la lumière », un « autocollant qui se complète que lorsque l’on ferme la fenêtre », un « totem pour recycler le papier »… avec plus ou moins d’efficacité.

Ils peuvent aussi investir des espaces spécifiques, comme un potager, un jardin, un « club nature », ou contribuer à végétaliser la cour. Ils se réunissent souvent le midi, seul temps disponible pour les enseignants comme pour les élèves.

L’éco-délégué est parfois identifié comme l’ambassadeur dont on attend qu’il soit : celui qui « explique les actions et réfléchit à de nouvelles stratégies », qui « présente et propose les projets et motive les élèves », résument des enquêtés. Sa mission de sensibilisation peut progressivement consister à « s’interroger », « trouver des idées pour améliorer le monde pour plus tard », voire à « donner des cours aux camarades », énumèrent d’autres lycéens. Leurs actions « parfois petites mais qui font grandir le lycée » sont vues avec bienveillance. Ils contribuent à « améliorer la vie en communauté pour ne pas avoir à souffrir plus tard », assure une élève. Ils peuvent être perçus comme des innovateurs et apporter des solutions pour « sauver notre terre et l’améliorer », comme l’indique une éco-déléguée.

De façon très marginale, des actions en dehors de la sphère environnementale qui domine les discours sont parfois citées : comme de la sensibilisation sur le handicap, la mise en place de produits d’hygiène féminine ou des « boîtes à livres ».

« Les importuns inutiles » (5 %) : Pour certains, les éco-délégués ne font « rien », ou « pas grand-chose ». Leurs rencontres sont identifiées comme l’occasion de « rater les cours pour faire des réunions souvent inutiles » ou pour lesquelles « nous n’avons aucun retour », déplore un élève. Les élèves d’un lycée agricole public en zone rurale sont parmi ceux qui ont les mots les plus durs : les éco-délégués « nous cassent les oreilles » ou sont là « pour faire joli et apporter des idées qui n’aboutissent jamais ».

« Les opérateurs de tri » (13 %) : Les éco-délégués ramassent, trient, nettoient, compostent, luttent contre le gaspillage, construisent des poubelles, font des « clean walk » dans leurs lycées, dans leurs villes, sur les plages… Les déchets identifiés sont ceux qui sont visibles, comme le papier ou les mégots, alors que les déchets numériques qui ne cessent de croître ne sont pas mentionnés.