16.01.2026 à 14:58

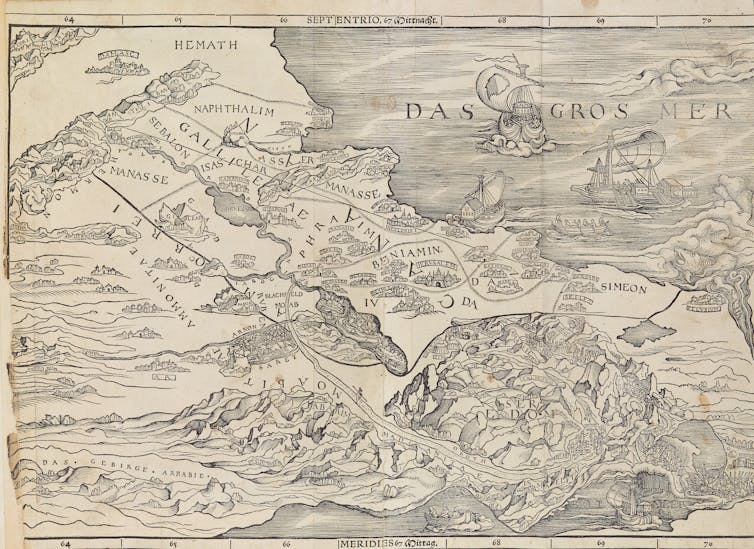

Avant le pétrole vénézuelien, il y a eu les bananes du Guatemala…

Texte intégral (2645 mots)

Dans les années 1950 déjà, les États-Unis intervenaient contre un gouvernement démocratiquement élu au nom d’une menace idéologique, tout en protégeant des intérêts économiques majeurs. Mais si les ressorts se ressemblent, les méthodes et le degré de transparence ont profondément changé.

Dans la foulée de la frappe militaire américaine qui a conduit à l’arrestation du président vénézuélien Nicolás Maduro le 3 janvier 2026, l’administration Trump a surtout affiché son ambition d’obtenir un accès sans entrave au pétrole du Venezuela, reléguant au second plan des objectifs plus classiques de politique étrangère comme la lutte contre le trafic de drogue ou le soutien à la démocratie et à la stabilité régionale.

Lors de sa première conférence de presse après l’opération, le président Donald Trump a ainsi affirmé que les compagnies pétrolières avaint un rôle important à jouer et que les revenus du pétrole contribueraient à financer toute nouvelle intervention au Venezuela.

Peu après, les animateurs de « Fox & Friends » ont interpelé Trump sur ces prévisions :

« Nous avons les plus grandes compagnies pétrolières du monde », a répondu Trump, « les plus importantes, les meilleures, et nous allons y être très fortement impliqués ».

En tant qu’historien des relations entre les États-Unis et l’Amérique latine, je ne suis pas surpris de voir le pétrole, ou toute autre ressource, jouer un rôle dans la politique américaine à l’égard de la région. Ce qui m’a en revanche frappé, c’est la franchise avec laquelle l’administration Trump reconnaît le rôle déterminant du pétrole dans sa politique envers le Venezuela.

Comme je l’ai détaillé dans mon livre paru en 2026, Caribbean Blood Pacts: Guatemala and the Cold War Struggle for Freedom (NDT : livre non traduit en français), les interventions militaires américaines en Amérique latine ont, pour l’essentiel, été menées de manière clandestine. Et lorsque les États-Unis ont orchestré le coup d’État qui a renversé le président démocratiquement élu du Guatemala en 1954, ils ont dissimulé le rôle qu’avaient joué les considérations économiques dans cette opération.

Un « poulpe » puissant

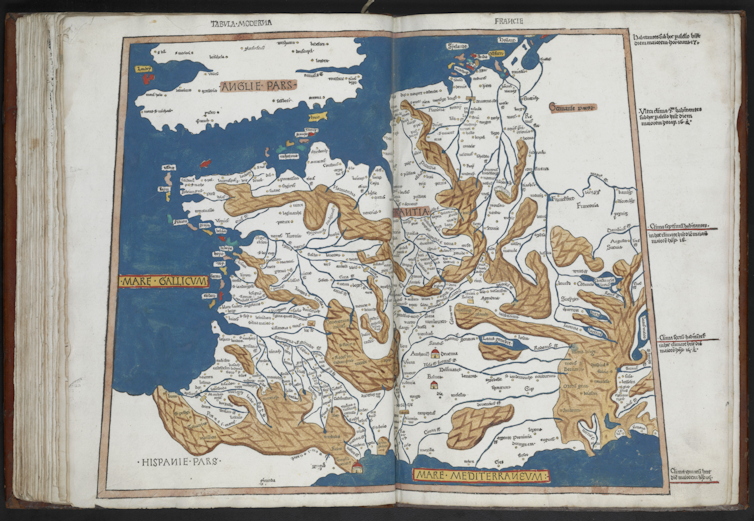

Au début des années 1950, le Guatemala était devenu l’une des principaux fournisseurs de bananes pour les Américains, comme c’est d'ailleurs toujours le cas aujourd’hui.

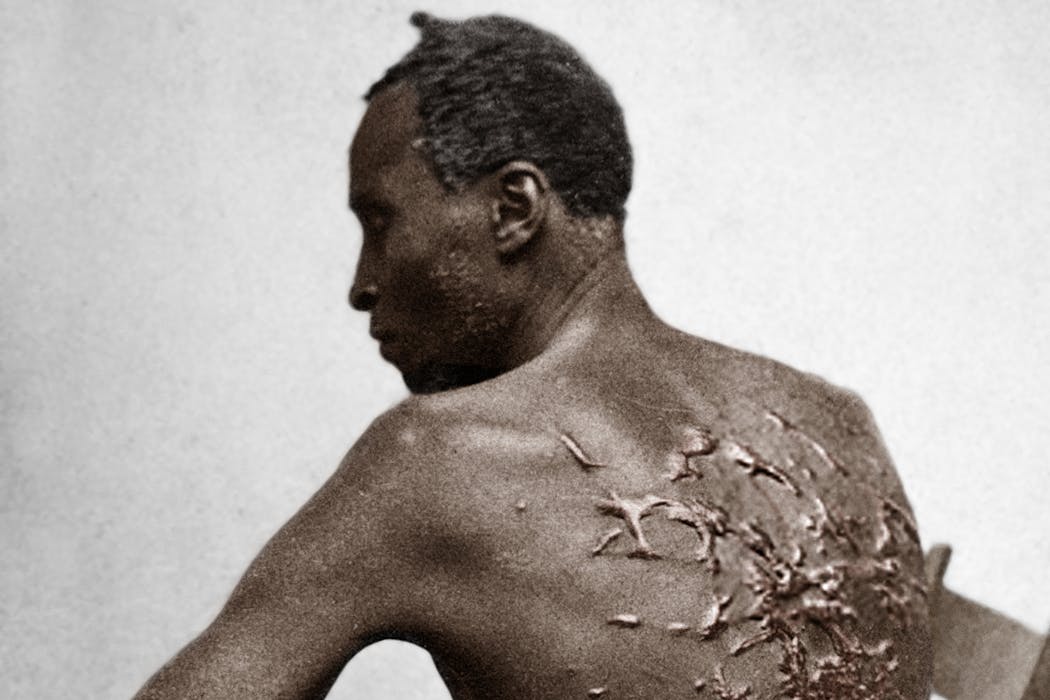

La United Fruit Company possédait alors plus de 220 000 hectares de terres guatémaltèques, en grande partie grâce aux accords conclus avec les dictatures précédentes. Ces propriétés reposaient sur le travail intensif d’ouvriers agricoles pauvres, souvent chassés de leurs terres traditionnelles. Leur rémunération était rarement stable, et ils subissaient régulièrement des licenciements et des baisses de salaire.

Basée à Boston, cette multinationale a tissé des liens avec des dictateurs et des responsables locaux en Amérique centrale, dans de nombreuses îles des Caraïbes et dans certaines régions d’Amérique du Sud afin d’acquérir d’immenses domaines destinés aux chemins de fer et aux plantations de bananes.

Les populations locales la surnommaient le « pulpo » – « poulpe » en espagnol – car l’entreprise semblait intervenir dans la structuration de la vie politique, de l'économie et de la vie quotidienne de la région. En Colombie, le gouvernement a par exemple brutalement réprimé une grève des travailleurs de la United Fruit en 1928, faisant des centaines de morts. Cet épisode sanglant de l’histoire colombienne a d'ailleurs servi de base factuelle à une intrigue secondaire de « Cent ans de solitude », le roman épique de Gabriel García Márquez, lauréat du prix Nobel de littérature en 1982.

L’influence apparemment sans limites de l’entreprise dans les pays où elle opérait a nourri le stéréotype des nations d’Amérique centrale comme des « républiques bananières ».

La révolution démocratique guatémaltèque

Au Guatemala, pays historiquement marqué par des inégalités extrêmes, une vaste coalition s’est formée en 1944 pour renverser la dictature répressive lors d’un soulèvement populaire. Inspirée par les idéaux antifascistes de la Seconde Guerre mondiale, cette coalition ambitionnait de démocratiser le pays et de rendre son économie plus équitable.

Après des décennies de répression, les nouveaux dirigeants ont offert à de nombreux Guatémaltèques leur premier contact avec la démocratie. Sous la présidence de Juan José Arévalo, élu démocratiquement et en fonction de 1945 à 1951, le gouvernement a mis en place de nouvelles protections sociales ainsi qu’un code du travail légalisant la création et l’adhésion à des syndicats, et instaurant la journée de travail de huit heures.

En 1951, lui a succédé Jacobo Árbenz, lui aussi président démocratiquement élu.

Sous Árbenz, le Guatemala a mis en œuvre en 1952 un vaste programme de réforme agraire, attribuant des parcelles non exploitées aux ouvriers agricoles sans terre. Le gouvernement guatémaltèque affirmait que ces politiques permettraient de bâtir une société plus équitable pour la majorité indigène et pauvre du pays.

United Fruit a dénoncé ces réformes comme le produit d’une conspiration mondiale. L’entreprise affirmait que la majorité des syndicats du pays étaient contrôlés par des communistes mexicains et soviétiques, et présentait la réforme agraire comme une manœuvre visant à détruire le capitalisme.

Pression sur le Congrès pour une intervention

Au Guatemala, United Fruit a cherché à rallier le gouvernement américain à son combat contre les politiques menées par Árbenz. Si ses dirigeants se plaignaient bien du fait que les réformes guatémaltèques nuisaient à ses investissements financiers et alourdissaient ses coûts de main-d’œuvre, ils présentaient aussi toute entrave à leurs activités comme faisant partie d’un vaste complot communiste.

L’entreprise a mené l'offensive à travers une campagne publicitaire aux États-Unis et en exploitant la paranoïa anticommuniste dominante de l’époque.

Dès 1945, les dirigeants de la United Fruit Company ont commencé à rencontrer des responsables de l’administration Truman. Malgré le soutien d’ambassadeurs favorables à leur cause, le gouvernement américain ne semblait pas disposé à intervenir directement dans les affaires guatémaltèques. L’entreprise s’est alors tournée vers le Congrès, recrutant les lobbyistes Thomas Corcoran et Robert La Follette Jr., ancien sénateur, pour leurs réseaux politiques.

Dès le départ, Corcoran et La Follette ont fait pression auprès des républicains comme des démocrates, dans les deux chambres du Congrès, contre les politiques guatémaltèques – non pas en les présentant comme une menace pour les intérêts commerciaux de United Fruit, mais comme les éléments d’un complot communiste visant à détruire le capitalisme et les États-Unis.

Les efforts de la compagnie bananière ont porté leurs fruits en février 1949, lorsque plusieurs membres du Congrès ont dénoncé les réformes du droit du travail au Guatemala comme étant d’inspiration communiste. Le sénateur Claude Pepper a qualifié le code du travail de texte « manifestement et intentionnellement discriminatoire à l’égard de cette entreprise américaine » et d’« une mitrailleuse pointée sur la tête » de la United Fruit Company.

Deux jours plus tard, le membre de la Chambre des représentants John McCormack a repris mot pour mot cette déclaration, utilisant exactement les mêmes termes pour dénoncer les réformes. Les sénateurs Henry Cabot Lodge Jr., Lister Hill et le représentant Mike Mansfield ont eux aussi pris position publiquement, en reprenant les éléments de langage figurant dans les notes internes de la United Fruit.

Aucun élu n’a prononcé un mot sur les bananes.

Lobbying et campagnes de propagande

Ce travail de lobbying, nourri par la rhétorique anticommuniste, a culminé cinq ans plus tard, lorsque le gouvernement américain a orchestré un coup d’État qui a renversé Árbenz lors d’une opération clandestine.

L’opération a débuté en 1953, lorsque l’administration Eisenhower a autorisé la CIA à lancer une campagne de guerre psychologique destinée à manipuler l’armée guatémaltèque afin de renverser le gouvernement démocratiquement élu. Des agents de la CIA ont alors soudoyé des membres de l’armée guatémaltèque tandis que des émissions de radio anticommunistes étaient diffusées et un discours, porté par les religieux et dénonçant un prétendu projet communiste visant à détruire l’Église catholique du pays, se propageait dans tout le Guatemala.

Parallèlement, les États-Unis ont armé des organisations antigouvernementales à l’intérieur du Guatemala et dans les pays voisins afin de saper davantage encore le moral du gouvernement Árbenz. La United Fruit a également fait appel au pionnier des relations publiques Edward Bernays pour diffuser sa propagande, non pas au Guatemala mais aux États-Unis. Bernays fournissait aux journalistes américains des rapports et des textes présentant le pays d’Amérique centrale comme une marionnette de l’Union soviétique.

Ces documents, dont un film intitulé « Why the Kremlin Hates Bananas », ont circulé grâce à des médias complaisants et à des membres du Congrès complices.

Détruire la révolution

En définitive – et les archives le démontrent –, l’action de la CIA a conduit des officiers de l’armée à renverser les dirigeants élus et à installer un régime plus favorable aux États-Unis, dirigé par Carlos Castillo Armas. Des Guatémaltèques opposés aux réformes ont massacré des responsables syndicaux, des responsables politiques et d’autres soutiens d’Árbenz et Arévalo. Selon des rapports officiels, au moins quarante-huit personnes sont mortes dans l’immédiat après-coup, tandis que des récits locaux font état de centaines de morts supplémentaires.

Pendant des décennies, le Guatemala s'est retrouvé aux mains de régimes militaires. De dictateur en dictateur, le pouvoir a réprimé brutalement toute opposition et instauré un climat de peur. Ces conditions ont contribué à des vagues d’émigration, comprenant d’innombrables réfugiés, mais aussi certains membres de gangs transnationaux.

Le retour de bâton

Afin d’étayer l’idée selon laquelle ce qui s’était produit au Guatemala n’avait rien à voir avec les bananes — conformément au discours de propagande de l’entreprise — l’administration Eisenhower a autorisé une procédure antitrust contre United Fruit, procédure qui avait été temporairement suspendue pendant l’opération afin de ne pas attirer davantage l’attention sur la société.

Ce fut le premier revers d’une longue série qui allait conduire au démantèlement de la United Fruit Company au milieu des années 1980. Après une succession de fusions, d’acquisitions et de scissions, ne demeure finalement que l’omniprésent logo de Miss Chiquita, apposé sur les bananes vendues par l’entreprise.

Et, selon de nombreux spécialistes des relations internationales, le Guatemala ne s’est jamais remis de la destruction de son expérience démocratique, brisée sous la pression des intérêts privés.

Les recherches d’Aaron Coy Moulton ont bénéficié de financements du Truman Library Institute, de Phi Alpha Theta, de la Society for Historians of American Foreign Relations, du Roosevelt Institute, de l’Eisenhower Foundation, de la Massachusetts Historical Society, de la Bentley Historical Library, de l’American Philosophical Society, du Dirksen Congressional Center, de la Hoover Presidential Foundation et du Frances S. Summersell Center for the Study of the South.

15.01.2026 à 16:01

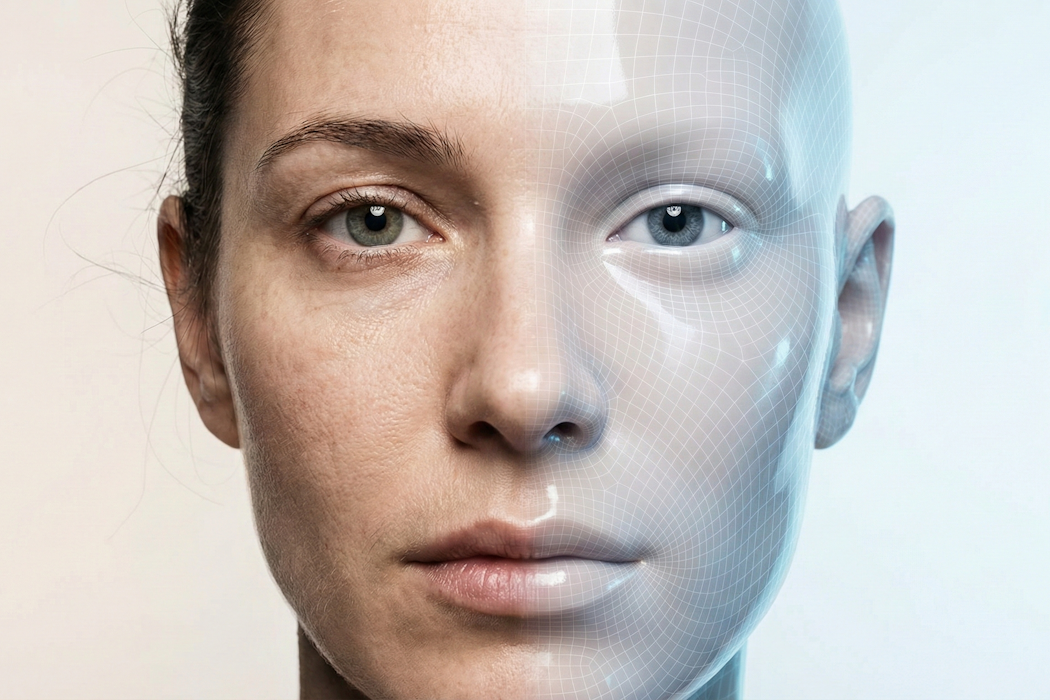

En 2026, à quoi vont ressembler les nouveaux deepfakes qui vont déferler sur nos écrans

Texte intégral (1455 mots)

En 2025, la génération de deepfakes a explosé : visages, voix et mouvements du corps créés par des systèmes d’intelligence artificielle deviennent presque indiscernables des humains, bouleversant la perception et la sécurité des contenus en ligne.

Au cours de l’année 2025, les techniques de génération de deepfakes ont connu une évolution spectaculaire. Les visuels de visages, de voix et de corps entiers générés des systèmes d’IA ont gagné en qualité – bien au-delà de ce que beaucoup d’experts imaginaient encore il y a quelques années. Ces vidéos sont aussi davantage utilisées pour tromper ceux qui les regardent.

Dans de nombreuses situations du quotidien – en particulier les appels vidéo de faible résolution et les contenus diffusés sur les réseaux sociaux –, leur réalisme est désormais suffisant pour berner à coup sûr des publics non spécialistes. Concrètement, les médias synthétiques sont devenus indiscernables d’enregistrements authentiques pour le grand public et, dans certains cas, même pour des institutions.

Et cette flambée ne se limite pas à la qualité. Le volume de deepfakes générés a lui aussi explosé : l’entreprise de cybersécurité DeepStrike estime qu’on est passé d’environ 500 000 vidéos de ce type présentes en ligne en 2023 à près de 8 millions en 2025, avec une croissance annuelle proche de 900 %.

Je suis informaticien et je mène des recherches sur les deepfakes et d’autres médias synthétiques. De mon point de vue, la situation risque encore de s’aggraver en 2026, à mesure que les deepfakes évolueront vers des entités synthétiques capables d’interagir en temps réel avec des humains.

Des améliorations spectaculaires

Plusieurs évolutions techniques expliquent cette escalade. Tout d’abord, le réalisme a franchi un cap grâce à des modèles de génération de vidéos conçus spécifiquement pour maintenir la cohérence temporelle. Ces modèles produisent des vidéos aux mouvements cohérents, avec des identités stables pour les personnes représentées et un contenu logique d’une image à l’autre. Ils dissocient les informations liées à la représentation de l’identité d’une personne de celles relatives au mouvement, ce qui permet d’appliquer un même mouvement à différentes identités ou, inversement, d’associer une même identité à plusieurs types de mouvements.

Ces modèles génèrent des visages stables et cohérents, sans les scintillements, déformations ou anomalies structurelles autour des yeux et de la mâchoire qui constituaient des signes techniques fiables de deepfakes auparavant.

Deuxièmement, le clonage vocal a franchi ce que j’appellerais le « seuil d’indiscernabilité ». Quelques secondes d’audio suffisent désormais pour générer un clone convaincant – avec une intonation, un rythme, des accents, des émotions, des pauses et même des bruits de respiration naturels. Cette capacité alimente déjà des fraudes à grande échelle. De grands distributeurs indiquent recevoir plus de 1 000 appels frauduleux générés par l’IA chaque jour. Les indices perceptifs qui permettaient autrefois d’identifier des voix synthétiques ont en grande partie disparu.

Troisièmement, les outils grand public ont fait chuter la barrière technique à un niveau proche de zéro. Les évolutions d’OpenAI avec Sora 2, de Google avec Veo 3 et l’émergence d’une vague de start-up font qu’il suffit aujourd’hui de décrire une idée et de laisser un grand modèle de langage comme ChatGPT d’OpenAI ou Gemini de Google rédiger un script, pour générer en quelques minutes des contenus audiovisuels aboutis. Des agents d’IA peuvent automatiser l’ensemble du processus. La capacité à produire à grande échelle des deepfakes cohérents et construits autour d’un récit s’est ainsi largement démocratisée.

Cette combinaison d’une explosion des volumes et de figures synthétiques devenues presque indiscernables d’êtres humains réels pose de sérieux défis pour la détection des deepfakes, en particulier dans un environnement médiatique où l’attention est fragmentée et où les contenus circulent plus vite qu’ils ne peuvent être vérifiés. Des dommages bien réels ont déjà été constatés – de la désinformation au harcèlement ciblé et aux arnaques financières – facilités par des deepfakes qui se propagent avant que le public n’ait le temps de comprendre ce qui se passe.

Le temps réel, nouvelle frontière

Pour l’année à venir, la trajectoire est claire : les deepfakes se dirigent vers une synthèse en temps réel capable de produire des vidéos reproduisant fidèlement les subtilités de l’apparence humaine, ce qui facilitera le contournement des systèmes de détection. La frontière évolue du réalisme visuel statique vers la cohérence temporelle et comportementale : des modèles qui génèrent du contenu en direct ou quasi direct plutôt que des séquences préenregistrées.

La modélisation de l’identité converge vers des systèmes unifiés qui capturent non seulement l’apparence d’une personne, mais aussi sa façon de bouger et de parler selon les contextes. Le résultat dépasse le simple « cela ressemble à la personne X » pour devenir « cela se comporte comme la personne X sur la durée ». Je m'attends à ce que des participants à des appels vidéo soient synthétisés en temps réel ; à voir des acteurs de synthèse pilotés par l’IA dont le visage, la voix et les gestes s’adaptent instantanément à une consigne ; et à ce que des arnaqueurs déploient des avatars réactifs plutôt que des vidéos fixes.

À mesure que ces capacités se développent, l’écart perceptuel entre humains authentiques et synthétiques continuera de se réduire. La véritable ligne de défense ne reposera plus sur le jugement humain, mais sur des protections au niveau des infrastructures. Cela inclut des mécanismes de traçabilité sécurisée, comme la signature cryptographique des médias et l’adoption par les outils de génération IA des spécifications de la Coalition for Content Provenance and Authenticity. Cela dépendra également d’outils d’analyse multimodaux, comme le Deepfake-o-Meter que je développe avec mes équipes dans mon laboratoire.

Se contenter d’examiner les pixels attentivement ne suffira plus.

Siwei Lyu ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

15.01.2026 à 15:59

Streaming de jeux vidéo : femmes, LGBTQIA+ et personnes racisées face à la cyberviolence

Texte intégral (2015 mots)

La cyberviolence est omniprésente dans le domaine du streaming – en particulier de jeux vidéo – et touche particulièrement les personnes minorisées, au point d’infléchir carrières et pratiques. Quels mécanismes sont à l’œuvre ? À l’heure où la visibilité se paie cher, comment rendre ces espaces numériques plus vivables ?

Depuis le milieu des années 2010, l’intérêt porté par la recherche et par le grand public s’est progressivement déplacé des « effets des jeux vidéo violents » ou des jeux vidéo « qui rendent violents » à la place de la violence ordinaire dans les interactions entre membres d’une situation de jeu. Parmi les terrains de la cyberviolence, la diffusion en direct de sessions de jeux vidéo (streaming) est fortement concernée.

Cette violence s’observe entre les joueurs et joueuses, au cours des parties en ligne, mais également de la part du public qui peut participer activement à travers l’interface de discussion (chat). Selon une récente étude de l’ADL Center for Technology and Society, plus du trois quarts des joueurs adultes aux États-Unis ont subi une forme de cyberviolence, allant de l’insulte en ligne au harcèlement.

Le streaming prend aujourd’hui des formes variées et se déploie sur une pluralité de plateformes, dont Twitch, YouTube ou Kick. Twitch demeure la plus utilisée : en 2024, elle représentait environ 61 % du total des heures de visionnage live dans le secteur de la webdiffusion.

Dans nos travaux, nous nous intéressons aux violences que subissent les streameurs et streameuses de jeux vidéo, un phénomène encore largement sous-estimé malgré ses effets concrets sur les pratiques et la carrière des vidéastes.

Les personnes minorisées tenues à l’écart

La cyberviolence touche durement Twitch, un « environnement communicationnel » où la personne qui diffuse est placée dans une « position exposée », livrée aux regards et aux prises de parole – parfois peu amènes – d’un large public. Le streaming fonctionne comme un régime de visibilité qui valorise l’« authenticité », la « proximité », l’humour et la « spontanéité ». Il se caractérise par une forte dimension spectatorielle et spectaculaire, qui cristallise la cyberviolence.

D’une part, les comportements violents surgissent de manière cyclique dans les environnements multijoueurs et les chats : les provocations et la toxicité entre les joueurs et joueuses sont monnaie courante, la violence peut même être encouragée par les streameurs et streameuses. D’autre part, le public peut se comporter en perturbateur intentionnel et faire dérailler la performance de la webdiffusion par des propos inappropriés, voire violents, publiés dans le chat, surtout quand ces propos deviennent collectifs et prennent la forme de « raids haineux ».

Comme en témoignait, en 2023, une vidéaste de Suisse romande déplorant la banalité et la violence de ces actes de harcèlement :

« On reçoit des compliments, des propositions sexuelles, mais aussi des menaces de mort. »

Ces agressions semblent même encouragées par le modèle économique des plateformes, dans la mesure où elles suscitent des controverses qui permettent d’augmenter le nombre de vues, mais aussi d’abonnés (followers) et de dons monétaires de leur part.

Les micro-agressions s’y accumulent de telle sorte qu’elles peuvent créer un environnement hostile et excluant pour les personnes minorisées qui s’adonnent à l’activité de webdiffusion. Par « groupes minorisés », on désigne notamment les femmes, les personnes racisées ou encore les personnes LGBTQIA+, qui sont statistiquement très exposées aux attaques : 49 % des femmes, 42 % des personnes noires et 39 % des personnes LGBTQIA+ déclarent avoir été harcelées en ligne sur la base de leur identité, tandis que 82 % des victimes de violences sexistes ou sexuelles sont des femmes ou des filles.

Une brutalisation croissante

Dans le contexte de la culture vidéoludique, historiquement façonnée par la masculinité hégémonique toxique et geek, la position exposée des streameurs et streameuses est loin de garantir aux personnes minorisées la légitimité accrue qu’elle confère aux joueurs (blancs et) masculins.

Cette visibilité fonctionne de manière différenciée : si elle tend à renforcer la crédibilité des hommes, elle offre en revanche davantage de prises aux critiques et aux attaques visant celles et ceux qui n’appartiennent pas à cette catégorie, les exposant à la surveillance de leurs comportements en jeu, à la mise en cause de leur légitimité et à du cyberharcèlement, ce qui rend leur maintien dans les environnements en ligne comparable à une course d’obstacles.

Participant à part entière à la dynamique de la webdiffusion, que ce soit par le soutien ou la moquerie, mais aussi l’insulte, le public contribue à la présence systémique de comportements sexistes, racistes, et parfois à l’humiliation constante de streameurs et streameuses. Ce dernier point s’est tristement et fatalement illustré avec le décès en direct du streameur Jean Pormanove en août 2025 sur Kick, une plateforme critiquée pour la faiblesse de son système de modération. Ici, les encouragements du public ont conduit au pire, poussant les personnes humiliant Jean Pormanove à poursuivre leurs sévices des jours durant.

Les recherches les plus récentes semblent indiquer ainsi une brutalisation croissante dans les usages quotidiens du Web, caractérisée par un double processus de banalisation et de légitimation de la violence dans les espaces (publics) numériques.

Une régulation déficiente, des stratégies d’adaptation épuisantes

Les règles de modération sur les plateformes de streaming oscillent entre approches réactives punitives – fondées sur la sanction a posteriori et, dans les cas les plus extrêmes, le bannissement définitif – et approches proactives, qui visent à prévenir les comportements offensants.

Sur Twitch, la régulation consiste essentiellement à punir les fauteurs de troubles. Elle s’exerce, d’une part, de manière centralisée, via des algorithmes et des lignes de conduite générales. Ces règles peuvent mener à la suppression de contenus, une suspension temporaire ou un bannissement, mais leur application dépend largement des signalements et du travail de modérateurs et modératrices bénévoles. D’autre part, la régulation s’opère de manière décentralisée par l’entremise des streameurs et streameuses (qui disposent d’un pouvoir discrétionnaire sur leur chaîne) et de leurs équipes. Son efficacité est limitée puisqu’elle repose aussi en grande partie sur le travail gratuit des modérateurs et modératrices qui font face à des offenses massives et continues.

Dans ce contexte, les streameurs et streameuses subissant des agressions entreprennent de nombreux efforts pour se préserver en essayant de « recadrer » les membres de leur audience qui les agressent. Nous avons étudié à ce propos le cas de l’expulsion d’un spectateur sexiste par une streameuse amatrice, et celui d’un streameur à succès qui, confronté à des sous-entendus racistes et par ailleurs harcelé en dehors de la plateforme, a fini par renoncer à son activité. D’autres travaux montrent que, face à l’absence de communication et de soutien technique de Twitch, certains streameurs et streameuses s’organisent en réseau pour partager des outils et des stratégies permettant de gérer le public pendant les attaques et d’apporter un soutien émotionnel à leurs pairs.

Ces exemples témoignent d’un important travail de sensibilisation du public, souvent épuisant, entrepris par les streameurs et streameuses_minorisés pour pallier le manque de régulation offert par les plateformes qui hébergent leur activité. Ce travail, destiné à rendre moins acceptables les actes de cyberviolence, est encore insuffisamment étudié à ce jour.

Accompagner les streameurs et streameuses dans leur travail de régulation

La recherche pourrait venir prêter main-forte aux acteurs et actrices du streaming dans leur effort crucial pour favoriser une dynamique saine des interactions avec le public. Mobiliser le savoir expérientiel des joueurs et des joueuses, des modérateurs et des modératrices est essentiel pour comprendre comment les streameurs et streameuses peuvent transformer, au quotidien, un environnement parfois hostile en espace viable.

Dans cette optique, une démarche participative associant chercheurs et communautés vidéoludiques permettrait d’identifier des moyens de réparer l’offense et de formaliser des dispositifs de régulation plus inclusifs que les outils techniques existants. À l’heure où la cyberviolence pousse nombre de personnes minorisées à abandonner leur activité de streaming, il est urgent de débrutaliser les pratiques vidéoludiques.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

15.01.2026 à 15:58

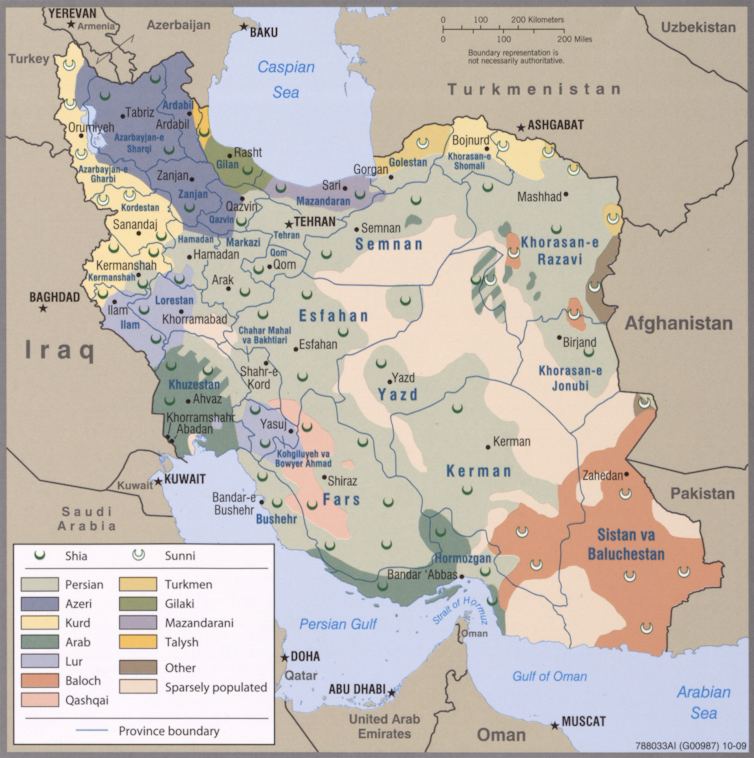

Comment les États-Unis pourraient-ils contribuer à achever le régime des mollahs ?

Texte intégral (2136 mots)

Des frappes états-uniennes sur des cibles en Iran semblent possibles à ce stade, mais, en tout état de cause, une simple série de bombardements ne suffira pas à faire chuter le régime. L’option la plus efficace consisterait, pour Washington, à approvisionner en armes des groupes locaux, à commencer par ceux des Kurdes, et à les appuyer par une campagne aérienne. C’est ainsi que, il y a près de vingt-cinq ans, en Afghanistan, les Américains avaient soutenu leurs alliés locaux, qui avaient chassé les talibans et pris Kaboul. Il reste que plusieurs puissances régionales ne verraient pas d’un très bon œil une issue qui aboutirait à un net renforcement des Kurdes…

Alors que le régime des mollahs s’engage dans un massacre à huis clos de son propre peuple afin d’étouffer la révolution commencée dans le bazar de Téhéran le 28 décembre 2025, tous les observateurs guettent l’annonce d’une campagne de bombardements américains. La réussite spectaculaire de l’enlèvement de Nicolas Maduro au Venezuela le 3 janvier et les déclarations récentes de Donald Trump – le régime iranien sera « frappé très durement, là où ça fait mal » – semblent en effet plaider en ce sens. Trump pourrait profiter de l’extrême fragilité de la République islamique d’Iran pour lui porter le coup de grâce à en frappant les lieux de pouvoir, décapitant ainsi le régime.

Toutefois, cette perspective abondamment relayée dans la presse présente plusieurs écueils évidents : même si une campagne de bombardement pourrait « décapiter » le régime, on voit mal comment des frappes aériennes pourraient permettre au peuple désarmé de tenir tête aux milliers de pasdaran, la milice des Gardiens de la révolution, bras armé du régime, et des bassidji, forces paramilitaires estimées à 600 000 ou 700 000 combattants, qui massacrent aujourd’hui les manifestants pour écraser la révolution.

Seule une campagne de frappes très longue et massive, mobilisant sur la durée plusieurs centaines d’appareils, pourrait vraiment fragiliser ces milices au point de permettre aux civils, désarmés pour la majorité, de renverser un régime qui s’apparente de plus en plus à une dictature militaire. Or, les déclarations de Trump suggèrent pour l’instant une opération courte et spectaculaire et rien n’indique que les États-Unis veuillent s’impliquer dans une campagne de longue durée comme celles menées contre la Serbie lors de la guerre du Kosovo en 1999 ou contre les armées de Saddam Hussein au Koweït lors de la phase initiale de l’opération Tempête du désert en 1991. Un autre indice semble aller en ce sens : pour l’heure, la Maison Blanche n’a déployé aucun porte-avions au large du Golfe persique, ce qui réduit la masse d’appareils disponibles et semble confirmer l’hypothèse d’une offensive aérienne éclair sur le modèle de la guerre des douze jours de l’été dernier.

Dans ce contexte, on pourrait se demander si le type d’opération apparemment choisi par la Maison-Blanche est réellement de nature à renverser le régime. Quelles sont les autres options dont dispose Washington pour parvenir à cette fin ?

Armer les minorités en lutte contre le régime

Les rares vidéos qui nous parviennent de la répression menée par les pasdaran et leurs auxiliaires bassidji montrent à quel point le peuple iranien manque d’armes pour se défendre et pour renverser le régime aux abois.

Équiper matériellement la résistance iranienne semble donc davantage répondre aux demandes immédiates des manifestants qu’une campagne de bombardements qui détruirait certes les centres du pouvoir mais pas l’appareil sécuritaire et répressif qui maille tout le territoire iranien. Dans cette optique, les Américains pourraient décider d’équiper des groupes armés déjà existants et opérationnels en Iran parmi les minorités iraniennes : les Baloutches, les Azéris et les Kurdes sont en lutte pour l’autonomie contre Téhéran depuis des décennies et disposent de milices comme le PJAK kurde ou Jaish al-Adl baloutche qui, si elles étaient correctement équipées, pourraient tenir tête aux pasdaran.

Les Kurdes seraient, dans l’optique américaine, la minorité la plus intéressante, puisque les Kurdes iraniens pourraient s’appuyer sur les bases arrière que leur fournit le Kurdistan irakien – et ce, d’autant plus facilement que les Américains sont très présents dans cette région frontalière.

La base américaine d’Erbil pourrait servir de hub logistique pour équiper la résistance kurde iranienne depuis les provinces kurdes de l’Irak.

Washington a récemment renforcé cette base pour lutter contre l’État islamique et y a déployé des unités d’élite, particulièrement la Delta Force et la 101e division aéroportée. Cette dernière unité possède une importante flotte d’hélicoptères CH-47 Chinook et UH-60 Blackhawk qui pourraient acheminer les armes depuis le carrefour d’Erbil jusqu’au Kurdistan iranien.

Sachant que les Kurdes ont joué un rôle très actif dans tous les mouvements de révolte contre le pouvoir des mollahs et notamment dans le mouvement « Femme, Vie, Liberté » en 2022, et que les Kurdes irakiens ont, ces derniers jours, largement fait part de leur soutien à leurs compatriotes iraniens, ce pari d’armer la minorité kurde pourrait s’avérer gagnant pour Washington.

Une guerre sur le modèle afghan ?

Dès lors, les Américains pourraient mener une guerre par proxy sur le sol de la République islamique, sans envoyer d’importants contingents au sol, conformément aux promesses électorales faites par Trump à sa base MAGA.

Les États-Unis pourraient effectuer une campagne de bombardements en soutien à leurs alliés locaux comme ils l’avaient fait contre le régime des talibans en Afghanistan après les attentats du 11 Septembre. Pendant les mois d’octobre et de novembre 2001, les Américains avaient soutenu la minorité tadjique, organisée autour de la milice rebelle l’Alliance du Nord, formée en 1992 par le commandant Massoud, par une campagne de bombardements ciblés et par l’envoi de forces spéciales capables de coordonner les bombardements et de coordonner les rebelles sur le terrain.

Il semble probable que les succès américains obtenus lors de cette première phase de la guerre d’Afghanistan constituent un modèle pour Trump : rappelons que Kaboul a été prise le 13 novembre 2001 par l’Alliance du Nord sans que les Américains ne déploient des contingents massifs au sol.

C’est bien l’occupation de l’Afghanistan dans un deuxième temps qui mobilisera beaucoup de troupes américaines, entraînera d’importantes pertes parmi ces militaires et se soldera par un échec cuisant. Fort de ce double enseignement, Trump pourrait soutenir les rebelles via des bombardements et l’envoi de forces spéciales, sans chercher à occuper l’Iran.

Une politique risquée… mais inévitable ?

Il reste que la mise en œuvre d’une telle stratégie expose à plusieurs risques de déstabilisation régionale, ce qui pourrait dissuader Washington d’armer massivement les minorités iraniennes.

Trump pourrait se montrer réceptif aux craintes des puissances régionales comme la Turquie ou la Syrie, qui ne veulent surtout pas voir une contagion sécessionniste se diffuser au Moyen-Orient. Il est probable d’Ankara ou Damas considéreraient le développement d’une guérilla kurde iranienne comme un danger nourrissant les velléités de leurs propres communautés kurdes.

De plus, les régimes autoritaires du Golfe comme l’Arabie saoudite ou le Qatar pourraient percevoir le succès de la révolution iranienne comme une menace pour le maintien de leurs propres systèmes, sachant notamment que l’Arabie est confrontée au mécontentement de la minorité chiite à l’est du pays, spécialement depuis le Printemps arabe et la révolte de Qatif en 2011.

Ces facteurs expliquent sans doute les hésitations de Trump ces jours derniers et le temps que prend Washington pour lancer ses frappes contre l’Iran. Cela dit, l’ampleur de la répression perpétrée par le régime de Téhéran est telle qu’un point de non-retour a sans doute été franchi et que la perspective d’une guerre civile entre les milices du régime et les franges les plus déterminées et les mieux équipés des révolutionnaires iraniens soit devenue presque inévitable. Fort ce constat, Washington pourrait accepter les risques qu’implique l’envoi d’armes en Iran et consentir à une opération armée plus longue que prévu, mais dont la perspective de gain reste énorme pour le président américain, lequel pourrait ainsi se prévaloir d’avoir apporté un appui décisif à une révolte populaire contre un ennemi déterminé des États-Unis et, aussi, de leur allié le plus proche dans la région, à savoir Israël.

Pierre Firode ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

15.01.2026 à 15:57

Exit madame Irma dans sa roulotte, place aux tarologues en ligne

Texte intégral (1674 mots)

En 2026, les tarologues sont devenus influenceurs à l’ère du tout-numérique. Ces nouveaux entrepreneurs doivent maîtriser la communication numérique et les attentes de leurs clients en termes de développement personnel. Témoignage de la stratégie de plusieurs tarologues sur le réseau social Instagram.

D’après un sondage Ifop de 2022, 29 % des Français déclarent croire à la cartomancie. Les chiffres financiers l’attestent. Le marché des cartes de tarot est en pleine expansion, estimé à 515 millions d’euros en 2024 et à un milliard d’euros d’ici 2033.

De nombreuses personnes consultent un tarologue davantage pour mieux gérer leurs émotions et développer leurs capacités à réaliser des objectifs personnels et professionnels que pour connaître leur avenir. Ces objectifs s’inscrivent dans une logique de développement personnel, comme le montre ce compte Instagram.

Notre étude cherche à comprendre la stratégie de marketing digital des tarologues et leur rapport au marché du développement personnel. Elle est issue de l’observation régulière de dix comptes Instagram de tarologues sur une période de six mois, complétée par cinq entretiens.

Perspective divinatoire et développement personnel

À partir des années 1960, la pratique du tarot se tourne vers la connaissance de soi via la projection d’émotions sur les cartes.

Alors, l’utilisation du tarot dans une perspective divinatoire a-t-elle totalement disparu ? À étudier les réseaux sociaux des tarologues, ces derniers continuent à proposer leurs services de divination, cette façon de prédire l’avenir par l’interprétation de certains phénomènes sur demande. Les contenus en lien avec la magie et l’ésotérisme sont toujours légion.

En 2024, notre étude montre que le langage des tarologues s’inscrit dans la recherche de bien-être émotionnel et de l’amélioration de l’estime de soi. Cela ne doit rien au hasard. Le réseau social Instagram est caractérisé par un vocabulaire tourné vers l’action, l’expression de valeurs individuelles et les compétences émotionnelles : « focus », « énergies », « travail sur soi », « être aligné », « fluide », « transformation », « changement », etc.

Le tarot apparaît comme un outil permettant d’identifier des points de résistance et de se (re)mettre en mouvement.

« Le tarot dit quelque chose, mais c’est à la personne de continuer sa vie et de prendre ses décisions, elle doit agir, sinon il se ne passera rien », souligne Emily, tarologue.

La notion de « libre arbitre », souvent mentionnée, met en valeur la responsabilité du client qui doit être prêt à faire des efforts pour obtenir des résultats : « Le tarot te donne une longueur d’avance pour prendre la direction qui te convient », explique Will. Et d’après Leena : « Il y a un côté mindset, tu as tiré une carte qui t’invite à voir ta journée sous un jour positif, comme ça même si tu ne te sens pas super bien le matin, ça va te motiver à passer une bonne journée malgré tout. »

Recherche de visibilité

L’insertion des tarologues dans le monde numérique passe par le suivi des usages des réseaux sociaux et la compréhension de leur fonctionnement. L’influence de l’algorithme qui, par ses changements réguliers, modifie les règles du jeu. Sandrine, tarologue interviewée dans notre étude, constate que « l’algorithme ne met en valeur que les reels ».

Les grandes tendances impactent la façon de catégoriser les services proposés par le tarologue via la formulation de la bio, le choix des photos ou la manière de monter les vidéos. D’après la psychologue Listhiane Pereira Ribeiro et l’anthropologue Candice Vidal e Souza, les pratiques de tirage de cartes sont influencées par les codes de l’entrepreneuriat numérique.

Leena, tarologue, adapte ses choix de publication aux différents formats : « Je vais créer plus de proximité en stories et plus d’information dans les posts. »

Les outils proposés – stories, reels, emojis, recours à des plateformes telles que Canva – permettent d’adapter les publications aux habitudes du public tout en essayant de retenir son attention. Will, tarologue, explique que « quelque chose de long n’a en général pas d’impact ».

Les stories à la une sont utilisées pour publier des contenus stratégiques qui doivent rester permanents : l’histoire du tarologue, les prestations proposées, les tarifs, les témoignages, etc. Inversement, les stories classiques sont utilisées pour lancer des événements promotionnels. Exemple : « Jusqu’à ce soir 22 heures, deux questions pour 10 euros », ou « Pour vous, qui est le Bateleur ? »

Le Bateleur, parfois appelé le Magicien, est la première carte du tarot de Marseille. Elle représente un jeune homme debout devant une table recouverte de différents objets, dont la symbolique oriente vers tous les potentiels et vers les nouveaux départs.

La difficulté reste de capter un public à la fois peu disponible et soumis à des offres similaires concurrentes. Au-delà de l’utilisation adaptée des formats existants, la clé réside dans l’authenticité perçue de la personne du tarologue et de ce qu’il propose.

« Il y a une sorte d’uniformité sur Instagram. Tous les dimanches soir, tu as l’énergie de la semaine, les “guidances” de la semaine… Il faut essayer de sortir de ça », explique Will.

L’utilisation des outils contribue à rendre ludique le rapport aux cartes, à travers leur mise en scène sur le réseau. Les cartes elles-mêmes par leur esthétique qui varie suivant le style du jeu (gothique, antique, tarot de Marseille traditionnel, humoristique, etc.) contribuent à la communication visuelle. Elles peuvent être mises en valeur par la couleur du fond, certains objets apparents sur la photo, etc. Certains tarologues adoptent une vision relativement humoristique du tarot, permettant de le dédramatiser.

J'ai interviewé des tarologues dans le cadre de la recherche ayant donné lieu à un article dont ma proposition pour The Conversation est issue. Certaines citations des ces entretiens apparaissent dans le texte.

15.01.2026 à 15:51

Face à l’IA, les médias ne pourront pas faire l’économie d’une profonde remise en question de leur mode de fonctionnement

Texte intégral (2808 mots)

L’intelligence artificielle remet profondément en cause la raison d’être des médias et leur modèle d’affaires. Leur survie pourrait passer par une rapide réflexion sur ce qui fait leur cœur de métier, à l’image de la politique suivie par le New York Times. Au risque de sombrer dans des offres très low cost ou de devenir des fournisseurs des géants de l’IA.

Trois ans après l’irruption de ChatGPT, les médias cherchent comment se positionner vis-à-vis de l’intelligence artificielle (IA) générative. Avec les précédentes vagues de numérisation (Web, plateformes sociales), les entreprises de médias ont dû faire face à une baisse d’audience ou à des problèmes de distribution de leurs contenus. L’arrivée de l’IA pose une question beaucoup plus existentielle à ces entreprises : celle de la pérennité à très court terme de leur modèle d’affaires, soit la façon dont l’entreprise opère et crée de la valeur pour ses parties prenantes.

Déstabilisés, les médias abordent cette nouvelle phase dans une position affaiblie. Faiblesse économique avec des pertes massives d’audiences, qui se traduisent pour certains par une chute des recettes publicitaires et d’abonnés. WPP, la principale agence mondiale de publicité, prévoit que les recettes publicitaires sur les plateformes (Instagram, TikTok, YouTube, etc.) de contenus générés par les utilisateurs dépassent en 2025 les recettes des médias historiques. Seuls 11 % des Français sont abonnés à un média en ligne en 2025.

La valeur du journalisme discutée

À cela s’ajoute un affaiblissement du rôle institutionnel des médias historiques. La confiance dans les médias connaît une érosion continue, particulièrement marquée en France. Seuls 29 % des Français ont confiance dans les médias contre 38 % en 2015, ce qui place la France au 41e rang mondial de l’indice de confiance analysé par le Reuters Institute dans son digital report].

Outre la fatigue informationnelle, une partie importante de la population manifeste une volonté d’évitement des médias historiques. Plus ces personnes consomment de contenus sur les plateformes sociales, plus elles remettent en question les règles et normes du journalisme.

À lire aussi : Quand les IA cadrent l’information et façonnent notre vision du monde

Un risque de disparition pure et simple

Dans cette situation difficile, les enjeux de l’IA peuvent apparaître différents pour la radio, la télévision et la presse. Clonage de voix, génération automatisée de vidéo, avatar (présentateur), génération automatique d’articles, chaque famille de médias doit relever ses propres défis. Mais la transformation des médias historiques en plateformes multimédias produisant des contenus dans des formats toujours plus nombreux (vidéo, podcast, article vocalisé, transcription de vidéo, sous-titrage) leur forge un destin commun face à l’IA.

Si, pour l’heure, les médias ont pour la plupart évité de repenser leur modèle d’affaires dans la phase de numérisation précédente, le déploiement des infrastructures cognitives, l’arrivée des moteurs de réponses (answer engine) remplaçant les moteurs de recherche (search engine), leur impose de le repenser entièrement sous peine de disparation.

Choisir un modèle low cost

Comme de nombreux marchés, les médias font face à l’irruption d’un modèle low cost que l’IA générative rend de plus en plus possible en compressant les coûts de plusieurs maillons de la chaîne de valeur. Génération de titres, édition d’articles, production d’images et de vidéos, doublage, traduction multilingue, sous-titrage, indexation automatisée, le champ d’applications de l’IA générative est très large et offre de substantielles sources de réduction de coûts. Dans ce modèle low cost, l’IA est déployée sur les processus internes, sur les fonctions de production de l’information (back-office) sans être utilisée directement dans la relation directe avec l’audience.

Dans le contexte de fragilité financière de bien des médias, succomber à une promesse d’une baisse des coûts est très tentant. Sous pression, les médias ont d’ores et déjà réduit une partie de leurs coûts de production en s’appuyant sur de larges systèmes de sous-traitances. Aller plus loin, au risque de dégrader la qualité des contenus rapprocheraient dangereusement les médias des producteurs de fermes de contenus produits par l’IA. Ces acteurs, qui se multiplient, contribuent à dégrader la qualité de l’espace informationnel, phénomène qualifié d’« _AI slop* » ».

Vendre des licences

Par ailleurs, les usages croissants des outils conversationnels fondés sur l’IA, comme ChatGPT, devraient conduire à modifier profondément la construction des audiences numériques. Le modèle actuel repose très largement sur les flux générés par les grandes plateformes, à commencer par Google. Le passage d’un moteur de recherches (search engine Google) à un moteur de réponses (answer engine, ChatGPT) pourrait réduire fortement le trafic vers les sites des médias, les utilisateurs se contentant de la réponse des outils d’IA. La captation par les producteurs d’IA d’une part substantielle des recettes de médias historiques les affaiblirait à nouveau.

Dans ce monde nouveau du « zéro clic », les acteurs de l’IA réintermédient la relation entre les médias et les audiences. Cette position pourrait les amener à développer une offre publicitaire qui produirait une nouvelle baisse des recettes des médias. Dans un tel environnement, les médias se trouveraient dans la position de fournisseur des acteurs de l’IA. Les médias peuvent proposer des données d’entraînement des modèles d’IA grâce à leurs archives indexées et des données fraîches dont les modèles d’IA sont dépourvus par définition.

L’enjeu pour les entreprises du secteur est alors de négocier au mieux la valeur des contenus fournis. Mais le rapport de force n’est pas forcément en faveur des médias et risque de conduire à des accords de licence peu rémunérateurs, l’information étant vue comme une commodité – une matière première – par les acteurs de l’IA.

Certifier et labelliser l’information

Afin d’augmenter la valeur de ces contenus, les médias pourraient les certifier comme provenant d’un média labellisé JTI (Journalism Trust Initiative) (1), si tant est que traçabilité et certification soient valorisées par les utilisateurs, justifiant une rémunération supérieure. Compte tenu de la faible confiance accordée aux médias, on peut douter de leur capacité à imposer un tel modèle de valeur aux producteurs d’IA.

Dans ce modèle business-to-business-to-consumer (B2B2C) de producteur certifié, dans lequel les médias produiraient des contenus en marque blanche, la valeur de leur marque risque de s’éroder. Ce modèle n’est donc guère souhaitable à long terme. En effet, il est hautement probable qu’il se combine au modèle low cost afin de maintenir des coûts de production d’autant plus faibles que les producteurs d’IA chercheront à obtenir des prix plus bas. Détenant la relation avec le consommateur final, ils pourront aisément mettre en concurrence les différents médias.

Un nouveau modèle ?

Être un des fournisseurs des producteurs d’IA ne pouvant suffire à garantir la pérennité des médias à long terme, repenser la proposition de valeur des médias est donc essentiel. Si le cœur de celle-ci doit rester la fourniture d’une information fiable et/ou d’une expérience de divertissement riche et unique, les médias cherchent depuis plusieurs années à enrichir cette proposition de valeur par des diversifications d’activités, qui n’ont pas abouti pour le moment à des offres distinctes à même d’assurer le développement et la pérennité des médias.

Le développement des agents d’IA crée de nouvelles expériences pour les utilisateurs. Davantage conversationnelles, elles nécessitent d’adapter l’offre proposée. Autrement dit, les médias devront franchir le pas de l’utilisation de l’IA dans l’interaction avec les audiences.

Cette véritable mutation devrait être l’occasion de repenser l’offre en termes de services. La transformation numérique est la généralisation d’une tendance plus vaste de transformation des produits en services, dont les médias se sont tenus éloignés jusqu’à aujourd’hui. Ce mouvement déplace le cœur de la création de valeur de l’échange vers l’usage. La valeur n’est plus tant dans la transaction et le transfert vers le client d’un produit (le journal, le film, l’article, etc.) que dans l’usage que le client en fera. Dans l’espace numérique, cet usage peut être approché, géré, développé grâce aux données produites par les dispositifs qui soutiennent ses services.

Le « New York Times », exemplaire ?

Le cas du New York Times illustre bien cette logique servicielle. Après avoir acquis plusieurs acteurs (WireCutter, 2016, The Athletic, Wordle 2022), le New York Times a cessé de promouvoir l’offre dite « news-only » dans ses campagnes marketing et pousse systématiquement l’accès via l’offre groupée News + Games + Cooking + Wirecutter + The Athletic + Audio.

En 2025, la refonte de l’application mobile fait de l’offre groupée la porte d’entrée unique d’un ensemble Read-Play-Swipe où l’on accède indifféremment aux articles, aux rubriques jeux, cuisine et audio. Chaque verticale proposée est conçue autour d’usages concrets : s’informer, se détendre, préparer à manger, choisir un produit, suivre son club, remplir un temps mort.

Cette offre multiservice repose sur plusieurs tâches de la vie quotidienne. La logique n’est plus seulement « le journal du jour », mais une disponibilité permanente de services d’actualités : push personnalisés, dossiers, explications pédagogiques (explainers, chronologies), alertes thématiques. L’abonné à l’offre groupée est en relation quasi permanente avec la marque via des usages variés tout au long de la journée, ce qui augmente son engagement et facilite la rétention des clients.

Dans cette logique de servicisation, le New York Times vend de moins en moins un produit (un PDF, un numéro) et de plus en plus un flux continu d’aides pour comprendre le monde, accessible partout, synchronisé entre web, app et audio. Les jeux servent de porte d’entrée vers l’offre groupée. Les nouveaux abonnés arrivant par ce canal sont ensuite orientés vers les autres services. Les jeux fonctionnent comme un service de fidélisation. Quand l’actualité est déprimante, ils offrent un usage positif et stable, qui protège la relation d’abonnement. On est typiquement dans une logique de valeur d’usage. Le consommateur ne paie pas pour « avoir des grilles de mots croisés ou de sudoku », mais pour un moment quotidien de détente intellectuelle, ritualisé.

Nouveaux liens avec le client

NYT Cooking fonctionne comme une application de service culinaire, pour répondre quotidiennement à la question « Qu’est-ce qu’on mange ce soir ? » Là encore, la valeur n’est plus seulement informative (lire des recettes). Elle est aussi pratique en proposant des outils d’aides à la planification des repas, la gestion du temps, l’inspiration. Surtout, le service s’intègre dans la routine familiale. Le New York Times a même signé un partenariat avec le service de livraison de courses Instacart pour les abonnés du service NYT Cooking.

Wirecutter est, quant à lui, un service d’aide à la décision (choisir un aspirateur, un smartphone, un matelas), une sorte de « conseiller personnel » plutôt qu’une rubrique consommation classique. Pour le New York Times, c’est une source de revenus diversifiés (affiliation) et un moyen de couvrir une autre dimension de la vie quotidienne, complémentaire de l’information et du divertissement.

The Athletic est un service de suivi sportif, organisé par club, ligue, compétition, avec analyses et podcasts qui captent des abonnés dont le besoin est davantage de « suivre [s]on équipe/[s]on sport » que l’actualité générale. C’est un service pour passionnés. Désormais, le quotidien offre un ensemble de contenus, notifications, podcasts, analyses autour d’une communauté de fans.

Un actif insuffisamment inexploité : les archives

Ce cas de servicisation d’un média se décline pour d’autres, comme la presse locale. Des services centrés sur la ville, le territoire, sont envisageables y compris le suivi fin de la démocratie locale grâce aux données ouvertes.

La presse magazine peut dans la logique de Wirecutter du New York Times bâtir des services de coaching sur de nombreux sujets dont elle a l’expertise nécessaire. Cette logique servicielle permet aux médias d’être un moteur de réponses (answer engine) et de rivaliser grâce à leurs expertises avec des services d’IA.

Dans cette perspective, les actifs accumulés (archives) retrouvent de la valeur. Articulés avec les compétences journalistiques, elles constituent la base d’un avantage concurrentiel face aux IA conversationnels en fournissant des réponses fiables, documentées et articulées. Il n’en demeure pas moins que cette transformation profonde du modèle de média est une source de tensions au sein des médias et appelle à un véritable aggiornamento culturel.

Ne pas répéter les erreurs du passé nécessite de dépasser des logiques de stratégies individuelles qui ne garantissent pas la pérennité à long terme. À cet égard, les tentatives d’actions collectives, comme la mutualisation des inventaires publicitaires, la création d’un identifiant unique pour les médias à des fins publicitaires, les négociations avec les grandes plateformes numériques, montrent bien que les médias n’ont pas réussi jusqu’ici à se coaliser de façon efficace face aux enjeux communs.

La situation appelle à l’abandon de telles postures tant l’avenir apparaît sombre. Il est urgent de dépasser les antagonismes pour bâtir un espace numérique informationnel et faire émerger de nouveaux modèles d’affaires pérennes.

(1) The Conversation France est labellisé JTI depuis 2025 (ndlr).

Henri Isaac est membre du Think tank Renaissance Numérique.

15.01.2026 à 10:30

La faute de nos biais cognitifs, vraiment ? Comment cette notion fabrique l’inaction écologique

Texte intégral (2295 mots)

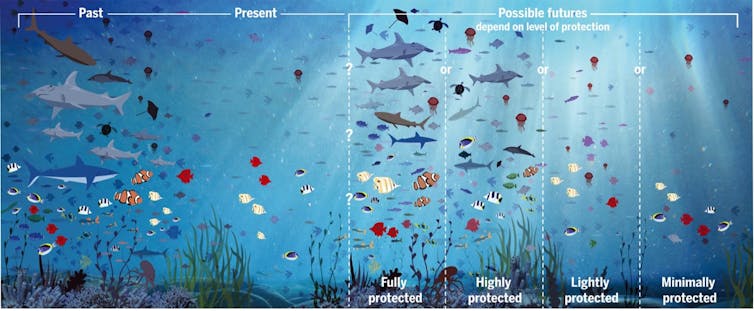

Face à l’urgence écologique, l’inaction est souvent justifiée par nos biais cognitifs individuels. Mais cette lecture psychologisante occulte l’essentiel. Des causes politiques, économiques et sociales sont à l’œuvre dans l’effondrement du vivant actuel. On le verra à travers l’exemple des océans et des milieux marins.

Face à l’urgence climatique, pourquoi sait-on mais n’agit-on pas ? Telle est la question posée par l’activiste Camille Étienne dans son documentaire Pourquoi on se bat ? (2022). Parmi ses invités figure Sébastien Bohler, journaliste et chroniqueur, notamment connu pour son essai le Bug humain (2019). Dans l’ouvrage, il explique que notre cerveau privilégierait le court terme au détriment de la planète. Il en conclut qu’il faut rééduquer notre cerveau pour déclencher l’action collective.

Ce discours, qui attribue l’inaction écologique à des biais cognitifs, c’est-à-dire à des mécanismes automatiques du cerveau, est repris par de nombreuses communications grand public. Sa simplicité est séduisante, mais il pose plusieurs problèmes. En effet, il ne dit rien des écarts considérables de comportements que l’on peut observer entre individus ou sociétés, il occulte les facteurs politiques, économiques et culturels et surtout il offre un alibi aux industries qui ont tout intérêt à maintenir l’exploitation intensive de la nature.

Cette explication est attrayante, mais ne permet pas de comprendre ce qui organise l’inaction ni d’y apporter des solutions concrètes et efficaces. Le cas du milieu marin illustre particulièrement cette logique : la gouvernance de l’océan est particulièrement délicate dans un contexte où prédomine l’exploitation économique, alors que les problèmes qui en découlent (catastrophes environnementales, destruction des moyens de subsistance de celles et ceux qui en dépendent ailleurs dans le monde…) sont souvent invisibilisés.

L’exemple des océans

L’océan constitue un bon exemple des limites de ce discours. Il s’agit du principal espace naturel à être exploité en continu à l’échelle planétaire : pêche, transport maritime, tourisme, sans parler de l’exploitation minière. Les prélèvements massifs y ont conduit à un effondrement global des espèces marines.

Cette découverte est relativement récente. En effet, la recherche océanographique s’est développée plus tardivement que ses équivalents terrestres, du fait, entre autres raisons, des difficultés d’accès du milieu marin. Ce retard explique en partie pourquoi la prise de conscience environnementale liée à la mer a été plus tardive que celle concernant les forêts ou les terres agricoles, par exemple.

De plus, l’océan a un statut particulier : c’est un bien commun global. Or, dans notre économie actuelle, les ressources libres et non régulées tendent à être surexploitées, les acteurs économiques cherchant à maximiser leurs bénéfices individuels avant que la ressource ne s’épuise. Cette dimension collective rend la gouvernance océanique complexe et retarde sa mise en place, puisqu’elle est dépendante de la coopération internationale.

Surtout, l’océan est un milieu qui nous est étranger : la dégradation des fonds, la raréfaction des espèces ou l’acidification des eaux se produisent hors de nos champs sensoriels. Ce contexte est particulièrement propice à l’émergence de biais cognitifs pour expliquer leur effondrement écologique.

Des biais réels mais surestimés

Depuis les années 1980, la recherche sur le sujet a montré qu'il existait à la fois des biais psychologiques et des remèdes à ces derniers. Pour n’en citer que quelques-uns : biais d’optimisme, de présentisme (c'est-à-dire, notre tendance à préférer les résultats immédiats au détriment des résultats futurs) ou encore distance psychologique.

Appliqués à l’écologie, ils se traduisent par une minimisation des risques environnementaux, qui sont alors perçus comme lointains, temporaires ou réversibles. De ces constats naît l’idée que l’inaction environnementale serait préprogrammée dans notre cerveau de façon universelle et que les solutions devraient viser cette partie rétive de nos psychologies.

Autre exemple : le phénomène de « shifting baseline » (aussi appelé amnésie environnementale), qui décrit la tendance pour chaque nouvelle génération à réévaluer comme « normal » un état de plus en plus dégradé de la nature. Pour le milieu marin, les professionnels prennent alors pour référence des niveaux de biodiversité déjà appauvris. Chaque nouvelle étape de dégradation des écosystèmes est ainsi intégrée comme un nouvel état stable, ce qui rend la perte globale plus difficile à voir.

Les biais cognitifs possibles sont nombreux : les facteurs individuels participant à l’inaction écologique sont depuis longtemps étudiés, connus et intégrés. Mais leur influence sur l’inaction climatique est surestimée.

À lire aussi : Inaction climatique : et si on était victime du biais de « statu quo » ?

Quand les biais cognitifs tombent à l’eau

Souvent mobilisés pour expliquer les comportements humains, ces biais peinent pourtant à décrire toute la réalité. Raisonnons par l’absurde : s’il existe des biais universels qui nous poussent à minimiser les enjeux environnementaux, voire à détruire l’environnement, comment expliquer les écarts parfois importants en termes de croyances et de comportements que l’on peut observer d’une personne à l’autre, d’une société à l’autre ?

Comment expliquer que, pour nombre de sociétés, le terme de nature n’existe tout simplement pas, parce qu’il n’y a pas de différence faite entre ce qui est considéré comme soi (humain) et comme autre, animal ou végétal ?

L’effondrement écologique ne peut se comprendre sans faire l’analyse des sociétés qui y contribuent et qui exacerbent nos biais individuels. Dans nos sociétés industrialisées, l’accroissement du capital structure à la fois nos environnements sociaux et nos motivations. Or, l’avènement des sociétés capitalistes n’a pas été le résultat de seuls biais cognitifs ou de processus biologiques universels : il a été mené par une petite fraction de l’humanité qui, avec les moyens matériels et politiques adéquats, a pu l’imposer à la majorité, entraînant la rupture des rapports sociaux et environnementaux préexistants.

Dans les milieux marins, l’effondrement écologique s’explique surtout par les conditions économiques et politiques qui le rendent possible à l’échelle globale : pêche industrielle peu régulée, marchandisation de la biodiversité marine (tourisme, aquaculture…), intérêts économiques et politiques liés au contrôle de l’extraction minière et énergétique (hydrocarbures offshore, minerais marins)… Le tout inscrit dans un système économique global fondé sur l’accumulation.

Tout cela montre que l’effondrement écologique actuel est davantage la conséquence d’arrangements sociopolitiques que de biais cognitifs individuels qui nous pousseraient naturellement à détruire les écosystèmes. Il nous faut sortir de cette vision et agir sur les causes systémiques qui produisent l’inaction.

En effet, nous pouvons agir sur les organes politiques et économiques qui encadrent la gestion des milieux naturels, dont les milieux marins. Or, c’est précisément ce que les discours majoritaires sur les biais psychologiques empêchent de faire. En légitimant l’idée selon laquelle ces biais universels – car inscrits dans notre biologie – seraient à l’origine des problèmes d’exploitation, ils invisibilisent les rapports de pouvoir, déresponsabilisent les politiques et fournissent des outils permettant ensuite de justifier l’inaction.

À lire aussi : Climat : comment l’industrie pétrolière veut nous faire porter le chapeau

Déplacer la focale de l’individuel au collectif

Que faire ? Individuellement, il est bien sûr possible d’agir sur sa consommation de produits issus de la surpêche et de l’exploitation animale, de limiter les déplacements polluants ou encore de rejoindre des collectifs afin de gagner en capacité d’action et d’information.

Quels arguments pour convaincre et engager à l’action ? La recherche en psychologie et en communication environnementale a identifié six « vérités clés » :

le changement climatique existe,

il est créé par nos sociétés industrielles,

il existe un consensus scientifique,

il a des conséquences graves sur l’humanité et la biodiversité,

la majorité des personnes en sont inquiètes et veulent agir,

enfin, des actions efficaces existent.

L’action collective doit ensuite œuvrer à tous les niveaux, du local à l’international, en gardant pour boussole :

le respect des droits et de la dignité des populations,

une gouvernance la plus égalitaire et démocratique possible,

et la mise en place de mesures efficaces, contrôlées et collaboratives de gestion des biens communs, tels que des aires marines protégées exigeantes.

L’effondrement du climat et de la biodiversité ne sont donc pas des fatalités, mais les conséquences des systèmes sur lesquels nous pouvons avoir un impact – à condition de les réorienter vers des modèles plus justes et soutenables.

Pierre-Yves Carpentier est membre de l'association Alternatiba06 qui œuvre pour l'écologie.

Benoit Dérijard a reçu des financements du CNRS (Centre National de la Recherche Scientifique), de l'Université Côte d'Azur, du FEAMPA (Fonds Européen pour les Affaires Maritimes, la Pêche et l'Aquaculture), de la Région Sud et de l'OFB (Office Français de la Biodiversité).

Clara Vincendon ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

15.01.2026 à 10:30

Faut-il en finir avec les incitations à mieux gérer nos déchets ? Le problème posé par les sciences comportementales

Texte intégral (1896 mots)

Pour réduire les déchets, les politiques publiques misent de plus en plus sur les sciences comportementales, comme les « nudges » (dispositifs de suggestion). Cette idée est séduisante, mais elle déplace la responsabilité d’un problème systémique vers les individus. Les défauts de tris et autres dépôts sauvages sont alors souvent requalifiés comme de « mauvais comportements ». Le problème de cette approche ? Elle invisibilise les déterminants matériels, sociaux et politiques de la production des déchets.

Depuis une dizaine d’années, les collectivités territoriales, les agences nationales et une partie du secteur privé se sont engouffrées dans une voie présentée comme prometteuse : l’application des sciences comportementales à la réduction des déchets.

L’idée est que si les individus trient mal, jettent au mauvais endroit ou produisent trop de déchets, c’est qu’ils manquent d’information, de motivation ou parce que les dispositifs censés orienter leurs gestes (emplacement des bacs, lisibilité des consignes…) n’envoient pas les « bons signaux ». Des campagnes fondées sur les « nudges », des dispositifs incitatifs ou des signalétiques présentées comme « engageantes », sont alors présentées comme suffisantes pour transformer les comportements ordinaires et les pratiques quotidiennes.

Ce récit séduit. En effet, il permet d’agir vite, à moindre coût, et sans remettre en cause les logiques structurelles qui génèrent les déchets. Mais cette vision est réductrice. Elle repose sur une vision des conduites humaines qui méconnaît profondément les rapports sociaux, les conditions d’habiter, les trajectoires résidentielles, les inégalités matérielles et symboliques.

Surtout, elle déplace la question politique des déchets à l’échelle des individus. Ce faisant, elle en assigne la responsabilité aux habitants, présentés comme des acteurs indisciplinés mais rationalisables à coups de micro-incitations.

À lire aussi : Les mots de la gestion des déchets : quand le langage façonne nos imaginaires

Dispositifs défaillants et production institutionnelle de la stigmatisation

Sur le terrain, les observations ethnographiques montrent un paysage différent. Il est davantage structuré par des dispositifs sociotechniques, économiques, organisationnels que par les intentions individuelles.

Dans de nombreux quartiers, le tri est entravé par des infrastructures inadaptées. Citons par exemple les vide-ordures encore en usage qui empêchent toute séparation des flux à la source, l’absence d’espaces de stockage dans les logements, les bacs trop éloignés ou difficilement accessibles… certains dispositifs semblent conçus sans avoir tenu compte des pratiques quotidiennes de circulation des habitants. On peut ainsi penser aux points d’apport volontaire dispersés sur plusieurs centaines de mètres, qui imposent de longs trajets pour trier le verre, le papier et les plastiques.

Ces contraintes matérielles façonnent les gestes quotidiens, bien davantage qu’un prétendu manque de volonté ou de sensibilisation. S’y ajoute un autre phénomène, particulièrement saillant dans les quartiers populaires : des pratiques de circulation d’objets – don, récupération, redistribution informelle – se trouvent placées sous un régime de suspicions et de sanctions.

Autrement dit, ce qui relevait auparavant d’une économie populaire du réemploi est désormais requalifié en dépôts sauvages et incivilités. Et cela non pas parce que les pratiques auraient nécessairement changé, mais parce que leur visibilité est perçue comme un problème par les institutions.

Cette requalification transforme des logiques de subsistance ou de solidarité en manquements à la norme. Dans ce cadre, les acteurs institutionnels chargés de la gestion des déchets valorisent avant tout une logique de salubrité publique. Leur action se concentre alors sur l’évacuation, la disparition rapide des traces, l’entretien visuel de la voie publique. Le déchet y est traité comme un rebut dont il faut se débarrasser, et non comme une ressource susceptible d’être valorisée. Ainsi, des objets laissés temporairement dans l’espace public dans l’attente d’un repreneur ou d’un réemploi sont ramassés par les camions de collecte. Et ce faisant, définitivement soustraits à toute possibilité de réutilisation, parfois réduits à l’état de déchets ultimes par le broyage.

Ce glissement est lourd d’effets. Dans ces quartiers, les déchets deviennent des marqueurs sociaux. Ils servent à requalifier des groupes, à leur attribuer des comportements naturalisés, à désigner des « responsabilités » qui coïncident souvent avec des stigmatisations ethno-sociales préexistantes.

La propreté devient alors un instrument de classement. La figure de l’« habitant défaillant » se substitue aux défaillances structurelles des dispositifs sociotechniques, économiques et organisationnels. Rebut d’un côté, ressources de l’autre : la distinction n’est pas seulement technique, elle est sociale et politique. Elle organise la manière dont les territoires sont perçus, traités et hiérarchisés.

À lire aussi : Pollution, un mot qui permet aussi d’opérer un classement social

Les sciences comportementales masquent les vrais enjeux

Dans ce contexte, le recours aux sciences comportementales agit comme un masque. Il détourne l’attention des problèmes très concrets qui structurent la gestion des déchets au quotidien :

infrastructures défaillantes ou mal pensées (vide-ordures qui encouragent à jeter sans trier, locaux poubelles saturés, équipements peu lisibles),

conditions de travail éprouvantes (gardiens inexistants ou cantonnés à « tenir » les parties communes sans moyens ni formation sur le tri, prestataires de nettoiement soumis à des règles strictes et à des cadences élevées),

et des conflits permanents entre acteurs (bailleur, métropole, prestataires, habitants).

Au lieu de rendre ces dysfonctionnements visibles, l’analyse se concentre sur le dernier maillon de la chaîne : l’habitant, présenté comme celui qui se trompe, résiste ou ne fait pas assez d’efforts. C’est pourtant l’organisation du système qui crée les conditions mêmes de ces « mauvais gestes ».

Les éboueurs, les agents de tri, les services techniques et les décisions politiques disparaissent derrière une théorie simplifiée des comportements, où l’individu devient un point d’application dépolitisé. Pour les instituions, cette approche est séduisante à plusieurs titres :

d’abord parce qu’elle promet des résultats visibles à court terme ;

ensuite, parce qu’elle évite d’avoir à ouvrir le dossier – plus coûteux et plus conflictuel – de la réduction à la source, de la régulation de la production, ou de la reconfiguration des infrastructures (transformation matérielle et organisationnelle des dispositifs existants). Cela impliquerait ainsi de remettre en cause des équipements qui orientent structurellement les pratiques vers l’évacuation plutôt que vers la valorisation. Ou encore de redéfinir le rôle des acteurs de terrain – gardiens, agents de propreté, prestataires –, aujourd’hui cantonnés à une gestion de la salubrité visible ;

enfin, elle s’accorde avec une conception néolibérale de l’action publique où chacun est sommé d’être responsable de son empreinte.

Pourtant, cette logique se heurte à deux limites majeures.

La première tient aux résultats eux-mêmes de ces interventions comportementales. D’abord, leurs effets sont difficiles à mesurer. Elles peuvent également se révéler peu durables, puisque fortement dépendante des configurations sociales et matérielles dans lesquelles elles sont déployées. Enfin, elles peuvent modifier les comportements à court terme, mais ces ajustements se défont rapidement lorsque les incitations cessent, tant que l’organisation concrète reste inchangée. En pratique, les effets observés dans des cadres expérimentaux se révèlent difficiles à transposer durablement dans les contextes ordinaires.

La seconde limite est politique. En recentrant l’attention sur les comportements individuels, ces interventions contribuent à déplacer la responsabilité vers ceux qui disposent de la marge de manœuvre la plus étroite. Les habitants les plus précaires deviennent les premiers visés par ces dispositifs correctifs, alors même qu’ils subissent des infrastructures défaillantes et des conditions d’habiter plus contraignantes que d’autres.

Pendant ce temps, les ressorts structurels de la production de déchets demeurent intouchés. L’action publique se focalise ainsi sur ceux qui ont le moins de pouvoir d’action et épargne ceux qui déterminent réellement les volumes et les flux.

Sortir de la vision psychologisante de la gestion des déchets

En finir avec les sciences comportementales appliquées à la gestion des déchets ne signifie pas rejeter toute forme d’attention aux pratiques quotidiennes et individuelles. Cela implique plutôt de déplacer son centre de gravité. Pour cela, il convient de sortir d’une vision psychologisante, de réintroduire les dimensions matérielles, institutionnelles, historiques, politiques et sociales, et enfin de reconnaître que les déchets ne sont pas seulement une affaire d’individus mais aussi de systèmes.

Les infrastructures, les logiques économiques de production, la division sociale du travail, les politiques urbaines et les rapports de pouvoir façonnent bien davantage les volumes, les flux et les gestes que ne le feront jamais les autocollants sur un bac jaune.

Si les sciences comportementales ont pu offrir quelques outils ponctuels, elles ne constituent ni une théorie sociale ni une politique publique durable. La gestion des déchets exige une compréhension plus exigeante, celle d’un monde où la matérialité, les normes, la stigmatisation, les inégalités et les infrastructures s’entremêlent. S’y dérober en réduisant sa complexité à des micro-incitations n’est pas seulement inefficace, c’est aussi renoncer à penser ce que les déchets révèlent réellement de nos sociétés.

Camille Dormoy ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

14.01.2026 à 17:12

Iran : l’adhésion prudente des minorités ethniques au mouvement de protestation

Texte intégral (3326 mots)

Près de la moitié des Iraniens ne sont pas des Perses. Si les habitants des régions périphériques — Kurdistan, Baloutchistan, Azerbaïdjan… — soutiennent le mouvement de contestation, ils redoutent également un éventuel retour de la monarchie Pahlavi, qui ne leur a pas laissé que de bons souvenirs…

Lorsque les manifestations actuelles en Iran ont commencé au Grand Bazar de Téhéran le 28 décembre 2025, le gouvernement les a d’abord considérées comme gérables et temporaires.

Les marchands des bazars ont toujours fait partie des groupes sociaux les plus conservateurs du pays, profondément ancrés dans la structure économique de l’État et étroitement liés au pouvoir politique. Le gouvernement estimait donc que leurs protestations n’étaient pas de nature révolutionnaire et qu’il ne s’agissait que d’une campagne de pression de courte durée visant à stabiliser une monnaie, le rial, en chute libre et à freiner l’inflation — deux phénomènes menaçant directement les moyens de subsistance des commerçants.

Lors de sa première réaction publique au mouvement du bazar, le guide suprême iranien Ali Khamenei a ouvertement admis que les commerçants avaient des raisons d’être mécontents. C’était la première fois qu’il reconnaissait la légitimité d’une manifestation contestataire. Rappelant l’alliance historique entre l’État et le bazar, il a indiqué que le gouvernement considérait que les troubles étaient maîtrisables.

Les autorités n’avaient pas prévu ce qui allait se passer ensuite : les manifestations se sont étendues à plus de 25 provinces et constituent désormais un risque direct pour la survie du régime, lequel a réagi par une répression violente au cours de laquelle plus de 6 000 personnes auraient déjà été tuées.

Spécialiste des groupes ethniques iraniens, j’ai observé la façon dont ces groupes minoritaires, malgré leurs doutes quant à l’issue du mouvement et quant aux projets de certaines figures centrales de l’opposition, se sont joints à la contestation.

Les minorités ethniques se joignent à la manifestation