21.01.2026 à 11:36

Des éclairs détectés sur Mars pour la toute première fois

Baptiste Chide, Chargé de Recherche CNRS à l'IRAP (Université de Toulouse, CNES), Observatoire Midi-Pyrénées

Franck Montmessin, Directeur de recherche CNRS au Laboratoire Atmosphères, Milieux, Observations Spatiales (LATMOS), Université de Versailles Saint-Quentin-en-Yvelines (UVSQ) – Université Paris-Saclay

Texte intégral (1725 mots)

Pour la première fois, un microphone placé sur le rover Perseverance de la Nasa a permis de découvrir l’existence de petites décharges électriques dans les tourbillons et les tempêtes martiennes de poussière. Longtemps théorisés, ces petits éclairs sur Mars deviennent une réalité grâce à des enregistrements acoustiques et électromagnétiques inédits que nous venons de publier dans la revue Nature. Cette découverte, aux conséquences multiples sur nos connaissances de la chimie et de la physique ainsi que sur le climat de la planète rouge, révèle de nouveaux défis pour les futures missions robotiques et habitées.

Un souffle de vent martien, et soudain, un claquement sec : les dust devils, ces tourbillons de poussière qui parcourent la planète rouge, viennent de nous livrer un secret bien gardé : ils sont traversés de petits arcs électriques ! Ils ont été vus, ou plutôt entendus, de manière totalement fortuite, grâce au microphone de l’instrument SuperCam sur le rover Perseverance qui sillonne Mars depuis 2020.

Ce microphone est notre oreille à la surface de Mars. Il alimente depuis 2021 une « playlist » de plus de trente heures composée de brefs extraits quotidiens du paysage sonore martien : le microphone est allumé environ trois minutes tous les deux jours, pour des raisons de partage du temps du rover avec les autres instruments.

Un jackpot scientifique

Parmi ses morceaux les plus écoutés ? Le ronflement basse fréquence du souffle du vent, le crépitement aigu des grains de sable et les grincements mécaniques des articulations du robot. Mais le dernier titre de cette compilation d’un autre monde est une pépite : un dust devil capté en direct alors qu’il passait au-dessus de notre microphone. Qu’un dust devil passe au-dessus de Perseverance, ce n’est pas forcément exceptionnel – ils sont très actifs dans le cratère de Jezero où est posé Perseverance. Mais, qu’il survole le rover à l’instant même où le microphone est allumé, cela relève du jackpot scientifique.

Au cœur de cet enregistrement se cachait un signal fort que nous avons peiné à interpréter. Notre première hypothèse fut celle d’un gros grain de sable ayant impacté la zone proche de la membrane du microphone. Quelques années plus tard, alors que nous assistions à une conférence sur l’électricité atmosphérique, nous avons eu une illumination : s’il y avait des décharges sur Mars, la façon la plus directe de les détecter serait de les écouter parce qu’aucun autre instrument à bord de Perseverance ne permet d’étudier les champs électriques.

Évidemment, l’enregistrement le plus favorable pour vérifier cette hypothèse était précisément celui-ci. Réexaminé à la lumière de cette interprétation, il correspondait bien au signal acoustique d’une décharge électrique. Ce n’était pas tout !

Cette onde de choc était précédée d’un signal étrange qui ne ressemblait pas à quelque chose de naturel mais qui provenait en réalité de l’interférence électromagnétique de la décharge avec l’électronique du microphone. Nous savions que celle-ci était sensible aux ondes parasites, mais nous avons tourné ce petit défaut à notre avantage. Grâce à la combinaison de ces deux signaux, tout était devenu clair : nous avions détecté pour la première fois des arcs électriques sur Mars. Pour en être absolument convaincus, nous avons reproduit ce phénomène en laboratoire à l’aide de la réplique de l’instrument SuperCam et d’une machine de Wimshurst, une expérience historiquement utilisée pour générer des arcs électriques. Les deux signaux – acoustique et électromagnétique – obtenus étaient rigoureusement identiques à ceux enregistrés sur Mars.

En soi, l’existence de ces décharges martiennes n’est pas si surprenante que cela : sur Terre, l’électrification des particules de poussière est bien connue, notamment dans les régions désertiques, mais elle aboutit rarement à des décharges électriques. Sur Mars, en revanche, l’atmosphère ténue de CO₂ rend ce phénomène beaucoup plus probable, la quantité de charges nécessaire à la formation d’étincelles étant beaucoup plus faible que sur Terre. Cela s’explique par le frottement de minuscules grains de poussière entre eux, qui se chargent en électrons puis libèrent leurs charges sous forme d’arcs électriques longs de quelques centimètres, accompagnés d’ondes de choc audibles. Le vrai changement de paradigme de cette découverte, c’est la fréquence et l’énergie de ces décharges : à peine perceptibles, comparables à une décharge d’électricité lorsqu’on touche une raquette à moustiques, ces étincelles martiennes sont fréquentes, en raison de l’omniprésence de la poussière sur Mars.

Des implications au niveau du climat martien

Ce qui est fascinant, c’est que cette découverte intervient après des décennies de spéculations sur l’activité électrique martienne, touchant une arborescence de phénomènes encore peu ou mal expliqués. Par exemple, l’activité électrique de la poussière a longtemps été suspectée de fournir un moyen très efficace pour soulever la poussière du sol martien. Les champs électriques derrière les arcs électriques entendus sur Mars sont a priori suffisamment forts pour faire léviter la poussière.

En absorbant et en réfléchissant la lumière solaire, la poussière martienne contrôle la température de l’air et intensifie la circulation atmosphérique (les vents). Et parce que les vents contrôlent en retour le soulèvement de la poussière, la boucle de rétroactions poussière-vent-poussière est à l’origine des tempêtes globales qui recouvrent intégralement la planète de poussière tous les 5 ou 6 ans. Vu l’importance de la poussière dans le climat martien, et alors que les meilleurs modèles ne savent pas encore prédire correctement son soulèvement, les forces électrostatiques ne pourront plus être ignorées dans le cycle global de la poussière sur Mars.

Expliquer la disparition du méthane

L’autre sujet qui attire les regards des scientifiques concerne le très controversé méthane martien. La communauté débat depuis plus de vingt ans à son sujet en raison de ses implications potentielles, à savoir une activité géophysique ou biologique éventuelle sur Mars, deux hypothèses fascinantes.

Au-delà du caractère énigmatique de ses détections sporadiques, sa disparition – des centaines de fois plus rapide que ce que prédisent les modèles de chimie atmosphérique les plus sophistiqués – a longtemps laissé les experts circonspects. L’un des mécanismes de destruction du méthane les plus prometteurs, proposé il y a une vingtaine d’années, fait précisément intervenir l’action de champs électriques intenses sur la chimie atmosphérique. En accélérant ions et électrons, ces champs permettent de casser les molécules de méthane, mais surtout celles de la vapeur d’eau, produisant ainsi de puissantes espèces réactives capables de détruire le méthane bien plus efficacement encore.

Qui plus est, la présence d’arcs électriques à l’échelle planétaire pourrait s’avérer déterminante dans la préservation de la matière organique. Des expériences de laboratoire ont montré la destruction brutale de biomarqueurs causée par le recyclage d’espèces chlorées induite par l’activité électrostatique de la poussière.

On le voit, la portée de ces nouveaux sons martiens dépasse largement le seul cadre de la communication grand public. Ils redessinent plusieurs pans de notre compréhension de Mars et ouvrent un nouveau champ d’investigations, qui nécessitera un nombre accru d’observations.

Peut-être lors de futures missions ? L’Agence spatiale européenne (ESA) avait déjà tenté l’expérience – sans succès – avec l’atterrisseur Schiaparelli, qui devait réaliser les premières mesures des champs électriques martiens avant de s’écraser à la surface de la planète. L’exploration future, humaine ou non, se devra de mieux caractériser ces champs pour mieux cerner leurs implications. D’ici là, Perseverance restera l’unique témoin in situ de ce phénomène qui est sans doute loin de nous avoir tout révélé.

Franck Montmessin a reçu des financements de l'ANR et du CNES.

Baptiste Chide ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

21.01.2026 à 11:36

Les crocodiles, des reptiles loquaces et à l’écoute du monde

Nicolas Mathevon, Professeur (Neurosciences & bioacoustique - Université de Saint-Etienne, Ecole Pratique des Hautes Etudes - PSL & Institut universitaire de France), Université Jean Monnet, Saint-Étienne

Texte intégral (3253 mots)

On l’imagine chasseur solitaire et discret, constamment à l’affût d’une proie. Pourtant, l’armure d’écailles du crocodile dissimule une vie sociale complexe. Tendez l’oreille : le seigneur des fleuves a beaucoup à dire.

Lorsque l’on se représente un crocodile, on pense à un prédateur silencieux, un tronc d’arbre flottant au milieu du fleuve, attendant patiemment qu’une proie s’approche pour faire brusquement claquer ses mâchoires. Cette image, bien que partiellement vraie – il est sagement déconseillé de nager au milieu de crocodiles –, occulte une réalité biologique fascinante : les crocodiliens (crocodiles, alligators, caïmans et gavials) sont les reptiles les plus vocaux et les plus sociaux de la planète.

Ces animaux possèdent un système de communication acoustique sophistiqué et une ouïe d’une finesse redoutable, peut-être hérités de leurs ancêtres communs avec les oiseaux et les dinosaures. Depuis près de trois décennies, notre équipe de recherche en bioacoustique s’attelle à décoder ce qu’ils disent et à comprendre comment ils perçoivent leur environnement sonore. Voici ce que nos études révèlent du monde sonore des crocodiliens.

La première conversation : parler depuis l’œuf

L’histoire acoustique d’un crocodile commence avant sa naissance. Contrairement à la majorité des reptiles qui pondent leurs œufs et les abandonnent, les mères ou les pères crocodiliens montent la garde près du nid. Mais comment savoir quand les petits sont prêts à sortir, enfouis sous des dizaines de centimètres de sable ou de végétation ? Nos recherches ont démontré que les embryons de crocodiles ne sont pas passifs. Lorsqu’ils sont prêts à sortir de l’œuf, après trois mois d’incubation, ils commencent à émettre des vocalisations particulières, appelées cris d’éclosion.

Ces sons, audibles à travers la coquille et à l’extérieur du nid, remplissent une double fonction. D’une part, ils s’adressent à la fratrie. Lors d’expériences consistant à émettre des sons depuis un haut-parleur près d’œufs de crocodiles du Nil prêts à éclore, nous avons observé que l’audition de ces cris incite les autres embryons à vocaliser à leur tour et à briser leur coquille. Ce mécanisme permet de synchroniser l’éclosion : toute la nichée va sortir ensemble. Pour des proies aussi vulnérables que des nouveau-nés de quelques dizaines de grammes, c’est une belle stratégie de survie face aux prédateurs.

D’autre part, ces cris sont un signal impérieux pour la mère ou le père. Une femelle crocodile qui monte la garde depuis trois mois réagit immédiatement à l’audition de ces cris d’éclosion : elle se met à creuser le nid avec ses pattes. Sans ce comportement parental en réponse à leur signal sonore, les petits resteraient prisonniers sous terre.

Cependant, la mère ne réagit pas au premier petit bruit venu. Nos expériences sur le crocodile du Nil ont montré que la femelle réagit à des cris isolés par des mouvements de tête, enfouissant son museau dans le sol comme pour en sentir les vibrations, mais elle ne commence à creuser activement que si les cris forment une séquence continue et rythmée. Ceci évite à la femelle d’ouvrir le nid trop tôt pour un seul petit précocement bavard, ce qui mettrait en danger le reste de la couvée.

Le langage des jeunes crocos

Une fois sortis de l’œuf et délicatement transportés à l’eau dans la gueule de leurs parents, les jeunes crocodiliens restent groupés en crèches sous la protection de l’adulte pendant des semaines, voire des mois. Durant cette période, la communication acoustique entre parent et jeunes est vitale.

Le répertoire vocal des juvéniles est structuré autour de deux types de signaux principaux : les cris de contact et les cris de détresse. Le cri de contact est utilisé pour maintenir la cohésion du groupe de jeunes. C’est un son d’intensité assez faible et dont la fréquence varie peu. Le cri de détresse, lui, est émis lorsqu’un jeune est saisi par un prédateur. Il est plus fort et sa fréquence est plus modulée. Il présente souvent une structure acoustique plus chaotique, ce qui le rend un peu rugueux à l’oreille.

La mère sait faire la différence : un cri de contact suscite une simple attention, tandis qu’un cri de détresse déclenche une réaction agressive de défense immédiate. Mais un parent reconnaît-il la voix de ses petits ? Visiblement pas : nos analyses acoustiques des crocodiles du Nil indiquent qu’il n’y a pas de signature vocale chez les nouveau-nés qui permettrait aux parents de les identifier individuellement. En revanche, nous avons découvert que plus le crocodile est petit, plus le cri est aigu. Lors d’expériences réalisées dans la nature, les mères crocodiles du Nil ont réagi plus intensément aux cris les plus aigus. C’est logique : les plus petits sont les plus vulnérables aux prédateurs et nécessitent une protection accrue.

Une ouïe entre l’eau et l’air

Le crocodile est un animal amphibie, vivant à l’interface entre l’air et l’eau, mondes aux propriétés acoustiques radicalement différentes. Mais son audition est d’abord aérienne. Lorsque le crocodile flotte, immobile, ce qui est sa position favorite pour attendre une proie, ses oreilles se trouvent juste au-dessus de la ligne de flottaison. Si l’animal plonge, une paupière vient protéger l’oreille, et l’on ne sait pas encore si les crocodiles entendent bien sous l’eau.

Comment un animal dont la tête est à moitié immergée fait-il pour localiser une proie, un petit ou un rival ? Chez l’humain ou d’autres mammifères et oiseaux, la localisation repose sur deux indices principaux : le son arrive plus vite à l’oreille tournée vers la source et est également plus fort, puisque la tête fait écran. Dans des expériences, nous avons entraîné des crocodiles à se diriger vers des haut-parleurs pour obtenir une récompense, et les résultats montrent qu’ils utilisent également ces deux sources d’information. Pour les sons graves, ils se fient surtout au temps ; pour les aigus, ils utilisent plutôt la différence d’intensité.

Distinguer dans le bruit

Les crocodiliens vivent souvent dans des environnements bruyants. Pour survivre, ils doivent être capables d’isoler un signal pertinent du bruit de fond, mais aussi d’identifier ce qu’ils entendent. Un bruit dans les roseaux est-il une proie ou un congénère ? Au laboratoire, nous avons découvert quel paramètre acoustique ils utilisent pour faire cette distinction. Ce n’est pas la hauteur du son ni son rythme mais l’enveloppe spectrale, c’est-à-dire le timbre du son. C’est exactement le même paramètre que nous, humains, utilisons pour distinguer les voyelles (« a » ou « o ») ou pour reconnaître la voix de quelqu’un au téléphone. Et la catégorisation des sons opérée par les crocodiles n’est pas totalement figée, elle peut être affinée par l’apprentissage, preuve d’une vraie plasticité cognitive.

En particulier, les crocodiles savent reconnaître et sont particulièrement appâtés par les signaux de détresse d’autres animaux. Quand on diffuse des enregistrements de pleurs de bébés humains, bonobos ou chimpanzés à des crocodiles du Nil, les résultats sont frappants : les crocodiles sont très fortement attirés par ces pleurs. Mais pas n’importe comment.

Les humains jugent la détresse d’un bébé principalement à la hauteur de son cri (plus c’est aigu, plus on pense que le bébé exprime de la douleur). Les crocodiles, eux, se basent sur un critère acoustique plus fiable : le chaos, qui se traduit par la rugosité de la voix qui survient lorsque les cordes vocales sont poussées à leurs limites physiques sous l’effet du stress ou de la douleur.

Les crocodiles se sont donc révélés meilleurs que les humains pour évaluer le niveau de détresse des bébés, en particulier des bonobos. Là où nous surestimons la détresse des bonobos à cause de leurs cris suraigus, les crocodiles ne réagissent intensément qu’aux pleurs contenant beaucoup de chaos acoustique, signe d’une véritable urgence, et donc d’une proie vulnérable.

Entre congénère et proie, que privilégier ?

Si les jeunes crocodiliens sont particulièrement bavards, les adultes ne sont pas en reste. Les mères, et les pères pour les espèces où ils s’occupent de leur progéniture, émettent des grognements qui attirent les jeunes. Femelles et mâles adultes rugissent lors des parades nuptiales et pour défendre leur territoire. Lorsqu’ils se sentent menacés, les adultes peuvent souffler de manière bruyante, ce qui passe l’envie de les approcher. On observe cependant de grandes différences dans l’usage des signaux sonores entre les groupes de crocodiliens : si les alligators et les caïmans sont particulièrement vocaux, les autres crocodiles deviennent plus silencieux à l’âge adulte.

Imaginez un jeune crocodile affamé qui entend un congénère l’appeler, mais qui sent en même temps une odeur de viande. Que fait-il ? Nous avons testé ce conflit sensoriel. Les résultats montrent que l’état de satiété modifie la réponse comportementale. Un crocodile rassasié est très attentif aux sons sociaux : il se dirige vers les cris de contact de ses congénères. Un crocodile affamé privilégie la recherche d’une source de nourriture. Cela suggère une modulation de l’attention : la priorité de l’animal peut basculer selon les besoins physiologiques.

Loin de l’image du monstre primitif, le crocodile est un animal doté d’une vie sensorielle et cognitive riche. Il naît dans un monde sonore, synchronisant son éclosion avec ses frères et sœurs. Il communique avec l’adulte qui s’occupe de lui pour obtenir protection. Il analyse son environnement sonore avec des outils sophistiqués (localisation binaurale, démasquage spatial) dignes des oiseaux ou des mammifères. Il catégorise les sons sur la base de leur timbre pour distinguer les congénères des en-cas. Et il est même capable d’évaluer le niveau de détresse dans la voix d’autres espèces.

Ces études sur les crocodiles ont impliqué de nombreux collaborateurs et collaboratrices, dont Thierry Aubin (CNRS), Nicolas Grimault (CNRS), Nicolas Boyer (Université de Saint-Étienne), Amélie Vergne, Léo Papet, Julie Thévenet et Naïs Caron-Delsbosc. Je remercie les parcs zoologiques La Ferme aux crocodiles (Pierrelatte, France) et Crocoparc (Agadir, Maroc) pour leur soutien.

Nicolas Mathevon ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

21.01.2026 à 11:36

Géo-ingénierie marine : qui développe ces grands projets, et qu’y a-t-il à y gagner ?

Manuel Bellanger, Chercheur en économie, Ifremer

Texte intégral (2658 mots)

Le mot « géo-ingénierie » recouvre un grand nombre de techniques, du « parasol spatial », qui limite l’arrivée de lumière du soleil dans l’atmosphère, à l’ensemencement de l’océan pour lui faire absorber encore plus de carbone qu’il ne le fait naturellement.

Manuel Bellanger étudie à l’Ifremer le développement des techniques de géo-ingénierie marine avec son regard d’économiste. Cet interview, réalisée par Elsa Couderc, cheffe de rubrique Sciences et Technologies, constitue le second volet de « regards croisés » sur la géo-ingénierie climatique. Dans le premier, nous explorons avec Laurent Bopp, climatologue et académicien, les nouveaux risques climatiques que ces techniques pourraient faire émerger.

The Conversation : La géo-ingénierie marine est mal connue en France, pourtant elle se développe à l’étranger. Qui développe ces projets ?

Manuel Bellanger : En ce qui concerne l’océan, le spectre des acteurs et des techniques de géo-ingénierie est très varié.

Les initiatives les plus prudentes sont en général pilotées par des instituts de recherche, par exemple aux États-Unis ou en Allemagne. Leur finalité est plutôt de comprendre si ces interventions sont techniquement possibles : peut-on développer des méthodes pour capturer du CO₂ atmosphérique par l’océan, mesurer la quantité de carbone stockée durablement, vérifier les affirmations des différents acteurs, étudier les impacts écologiques, tenter de définir des bonnes pratiques et des protocoles ? Ces projets de recherche sont typiquement financés par des fonds publics, souvent sans objectif de rentabilité immédiate.

Il existe aussi des collaborations entre institutions académiques et partenaires privés et, enfin, à l’autre bout du spectre, un certain nombre de start-up qui font la promotion du déploiement rapide et massif de ces techniques.

Peut-on espérer gagner de l’argent grâce à la géo-ingénierie marine ?

M. B. : Le modèle économique de ces start-up repose sur la vente de crédits carbone qu’elles espèrent pouvoir mettre sur les marchés volontaires du carbone – c’est-à-dire qu’elles cherchent à vendre des certificats à des acteurs privés qui veulent compenser leurs émissions.

Pour cela, la séquestration doit être certifiée par des standards ou des autorités. Sachant qu’il y a aussi des initiatives privées qui développent des certifications… aujourd’hui, c’est un peu la jungle, les marchés volontaires du carbone. Et l’achat de ces crédits certifiés reste sur la base du volontariat, puisqu’il n’y a généralement pas d’obligation réglementaire pour les entreprises de compenser leurs émissions.

Pouvez-vous nous donner des exemples de telles start-up et l’état de leurs travaux ?

M. B. : Running Tide, aux États-Unis, a tenté de développer des crédits carbone issus de la culture d’algues sur des bouées biodégradables qui devaient couler sous leur propre poids dans les profondeurs abyssales. Mais ils ne sont pas parvenus à produire des quantités significatives d’algues. L’entreprise a finalement eu recours au déversement de milliers de tonnes de copeaux de bois dans les eaux islandaises pour essayer d’honorer les crédits carbone qu’ils avaient vendus. Mais les experts et observateurs ont critiqué le manque de preuves scientifiques montrant que cette approche permettait réellement de séquestrer du CO₂ et l’absence d’évaluation des impacts sur les écosystèmes marins. L’entreprise finalement a cessé ses activités en 2024 pour des raisons économiques.

Une start-up canadienne, Planetary Technology, développe une approche d’augmentation de l’alcalinité océanique visant à accroître l’absorption du CO₂ atmosphérique et son stockage à long terme sous forme dissoute dans l’océan. Pour cela, ils ajoutent à l’eau de mer du minerai alcalin, de l’hydroxyde de magnésium. Ils ont annoncé avoir vendu des crédits carbone, notamment à Shopify et British Airways.

Une autre société, californienne cette fois, Ebb Carbon, cherche également à augmenter l’alcalinité océanique, mais par électrochimie : ils traitent de l’eau de mer pour la séparer en flux alcalins et acides, puis renvoient la solution alcaline dans l’océan. Cette société a annoncé avoir signé un contrat avec Microsoft pour retirer des centaines de milliers de tonnes de CO₂ sur plusieurs années.

L’écosystème commercial fleurit déjà en Amérique du Nord, même si on n’en entend pas forcément parler ici.

Il y a aussi une sorte de fonds, appelé Frontier Climate, qui engage des contrats anticipés pour des tonnes de CO₂ qui seront retirées de l’atmosphère dans le futur : ils achètent par avance des crédits carbone à des sociétés qui sont en phase de développement et qui ne sont pas encore réellement en train de capturer et de séquestrer du carbone. Derrière ce fonds-là, il y a des géants de la tech, comme Google ou Facebook, parmi les membres fondateurs. On peut supposer que c’est une manière pour ces entreprises, qui ont une consommation énergétique assez importante, de s’acheter une vertu climatique. Donc, eux, ils ont déjà annoncé avoir acheté pour 1,75 million de dollars (plus de 1,5 million d’euros) de crédits carbone à des entreprises d’alcalinisation de l’océan.

Et pourtant, vous disiez tout à l’heure qu’on n’est pas encore sûrs de savoir mesurer scientifiquement si l’océan a bien absorbé ces tonnes de carbone.

M. B. : Effectivement, les bases scientifiques de ces techniques-là ne sont vraiment pas solides aujourd’hui. On ne sait pas encore quelles quantités de CO₂ elles vont permettre de capturer et de séquestrer et on ne sait pas non plus quels vont être les impacts sur l’environnement.

À lire aussi : Géo-ingénierie climatique : de quoi parle-t-on ? Pour quelle efficacité et quels nouveaux risques ?

Et côté scientifique, il n’y a donc pour l’instant pas de consensus sur la capacité des techniques de géo-ingénierie marine à retirer suffisamment de carbone de l’atmosphère pour réellement freiner le changement climatique ?

M. B. : Il y a même pratiquement un consensus scientifique pour dire que, aujourd’hui, on ne peut pas présenter les techniques de géo-ingénierie marine comme des solutions. En fait, tant qu’on n’a pas drastiquement réduit les émissions de gaz à effet de serre, beaucoup considèrent qu’il est complètement futile de vouloir commencer à déployer ces techniques-là.

En effet, aujourd’hui, les ordres de grandeur évoqués (le nombre de tonnes que les entreprises annoncent séquestrer) n’ont rien à voir avec les ordres de grandeur qui permettraient de changer quoi que ce soit au climat. Par exemple, pour la culture de macroalgues, certaines modélisations estiment qu’il faudrait recouvrir 20 % de la surface totale des océans avec des fermes de macroalgues – ce qui est déjà presque absurde en soi – pour capturer (si ça marche) 0,6 gigatonne de CO₂ par an… à comparer aux 40 gigatonnes que l’humanité émet aujourd’hui chaque année. Si ces techniques pouvaient jouer un rôle dans le futur pour compenser les émissions que le Giec désigne comme « résiduelles » et « difficiles à éviter » (de l’ordre de 7 à 9 gigatonnes de CO₂ par an à l’horizon 2050) et atteindre des objectifs de neutralité carbone, les déployer aujourd’hui ne pourrait en aucun cas remplacer des réductions d’émissions rapides et massives.

Alors, qui pousse ces développements technologiques ?

M. B. : Un certain nombre d’initiatives semblent être poussées par ceux qui ont un intérêt au statu quo, peut-être même par certains qui n’auraient pas de réelle volonté de déployer la géo-ingénierie, mais qui ont un intérêt à faire diversion pour retarder l’action qui viserait à diminuer les émissions aujourd’hui.

On pense plutôt aux acteurs des énergies fossiles qu’aux géants de la tech, dans ce cas ?

M. B. : Les acteurs des énergies fossiles ont effectivement cet intérêt à retarder l’action climatique, mais ils sont de fait moins visibles aujourd’hui dans le financement direct des techniques de géo-ingénierie – il semble qu’ils soient plus dans le lobbying et dans les discours qui vont légitimer ce genre de techniques.

De fait, investir dans la géo-ingénierie ne fait-il pas courir le risque de détourner l’attention des citoyens et des gouvernements de l’urgence de réduire nos émissions de gaz à effet de serre ?

M. B. : C’est un risque clairement identifié dans la littérature scientifique, parfois sous le nom d’« aléa moral climatique », parfois d’« effet de dissuasion ». Derrière, il y a l’idée que la promesse de solutions technologiques futures, comme la géo-ingénierie marine, pourrait affaiblir la volonté politique ou sociétale de réduire les émissions dès maintenant. Donc le risque d’être moins exigeants envers nos décideurs politiques pour qu’ils tiennent les engagements climatiques et, in fine, que le décalage entre les objectifs et l’action climatique réelle soit toujours plus grand.

Par ailleurs, on a des ressources financières, ressources en main-d’œuvre, en expertise, qui sont somme toute limitées. Tout ce qui est investi dans la recherche et le développement ou pour l’expérimentation de ces technologies de géo-ingénierie peut se faire au détriment des ressources allouées pour les mesures d’atténuation connues et démontrées : l’efficacité énergétique, les énergies renouvelables, la sobriété. On sait que ces solutions fonctionnent : ce sont elles qu’il faudrait mettre en œuvre le plus rapidement.

La priorité absolue – on n’arrête pas de le répéter –, c’est la diminution rapide des émissions de gaz à effet de serre. Donc la position de la plupart des scientifiques, c’est que ces techniques de géo-ingénierie marine devraient être explorées d’un point de vue de la recherche, par exemple pour évaluer leur efficacité et leurs effets environnementaux, économiques et sociaux, de manière à éclairer les choix politiques et sociétaux à venir. Mais, encore une fois, aujourd’hui la géo-ingénierie marine ne peut pas être présentée comme une solution à court terme.

C’est pour cela que la communauté scientifique appelle à une gouvernance internationale de la géo-ingénierie, avant un déploiement massif de ces techniques. Quelles instances internationales seraient à même de mener une gouvernance sur le sujet ?

M. B. : Il faut en effet que les États s’impliquent fortement dans la gouvernance de la géo-ingénierie, et il faut des traités internationaux. Pour l’instant, c’est assez fragmenté entre différents instruments juridiques, mais il y a ce qu’on appelle le protocole de Londres, adopté en 1996, pour éviter la pollution en mer par dumping (le fait de pouvoir décharger des choses en mer). Ce protocole permet déjà en partie de réguler les usages de géo-ingénierie marine.

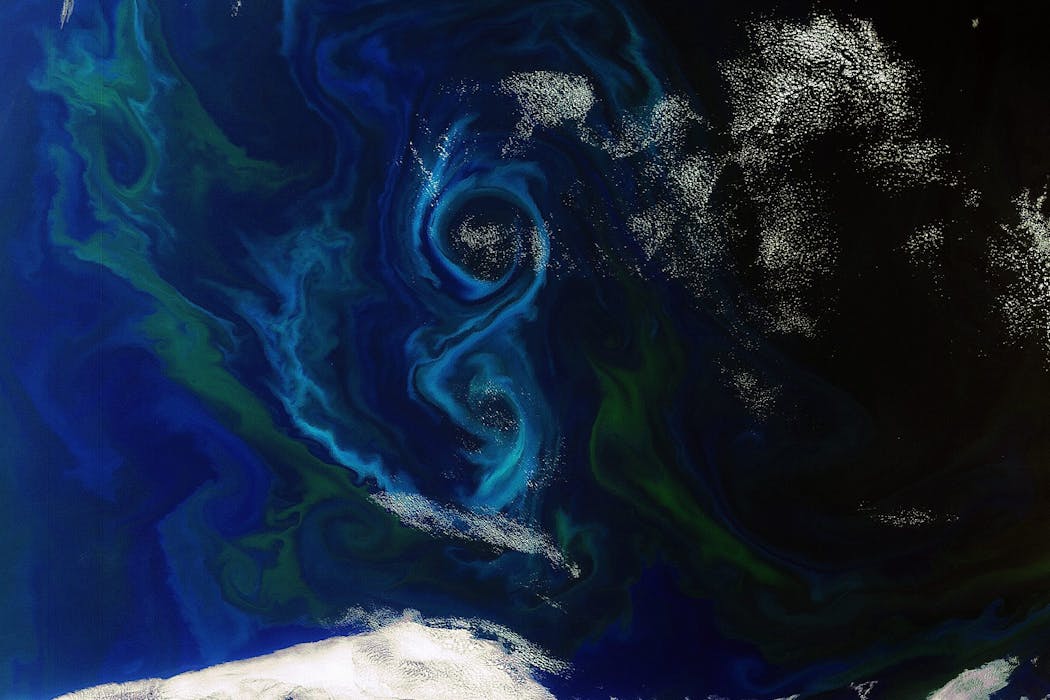

Par exemple, la fertilisation des océans par ajout de fer visant à stimuler le phytoplancton qui capture le CO₂ par photosynthèse. Cette technique rentre dans le cadre existant du protocole de Londres, qui interdit la fertilisation de l’océan à des fins commerciales et impose un cadre strict pour la recherche scientifique depuis plus d’une quinzaine d’années. Le protocole pourrait être adapté ou amendé pour réguler d’autres techniques de géo-ingénierie marine, ce qui est plus facile que de créer un nouveau traité international.

Les COP sur le climat sont aussi importantes pour deux raisons : elles rassemblent plus de nations que le protocole de Londres, et elles sont le cadre privilégié pour discuter des marchés carbone et donc pour éviter la prolifération d’initiatives commerciales non contrôlées, pour limiter les risques environnementaux et les dérives du type crédits carbone douteux.

Il y a des précédents avec ce qu’il s’est passé sur les crédits carbone forestiers : une enquête publiée par le Guardian en 2022 a montré que plus de 90 % des projets certifiés par Verra – le principal standard mondial – n’ont pas empêché la déforestation ou ont largement surévalué leurs bénéfices climatiques. Sans encadrement, la géo-ingénierie marine pourrait tout à fait suivre le même chemin.

Enfin, il y a bien sûr des enjeux d’équité, si ceux qui mettent en œuvre une action ne sont pas ceux qui risquent de subir les impacts ! Là aussi, il y a des précédents observés sur des projets forestiers certifiés pour générer des crédits carbone, où les bénéfices économiques sont captés par les investisseurs tandis que les communautés locales subissent des restrictions d’accès aux ressources forestières ou sont exposées à des changements dans leur mode de vie.

Concrètement, quels sont les risques pour les populations qui vivent à proximité de l’océan ou s’en servent de ressource nourricière, par exemple ?

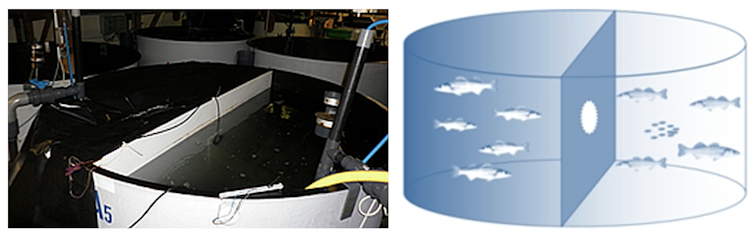

M. B. : Ça dépend vraiment de la technique de géo-ingénierie utilisée et de l’endroit où ça va être déployé. Par exemple, si on imagine un déploiement massif de cultures d’algues, ça pourrait modifier les écosystèmes côtiers, et par ailleurs générer une concurrence pour l’espace avec la pêche ou l’aquaculture traditionnelle.

Sur les littoraux, où les activités maritimes sont souvent très denses, il y a déjà des conflits d’usage, que l’on observe par exemple dans les tensions autour des installations de parcs éoliens en mer.

Propos recueillis par Elsa Couderc.

Manuel Bellanger a reçu des financements dans le cadre du programme ANR n° 21-POCE-0001 PPR Océan & Climat.

21.01.2026 à 11:36

Géo-ingénierie climatique : de quoi parle-t-on ? Pour quelle efficacité et quels nouveaux risques ?

Laurent Bopp, Directeur de recherche, Centre national de la recherche scientifique (CNRS); École normale supérieure (ENS) – PSL; Académie des sciences

Texte intégral (3489 mots)

La « géo-ingénierie climatique » recouvre un ensemble de techniques qui visent à manipuler le climat à grande échelle afin d’éviter les risques du changement climatique. Ces techniques sont très variées, depuis les parasols spatiaux pour limiter l’arrivée des rayons du soleil dans l’atmosphère jusqu’à la fertilisation des océans pour que le phytoplancton consomme davantage de CO₂, en passant par la restauration et la conservation de zones humides où le carbone est stocké de façon préférentielle.

En octobre 2025, l’Académie des sciences a publié un rapport qui détaille ce que l’on sait et ce que l’on ignore encore sur les éventuels bénéfices de ces techniques et sur les nouveaux risques qu’elles font surgir.

Elsa Couderc, cheffe de rubrique Sciences et Technologies, explore ici avec Laurent Bopp, climatologue et académicien, les nouveaux risques climatiques que ces techniques pourraient faire émerger. Le second volet de ces « regards croisés » est un entretien avec Manuel Bellanger, qui étudie à l’Ifremer le développement des techniques de géo-ingénierie marine avec un regard d’économiste.

The Conversation : Pourquoi l’Académie des sciences s’empare-t-elle aujourd’hui du sujet de la géo-ingénierie climatique, alors qu’on en parle relativement peu en France ?

Laurent Bopp : Le sujet est de plus en plus présent dans la littérature scientifique, dans le débat scientifique et dans le débat politique qui entoure les discussions sur le changement climatique. On ne s’en rend pas bien compte en France, mais aux États-Unis, en Angleterre, en Allemagne, au Canada, le débat est beaucoup plus présent.

Certains climatologues, y compris de renom, se prononcent pour faire beaucoup plus de recherches sur ces technologies, mais aussi parfois pour envisager leur déploiement à grande échelle afin d’éviter un réchauffement trop important. L’argument est simple : un niveau de réchauffement trop élevé génère des risques importants et pourrait conduire au dépassement de certains points de bascule potentiels dans le système climatique, par exemple une fonte irréversible des calottes glaciaires du Groenland et de l’Antarctique, ce qui pourrait entraîner une élévation du niveau de la mer de plusieurs mètres additionnels.

En France, nous avons besoin collectivement de plus d’informations et de plus de débats autour de ces techniques. Nous avons eu le sentiment que certains de nos représentants se sont retrouvés en partie dépourvus dans des arènes de négociations internationales, face à des représentants d’autres gouvernements qui ont un agenda très agressif sur ces technologies. C’est sans doute une des raisons pour lesquelles l’Académie des sciences s’est emparée du sujet.

L’idée des interventions de géo-ingénierie climatique, c’est de réduire les risques liés au changement climatique. Mais ces interventions pourraient-elles induire de nouveaux risques et lesquels ?

L. B. : Un des intérêts de ce rapport, c’est de mettre la lumière sur ces nouveaux risques.

Mais, avant de rentrer dans le détail, il faut, quand nous parlons de géo-ingénierie climatique, distinguer deux grandes catégories de techniques – ces deux catégories sont fondées sur des approches très différentes et présentent des risques, là aussi, très différents.

Pour la première de ces catégories, il s’agit de modifier de façon assez directe le rayonnement solaire. On parle en anglais de Solar Radiation Management ou SRM. Dans ce cas-là, l’action s’apparente plutôt à une sorte de pansement sur la plaie d’une blessure, sans s’attaquer du tout à la cause du changement climatique : l’idée est de refroidir la Terre de façon artificielle, en utilisant par exemple des particules atmosphériques ou des miroirs spatiaux qui limiteraient la pénétration du rayonnement solaire jusqu’à la surface de la Terre. Ce refroidissement pourrait compenser, en partie au moins, le réchauffement lié aux gaz à effet de serre qui continueraient à augmenter dans l’atmosphère.

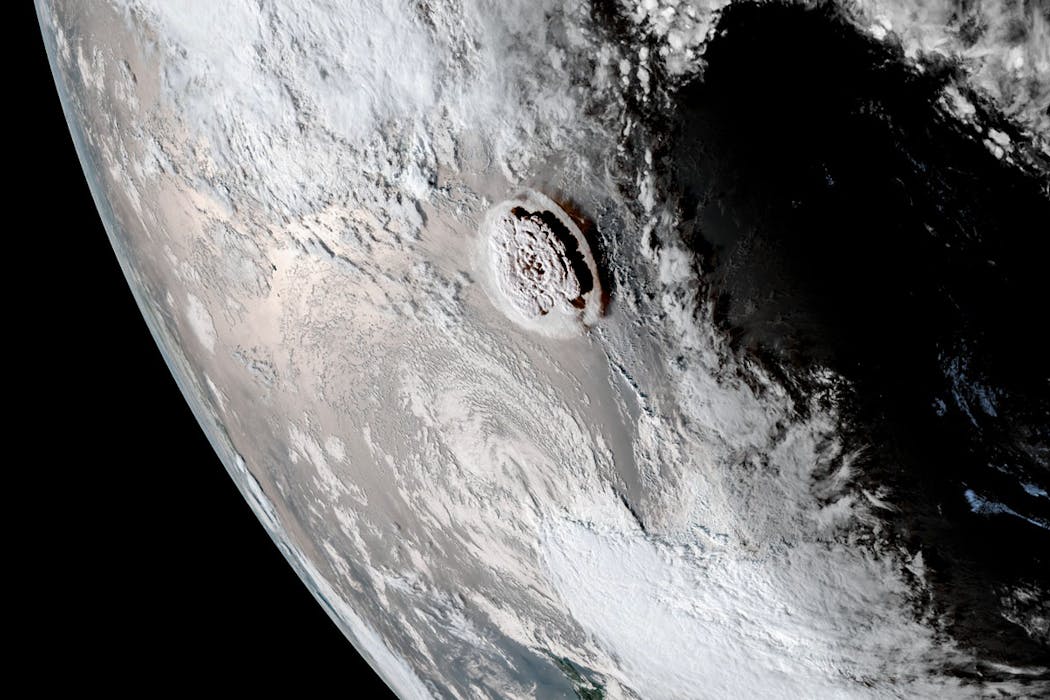

L’injection d’aérosols dans la haute atmosphère vise à imiter des éruptions volcaniques de très grande taille qui, par le passé, ont pu refroidir la Terre. Une des limites premières de cette approche, c’est que cette façon de refroidir la Terre est très différente de la façon dont elle se réchauffe aujourd’hui à cause des gaz à effet de serre : les échelles de temps et les échelles spatiales associées sont très différentes, et cela engendre un certain nombre de conséquences. Les risques sont à lire en fonction de ces deux échelles.

Les aérosols que l’on pourrait injecter dans la haute atmosphère ont une durée de vie courte. Ils vont disparaître de l’atmosphère assez rapidement, tandis que les gaz à effet de serre qui réchauffent le système Terre, le CO₂ en particulier, sont dans l’atmosphère pour très longtemps.

Cette différence majeure entraîne l’un des risques les plus préoccupants : le risque de « choc terminal ». Concrètement, si l’on décidait d’arrêter brutalement l’injection d’aérosols après s’être engagé dans ce type de stratégie

– et les raisons pourraient être multiples, qu’il s’agisse de problèmes de gouvernance, de financement ou de conflits internationaux – le réchauffement climatique jusque-là partiellement masqué réapparaîtrait d’un seul coup. On subirait alors, en très peu de temps, plusieurs années de réchauffement accumulé. On aurait des taux de réchauffement temporels très très rapides, et donc des conséquences sur la biodiversité ou sur les sociétés humaines difficiles à anticiper.

En d’autres termes, si le réchauffement arrive relativement lentement, la mise en place de mesures d’adaptation est possible ; s’il est très rapide, les conséquences sont potentiellement bien plus dévastatrices.

L’autre risque majeur est lié aux échelles spatiales : refroidir avec des aérosols par exemple, ce n’est pas du tout la même chose que ne pas refroidir en émettant moins de CO₂. Les effets régionaux du refroidissement vont être très différents de ce qu’ils auraient été si on avait réchauffé un peu moins. La localisation des précipitations, l’intensité de la mousson notamment ont des conséquences sur l’agriculture, sur la santé. Sur ces effets régionaux, il y a encore beaucoup d’incertitudes aujourd’hui, c’est quelque chose que les modèles décrivent moins bien que les effets temporels dont je parlais tout à l’heure.

À lire aussi : Parasols géants et blanchiment du ciel : de fausses bonnes idées pour le climat

Face à ce risque majeur, l’Académie recommande d’arrêter le déploiement des techniques de modification du rayonnement solaire, et même les recherches sur cette technique de géo-ingénierie…

L. B. : Effectivement, notre rapport recommande de ne pas utiliser ces techniques, et nous allons même jusqu’à suggérer un traité international qui interdirait leur déploiement.

Nous pensons aussi qu’il ne faut pas financer, de façon importante, de la recherche qui soit spécifiquement fléchée sur ces techniques de modification du rayonnement solaire, pour éviter de légitimer ces approches trop dangereuses.

Bien sûr, nous avons besoin de bien plus de recherche sur le climat et sur les processus climatiques importants, donc sur les processus qui lient, par exemple, les aérosols dans la haute atmosphère avec la modification du rayonnement, mais nous pensons vraiment qu’il faut éviter les projets fondamentalement pensés pour pousser l’avènement de ces technologies. Les risques associés sont trop importants.

La géo-ingénierie climatique inclut une deuxième approche, celle qui consiste à augmenter l’efficacité des puits de carbone naturels, par exemple les forêts, les tourbières ou les océans qui absorbent naturellement du carbone. En quoi est-ce fondamentalement différent de la modification du rayonnement solaire ?

L. B. : Il ne s’agit plus de refroidir la Terre pour compenser un réchauffement qui serait lié à l’augmentation des gaz à effet de serre, mais d’éliminer du CO₂ qui est déjà présent dans l’atmosphère. Le terme consacré est celui d’« élimination du dioxyde de carbone », ou Carbon Dioxide Removal (CDR) en anglais.

D’abord, soyons clairs : la priorité des priorités reste de réduire les émissions actuelles de façon drastique. Ces « puits de carbone » additionnels ne doivent intervenir que comme un complément, après la réduction des émissions de façon massive et immédiate.

Pour stabiliser le climat et répondre aux objectifs de l’accord de Paris à 1,5 ou 2 °C de réchauffement par rapport à l’époque préindustrielle, nous avons besoin d’aller collectivement vers des émissions nettes nulles !

Comme il y aura sans doute des secteurs difficiles à décarboner, comme la sidérurgie ou le transport aérien, nous savons qu’il y aura sans doute besoin d’un peu de ces puits de carbone pour compenser ces émissions résiduelles.

On est donc sur une ligne de crête compliquée à tenir : ne pas mettre ces techniques d’élimination du CO₂ en avant, pour ne pas décourager la réduction des émissions – en raison du potentiel de décarbonation limité de ces techniques, nous allons y revenir – et en même temps continuer à soutenir la recherche sur ces technologies parce qu’elles pourraient se révéler utiles, au moins dans une certaine mesure.

En augmentant l’efficacité des puits de carbone naturels, si on reprend l’analogie avec le pansement et la blessure, on ne s’attaque toujours pas à la cause (l’émission de gaz à effet de serre), mais on remonte dans la chaîne de causalité en s’attaquant à quelque chose de plus amont que dans le cas de la modification du rayonnement solaire.

Il existe de nombreux types de méthodes d’élimination du CO₂, à la fois naturelles et technologiques. Présentent-elles toutes le même potentiel et les mêmes risques ?

L. B. : Pour éliminer du CO₂ déjà dans l’atmosphère, il y a une très grande diversité de techniques, en partie parce qu’il existe plusieurs « réservoirs » dans lesquels il serait possible de stocker le CO₂ retiré de l’atmosphère : dans le sous-sol, dans l’océan, dans la biomasse continentale.

Pour simplifier, je dirais qu’il y a une série de techniques qui sont aujourd’hui considérées comme « gagnant-gagnant » : elles permettent de retirer du CO₂ de l’atmosphère et elles ont d’autres bénéfices.

Prenons par exemple la restauration et la conservation des écosystèmes côtiers, comme les mangroves ou les herbiers marins : ces actions permettent un stockage de carbone et, par exemple, de mieux protéger les côtes contre la montée du niveau marin et les épisodes de submersion côtière. D’autres techniques, en foresterie, en agroforesterie ou en stockant le carbone dans les sols, permettent aussi de développer des pratiques agricoles qui sont plus vertueuses.

Malheureusement, comme évoqué dans le rapport, ces approches sont difficiles à mettre à l’échelle, en raison des surfaces souvent limitées et des quantités phénoménales de carbone qu’il faudrait pouvoir stocker dans ces réservoirs naturels pour avoir un effet significatif.

Et puis il y a, à l’autre bout du spectre, des techniques qui sont jugées peu efficaces et dont on sait qu’elles ont sans doute des effets dommageables sur les écosystèmes. Compte tenu des connaissances actuelles, l’Académie des sciences recommande de ne pas poursuivre dans ces directions-là.

L’exemple le mieux documenté est celui de la fertilisation par le fer du plancton marin, car elle a été envisagée il y a déjà longtemps, à la fin des années 1980. L’idée est d’aller en pleine mer, dans des régions où le développement du phytoplancton est limité par la faible abondance d’un nutriment bien particulier : le fer. Dans ces régions, il n’y a pas besoin d’ajouter beaucoup de fer pour fertiliser le plancton, qui va se développer davantage, et pour cela absorber plus de CO₂. Une partie de la matière organique produite coule ensuite vers les profondeurs de l’océan, emportant avec elle le carbone qu’elle contient. Ce carbone est ainsi isolé de l’atmosphère dans l’océan profond, potentiellement pour des centaines d’années.

Plusieurs expériences scientifiques ont été menées en pleine mer dans les années 1990 et 2000. À court terme, elles ont effectivement mis en évidence une augmentation du flux de carbone de l’atmosphère vers l’océan.

Toutefois, des travaux plus récents, notamment fondés sur la modélisation, montrent que cette technique est probablement beaucoup moins efficace qu’on ne l’imaginait initialement. Surtout, en modifiant fortement les écosystèmes marins pour capter du carbone, elle entraîne toute une série d’effets indésirables : l’émission d’autres gaz à effet de serre, une diminution de l’oxygène dans les eaux profondes, ou encore l’épuisement de certains nutriments essentiels, qui ne sont alors plus disponibles pour d’autres écosystèmes.

Ces constats ont conduit la communauté internationale à réagir. En 2008, les États ont amendé le protocole de Londres afin d’y introduire une interdiction de ce type de pratiques en haute mer.

Dans le cas de la fertilisation des océans, les risques sont donc bien documentés – ils ne concernent pas directement le climat mais des dommages collatéraux ?

L. B. : Oui. Malheureusement, on voit en ce moment une résurgence de certains projets poussés par certains chercheurs qui continuent à défendre ce type de techniques, par exemple aux États-Unis. Mais pour nous, il semble clair qu’il ne faut pas recommander ces techniques aux effets collatéraux bien documentés.

À lire aussi : Géo-ingénierie marine : qui développe ces grands projets, et qu’y a-t-il à y gagner ?

Entre les techniques trop risquées, comme la fertilisation des océans, et les techniques de conservation et de restauration, que j’appelais « gagnant-gagnant » tout à l’heure, il y a d’autres techniques, pour lesquelles on a besoin de davantage de recherche – c’est le cas, par exemple, des techniques d’alcalinisation de l’océan.

Il s’agit d’une technique chimique cette fois : on augmente le pouvoir tampon de l’océan en ajoutant du matériel alcalin. Un des points positifs, c’est que cette technique consiste en l’accélération d’un phénomène naturel qui est l’altération des roches sur les continents. Quand les roches s’altèrent, elles apportent de l’alcalinité à l’océan, donc elles augmentent le pouvoir tampon de l’océan qui absorbe plus de CO₂ – c’est un processus très lent, qui a un rôle très important sur les échelles de temps très, très longues et qui régule en partie le cycle du carbone sur les échelles de temps géologiques.

Deuxième avantage : le CO2 ainsi stocké dans l’océan l’est de manière très durable, bien plus que dans des approches reposant sur du carbone organique (comme la fertilisation des océans) où le stockage est beaucoup plus incertain. Troisième point positif, cette augmentation de l’alcalinité permet aussi de réduire partiellement l’acidification des océans.

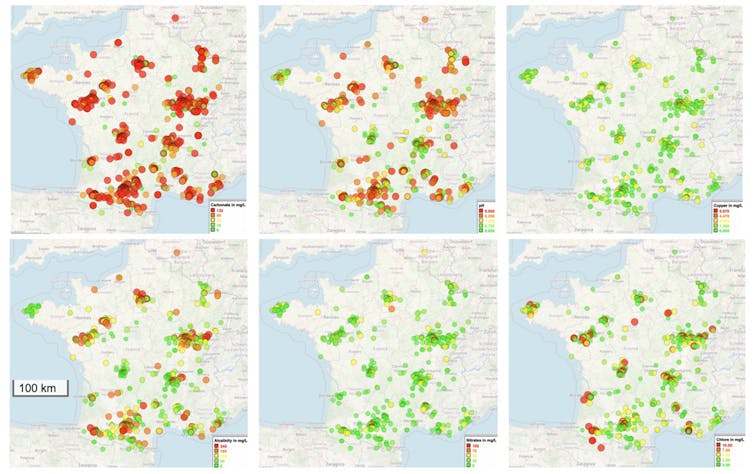

Mais ces bénéfices s’accompagnent de nombreuses incertitudes et de risques. Ajouter des matériaux alcalins modifie parfois fortement la chimie de l’eau de mer. Quels effets cela pourrait-il avoir sur les écosystèmes marins, le plancton ou les espèces côtières dont dépendent de nombreuses populations humaines ? À ce stade, nous manquons encore de données pour répondre clairement à ces questions.

L’efficacité même de la technique reste également incertaine. Pour qu’elle fonctionne, l’alcalinité ajoutée doit rester dans les couches de surface de l’océan, là où les échanges avec l’atmosphère ont lieu. Si elle est rapidement entraînée vers les profondeurs, son impact sur l’absorption du CO₂ devient très limité.

Enfin, il y a beaucoup de questions sur le coût de ces techniques. En particulier, un certain nombre de start-up et d’entreprises s’orientent vers des méthodes électrochimiques, mais c’est très coûteux d’un point de vue énergétique. Il faut faire le bilan sur l’ensemble du cycle de vie de ces techniques.

En somme, on a une gamme de techniques, parfois appelées abusivement « solutions » : certaines que l’on ne recommande pas aujourd’hui parce que les risques sont énormes ; d’autres qu’il faut prioriser et recommander, mais qui ont une efficacité somme toute limitée. Et puis entre les deux, des méthodes sur lesquelles il faut continuer à travailler.

À l’échelle internationale, où et quand se discutent les nouveaux risques des techniques de géo-ingénierie climatique ?

L. B. : La question des puits de carbone est déjà largement débattue dans le cadre des COP Climat, notamment parce que les gouvernements peuvent les intégrer dans leurs objectifs de réduction des émissions. C’est le cas, par exemple, des stratégies d’afforestation (boisement) et de reforestation. En revanche, il reste encore beaucoup de travail à faire sur les modalités concrètes de mise en œuvre de certaines techniques d’élimination du CO₂ que nous avons évoquées. En particulier, les questions de mesure et de vérification du CO₂ réellement retiré de l’atmosphère sont complexes et loin d’être résolues. Le Giec a d’ailleurs été mandaté par les gouvernements pour produire un rapport méthodologique spécifiquement consacré à ces enjeux.

En ce qui concerne la modification du rayonnement solaire, mon inquiétude est nettement plus forte. Certains pays affichent désormais ouvertement leur intérêt pour un déploiement potentiel de ces techniques.

Dans le prochain rapport du Giec, la géo-ingénierie occupera une place plus importante que dans les précédents. J’espère que cela permettra de documenter de façon précise et convaincante les risques potentiels associés à ces approches.

Propos recueillis par Elsa Couderc.

Bopp Laurent a reçu des financements du CNRS, de l'Agence Nationale de la Recherche, de la Fondation pour la Recherche sur la Biodiversité, du Programme Horizon Europe de la Commission Européenne, et de la Fondation Schmidt Sciences.

20.01.2026 à 16:58

Des planètes errantes, sans étoile, découvertes par le satellite Euclid

Hervé Bouy, Professeur, Astrophysique, Université de Bordeaux

Texte intégral (1655 mots)

Sa mission est de cartographier le cosmos pour en dévoiler les mystères. Mais au passage, le satellite Euclid a découvert une quinzaine d’exoplanètes sans étoiles : des planètes errantes. On en connaît peu, mais Euclid et de futurs satellites devraient nous aider à comprendre leur formation.

Lorsque le télescope spatial Euclid de l’Agence spatiale européenne (ESA) a été lancé en 2023, son objectif était d’explorer l’un des plus grands mystères de l’Univers : le côté obscur du cosmos. En cartographiant des milliards de galaxies, Euclid doit aider à révéler la nature de la mystérieuse énergie noire qui serait le moteur de l’évolution du cosmos. Il n’avait pas été conçu pour étudier les régions de formation d’étoiles ni pour traquer des planètes.

Mais quelques mois après son lancement, l’ESA a mis en place le programme d’observations préliminaires d’Euclid (Euclid early release observations, ou ERO). Ce programme vise à démontrer les performances exceptionnelles du télescope à travers une large gamme d’objets astrophysiques, qu’il s’agisse de galaxies et d’amas lointains ou de régions de formation d’étoiles beaucoup plus proches. Cela permet de mettre en lumière la polyvalence et la précision des instruments d’Euclid, et prouver leur valeur bien au-delà de sa mission principale de cosmologie.

Des planètes sans soleil

Par définition, les planètes sont censées orbiter autour d’étoiles. Mais certaines sont solitaires, errant dans l’espace interstellaire sans étoile pour les réchauffer. Ces planètes errantes, comme on les surnomme, sont de véritables orphelines du cosmos. On pense qu’elles peuvent s’être formées comme des mini-étoiles, à partir de l’effondrement de petits nuages de gaz et de poussières.

Une autre hypothèse y voit de vraies planètes, nées autour d’une étoile et ayant été violemment éjectées de leur système d’origine. Les détecter et les étudier permet ainsi aux astronomes de mieux comprendre à la fois la formation des étoiles et la formation et l’évolution précoce (et parfois chaotique) des systèmes planétaires.

Jusqu’à présent, repérer ces corps discrets relevait presque de l’impossible tant la lumière qu’ils émettent est faible. Ils sont aussi très difficiles à distinguer d’autres objets astrophysiques, en particulier de galaxies lointaines. Mais Euclid, grâce à la combinaison unique d’un grand champ de vision, d’une résolution fine et d’une sensibilité allant de la lumière visible à l’infrarouge, a changé la donne.

Euclid prend le Taureau par les cornes

Lorsque l’ESA a proposé à la communauté scientifique de participer au programme ERO, notre équipe a suggéré de pointer Euclid vers une région de formation d’étoiles bien connue : le nuage LDN 1495, au sein de la constellation du Taureau, situé à environ 450 années-lumière. Cette région sombre, où le gaz et la poussière se condensent pour former de jeunes étoiles, est étudiée depuis des décennies, mais ne l’avait jamais été avec la précision et la sensibilité fournie par Euclid.

Les observations d’Euclid ont été combinées à plus de vingt ans d’imagerie au sol accumulée par notre équipe et obtenue avec des télescopes, comme le Canada-France-Hawaii Telescope (CFHT), Subaru ou UKIRT, tous les trois situés sur le sommet du volcan Mauna Kea dans l’archipel hawaiien (États-Unis). Cette longue période d’observation nous a permis de mesurer les mouvements, les luminosités et les couleurs de centaines de milliers de sources faibles dans ces images.

Parmi elles, 15 objets se distinguent. Leur luminosité, leur couleur et leur mouvement correspondent à ceux attendus pour des objets qui se sont formés dans les nuages moléculaires du Taureau. Ces objets partagent certaines propriétés : étant nés à peu près ensemble, ils sont tous jeunes (quelques millions d’années), situés à une distance similaire (celle des nuages, d’environ 425 à 490 années-lumière) et se déplacent ensemble à la même vitesse et dans la même direction dans le ciel, ayant hérité du mouvement du nuage moléculaire où ils sont nés. Neuf de ces quinze objets sont totalement nouveaux, et parmi les plus faibles et les moins massifs jamais détectés dans cette région.

Certains de ces candidats sont incroyablement petits : d’après leur luminosité extrêmement faible, ils pourraient avoir des masses proches ou légèrement supérieures à celle de Jupiter. C’est bien en dessous du seuil de masse d’une étoile ou même d’une naine brune, un astre plus gros qu’une planète, mais trop petit pour être une étoile. Cela les place donc clairement dans la catégorie des objets de masse planétaire. S’ils sont confirmés, ils compteraient parmi les objets les plus légers jamais détectés de manière directe en dehors d’un système solaire.

Une fenêtre sur les origines cosmiques

Cette découverte est bien plus qu’une curiosité : elle ouvre une fenêtre directe sur la façon dont l’Univers fabrique ses étoiles et ses planètes. Ces mondes solitaires se forment-ils de la même manière que les étoiles, à partir de petits fragments de nuages qui s’effondrent sous l’effet de la gravité ? Ou bien sont-ils les orphelins de systèmes planétaires, expulsés par le chaos gravitationnel de leur famille ?

Chacun de ces deux scénarios a des implications différentes pour notre compréhension des premiers stades de la formation stellaire, mais aussi de la formation des planètes. Dans des régions comme la constellation du Taureau, où la densité d’étoiles est faible et les étoiles massives sont rares, ces objets de masse planétaire pourraient se former directement par effondrement gravitationnel, brouillant encore davantage la frontière entre planète et étoile.

Les résultats de notre équipe suggèrent également que ces planètes errantes pourraient ne pas être si rares. En extrapolant nos résultats à l’ensemble du complexe du Taureau, on peut estimer que des dizaines d’entre elles, encore à découvrir, pourraient exister dans cette région.

Un Univers plein de surprises

Ce travail ne constitue qu’une première étape. Euclid a déjà observé d’autres régions de formation d’étoiles dans le cadre du programme ERO, actuellement en cours d’analyse, et pourrait en observer à nouveau à l’avenir, offrant ainsi des mesures de mouvements encore plus précises et des recensements plus complets.

À moyen terme, le futur télescope spatial Nancy-Grace-Roman, dont le lancement est prévu à l’automne 2026, disposera de capacités similaires et complémentaires en grand champ et en infrarouge. Ensemble, ces télescopes ouvriront une ère nouvelle pour l’étude systématique des objets de très faible masse dans les jeunes régions du cosmos.

Enfin, le James-Webb Space Telescope jouera un rôle clé dans le suivi de ces découvertes, en fournissant les observations spectroscopiques indispensables pour confirmer la nature, la masse et la composition des atmosphères de ces mondes errants. Ces missions dessinent un avenir particulièrement prometteur pour l’exploration des origines des étoiles et des planètes errantes.

À lire aussi : Euclid vs James-Webb : le match des télescopes spatiaux ?

Chaque nouveau grand télescope finit par accomplir des découvertes qu’il n’était pas censé faire. Le télescope spatial Hubble a révolutionné la cosmologie, mais il nous a aussi offert des vues spectaculaires des pouponnières d’étoiles. Aujourd’hui, Euclid, construit pour cartographier le squelette invisible du cosmos, révèle de nouveaux mondes en formation flottant dans l’Univers sans attache et sans étoile. Petits, froids et solitaires, ces mondes vagabonds nous rappellent que la frontière entre planète et étoile est mince et que, même dans l’obscurité entre les étoiles, il reste des histoires à découvrir.

Hervé Bouy est membre senior de l'Institut Universitaire de France. Il a reçu des financements du Conseil européen pour la recherche (ERC) et a été employé à l'Agence spatiale européenne (ESA).

19.01.2026 à 16:25

La microscopie de fluorescence à super-résolution : véritable tournant technologique dans l’analyse de la dynamique des mitochondries

Pauline Teixeira, Docteur en biologie cellulaire, Université d’Angers

Arnaud Chevrollier, Professeur des Universités Biologie Médicale, Biotechnologie, Université d’Angers

Solenn Plouzennec, Doctorante, Université d’Angers

Texte intégral (1890 mots)

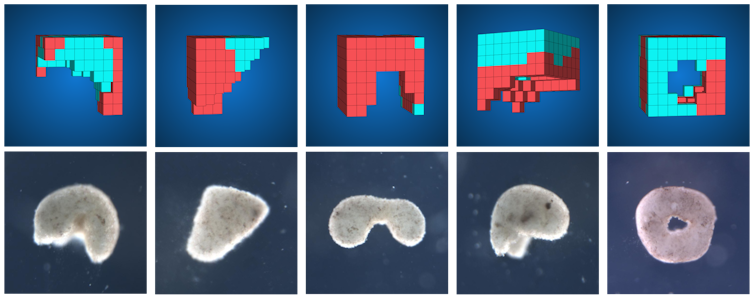

Explorer l’intérieur de nos cellules et leurs compartiments, tout en identifiant chaque protéine pour les cartographier, préciser leurs interactions et déchiffrer de nouveaux mécanismes biologiques… c’est désormais à notre portée grâce au développement de microscopes de super-résolution. Grâce à ces nouvelles techniques, les mitochondries, composants clés des cellules impliqués dans de nombreuses pathologies, révèlent une partie de leurs mystères.

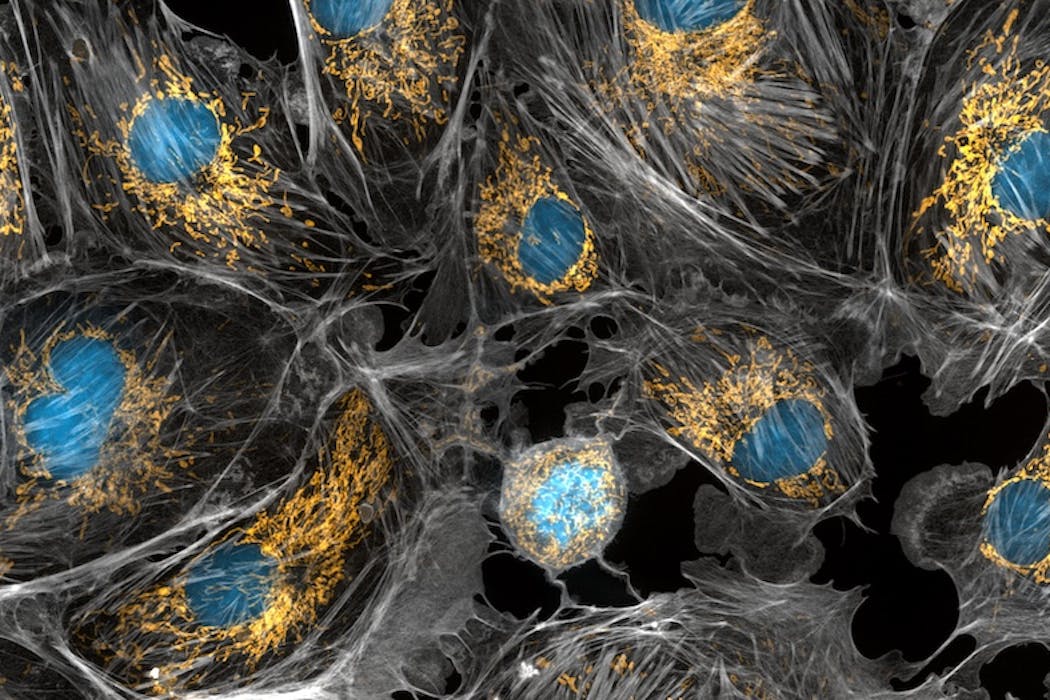

Les mitochondries sont principalement connues pour être les centrales énergétiques de nos cellules, car elles y sont responsables de la production d’énergie et de chaleur. Elles participent également à la synthèse de nombreuses molécules et assurent un contrôle crucial sur la vie et la mort des cellules. Récemment, des microscopes ultrasophistiqués ont permis de mettre à jour l’incroyable vie active des mitochondries, qui se déplacent, fusionnent entre elles et se séparent.

Ces progrès sont cruciaux car les mitochondries sont impliquées dans de nombreuses atteintes neurodégénératives, maladies cardio-vasculaires et cancers. Comprendre comment les mitochondries endommagées contribuent au processus d’une maladie est essentiel pour le développement de traitements.

Les mitochondries, un réseau en reconfiguration perpétuelle

Dans la plupart des cellules et des tissus, les mitochondries ont la forme de tubes, plus ou moins longs. Les mitochondries s’adaptent à la taille et aux besoins énergétiques des cellules, ainsi dans les larges cellules énergivores, il peut y avoir plus de 200 000 mitochondries par cellules tandis que dans d’autres cellules, il y aurait moins de 100 mitochondries. En fonction de l’organe d’origine de la cellule, les mitochondries se répartissent dans la cellule et forment de grands réseaux. Elles changent également sans cesse de formes et leurs attachements avec les autres structures de la cellule.

Dès les années 1950, les données de microscopies électroniques ont révélé la structure de ces petits tubes et précisé leur organisation membranaire. Leur membrane externe est doublée d’une membrane interne, qui s’invagine et forme des poches à l’intérieur des mitochondries. Ces poches sont appelées crêtes et sont le lieu de la synthèse d’énergie.

Pour bien comprendre la fonction des mitochondries, il faut donc s’intéresser à leur structure, leur dynamique et leur distribution. Un axe important de travaux scientifiques porte sur cette relation structure-fonction afin de découvrir de nouveaux moyens de protéger la morphologie mitochondriale et de développer des stratégies thérapeutiques pour lutter contre les maladies mitochondriales ou les atteintes neurodégénératives.

La microscopie de fluorescence, la clé pour le suivi des mitochondries en temps réel

Si la microscopie électronique permet d’obtenir des vues extrêmement détaillées des mitochondries, son utilisation ne permet pas de rendre compte de la complexité de leur organisation au sein des cellules, ni de leur nature dynamique. En effet, ce type de microscopie se limite à des images cellulaires figées dans le temps. C’est ici qu’intervient la microscopie de fluorescence, un domaine en pleine effervescence qui permet de capturer des images ou des vidéos.

La microscopie de fluorescence repose sur le principe d’excitation et d’émission contrôlées de photons, particules composant la lumière, par des molécules présentes dans les cellules. Contrairement aux microscopes à fond clair, qui sont les microscopes les plus simples, comme ceux utilisés en cours de sciences, et où l’image est générée à partir des signaux collectés après le passage de la lumière à travers l’échantillon, les microscopes à fluorescence collectent les signaux lumineux qui proviennent de l’objet biologique lui-même, comme des petites ampoules que l’on allumerait au cœur de la cellule.

Le développement de l’informatique et des capteurs de caméra sensibles et rapides ont également rendu possible le suivi des signaux dans le temps, et la quantification des mouvements de chaque compartiment des mitochondries.

La super-résolution, quand la science éclaire l’invisible

Pour aller plus loin que ces observations déjà fascinantes de réseaux de mitochondries, la microscopie de fluorescence ne suffit pas. En effet, en microscopie optique, les objets plus petits qu’une certaine taille, environ 200-300 nanomètres radialement et 500-700 nanomètres axialement, ne peuvent pas être distingués. En effet, selon un principe physique, la diffraction de la lumière, soit la déviation des rayons lumineux, fait qu’un émetteur unique apparaît comme une tache sur la caméra – on parle de figure de diffraction, et plus précisément ici de « fonction d’étalement du point ».

Cette limitation entrave l’observation précise de structures complexes telles que les mitochondries du fait de leur taille qui est similaire à la limite de diffraction.

La microscopie de fluorescence à super-résolution (microSR) a changé la donne dans le domaine de la recherche biologique depuis les années 2000. Grâce à cette technologie, les scientifiques peuvent pénétrer dans le monde nanoscopique et observer en temps réel les structures complexes et les interactions des composants cellulaires. La microscopie de fluorescence à super-résolution englobe quatre techniques principales, dont l’une a été récompensée par le prix Nobel de chimie en 2014.

Chacune de ces techniques s’attaque à la limite de diffraction d’une manière unique, permettant de séparer des points situés à moins de 200 nanomètres. Cette avancée permet aux chercheurs d’atteindre des résolutions spatiales de quelques nanomètres, dévoilant ainsi les détails les plus fins des structures cellulaires comme jamais auparavant. Restreints il y a encore peu de temps à quelques laboratoires prestigieux dans le monde, ces équipements se démocratisent et se déploient dans les plates-formes de microscopie.

La mitochondrie sous un nouveau jour, dévoilée à l’échelle nanométrique

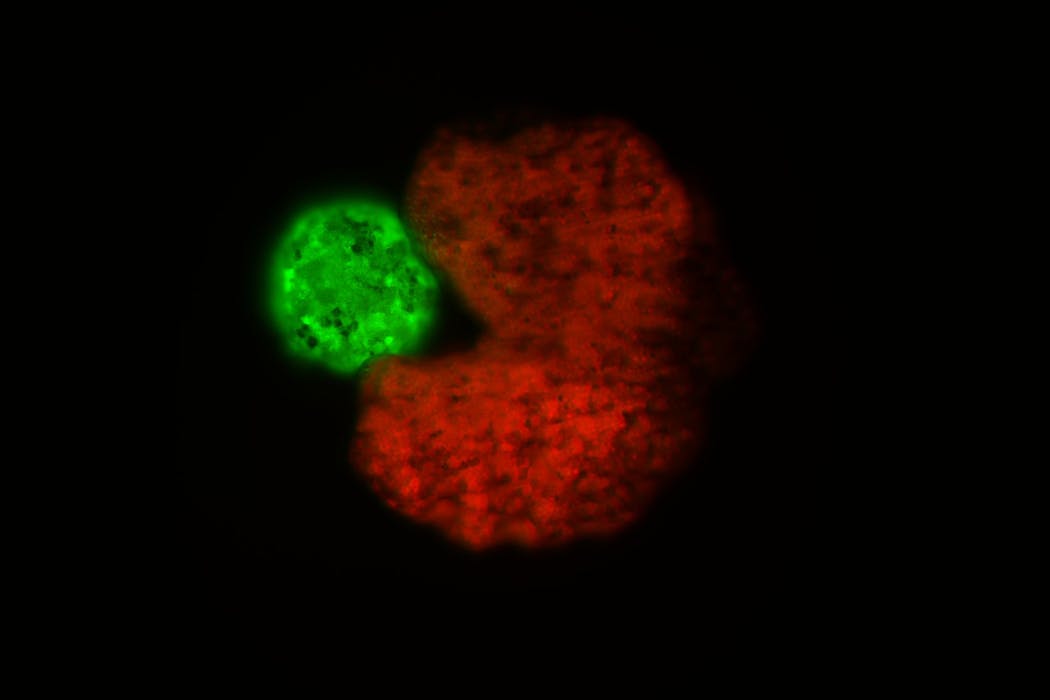

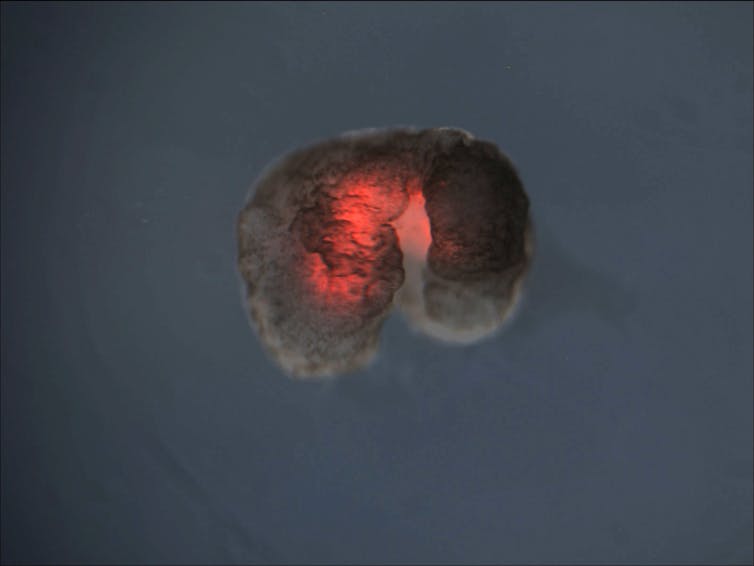

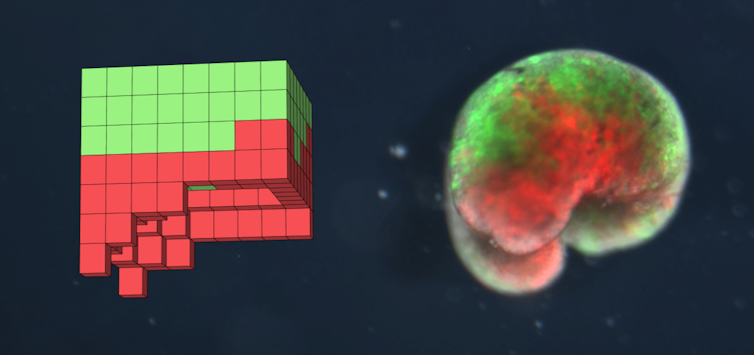

Nous avons utilisé un type de microscopie de fluorescence à super-résolution, la microscopie de localisation de molécules uniques, qui nous a permis d’identifier les protéines sur les membranes des mitochondries et de les cartographier.

Avec un autre type de microscopie de fluorescence à super-résolution, nous avons visualisé le contour des crêtes, retrouvant ainsi le visuel connu d’une image de microscopie électronique… à ceci près qu’aucun traitement chimique liée à la fixation de l’échantillon n’est venu perturber l’organisation de ces fines membranes et fragiles petites poches. Ceci permet de découvrir la complexité interne des mitochondries et l’hétérogénéité de ses structures, afin de corréler la morphologie des mitochondries à leur activité ou à la présence de défaut génétique.

Ces images donnent accès à deux échelles de temps, c’est-à-dire deux niveaux de cinétique. D’une part, sur quelques minutes durant lesquelles nous pouvons observer, nous voyons que les mitochondries se déplacent, changent de forme, fusionnent entre elles ou se séparent.

D’autre part, toujours avec la microscopie de super résolution, nous pouvons observer sur quelques secondes, toute l’ondulation et le remodelage des structures internes des mitochondries nécessaires à la production d’énergie.

Ainsi, on découvre que les mitochondries ne sont pas de simples centrales énergétiques cellulaires mais des organites dynamiques possédant de nombreuses particularités nanoscopiques. La microscopie de super résolution permet d’envisager une meilleure compréhension de comment les mitochondries endommagées contribuent au processus de nombreuses maladies, ce qui est essentiel pour le développement de traitements.

Arnaud Chevrollier a reçu des financements de l'Université d'Angers, AFM-téléthon

Pauline Teixeira et Solenn Plouzennec ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

19.01.2026 à 16:06

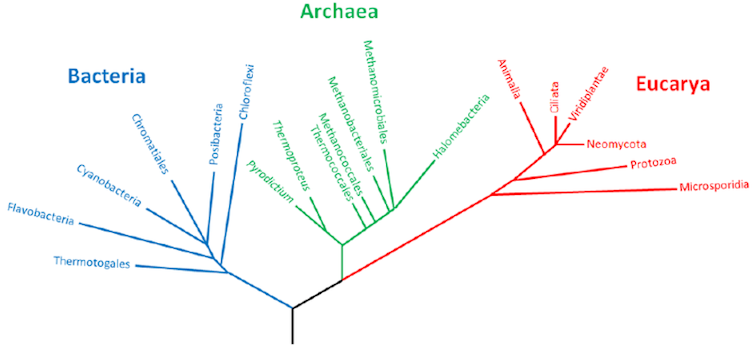

L’origine du « moustique du métro de Londres » enfin résolue

Haoues Alout, chargé de recherche, Inrae

Texte intégral (1808 mots)

Longtemps présenté comme un exemple spectaculaire d’adaptation rapide à l’urbanisation, le « moustique du métro de Londres » n’est en réalité pas né dans les tunnels londoniens, comme on le pensait jusqu’ici. Une nouvelle étude retrace ses origines et montre qu’elles sont bien plus anciennes que ce que l’on imaginait. Elles remonteraient à plus de mille ans, en lien avec le développement des sociétés agricoles.

Et si le « moustique du métro de Londres », surtout connu pour ses piqûres sur les populations réfugiées à Londres dans les sous-sols de la ville pendant la Seconde Guerre mondiale, n’était en réalité pas né dans les tunnels londoniens ? C’est ce que révèle une étude que nous avons récemment publiée avec des collègues.

Nos résultats montrent que les caractéristiques « urbaines » de ce moustique, que l’on pensait s’être adapté à la vie souterraine il y a un peu plus d’un siècle, remontent en fait à plus de mille ans.

Le moustique Culex pipiens molestus, qui diffère de son cousin Culex pipiens pipiens dans la mesure où le premier pique surtout des humains, et le second surtout des oiseaux, est probablement né dans la vallée du Nil ou au Moyen-Orient, en lien avec le développement des premières sociétés agricoles humaines.

À lire aussi : Combien de temps un moustique peut-il survivre sans piquer un humain ?

Le « moustique du métro de Londres » n’est pas né dans le métro

Cette découverte jette une lumière nouvelle sur l’évolution des moustiques. Depuis plusieurs décennies, une hypothèse présentait en effet le moustique commun (Culex pipiens) comme un exemple spectaculaire d’adaptation rapide à l’urbanisation.

Selon cette théorie, une forme particulière de ce moustique, appelée Culex pipiens molestus, se serait adaptée à la vie urbaine en un peu plus de cent ans seulement, à partir de sa forme jumelle Culex pipiens pipiens. Là où celle-ci préfère piquer les oiseaux, s’accoupler dans des espaces ouverts et « hiberner » pendant l’hiver, la forme molestus aurait évolué en une forme quasi distincte, capable de vivre dans les souterrains et de piquer l’humain et d’autres mammifères, de s’accoupler dans des souterrains et de rester actif toute l’année.

Cette adaptation spectaculaire du « moustique du métro de Londres » était devenue un cas d’école, figurant dans de nombreux manuels d’écologie et d’évolution. L’idée sous-jacente était que l’urbanisation des villes pouvait sélectionner à grande vitesse de nouvelles espèces et en quelque sorte « accélérer » l’évolution.

Mais notre étude vient montrer que cette belle histoire, aussi séduisante soit-elle, est fausse.

Un moustique urbain… né bien avant les villes modernes

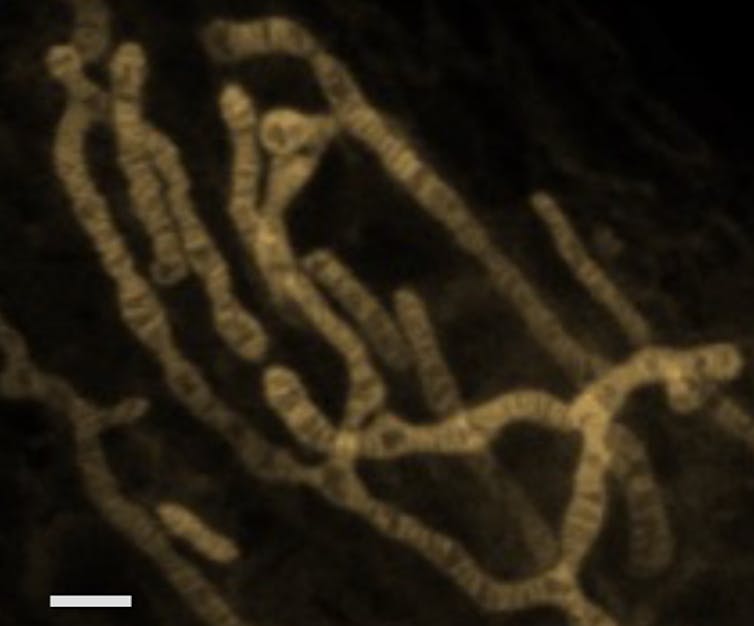

Notre consortium international de chercheurs PipPop a ainsi publié dans la revue Science une étude qui démystifie cette hypothèse. En séquençant le génome de plus de 350 moustiques, contemporains et historiques, issus de 77 populations d’Europe, d’Afrique du Nord et d’Asie occidentale, nous avons reconstitué leur histoire évolutive.

En définitive, les caractéristiques qui font de Culex pipiens molestus un moustique si adapté à la vie urbaine ne sont pas apparues dans le métro londonien, mais bien plus tôt, il y a plus de mille ans, vraisemblablement dans la vallée du Nil ou au Moyen-Orient. Ce résultat remet en question ce qui était considéré comme un exemple clé de l’évolution urbaine rapide. Au final, il s’agirait d’une adaptation plus lente, associée au développement de sociétés humaines anciennes.

Autrement dit, ce moustique était déjà « urbain » (au sens : étroitement associé aux humains) bien avant l’ère industrielle. Les premières sociétés agricoles, avec leurs villages denses, leurs systèmes d’irrigation et leurs réserves d’eau, lui ont offert un terrain de jeu idéal pour son adaptation.

À lire aussi : Comment les moustiques nous piquent (et les conséquences)

Un acteur clé des épidémies modernes

Le moustique Culex pipiens n’est pas juste une curiosité scientifique : il joue un rôle majeur dans la transmission de virus comme ceux du Nil occidental ou d’Usutu. Ces derniers circulent surtout chez les oiseaux mais peuvent aussi être transmis aux humains et aux mammifères.

La forme Culex pipiens pipiens, qui pique les oiseaux, est principalement responsable de la transmission du virus dans l’avifaune, tandis que Culex pipiens molestus est vu comme responsable de la transmission aux humains et aux mammifères.

Lorsque les deux se croisent et s’hybrident, ils pourraient donner naissance à des moustiques au régime mixte, capables de « faire le pont » entre oiseaux et humains et de nous transmettre des virus dits zoonotiques.

De fait, nos analyses confirment que les deux formes s’hybrident davantage dans les villes densément peuplées, augmentant le risque de transmission de ces virus. Autrement dit la densité humaine augmente les occasions de rencontre entre les deux formes de moustiques – et potentiellement la probabilité de produire des moustiques capables de piquer à la fois les oiseaux et les humains.

Comprendre quand et où ces deux formes se croisent et comment leurs gènes se mélangent est donc crucial pour anticiper les risques d’épidémie.

Repenser l’adaptation urbaine

L’histoire du « moustique du métro de Londres » a eu un immense succès parce qu’elle incarne en une image frappante tout ce que l’on redoute et admire dans l’adaptation rapide des espèces à nos environnements. Par exemple, une adaptation très rapide face à l’augmentation de la pollution et de l’artificialisation des habitats, souvent mobilisée dans les imaginaires, de science-fiction en particulier.

Mais la réalité est tout autre : les moustiques de nos villes modernes ne sont pas une nouveauté née dans le métro londonien. En revanche, le développement urbain a offert une nouvelle scène à un acteur déjà préparé par des millénaires de cohabitation avec les humains dans les premières sociétés agricoles du Moyen-Orient et de la Méditerranée. Le fruit de cette évolution a ensuite pu être « recyclé » dans les villes contemporaines.

On parle alors d’ « exaptation », c’est-à-dire qu’un trait préexistant dans un contexte donné (ici les premières villes du Moyen-Orient) devient avantageux dans un autre contexte (les villes du nord de l’Europe). Les circuits sensoriels et métaboliques qui pilotent la recherche d’hôtes à piquer, la prise de repas sanguin et la reproduction avaient déjà été remodelés par l’histoire ancienne des sociétés agricoles de la Méditerranée et du Moyen-Orient, avant d’être « réutilisés » dans le contexte urbain moderne au nord de l’Europe.

Nos systèmes d’irrigation antiques, nos premières villes et nos habitudes de stockage de l’eau ont donc posé les bases génétiques qui permettent aujourd’hui à certains moustiques de prospérer dans les galeries de métro ou les sous-sols d’immeubles de nos grandes villes.

Cette découverte change la donne. En retraçant l’histoire de la forme urbaine du moustique commun Culex pipiens, l’étude invite à changer de regard sur l’évolution urbaine : ce n’est pas seulement une adaptation rapide déclenchée par l’urbanisation intensive des villes, mais un long processus qui relie notre développement technique et social et celle des autres espèces.

Comprendre ces dynamiques est crucial : non seulement pour la science, mais aussi pour anticiper les risques sanitaires et mieux cohabiter avec les autres espèces. Et vous, saviez-vous que le moustique qui vous pique la nuit avait une histoire évolutive aussi ancienne ?

Haoues Alout a reçu des financements de l'ANR et de l'ANSES ainsi que de l'Union Européenne.

18.01.2026 à 20:51

Les plantes aussi ont un microbiote – pourrait-on s’en servir pour se passer de phytosanitaires ?

Cécile Monard, Chargée de recherche, Centre national de la recherche scientifique (CNRS)

Abdelhak El Amrani, MCF-Génomique Fonctionnelle

Texte intégral (1359 mots)

Les plantes et leur microbiote – tout comme les humains et leur microbiote –échangent du matériel génétique. En étudiant cette forme de communication entre les partenaires d’une symbiose, des scientifiques montrent comment les racines peuvent favoriser l’accès aux nitrates présents dans le sol – une ressource indispensable à la croissance des plantes. Ils et elles explorent aussi l’hypothèse que ce langage permette de lutter contre les pathogènes.

Depuis une dizaine d’années, une nouvelle vision des organismes s’impose. Les êtres humains, les animaux et les plantes ne peuvent exister sans leur association avec une myriade d’espèces de microorganismes qui constituent leur microbiote et qui leur apportent des fonctions biologiques complémentaires à leur hôte.

Par exemple, les champignons « mycorhiziens » prolongent les fonctions racinaires des plantes. Ils leur permettent notamment d’explorer le sol et ses ressources ; et apportent une fonction protectrice contre les pathogènes grâce à leur capacité à synthétiser des fongicides et des antibiotiques.

Cet ensemble « hôte et microbiote » forme ce que l’on appelle l’« holobionte », et il est maintenant admis qu’il s’agit d’une unité évolutive et fonctionnelle à prendre en compte dans son ensemble.

Cette nouvelle vision des organismes, non plus comme des individus uniques mais comme des métaorganismes, implique l’existence d’un dialogue entre les différents partenaires de cet ensemble complexe – que nous nous efforçons aujourd’hui de décoder.

Un nouveau langage, fondé sur le transfert de « code génétique » au sein des êtres vivants

Au sein des êtres vivants, différents mécanismes de communication sont connus, permettant le transfert d’informations à différentes échelles de l’organisme. Il peut s’agir d’échanges d’ions, comme le calcium ou le potassium entre les cellules, de signaux électriques à travers nos neurones ou encore le transport d’hormones dans le sang, comme l’insuline qui régule la glycémie en fonction de notre régime alimentaire.

Il existe même des petites protéines ou des peptides capables de voyager entre les organes, qui peuvent par exemple être impliqués dans l’immunité. Un cas très étudié est celui de la systémine, produite par les feuilles de plantes blessées. Ce peptide est transféré à d’autres organes pour induire des mécanismes de défense dans la plante entière.

En plus de cet arsenal de dialogues moléculaires, une autre voie de communication a été découverte en 1993 et a révolutionné le domaine de la communication chez les organismes vivants. Elle est basée sur l’échange de matériel génétique, composé de mini-séquences appelées « microARN », entre différentes cellules et/ou organes d’un même individu.

Initialement observée chez un nématode (un ver microscopique), cette découverte a ensuite été généralisée à d’autres animaux, aux êtres humains et aux plantes. Elle a donné lieu à l’attribution du prix Nobel de médecine 2024 à Victor Ambros et Gary Ruvkun.

Les premières recherches ont montré que ces microARN sont des intermédiaires de communication impliqués dans la majorité des processus biologiques, depuis l’embryogenèse jusqu’au vieillissement, et affecte notamment l’immunité et la résistance des organismes aux contraintes environnementales.

Un langage aussi utilisé entre différents êtres vivants