22.01.2026 à 15:59

Apprendre à varier son alimentation : écouter les émotions des enfants, un enjeu central

Aurélie Maurice, Maîtresse de conférences en Sciences de l'Éducation et de la Formation, Université Sorbonne Paris Nord

Texte intégral (1336 mots)

Se nourrir est un acte complexe, croisant psychologie, culture et physiologie. Dès lors, comment s’y prendre, en tant que parent ou éducateur, pour aider les enfants à former leur goût et élargir leur répertoire alimentaire ? La recherche donne quelques pistes pour mieux tenir compte de la place des émotions dans le rapport à la nourriture.

L’éducation à l’alimentation des jeunes est au cœur des politiques publiques : elle est l’un des objectifs du Programme national nutrition santé (PNNS) et l’un des axes du Programme national pour l’alimentation (PNA). De plus, un Vademecum sur l’éducation à l’alimentation et au goût a récemment émané de l’éducation nationale. Plusieurs membres de l’Assemblée nationale organisent aussi depuis quelques années des « états généraux » sur le sujet.

Les derniers états généraux d’octobre 2025 ont conduit à une proposition de loi d’expérimentation pour l’instauration d’un enseignement d’éducation à l’alimentation obligatoire à l’école.

À lire aussi : Comment peut-on repenser l’éducation à l’alimentation ?

Alors que l’éducation à l’alimentation s’est longtemps heurtée à des limites, notamment face aux inégalités sociales de santé, de nouvelles approches apparaissent : citons l’approche tridimensionnelle qui intègre les dimensions « nutritionnelle », « psycho-sensorielle et comportementale » et « socio-environnementale ». L’approche hédonique, elle, privilégie le plaisir alimentaire avec trois leviers d’actions : l’exposition sensorielle répétée aux aliments, les interactions sociales lors des prises alimentaires et les croyances sur les aliments.

Si ces démarches mettent en avant l’importance des émotions, comment, concrètement, les prendre en compte au quotidien, lors de repas ou de séances de découverte, que l’on soit parent, acteur ou actrice de l’éducation ?

Veiller au contexte des repas

S’alimenter est un acte complexe, car multidimensionnel : physiologie, sociabilité, identité culturelle et psychologie s’entremêlent. S’alimenter, c’est aussi ressentir toute une palette d’émotions : la joie, le dégoût, la peur… Celles-ci sont pour l’instant peu prises en compte globalement dans les séances d’éducation à l’alimentation. C’est le cas néanmoins dans l’éducation au goût, qui cherche à reconnecter les jeunes avec leurs sens.

Marie Jaunet, Sylvie Delaroche-Houot et moi-même avons mené une revue de la littérature scientifique afin d’explorer comment les émotions peuvent être mobilisées dans le champ de l’éducation à l’alimentation et quels en sont les bénéfices. Cette revue a été effectuée sur 30 articles publiés entre 2005 et 2022, dont 90 % en anglais, provenant principalement d’Amérique du Nord et d’Europe occidentale.

Cette revue montre que les émotions des jeunes sont bel et bien à prendre en compte, et ce, pour plusieurs raisons. Tout d’abord, il apparaît que la composition nutritionnelle des aliments a un impact sur ces émotions. Un repas suffisamment varié et correspondant bien aux besoins nutritionnels des enfants diminuerait les émotions négatives, comme la tristesse ou l’anxiété.

Ensuite, l’importance d’être attentif à ses cinq sens quand on se nourrit est soulignée, notamment, par des études sur l’alimentation consciente chez les enfants. Créer un environnement positif pendant les repas, c’est-à-dire faire du moment du repas un moment joyeux, ludique et apaisant, favorise une prise alimentaire diversifiée et en quantité suffisante de la part des enfants. Cette attention portée à la qualité de l’ambiance des repas est d’autant plus bénéfique qu’elle est travaillée tant à la maison qu’à l’école.

En obligeant les enfants à finir leurs assiettes, ou en se servant de l’alimentation comme d’une récompense ou d’un élément de chantage, certains parents peuvent favoriser le développement d’une « alimentation émotionnelle » chez leurs enfants. Cela peut conduire à un surpoids à moyen et long terme.

Favoriser l’empathie

Un groupe d’experts est arrivé à une classification des styles éducatifs parentaux sur l’alimentation qui en distingue trois types : coercitif (fondé sur la pression, les menaces et les récompenses), structuré (donnant des règles qui encadrent les prises alimentaires) et favorisant l’autonomie (donnant les clés à l’enfant pour qu’il fasse ses propres choix, dans un climat d’amour inconditionnel).

Ces trois grandes catégories conduisent à des états émotionnels très différents, allant de la peur à la joie, et à des pratiques alimentaires enfantines très contrastées (se cacher pour manger des aliments interdits, se restreindre de manière autonome).

Le repas familial peut être un moment propice au partage et à l’écoute des émotions de l’enfant. Aux États-Unis apparaît depuis plusieurs décennies un terme, « parent responsiveness », qui pourrait être traduit par « réactivité parentale », à savoir une attitude empathique des parents, apportant une réponse adaptée aux émotions exprimées par leurs enfants et aux besoins sous-jacents.

Plusieurs chercheurs ont proposé d’adapter ce concept à l’alimentation, et parlent de « responsive feeding » ou « réactivité alimentaire ». Il s’agit de soigner le temps du repas, d’en faire un moment pendant lequel l’enfant se sent à l’aise et en confiance. Le parent cherche à être attentif aux sensations de faim et de satiété de son enfant, à lui répondre rapidement, de façon appropriée, en fonction de l’émotion qu’il exprime et de son stade de développement.

Enfin, les articles étudiés dans la revue de littérature font état de plusieurs outils conçus pour aider les enfants à s’exprimer autour de l’alimentation et à nommer leurs émotions.

Cette revue montre qu’il faut prendre en compte les différentes dimensions de l’acte alimentaire, tel que l’environnement dans lequel l’aliment est consommé. Un climat bienveillant et joyeux apparaît plus propice aux nouvelles expériences gustatives, alors que, si l’enfant se sent contraint, voire angoissé, les conditions ne sont pas réunies pour qu’il découvre de nouveaux aliments ou accepte de manger des légumes, par exemple.

La politique publique des mille premiers jours de l’enfant recommande des activités conjointes parents/enfant, sources d’émotions positives dans lesquelles l’alimentation a toute sa place. Il apparaît donc que la formation tant des parents que des enseignants, des personnels du périscolaire et des autres professionnels éducateurs est essentielle pour développer la capacité d’autorégulation et d’ouverture des jeunes dans leur alimentation.

Aurélie Maurice a reçu des financements de l'ANR pour le projet ERMES qu'elle coordonne.

22.01.2026 à 15:56

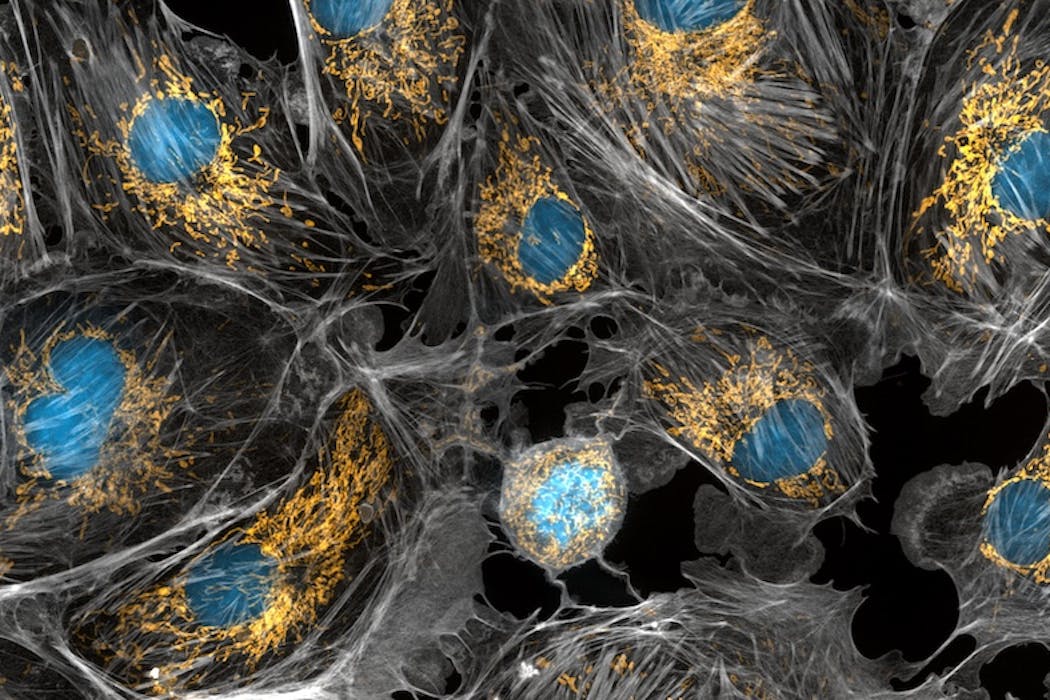

Les « actions cachées » : quand des régions du cerveau liées à la motricité s’activent… alors qu’on ne bouge pas

Carol Madden-Lombardi, Chargée de recherche, Université Bourgogne Europe

Florent Lebon, Professeur des Universités en Neurosciences cognitives et comportementales, Université Claude Bernard Lyon 1

Texte intégral (1514 mots)

Les « actions cachées » engagent des régions cérébrales liées à la motricité alors qu’on reste immobile. Cette plasticité des neurones, qui renforce les liens entre le cerveau et les muscles, n’a pas encore livré tous ses secrets. Mais ces processus cognitifs pourraient, dans le futur, se révéler précieux pour optimiser des gestes sportifs ou encore favoriser la rééducation après une blessure.

En bout de piste, un sauteur en longueur se prépare pour son dernier essai. La médaille est en jeu. Avant de s’élancer, il répète mentalement sa course d’élan, les premières foulées, l’accélération, l’impulsion et la réception dans le sable. Il rouvre les yeux, et c’est parti !

Une jeune joueuse de volley-ball assiste à un match de son équipe préférée. Elle observe la posture des joueuses en attaque et en défense, la manière dont elles se déplacent. Elle comprend la tactique annoncée et s’attend à ce que son équipe marque. Elle apprend en observant !

L’être humain possède l’extraordinaire capacité d’imaginer ses propres mouvements, de comprendre les actions d’autrui par la simple observation, ou encore de communiquer et transmettre ses actions par l’écriture et la lecture.

Activation du cerveau sans bouger

Tous ces processus cognitifs engagent des régions cérébrales liées à la motricité, alors même que l’on ne bouge pas. Ils peuvent être identifiés sous le terme d’« actions cachées ». Même si on est immobile, certaines parties de notre cerveau, normalement actives pendant nos actions, le sont également pendant les actions cachées, telles que l’imagerie motrice, l’observation d’action ou encore le langage d’action.

L’imagerie motrice correspond au fait de se représenter mentalement, de façon consciente, un mouvement, sans l’exécuter physiquement. Les modalités basées sur les sens permettent de se représenter une action. Les deux principales sont le visuel (« se voir » en train de faire l’action) et le kinesthésique (« ressentir » les sensations associées au mouvement). L’observation d’action, elle, consiste à sélectionner les informations pertinentes d’une action en train de se réaliser, et d’en comprendre les intentions.

Enfin, dans ce contexte, le langage d’action fait référence à la lecture, silencieuse ou non, de verbes évoquant une action, tels que « serrer », « prendre », « sauter ». Ces verbes isolés peuvent être enrichis par un contexte (« je vois une orange sur la table, je la prends ») afin d’activer d’autant plus le système moteur lié à cette action.

Les outils technologiques actuels nous permettent de « voir » à l’intérieur de notre cerveau. On parle alors d’imagerie par résonance magnétique (IRM) ou de stimulation magnétique transcrânienne (TMS).

La découverte des neurones miroirs

Rappelons qu’une grande étape dans la compréhension des actions cachées a été la découverte des neurones miroirs. Une équipe italienne, menée par Rizzolatti, a enregistrée dans le cerveau de singes, l’activité de neurones qui déchargeaient non seulement lorsque le singe exécutait une action de préhension d’un objet, mais aussi lorsqu’il observait l’expérimentateur saisir cet objet – une découverte accidentelle mais révolutionnaire.

Les actions cachées activent ainsi un réseau complexe au sein du cerveau, montrant l’interaction entre plusieurs régions, telles que le cortex moteur primaire (de là où partent nos commandes motrices), le cortex occipital (là où sont traitées les informations visuelles) ou encore le cortex pariétal (là où sont traitées les informations sensorielles).

La majorité des personnes peuvent ainsi recréer mentalement leur dernier lieu de vacances au soleil, avec plus ou moins de détails, et s’imaginer courir sur la plage (pour exception, voir l’article sur l’aphantasie).

On dit alors que les processus cognitifs associés à nos actions sont incarnés dans notre cerveau (théories de la cognition incarnée). Il n’est pas nécessaire de bouger pour activer le réseau de la motricité. La simulation mentale nous permettrait de planifier nos propres actions, de comprendre les actions d’autrui, de juger les conséquences des actions ou encore de comprendre plus facilement un récit impliquant des actions.

Même si cette simulation n’est pas explicite (c’est-à-dire qu’on ne crée pas volontairement d’images dans notre tête, et on n’en est peut-être même pas conscient), elle optimiserait notre imagerie et la compréhension des actions (par l’observation et le langage).

Des actions cachées pour renforcer les liens entre cerveau et muscles

Ces différents types d’actions cachées peuvent être utilisées de manière très pratique pour apprendre un nouveau morceau de musique, optimiser son geste sportif ou encore récupérer à la suite d’une blessure ou d’une pathologie, sans risquer d’accident ni de fatigue.

Une des études pionnières est celle de Yue et Cole, en 1992. Par le simple fait d’imaginer des contractions de la main, tel un entraînement à raison de quatre séances par semaine pendant quatre semaines, les participants ont réussi à augmenter leur force de 22 %. La plasticité cérébrale rentre en jeu pour renforcer les réseaux neuronaux normalement impliqués dans l’action. Plus je répète mentalement, plus j’entraîne mon cerveau : je renforce les liens entre le cerveau et les muscles.

Des perspectives pour, demain, favoriser l’apprentissage ou la rééducation

Se représenter mentalement des mouvements peut également améliorer d’autres capacités, comportementale ou cognitive. Une récente étude montre qu’imaginer des actions simples (écrire, lancer, remplir une tasse, etc.) peut améliorer la performance à des tâches de compréhension du langage, en facilitation l’accès lexico-sémantique.

À l’heure actuelle, les chercheurs s’attachent à mieux comprendre les liens entre les différents types d’actions cachées et à optimiser leur utilisation. Dans des études encore en cours, ils testent, par exemple, la combinaison de ces actions cachées dans le but de favoriser d’autant plus l’apprentissage et la rééducation. Il est possible de combiner l’observation d’un adversaire au tennis et d’imaginer le coup approprié pour gagner le point. Ou bien il est envisageable de lire des verbes d’actions avant d’imaginer un mouvement de force pour en booster les effets.

L’enjeu est alors de trouver le bon dosage entre les différentes pratiques, pour éviter la fatigue mentale, tout en observant des effets positifs.

Il est à noter que ces différents types d’actions cachées restent distincts. Ils restent encore des zones d’ombre pour comprendre leur interaction potentielle et favoriser ainsi leur utilisation seule ou combinée.

Le cerveau a encore des choses à nous dévoiler.

Les projets « Interaction entre Langage et Imagerie motrice pour améliorer l’apprentissage moteur et la compréhension du langage » – LAMI – et « Explorer les marqueurs neuronaux et fonctionnels des actions cachées à travers le prisme de la phantasie » – COVACT – sont soutenus par l’Agence nationale de la recherche (ANR), qui finance en France la recherche sur projets. Elle a pour mission de soutenir et de promouvoir le développement de recherches fondamentales et finalisées dans toutes les disciplines, et de renforcer le dialogue entre science et société. Pour en savoir plus, consultez le site de l’ANR.

Florent Lebon a reçu des financements de l'agence nationale de la recherche.

Carol Madden-Lombardi ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

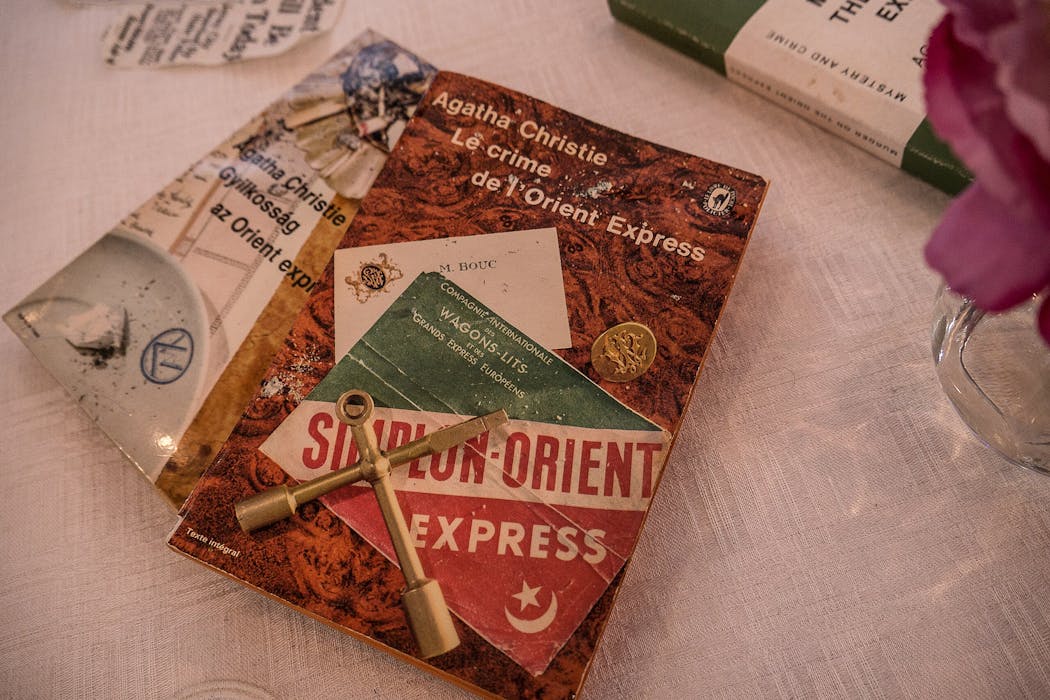

22.01.2026 à 15:56

Face aux attaques contre la science, l’importance d’inscrire la liberté académique dans la Constitution belge

Édouard Delruelle, Professeur de Philosophie politique, Université de Liège

Texte intégral (2491 mots)

Dans le cadre de notre émission consacrée à la défense de la liberté académique, diffusée vendredi 23 janvier, nous publions cet article initialement paru dans le Quinzième jour, le quadrimestriel de l’Université de Liège. Édouard Delruelle y développe un plaidoyer en faveur de l’inscription de la liberté académique dans la Constitution belge comme une étape pour ouvrir un débat démocratique sur le sujet.

En septembre dernier, l’Université de Berkeley, temple historique de la liberté de pensée, a accepté de livrer à l’administration Trump une liste d’étudiants et de professeurs suspectés d’« antisémitisme » en raison de leur engagement en faveur de la cause palestinienne.

Dans cette liste figure la philosophe Judith Butler, docteure honoris causa de l’université de Liège. Qui aurait imaginé, il y a un an à peine, que les universités les plus performantes et les plus prestigieuses au monde seraient l’objet d’attaques aussi violentes de la part du pouvoir politique, et qu’elles céderaient si prestement à ses intimidations et injonctions ? Que des programmes de recherche essentiels pour l’avenir de l’humanité dans les domaines de la santé ou du climat seraient démantelés ? Que les chercheurs en sciences humaines et sociales devraient bannir de leur vocabulaire des termes tels que diversité, égalité, inclusion ?

En Belgique, des coupes et des inquiétudes

Pourtant, nous avions tort de penser que ces atteintes brutales à la liberté académique ne pouvaient avoir cours que dans les régimes autoritaires. Cela fait plusieurs années que l’Academic Freedom Index enregistre une dégradation de la liberté académique en Europe. Intrusion du management dans la gouvernance universitaire, culture de la « post-vérité » sur les réseaux sociaux, ciblage d’intellectuels critiques par l’extrême droite, stigmatisation d’un prétendu « wokisme » que propageraient les études de genre, décoloniales ou LGBTQIA+ : ces offensives ne sont pas neuves, et elles touchent aussi la Belgique.

Mais un coup d’accélérateur a indéniablement été donné en 2025, avec les coupes budgétaires dans la recherche décidées par le gouvernement de la Fédération Wallonie-Bruxelles, une réforme drastique des retraites des Académiques, avant d’autres mesures annoncées sur le précompte chercheur ou le statut de fonctionnaire. Les mouvements Stand Up for Science au niveau mondial, ou « Université en Colère » chez nous, témoignent de l’inquiétude de la communauté universitaire face aux menaces qui pèsent sur la liberté académique.

De nombreuses menaces

Ces menaces sont multiples. On peut schématiquement en identifier quatre :

les menaces politiques provenant de gouvernements et de mouvements politiques déterminés à contrôler idéologiquement la production et la diffusion des connaissances ;

celles que font peser sur la science la logique économique de marché

– rentabilité, compétitivité, privatisation de la recherche, avec comme conséquences, entre autres, la précarisation grandissante des chercheurs et le découplage de l’excellence scientifique et de la liberté académique ;l’emprise des technologies du numérique et leur l’impact sur la propriété intellectuelle, l’autonomie pédagogique, l’esprit critique ou la créativité (fake news, IA mobilisée à des fins de propagande, intrusion des réseaux sociaux dans les débats académiques, etc.) ;

la propagation d’un « sciento-populisme » au sein d’une opinion publique de plus en plus polarisée et critique à l’égard des élites (intellectuelles, judiciaires, journalistiques, etc.).

Ces menaces se conjuguent le plus souvent : la censure politique d’un Trump s’exerce par la pression économique, la Tech numérique délégitime la science auprès des internautes, les impératifs financiers justifient la mise au ban des savoirs critiques. Aucun domaine de recherche n’est épargné : les sciences humaines et sociales sont attaquées en raison de leur prétendue dangerosité idéologique ou de leur inutilité économique présumée mais les STEM (sciences, technologie, ingénierie, mathématiques) sont aussi menacées d’être instrumentalisées comme simples vecteurs de puissance géopolitique, comme c’est déjà le cas en Russie ou en Chine.

La recherche en plein « warscape »

La recherche scientifique évolue dorénavant dans un « warscape », c’est-à-dire un espace traversé par la violence politique, sociale et économique, et où les rapports de pouvoir et de savoir sont complètement reconfigurés. Trois modalités de ces rapports se dégagent :

la guerre contre la science menée par ceux qui veulent la destruction de l’autonomie des universités et de la libre recherche (en même temps que celle de la démocratie) ;

la guerre dans la science, du fait des fractures au sein de la communauté universitaire elle-même autour de questions controversées telles que le colonialisme, le conflit israélo-palestinien, le transgenrisme, etc. ;

la science face à la guerre, qui soulève la question des collaborations « à risques », notamment avec l’industrie de l’armement ou avec des partenaires internationaux potentiellement impliqués dans des violations du droit humanitaire – question très polarisante, comme l’a montré à l’ULiège la polémique autour de la chaire Thalès.

Une culture citoyenne

C’est dans cette perspective que la liberté académique, j’en suis convaincu, doit être défendue et protégée, non par corporatisme, mais parce qu’elle est la condition de tout développement scientifique comme de tout État de droit et de toute démocratie.

Telle est aussi la conclusion du remarquable rapport publié récemment par Sophie Balme pour France Universités, qui propose une “stratégie globale” de renforcement de la liberté académique en 65 propositions. Comment créer une véritable culture professionnelle, politique et surtout citoyenne autour de la liberté de recherche et d’enseignement ? Une culture citoyenne surtout, car l’une des raisons pour lesquelles Trump peut attaquer si brutalement les universités est l’hostilité d’une grande partie de l’opinion publique américaine à l’égard d’un monde universitaire jugé arrogant, coupé des réalités et entretenant un système de reproduction sociale financièrement inaccessible au plus grand nombre. Nous devons éviter de nous retrouver dans cette situation.

La première des 65 propositions de Sophie Balme est d’inscrire la liberté académique dans la Constitution française. Pourquoi pas aussi en Belgique, qui suivrait ainsi l’exemple de l’Italie ou de l’Allemagne (dont on sait quelles tragédies historiques ont été à l’origine de leurs constitutions d’après-guerre) ? Ouvrons le débat.

Ouvrir un débat démocratique

Certains constitutionnalistes objecteront que si la liberté académique ne figure pas formellement dans le texte constitutionnel, elle est néanmoins explicitement reconnue par la jurisprudence de la Cour constitutionnelle et de la Cour européenne des droits de l’Homme, et qu’elle est en outre consacrée par la Charte des droits fondamentaux de l’Union européenne, un texte qui est au sommet de la pyramide normative et d’application directe dans notre droit national. D’un point de vue juridique, ma proposition serait comme un coup d’épée dans l’eau. On répondra toutefois que presque toutes les libertés fondamentales sont dupliquées aux deux niveaux normatifs, européen et national, ce qui renforce leur effectivité juridique et leur portée symbolique.

Mais surtout, le processus politique de révision de la Constitution qu’il faudra parcourir serait l’occasion d’une large mobilisation du monde académique et, espérons-le, de la société civile, et d’un débat démocratique autour de la liberté de recherche et d’enseignement. Ce débat obligerait les partis politiques à se positionner et à en tirer les conséquences sur les plans programmatique et législatif. Et il représenterait une belle opportunité de solidarité et d’échange entre acteurs et actrices de la recherche au nord et au sud du pays.

Une liberté spécifique et complexe

Ce débat serait surtout l’occasion de s’interroger sur la spécificité et la complexité de la liberté académique. Spécificité par rapport à la liberté d’expression, dont jouit tout citoyen et qui l’autorise à dire ce qu’il veut (hors des atteintes à la loi), y compris des choses idiotes et insignifiantes – ce dont un grand nombre ne se prive pas. Tandis que la liberté académique est un outil au service d’une finalité qui dépasse son bénéficiaire : la recherche de la vérité sans contraintes (une belle définition du philosophe Paul Ricœur sa « Préface » à Conceptions de l’université de J. Drèze et J. Debelle. Une finalité qui nous impose des devoirs (à commencer par celui de nous soumettre au jugement de nos pairs).

Complexité ensuite de la liberté académique, qui est multidimensionnelle, comme en témoignent les cinq critères utilisés par l’Academic Freedom Index : la liberté de recherche et d’enseignement, la liberté de collaborer, d’échanger et de diffuser les données et les connaissances, l’autonomie institutionnelle des universités, l’intégrité du campus à l’égard des forces de l’ordre mais aussi des groupes militants violents et enfin la liberté d’expression académique et culturelle, y compris sur des questions politiques ou sociétales.

De vrais enjeux se posent quant aux limites de chacune de ces libertés, et aux tensions qui peuvent exister entre elles, en particulier entre la liberté académique individuelle et l’autonomie des universités. Car pour garantir celle-là, celles-ci ne doivent-elles pas s’astreindre à une certaine « réserve institutionnelle » (un terme plus approprié que « neutralité ») sur les questions politiques ? Je le crois ; mais cette « réserve » est-elle encore de mise face à des violations caractérisées du droit international et du droit humanitaire ? C’est toute la complexité du débat autour des collaborations avec les universités israéliennes…

Résistance, nuance, responsabilité

Comment faire de nos universités des espaces à la fois ouverts sur le monde et préservés de la violence qu’il engendre ? Des espaces de résistance à l’obscurantisme abyssal qui gangrène nos sociétés, de nuance contre les simplismes idéologiques, de responsabilité à l’égard des immenses défis environnementaux, sociaux, géopolitiques dont dépend l’avenir de l’humanité ? Ce qui arrive aujourd’hui au monde de la recherche doit faire réfléchir chacun d’entre nous sur son ethos académique, sur le mode de subjectivation qu’implique un exercice sans réserve mais responsable de la liberté académique. Mais cette réflexion doit aussi être collective, autour d’un objectif mobilisateur. C’est ce que je propose.

La liberté académique dans la Constitution, ce n’est donc pas figer dans le marbre une vérité révélée, mais au contraire ouvrir le débat sur une liberté essentielle mais menacée, qui regarde tant les acteurs de la recherche que les citoyens qui en sont les destinataires finaux. Ce n’est pas non plus cantonner le débat au niveau belge, mais créer l’opportunité d’un mouvement à l’échelon européen, afin que la recherche y préserve son autonomie à l’heure où, en Chine et aux États-Unis (et ailleurs), elle est désormais sous contrôle politique. Sophie Balme propose ici aussi des pistes d’action pour l’Union européenne, en termes d’investissements mais aussi d’outils concrets de mesure et de promotion de la liberté académique. Et bien sûr, nous devons continuer à manifester notre solidarité envers les chercheurs inquiétés ou opprimés partout dans le monde.

Pour atteindre ces objectifs, je suggère une double stratégie, par « en haut » et par « en bas ». D’un côté, un engagement des rectrices et des recteurs du nord et du sud (via le CREF – Conseil des rectrices et recteurs francophones – et le VLIR – Vlaamse interuniversitaire raad), en nouant aussi des alliances par-delà les frontières. L’ULiège pourrait être le moteur d’un tel engagement, par la voix de la rectrice Anne-Sophie Nyssen. De l’autre côté, une mobilisation de nous tous, acteurs et actrices de la recherche, envers le monde politique et la société civile – une mobilisation qui prendrait la forme de pétitions, de colloques, de forums, mais aussi de production de savoirs qui manquent cruellement dans le domaine francophone (Notons malgré tout l’Observatoire des atteintes à la liberté académique).

En tous cas, il est grand temps d’agir si nous ne voulons pas plier demain, à notre tour, devant les apprentis Trump qui pullulent autour de nous.

Édouard Delruelle a reçu des financements du FNRS (Belgique) et de l'Université de Liège

22.01.2026 à 15:55

L’aide au développement sert aussi à sécuriser les chaînes d’approvisionnement des pays riches

Basak Bayramoglu, Directrice de recherche, Inrae

Jean-François Jacques, Professeur des Universités, Université Gustave Eiffel

Julie Lochard, Professeure des Universités en Économie, Université Paris-Est Créteil Val de Marne (UPEC)

Texte intégral (1554 mots)

En théorie, le montant de l’aide au développement versé à tel ou tel pays ne devrait pas dépendre de sa contribution aux chaînes de valeur mondiales. Dans les faits, pourtant, on observe que les pays donateurs ont tendance à privilégier, quand ils aident financièrement des pays pauvres, ceux qui sont utiles à leur propre production…

Pourquoi certains pays reçoivent-ils davantage d’aide au développement que d’autres alors que leurs besoins sont comparables ? Les chercheurs s’interrogent sur cette question depuis des décennies. Nous savons déjà que les motivations des donateurs ne sont pas uniquement altruistes : elles incluent des considérations diplomatiques ou commerciales par exemple.

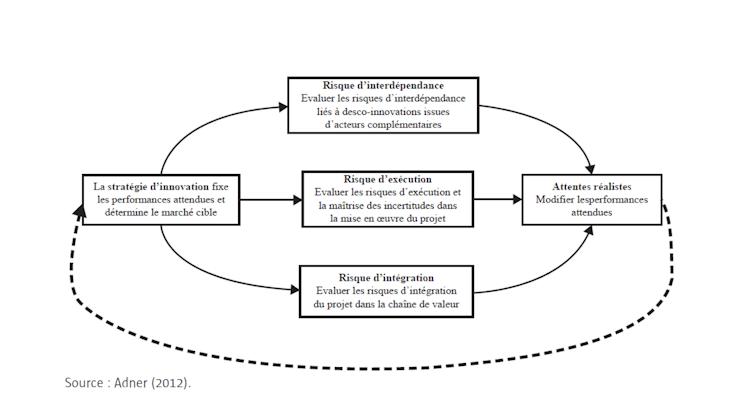

Dans un article récent, nous montrons que les chaînes de valeur mondiales — ces réseaux internationaux où les biens sont produits en plusieurs étapes dans différents pays — créent de nouvelles interdépendances entre pays et influencent l’allocation de l’aide.

Aide au développement bien ordonnée…

Depuis les années 1990, la production mondiale s’est largement fragmentée : composants électroniques, pièces automobiles, produits agricoles transformés… une multitude d’étapes de production sont désormais dispersées entre plusieurs pays. Les échanges liés à cette organisation de la production mondiale en chaînes de valeur représentent environ 50 % du commerce mondial.

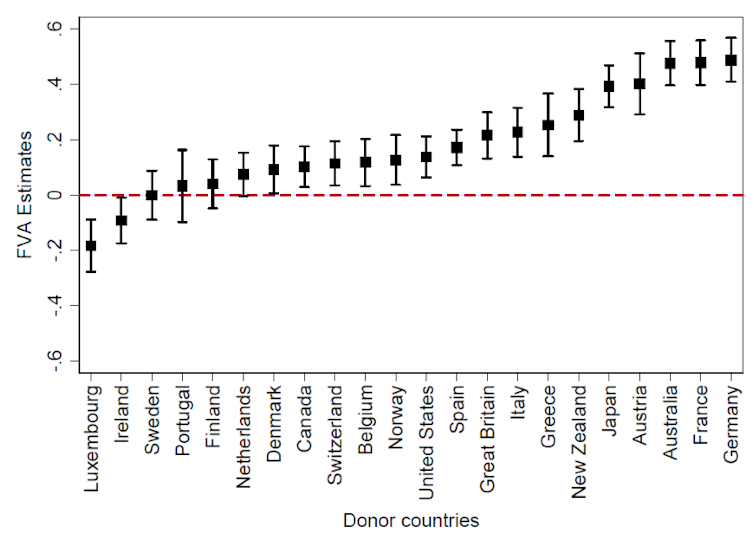

Notre analyse empirique montre que les pays donateurs accordent davantage d’aide aux pays qui fournissent des biens intermédiaires utilisés dans leur production destinée à l’exportation. Autrement dit, l’aide n’est pas uniquement destinée aux pays dont les besoins sont les plus importants : elle se dirige aussi vers ceux qui occupent des positions clés dans les chaînes de valeur mondiales.

Les exportations des pays récipiendaires de l’aide jouent un rôle particulièrement important dans les secteurs caractérisés par des biens intermédiaires différenciés, difficiles à substituer : équipements électriques et machines, transport et pièces automobiles, industrie agroalimentaire. Les pays produisant ce type de biens reçoivent davantage d’aide, toutes choses égales par ailleurs. Ce résultat complète d’autres recherches montrant que les réserves en pétrole des pays récipiendaires influencent également l’allocation de l’aide.

Le poids des entreprises des pays donateurs

Nous observons aussi une hétérogénéité importante entre pays donateurs déjà mise en avant dans d’autres travaux : les grands pays exportateurs (France, Allemagne, Japon, Royaume-Uni, États-Unis, notamment) semblent allouer l’aide de manière plus stratégique, tandis que les pays considérés traditionnellement comme plus « altruistes » (Pays-Bas, Danemark, Suède…) semblent moins sensibles au fait que le pays récipiendaire soit exportateur de biens intermédiaires spécifiques.

Pour comprendre ces résultats, nous proposons une explication théorique.

Le pays donateur, situé en aval de la chaîne de valeur, dépend d’un intrant produit dans un pays receveur, situé en amont. En transférant — sous forme d’aide — des ressources financières qui font l’objet de négociations, il incite le pays receveur à réduire ses tarifs douaniers d’importations de biens intermédiaires, ce qui diminue le coût final de son intrant produit et exporté vers le pays donateur.

L’aide agirait ainsi comme un levier discret de réduction des coûts de production pour les entreprises du pays donateur. L’influence des entreprises dans l’allocation de l’aide est également révélée ces dernières années par des enquêtes journalistiques.

Un processus qui creuse les inégalités entre pays pauvres

Ce travail montre que l’aide au développement apparaît, au moins en partie, comme un moyen permettant aux pays donateurs de garantir un accès à des biens intermédiaires stratégiques en soutenant les pays situés en amont des chaînes de production. Ce constat interroge la manière dont l’aide est allouée si l’on souhaite éviter que les pays les plus pauvres ne soient doublement exclus : des chaînes de valeur mondiales et des flux d’aide.

Nos résultats ont des implications politiques importantes.

Premièrement, le développement des chaînes de valeur mondiales peut exacerber la fragmentation de l’aide en concentrant les financements vers les pays déjà intégrés dans ces chaînes. Or, malgré plusieurs initiatives internationales comme la Déclaration de Paris sur l’efficacité de l’aide au développement adoptée par l’OCDE en 2005, cette fragmentation persiste. Une étude de la Banque mondiale montre que l’augmentation des engagements d’aide au développement en termes réels entre 2000 et 2019 s’est accompagnée d’une multiplication du nombre de donateurs et d’agences d’aide, rendant la coordination de l’allocation de l’aide plus complexe.

Deuxièmement, orienter prioritairement l’aide vers les pays liés aux chaînes de valeur mondiales peut nuire au développement des pays les moins avancés, dont l’intégration dans les réseaux de production mondiaux reste limitée. Or, l’intégration aux chaînes de valeur stimule la croissance : une étude de la Banque mondiale indique qu’une augmentation de 1 % de participation entraîne en moyenne plus de 1 % de hausse du revenu par habitant. Mais si l’aide se concentre sur les pays déjà bien intégrés, elle risque de creuser davantage l’écart entre les « gagnants » et les laissés-pour-compte de la mondialisation. Or, les déclarations récentes de l’administration américaine qui limiteraient l’aide au développement à 17 pays prioritaires choisis par les États-Unis (« excluant certains pays en proie à de graves crises humanitaires, tels que l’Afghanistan et le Yémen ») ne font que renforcer ces inquiétudes.

Basak Bayramoglu est membre de la Chaire Énergie et Prospérité, sous l'égide de La Fondation du Risque.

Jean-François Jacques et Julie Lochard ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

22.01.2026 à 12:29

En Moselle, on dépollue les sols d’une friche sidérurgique grâce aux plantes

Sonia Henry, Chercheuse, Université de Lorraine

Texte intégral (2893 mots)

La phytoremédiation est une technique de dépollution naturelle fondée sur l’utilisation de plantes pour gérer différents polluants présents dans les sols. Prometteuse, mais encore expérimentale, cette méthode est testée sous plusieurs modalités par des scientifiques à Uckange, en Moselle, sur la friche d’une ancienne usine sidérurgique.

À l’échelle de l’Europe, 62 % des sols sont aujourd’hui considérés comme dégradés, selon l’Observatoire européen des sols – EUSO. L’enjeu est de taille : les sols, que nous avons longtemps réduits à un rôle de simple support, jouent en réalité de très nombreuses fonctions pour le vivant. Celles-ci sont traduites en services écosystémiques rendus à l’humain : fourniture d’aliments, de fibres, de combustibles, pollinisation, régulation du climat ou encore la purification de l’eau, etc.

Ces biens et services, que nos sols dégradés ne fournissent plus correctement, engendrent notamment une baisse de la production agricole et de la qualité des aliments et de l’eau. Parmi les causes de cette dégradation figurent en bonne place les pollutions d’origine anthropique. Par exemple, l’utilisation de produits phytosanitaires, d’hydrocarbures (stations-service) ou encore pollutions industrielles.

Les polluants peuvent engendrer des problématiques de santé publique et tendent à se propager dans l’environnement, dans les sols, mais aussi, sous certaines conditions, vers les eaux et dans la chaîne alimentaire. Leur élimination est donc cruciale. Pour agir au niveau du sol, il existe trois grandes catégories de traitements : physiques, chimiques et biologiques. La sélection s’opère en fonction de différents paramètres, comme l’hétérogénéité et les teneurs en contaminants, l’étendue de la pollution, l’encombrement du site, les contraintes de temps, le bilan carbone de l’opération ou encore l’acceptabilité du projet par les riverains.

De plus en plus de projets de recherche explorent les traitements biologiques fondés sur la phytoremédiation : la dépollution par des plantes.

C’est notamment le cas à Uckange, en Moselle, où un ancien site sidérurgique est devenu un laboratoire à ciel ouvert permettant de tester ces méthodes, à travers une initiative portée par la Communauté d’agglomération du Val de Fensch en partenariat avec l’Université de Lorraine, l’Inrae et le Groupement d’intérêt scientifique requalification des territoires dégradés : interdisciplinarité et innovation (Gifsi).

Les vertus de la phytoremédiation

Commençons par expliquer ce que l’on entend par « phytoremédiation ».

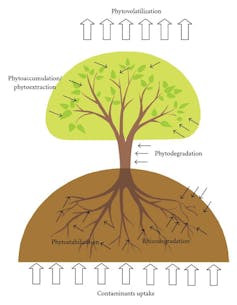

Il s’agit de sélectionner des végétaux appropriés qui vont, via leurs systèmes racinaires et parfois leurs parties aériennes, permettre de dégrader les polluants organiques (phyto et/ou rhizodégradation), d’extraire les polluants minéraux (phytoextraction), de les stabiliser dans les sols afin d’éviter une mobilité et/ou une biodisponibilité (phytostabilisation) ou même de les volatiliser pour certains d’entre eux (phytovolatilisation).

Le choix des espèces végétales va dépendre, entre autres, des caractéristiques physico-chimiques du sol (potentiel agronomique, contaminant ciblé et teneur), du climat et de leurs capacités à être maîtrisées (non envahissante). Pour ce projet, leurs potentiels de valorisation à la suite de l’action de dépollution ont également été pris en compte.

Certaines plantes sont par ailleurs particulièrement intéressantes pour leur capacité à dépolluer le sol de plusieurs éléments à la fois : le tabouret bleu (Noccaea caerulescens), par exemple, peut extraire d’importantes quantités de zinc, mais aussi de cadmium et de nickel.

Le miscanthus géant (Miscanthus x giganteus) stimule, quant à lui, la microflore du sol pour dégrader les hydrocarbures totaux ou les hydrocarbures aromatiques polycycliques.

L’association de la luzerne (Medicago sativa) à la fétuque élevée (Festuca arundinacea) permet en parallèle, grâce à la microflore du sol, l’élimination de plusieurs molécules de polychlorobiphényles

À lire aussi : La phytoremédiation : quand les plantes dépolluent les sols

La friche d’Uckange, laboratoire à ciel ouvert

Le parc U4, à Uckange, est un ancien site sidérurgique multicontaminé. Il est également classé à l’inventaire supplémentaire des monuments historiques.

Depuis quelques années, une initiative baptisée les jardins de transformation – accessible au public lors de visites guidées – a pour objectif de tester différentes modalités de phytoremédiation. Sur deux hectares de ce site qui en compte douze – les scientifiques explorent la dépollution par les plantes, en association avec des microorganismes présents dans les sols et qui participent également à ce processus de décontamination.

Quand cela était possible, une première phase d’essai en laboratoire a été menée avant l’implantation sur site. Il s’agissait d’expérimentations sous conditions contrôlées (température, humidité, luminosité avec des cycles jour-nuit). L’objectif était de sélectionner les espèces végétales potentielles candidates à un usage pour la phytoremédiation. Après la validation de cette phase en laboratoire, des essais en conditions réelles ont été mis en place.

Depuis 2022, différentes modalités de phytoremédiation sont testées au travers des jardins de transformation. Ce site, qui est contaminé à la fois en éléments traces métalliques (cuivre, zinc, nickel, chrome…) et en polluants organiques (hydrocarbures totaux, hydrocarbures aromatiques polycycliques), accueille, pour le moment, 7 modalités, toutes en co-culture.

Par exemple, des jardins-forêts ont été installés sur trois parcelles du site, représentant environ 750 m2. Une vingtaine d’espèces végétales comestibles de différentes strates (arbres, arbustes, herbacées, légumes racines, lianes) ont été installées afin de tester la capacité de ces associations végétales à dépolluer les sols. De quoi récolter des informations précieuses à l’avenir sur l’éventuel transfert des polluants du sol vers les parties comestibles de ces plantes, qui n’a pas encore été étudié.

Les espèces végétales présentes naturellement sur le site sont également suivies afin de comprendre le mode de recolonisation de ces espaces dégradés et estimer l’implication des 200 plantes identifiées dans l’amélioration de la qualité des sols et la dépollution.

À lire aussi : Peut-on rendre la forêt « nourricière » ? La proposition du jardin-forêt

Associer plantes d’extraction et de dégradation

Une autre originalité du projet est d’associer, pour la première fois, des procédés de phytoextraction et de phyto/rhizodégradation. Jusqu’à présent, seule une espèce végétale capable de traiter un contaminant était mise en place sur un sol. Ici, nous misons sur des co-cultures de végétaux. L’enjeu est d’améliorer l’efficacité de dépollution, mais aussi les fonctions du sol (qualité agronomique, biodiversité, stockage carbone).

L’innovation réside, ici, dans l’association de Miscanthus x giganteus, qui favorise la dégradation des molécules organiques, avec des espèces de la famille des Brassicaceae capables d’extraire les éléments traces métalliques.

Pour chacune des phases et pour tester l’efficience des processus en conditions réelles, des analyses sur le sol, en amont et après les cycles de cultures, sont réalisées dans le but d’évaluer :

la diminution des teneurs en contaminants,

l’amélioration de la qualité agronomique,

et l’augmentation de la biodiversité microbienne.

La biomasse végétale produite sur site est également caractérisée afin d’estimer son application dans les processus de dépollution (notamment la phytoextraction) et d’évaluer la possibilité de valorisation de cette matière première produite sur site dégradé.

Les premiers résultats seront publiés dans les prochains mois.

Bénéfices collatéraux de la phytoremédiation

Notre approche va au-delà de la remédiation des sols : la présence de ces différents organismes vivants aura d’autres effets bénéfiques.

Ces multiples espèces permettent d’améliorer la qualité des sols. En effet, cela augmente sa teneur en matière organique et fournit davantage d’éléments nutritifs, en améliorant l’efficacité du recyclage dans les cycles biogéochimiques. Cela participe aussi à la modification de la structure du sol et à la réduction de l’érosion, et in fini à l’amélioration des rendements et de la qualité des biomasses produites. On peut également noter l’augmentation de la taille des communautés microbienne et de la diversité des microorganismes.

Ceci a déjà été démontré en système agricole, l’idée est désormais de déterminer si les mêmes effets seront détectés sur des sols dégradés. Cette démarche participe également à la lutte contre le changement climatique car elle améliore le stockage du carbone par les sols, ainsi qu’à la régulation des ravageurs et à la pollinisation des cultures sur site, par l’augmentation de la biodiversité animale.

En outre, ce laboratoire à ciel ouvert permet non seulement de tester différentes modalités de phytoremédiation sans être soumis à des contraintes de temps, mais aussi d’obtenir, grâce à ses surfaces importantes, suffisamment de biomasse végétale pour vérifier la possibilité de valoriser les plantes cultivées pour d’autres usages (par exemple, paillage, compost, production d’énergie, produits biosourcés…), une fois leur action dépolluante terminée.

Sonia Henry a reçu des financements de la Communauté d'Agglomération du Val de Fensch et de l'Institut Carnot Icéel

22.01.2026 à 12:16

Comment dépolluer les friches industrielles face à la défiance des habitants ?

Cecile Bazart, Maîtresse de conférences, Université de Montpellier

Marjorie Tendero, Associate Professor in economics, ESSCA School of Management

Texte intégral (2084 mots)

Près de huit Français sur dix vivent à proximité d’une friche polluée. Malgré les opérations de dépollution, les politiques de reconversion et l’objectif zéro artificialisation nette (ZAN), plusieurs milliers de sites restent à l’abandon. Entre incertitudes techniques, coûts de dépollution cachés et mémoire collective, la confiance des habitants reste difficile à restaurer.

Vous vivez peut-être, sans le savoir, à proximité d’une friche polluée : c’est le cas de près de huit Français sur dix. Malgré les politiques de reconversion engagées ces dernières années, notamment dans le cadre de France Relance (2020-2022) et des dispositifs mis en place par l’Agence de la transition écologique (Ademe), ces friches existent toujours. Selon les données de l’inventaire national Cartofriches, plus de 9 000 friches sont encore en attente de projets de reconversion en France en 2026.

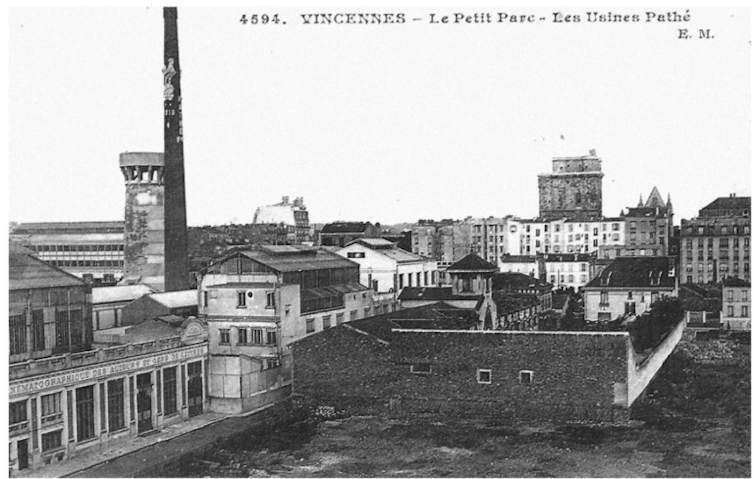

Anciennes usines, décharges, casernes militaires, zones portuaires ou ferroviaires, mais aussi hôpitaux, écoles ou équipements de services… Les friches sont, par nature, très diverses. Elles sont majoritairement héritées de notre passé industriel. Mais certaines concernent des activités de services actuelles qui ont été implantées sur d’anciens terrains industriels déjà contaminés, comme l’illustre l’ancien site Kodak à Vincennes (Val-de-Marne).

Au-delà de leur emprise physique, certaines friches ont marqué durablement les territoires et les mémoires collectives. Certains noms sont aujourd’hui associés à des pollutions persistantes, voire à des crises sociales, comme Métaleurop, Péchiney, Florange ou encore AZF.

Ces sites abandonnés, bâtis ou non, mais nécessitant des travaux avant toute réutilisation font l’objet de transformations variées : logements, jardins, bureaux, centres commerciaux ou espaces culturels, à l’instar de la friche de la Belle-de-Mai dans le 3ᵉ arrondissement de Marseille. À l’heure où la France s’est engagée vers l’objectif zéro artificialisation nette (ZAN), la reconversion des friches est un enjeu majeur pour les territoires afin de limiter l’étalement urbain et promouvoir l’attractivité des territoires.

Pourtant, malgré les opérations de dépollution, beaucoup peinent à retrouver un usage. Pourquoi ? Parce que dépolluer un sol ne suffit pas à effacer un passé ni à restaurer la confiance des habitants.

Dépolluer : une étape indispensable mais complexe

Avant d’être réaménagée, une friche polluée fait l’objet de diagnostics des sols qui débouchent le plus souvent sur l’élaboration d’un plan de gestion. Ce document définit les mesures nécessaires pour rendre le site compatible avec l’usage envisagé : excavations des terres polluées, confinement sous des dalles ou des enrobés, gestion des eaux, surveillance dans le temps, ou encore restrictions d’usage.

Son contenu dépend de l’usage futur. Transformer une friche en entrepôt logistique n’implique pas les mêmes exigences que la création d’une école. Plus l’usage est dit « sensible » et plus les exigences sanitaires sont élevées. En France, la dépollution ne vise donc pas à un retour à un sol totalement exempt de pollution. Elle repose sur un arbitrage entre pollution résiduelle, exposition potentielle et usages futurs.

À cela s’ajoute une réalité souvent sous-estimée : le coût de la dépollution est très variable et est rarement connu avec précision dès le départ.

Selon les caractéristiques du site, les polluants, leur profondeur et les usages envisagés, les coûts peuvent devenir exponentiels. En cas de découvertes fortuites (amiante caché dans des remblais ou concentrations en métaux lourds plus élevées que prévu), le plan de gestion est modifié. Autrement dit, dépolluer est souvent simple sur le papier, mais beaucoup plus incertain dans la réalité, avec potentiellement des coûts cachés.

À lire aussi : En Moselle, on dépollue les sols d’une friche sidérurgique grâce aux plantes

Le stigmate, angle mort de la reconversion

Cette incertitude technique n’est pas sans effet sur la perception des habitants, qui voient parfois ressurgir au fil des travaux les traces d’un passé que l’on pensait maîtriser. Même après des travaux conformes aux normes, de nombreuses friches peinent à attirer habitants, usagers ou investisseurs.

C’est ce que l’on appelle « l’effet de stigmate ». Un site reste associé à son passé, à des pollutions médiatisées ou à des crises sanitaires et sociales qui ont marqué les esprits.

Autrement dit le passé continue de se conjuguer au présent. Le sol est assaini, mais la mémoire collective, elle, ne l’est pas. Pour filer la métaphore, la friche devient un présent imparfait : juridiquement réhabilitée, mais symboliquement suspecte. Ce stigmate a des effets concrets : inoccupations ou sous-utilisations prolongées et oppositions locales, par exemple.

Pour objectiver cette défiance, nous avons mené une enquête auprès de 803 habitants vivant à proximité d’une friche polluée, répartis dans 503 communes françaises. Les résultats sont sans appel : près de 80 % des personnes interrogées se déclarent insatisfaites de la manière dont sont gérées et reconverties les friches polluées en France.

Cette insatisfaction est plus forte parmi les personnes percevant les sols comme fortement contaminés ayant déjà été confrontées à des situations de pollution ou exprimant une faible confiance dans les actions de l’État. Elles se déclarent également plus réticentes à utiliser ou à investir les sites une fois réhabilités.

À lire aussi : Comment redonner une nouvelle vie aux friches industrielles en ville ?

Un décalage entre gestion technique et perceptions

Ces résultats révèlent un décalage entre la gestion technique des friches et la manière dont elles sont perçues par les habitants. Sur le plan réglementaire, un site peut être déclaré compatible avec l’usage prévu, mais sur le plan social, il peut rester perçu comme risqué.

Plusieurs mécanismes expliquent ce décalage.

Le premier tient à l’invisibilité de la pollution des sols. Contrairement à un bâtiment délabré, un sol dépollué ne se voit pas, ce qui peut alimenter le doute.

La mémoire collective joue également un rôle central. Les friches polluées sont souvent associées à un passé industriel lourd, parfois marqué par des scandales sanitaires ou des crises sociales qui laissent des traces durables dans les représentations.

Enfin, le manque d’information peut renforcer la suspicion. Les notions de pollution résiduelle ou de plan de gestion peuvent en effet être difficiles à appréhender pour les non-spécialistes. Or, lorsqu’une pollution n’est pas totalement supprimée, le message peut être mal compris et perçu comme un danger dissimulé.

Ainsi, même si les solutions techniques sont solides, le stigmate persiste. Pourtant, sans confiance des populations, point de reconversion durable.

Ces résultats soulignent un point essentiel : la reconversion des friches polluées ne repose pas uniquement sur la qualité des travaux de dépollution. Elle dépend tout autant de la capacité à instaurer un climat de confiance. Cela suppose une information claire, transparente et accessible, expliquant non seulement ce qui a été fait, mais aussi ce qui reste en place et pourquoi. Cela implique d’associer les riverains aux projets, en amont, afin qu’ils ne découvrent pas les transformations une fois les décisions prises. Enfin, cela nécessite de reconnaître le poids du passé et de la mémoire locale, plutôt que de chercher à l’effacer.

Dans un contexte de zéro artificialisation nette (ZAN), les friches polluées constituent une opportunité foncière. Mais sans prise en compte des dimensions sociales et symboliques, les solutions techniques, aussi performantes soient-elles, risquent fort de rester insuffisantes. Dépolluer les sols est indispensable. Instaurer ou restaurer la confiance des habitants l’est tout autant.

À lire aussi : Sur les terrils miniers du Nord-Pas-de-Calais, la naissance d’une niche écologique inédite

L'enquête détaillée dans l'article a été financée par l'Université de Montpellier.

Marjorie Tendero a reçu un co-financement de sa thèse en sciences économiques par l'ADEME et la Région Pays de la Loire (2014-2017).

22.01.2026 à 11:09

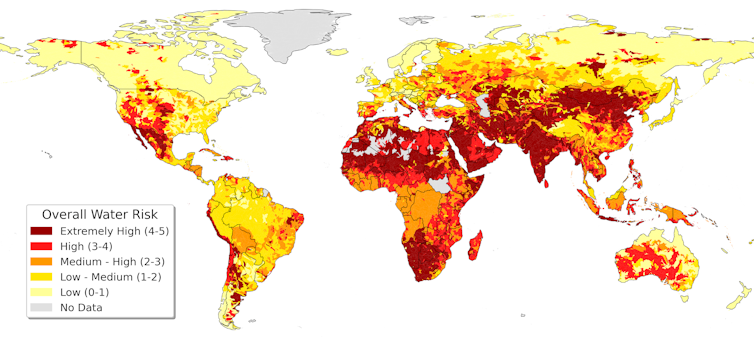

L’eau invisible des chaînes de valeur mondialisées

Simon Porcher, Professeur, Université Paris Dauphine – PSL

Texte intégral (1725 mots)

C’est le maillon caché de la mondialisation : quand on échange des biens et des services, on transfère aussi de l’eau douce d’un pays à l’autre. Pourtant, la gestion de l’eau reste locale, quand sa consommation est devenue mondiale. Des solutions émergent.

L’eau douce, pourtant indispensable à toute activité humaine, reste souvent absente des débats sur la mondialisation, comme si sa disponibilité allait de soi. Pourtant, sans eau, il n’y a ni alimentation, ni industrie, ni énergie, ni numérique. Nos vies, même dématérialisées, reposent sur l’utilisation de l’eau, qui refroidit, nettoie, chauffe. L’eau est l’intrant invisible de notre économie. Un chiffre résume son importance : 88 % de l’eau prélevée dans le monde sert à produire des biens ou des services.

L’eau circule déjà d’un continent à l’autre, non pas dans des canalisations, mais à travers les chaînes de valeur mondialisées, dans les produits alimentaires ou les habits que nous consommons et dans toutes nos infrastructures. Cette « eau virtuelle » irrigue la mondialisation, mais reste largement ignorée des décisions économiques et politiques. Résultat : l’eau est mobilisée comme si elle était une ressource infinie, au service d’une économie qui privilégie la performance immédiate au détriment des écosystèmes et des populations.

Les flux d’eau cachés dans notre assiette

Le concept d’eau virtuelle, inventé au début des années 1990 par le géographe Tony Allan, permet de mesurer l’eau incorporée dans les produits que nous consommons. Par exemple, il faut 15 000 litres d’eau pour produire un kilogramme de bœuf, 4 000 litres pour un kilogramme de pistaches et 1 000 itres pour un kilogramme de maïs.

Chaque petit déjeuner devient un voyage autour du monde : le café du matin vient de Colombie ou du Brésil, arrosé par les pluies tropicales ; le carré de chocolat noir qui l’accompagne est fabriqué à partir de cacao équatorien ; l’avocat du Pérou vient d’un champ irrigué. Seuls le blé et le sel de la baguette de pain, et la poule qui a pondu l’œuf viennent de France. Nos choix alimentaires connectent les bassins d’eau du monde entier, souvent à notre insu.

À lire aussi : L’eau, la grande oubliée du label bio ?

Afin de mesurer le volume ainsi utilisé indirectement, Arjen Hoekstra a élaboré en 2002 le concept d’« empreinte eau ». Celle-ci correspond au volume total d’eau utilisé pour produire les biens et les services que nous consommons. Elle peut être calculée pour un pays ou pour un consommateur. Par exemple, l’empreinte eau d’un Français est supérieure à 4 000 litres par jour et 90 % de cette quantité proviennent de son alimentation.

L’eau dans les chaînes de valeur mondialisées

Cette approche par l’assiette, et plus généralement par le produit final, révèle les transferts massifs d’eau entre pays, souvent invisibles dans les échanges commerciaux.

L’industrie textile illustre parfaitement cette réalité. De la culture du coton à la teinture et au lavage, chaque vêtement consomme des milliers de litres d’eau. Les fleuves Amou-Daria et Syr-Daria, qui prennent leur source au Tadjikistan et au Kirghizistan, ont été détournés par les pays en aval pour irriguer du coton. Cette irrigation massive a réduit leur flux au point d’assécher la mer d’Aral (Asie centrale). Là-bas, la baisse de la quantité d’eau entraîne des problèmes sanitaires et de dégradation des conditions d’existence. Les procédés industriels génèrent des rejets polluants, mal traités, contaminant rivières, sols et nappes. Les pays producteurs de textile paient le prix écologique de nos vêtements à bas coût.

Cet exemple illustre un problème plus large. La mondialisation des flux d’eau virtuelle révèle un vide institutionnel majeur. L’économie est globale, mais la gestion de l’eau reste locale. Cette disjonction favorise le dumping hydrique et environnemental. Les règles du commerce mondial invisibilisent les impacts réels sur les populations et les écosystèmes. Les chaînes de production éclatées permettent aux entreprises de profiter des ressources des pays fragiles, sans compensations ni reconnaissance des impacts sociaux et écologiques.

Des inégalités accentuées

L’exploitation intensive de l’eau n’est pas seulement un problème environnemental ; c’est un enjeu social et politique. Les populations des pays producteurs subissent la raréfaction de l’eau, la pollution des nappes et les risques sanitaires. Les inégalités s’accentuent : ce sont les plus vulnérables qui supportent les coûts, et les plus riches qui récoltent les bénéfices.

Au-delà de l’opposition entre le Nord et le Sud, c’est la domination des logiques de marché qui pose problème. Les multinationales choisissent leurs sites de production selon le coût de l’eau et la faiblesse des normes, renforçant un modèle où la ressource devient une variable d’ajustement économique plutôt qu’un bien commun. Les États, souvent dépassés, adoptent ces normes pour rester compétitifs, laissant peu de place à des alternatives locales ou écologiques.

Vers une reconnaissance de l’eau comme une ressource commune globale

La gouvernance de l’eau demeure aujourd’hui largement fragmentée à l’échelle mondiale. Contrairement au changement climatique, qui bénéficie d’un cadre multilatéral de référence malgré ses limites, l’eau n’est pas reconnue comme une ressource commune globale dotée de règles et de normes contraignantes pour les acteurs économiques.

Cette situation limite la capacité de régulation des usages et des impacts. En l’absence d’un étiquetage systématique de l’empreinte eau des produits, la consommation d’eau liée aux biens et aux services échangés reste en grande partie invisibles. Alors même que l’empreinte eau d’un produit peut varier fortement selon les systèmes de production et les intrants mobilisés, cette invisibilité contribue à une faible responsabilisation de l’ensemble des acteurs. Dans un contexte de dépassement des limites planétaires relatives à l’eau, la disponibilité et la transparence des informations relatives à l’empreinte eau des produits et des services constituent un enjeu central de gouvernance.

Par ailleurs, les usages de l’eau reflètent de fortes inégalités géographiques : les pays industrialisés concentrent une part importante des consommations d’eau indirectes à travers les importations de produits agricoles et industriels, tandis que les pressions hydriques se manifestent principalement dans les pays producteurs. Dans ce contexte, les politiques commerciales et de coopération internationale sont des leviers potentiels de régulation indirecte des impacts hydriques. La jurisprudence de l’Organisation mondiale du commerce (OMC) a reconnu la possibilité pour un État de restreindre l’accès à son marché sur la base de procédés et de méthodes de production. Demain peut-être prendra-t-on en compte les impacts environnementaux localisés, tels que le stress hydrique, dans la régulation des échanges internationaux.

Internaliser la contrainte ?

Du côté des entreprises, la prise en compte des risques hydriques progresse mais demeure hétérogène. Elle repose largement sur des démarches volontaires, souvent intégrées à des stratégies de responsabilité sociale sans caractère contraignant. Mais certaines multinationales commencent toutefois à internaliser ces enjeux.

Michelin a par exemple mis en place un prix fictif de l’eau en interne pour orienter ses usines à investir dans des systèmes d’économie et de réutilisation de l’eau. À Gravanches et à Troyes, l’amélioration des processus de refroidissement devrait diminuer les prélèvements de plus de 60 %.

Néanmoins, ces initiatives restent principalement concentrées sur les sites de production directe, alors que l’essentiel des consommations d’eau associées aux produits se situe en amont, le long des chaînes de valeur, où se concentre également une part importante des risques hydriques. L’analyse de l’empreinte eau sur l’ensemble des chaînes d’approvisionnement apparaît dès lors comme un outil central pour identifier et gérer les risques hydriques liés à leurs investissements.

L’eau n’est pas seulement un enjeu environnemental, c’est un facteur structurant de la production économique, du commerce international et de la souveraineté. Le décalage entre la nature localisée des ressources hydriques et l’organisation mondialisée des chaînes de valeur constitue l’un des défis majeurs de la gouvernance contemporaine de l’eau.

Cet article fait partie du dossier « La gestion à l’épreuve du réel » réalisé par Dauphine Éclairages, le média scientifique en ligne de l’Université Paris Dauphine – PSL.

Simon Porcher co-dirige l’Institut d'économie de l’eau, soutenu par des mécènes. Ceux-ci n’ont joué aucun rôle dans le choix de l’angle, la rédaction ou les conclusions ; cette tribune n’engage que son auteur.

21.01.2026 à 16:44

Transition énergétique : développer les bioénergies, oui mais avec quelles biomasses ?

Fabrice Beline, Directeur de Recherche, Inrae

Texte intégral (2248 mots)

En matière de transition énergétique, les débats sur la production et la consommation électrique tendent à occuper le devant de la scène politico-médiatique et à occulter le rôle des bioénergies. Ces dernières font pourtant partie intégrante de la programmation énergétique du pays. Leur production peut avoir des impacts majeurs tant sur les modes de production agricole que sur nos habitudes alimentaires.

Dans les prospectives énergétiques telles que la stratégie nationale bas carbone (SNBC), les scénarios négaWatt ou encore ceux de l’Agence de la transition écologique Ademe… les bioénergies sont régulièrement présentées comme un levier incontournable de la transition, en complément de l’électrification du système énergétique.

Pour rappel, ces énergies, qui peuvent être de différentes natures (chaleur, électricité, carburant…), se distinguent des autres par leur provenance. Elles sont issues de gisements de biomasses tels que le bois, les végétaux et résidus associés, les déchets et les effluents organiques.

L’électrification met en scène de nombreuses controverses politiques et sociétales dans le débat public et médiatique. Par exemple : compétition entre renouvelable et nucléaire, arrêt des moteurs thermiques… À l’inverse, les discussions sur les bioénergies se cantonnent encore aux milieux scientifiques et académiques.

Pourtant, leur déploiement implique des évolutions importantes. Et ceci à la fois dans les modes de production agricole et les habitudes alimentaires, en tout cas si nous le voulons durable.

Il est donc essentiel que le sujet bénéficie d’une meilleure visibilité et d’une plus grande appropriation par la société pour que puissent naître des politiques publiques cohérentes.

Les bioénergies, levier de la transition énergétique

La transition énergétique, qui consiste à réduire drastiquement le recours aux énergies fossiles, est centrale dans la lutte contre le changement climatique. À l’horizon 2050, elle s’appuie sur deux piliers :

d’une part l’augmentation de la production d’électricité « bas carbone », associée à une forte électrification des usages, notamment pour la mobilité.

de l’autre, une hausse conséquente de la production de bioénergies pour compléter l’offre électrique, en particulier pour les usages difficilement « électrifiables » (par exemple dans l’industrie).

Actuellement, au niveau national, les bioénergies représentent de 150 à 170 térawattheures (TWh) par an, soit un peu plus de 10 % de l’énergie finale consommée. Ce chiffre concerne principalement la filière bois, à laquelle s’ajoutent les biocarburants et la filière biogaz. À l’horizon 2050, les prospectives énergétiques prévoient une consommation de plus de 300 de bioénergies, avec une forte croissance dans les secteurs du biométhane (injection du biogaz dans le réseau de gaz après épuration du biométhane) et, dans une moindre mesure, des biocarburants.

La programmation pluriannuelle de l’énergie n°3 (PPE3), qui est en cours de consultation, constitue la feuille de route de la France pour sa transition énergétique, avec des objectifs chiffrés. Pour la filière biométhane, la cible est fixée à 44 TWh/an dès l’horizon 2030 puis jusqu’à 80 TWh/an en 2035, contre une production actuelle de l’ordre de 12 TWh/an. Concernant les biocarburants, la PPE3 prévoit une légère augmentation pour atteindre 50 TWh/an en 2030-2035.

À lire aussi : Avenir énergétique de la France : le texte du gouvernement est-il à la hauteur des enjeux ?

La nécessité d’une biomasse « durable »

L’optimisme quant à nos capacités à cultiver de manière durable les biomasses nécessaires à la production de ces bioénergies n’est cependant plus de mise.

Alors que la deuxième Stratégie nationale bas carbone (SNBC) tablait sur une production de 370 TWh/an de bioénergies en 2050, la nouvelle version SNBC 3 revoit ce chiffre à la baisse à 305 TWh/an. En mai 2025, le rapport des académies d’agriculture et des technologies réduisait ce chiffre à 250 TWh/an.

L’évolution à la baisse de ces chiffres met en lumière l’inadéquation entre les besoins de biomasse pour la transition énergétique, telle qu’elle est actuellement envisagée, et les capacités de production du système agricole actuel.

En novembre 2023, le Secrétariat général à la planification écologique lançait l’alerte, à travers cette formule relayée par le Monde :

« Il y a un problème de bouclage sur la biomasse. »

Ces questionnements ont donné lieu à des échanges entre le ministère de l’agriculture et de la souveraineté alimentaire et l’Inrae autour des enjeux agronomiques, techniques et économiques d’une mobilisation accrue des différents gisements de biomasse et de leur transformation en bioénergies. Ils ont confirmé les difficultés de faire correspondre les besoins pour la transition énergétique et la capacité de production.

Les flux de biomasse en France

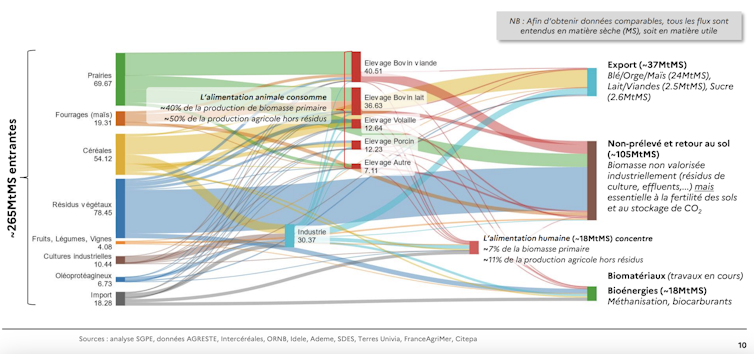

Pour y voir plus clair sur les enjeux et les leviers disponibles, il convient d’analyser plus globalement les flux de biomasses agricoles à l’échelle nationale.

Environ 245 millions de tonnes de matière sèche (MtMS) sont produits chaque année pour des usages primaires (directs) et secondaires (indirects). Ces usages se répartissent comme suit :

Environ 100-110 MtMS sont mobilisés pour l’alimentation animale et finalement la production de denrées alimentaires telles que le lait, la viande, les œufs.

Quelque 70-80 MtMS/an retournent directement au sol (résidus de cultures, fourrages et prairies), auxquels s’ajoutent environ 30 MtMS/an de flux secondaires principalement issus de l’élevage sous forme d’effluents (lisier, fumier, digestat…).

Environ 50-55 MtMS/an sont utilisés directement pour la production de denrées alimentaires humaines (dont plus de la moitié est exportée).

Et 9 MtMS/an servent à la production d’énergie (biocarburant et biogaz) auxquels s’agrègent environ 9MtMS/an de flux secondaires provenant de l’élevage et de l’industrie agroalimentaire (lisier, fumier, biodéchets…).

À échéance 2050, les besoins supplémentaires en biomasses pour les bioénergies s’établissent entre 30 et 60 MtMS/an.

Les dilemmes pour répondre à ces besoins accrus

Tous les acteurs s’accordent sur le fait qu’il n’est pas concevable de rediriger des ressources utilisables – et actuellement utilisées pour l’alimentation humaine – vers des usages énergétiques.

Il apparaît dès lors tentant de rediriger la biomasse qui retourne actuellement au sol. Pourtant, ces flux de biomasse sont essentiels à la santé, qualité et à la fertilité des sols. Ils participent à la lutte contre le changement climatique à travers leur contribution au stockage (ou à la limitation du déstockage) de carbone dans les sols.

Une autre piste, pour répondre à ces besoins croissants, serait d’augmenter la production primaire de biomasse à travers le développement et la récolte de cultures intermédiaires appelées « cultures intermédiaires à vocation énergétique » (CIVE). Celles-ci sont cultivées entre deux cultures principales.

Toutefois, une telle production supplémentaire de biomasse implique l’utilisation de ressources supplémentaires (nutriments, eau, produits phytosanitaires). Elle tend aussi à accroître les risques de transferts de pollution vers la biosphère.

Mobiliser trop fortement ces leviers pourrait donc s’avérer contreproductif. Les alertes s’accumulent à ce sujet. Ces leviers sont donc à actionner avec parcimonie.

Une autre piste, conceptualisée dans plusieurs scénarios de transition, serait de rediriger une partie de la biomasse actuellement utilisée pour nourrir les animaux d’élevage vers la production énergétique.

Ceci impliquerait à la fois une diminution des cheptels et une extensification des élevages afin de préserver leurs services écosystémiques rendus, tout en minimisant leur consommation de biomasse. Cela répondrait à l’enjeu de réduction des émissions de gaz à effet de serre de l’agriculture et serait donc le plus cohérent pour affronter les enjeux écologiques.

Ce scénario requiert toutefois des changements d’envergure dans nos habitudes alimentaires, avec une réduction de notre consommation de produits animaux pour éviter une augmentation des importations.

Vers des politiques publiques coordonnées et cohérentes ?

Après deux ans de retard et de blocages dans les ministères, la stratégie nationale pour l’alimentation, la nutrition et le climat ne semble malheureusement pas à la hauteur de cette problématique. En témoigne l’absence d’objectif chiffré sur la réduction de la consommation de produits animaux, voire la disparition du terme de réduction dans les dernières versions.

De même, les lois récentes d’orientation agricole et Duplomb renforcent l’orientation productiviste de l’agriculture, tout en minimisant les enjeux de transition. Ceci va à l’encontre (au moins partiellement) des orientations nécessaires pour la transition énergétique et la SNBC 3, sans parler des antagonismes avec la stratégie nationale biodiversité.

La France ne manque donc pas de stratégies, mais d’une cohérence globale entre elles. C’est bien cela qui conduit à un découragement des responsables de l’élaboration et la mise en œuvre des politiques publiques et à une adhésion insuffisante des citoyens à ces stratégies.

Il y a donc urgence à développer une vision et des politiques publiques intersectorielles cohérentes et complémentaires englobant l’énergie, l’agriculture, l’environnement, l’alimentation et la santé.

Fabrice Beline a reçu des financements de l’Ademe (projet ABMC) et de GRDF (projet MethaEau).

21.01.2026 à 16:23

Derrière le sans-abrisme, la face cachée du mal-logement

Pascale Dietrich, Chargée de recherche, Ined (Institut national d'études démographiques)

Marie Loison-Leruste, Maîtresse de conférences en sociologie, Université Sorbonne Paris Nord

Texte intégral (2132 mots)

Ce 22 janvier, une Nuit de la solidarité est organisée à Paris et dans d’autres villes françaises – une forme d’opération citoyenne de décompte des personnes dormant dans la rue. Celle-ci ne doit pas occulter ce que les travaux de recherche montrent depuis une quarantaine d’années : à la figure bien connue du sans-abri s’ajoutent d’autres formes moins visibles de précarité résidentielle et de mal-logement.

Aujourd’hui, de plus en plus de personnes sont exclues du logement ordinaire. Les derniers chiffres dont on dispose datent de 2012 et indiquent que le nombre de personnes sans domicile a augmenté de 50 % entre 2001 et 2012 : à cette date, 81 000 adultes, accompagnés de 31 000 enfants étaient sans domicile dans les agglomérations d’au moins 20 000 habitants de France hexagonale. L’enquête Sans Domicile menée par l’Insee en 2025 est en cours d’exploitation et permettra d’actualiser ces chiffres, mais tout laisse penser que la situation s’est encore dégradée, comme en témoignent nos observations de terrain.

D’après l’Insee, une personne est considérée comme sans domicile si elle a dormi la nuit précédente dans un lieu non prévu pour l’habitation (elle est alors « sans-abri »), ou si elle est prise en charge par un organisme fournissant « un hébergement gratuit ou à faible participation » (hôtel ou logement payé par une association, chambre ou dortoir dans un hébergement collectif, etc.). Ainsi, le sans-abrisme est-il la forme extrême du sans-domicilisme qui s’inscrit lui-même dans la myriade des formes du mal-logement.

Au-delà de ces personnes sans domicile, d’autres vivent dans des caravanes installées dans des campings, dans des squats, chez des tiers, des camions aménagés, des logements insalubres, etc., autant de situations résidentielles précaires qui échappent aux radars de la société et sont peu relayées dans les médias.

Ainsi, la Fondation pour le logement des défavorisés estime dans son rapport de 2025 que près de 4 millions de personnes sont touchées en France par toutes ces formes de mal-logement, la plupart des indicateurs de mal-logement s’étant dégradés.

À la figure bien connue du sans-abri dormant dans la rue s’ajoutent donc d’autres formes moins repérables de précarité résidentielle.

À l’approche de la Nuit de la solidarité organisée chaque année à Paris et dans d’autres villes françaises, il n’est pas inutile de rappeler ce que soulignent les travaux de recherche sur le sujet depuis une quarantaine d’années : le sans-abrisme n’est que la partie émergée de l’iceberg.

Si les opérations de décompte des personnes vivant dans des lieux non prévus pour l’habitation, et notamment la rue, sont importantes pour sensibiliser les citoyennes et citoyens, elles ne permettent d’obtenir que des estimations très approximatives du sans-abrisme et masquent une problématique plus vaste qui ne se réduit pas à ces situations extrêmes, comme on peut le lire dans ce rapport (pp. 42-52).

Les visages cachés de l’exclusion du logement

À la figure ancienne et un peu caricaturale du clochard – un homme seul, blanc, sans emploi et marginalisé – s’ajoutent d’autres visages : travailleurs et travailleuses précaires, femmes, parfois accompagnées d’enfants, personnes âgées percevant de petites retraites, personnes discriminées en raison de leur orientation sexuelle, étudiantes et étudiants, jeunes sortant de l’Aide sociale à l’enfance ou encore populations issues de l’immigration…

Ces différents types de personnes ont toujours été plus ou moins présentes parmi les populations en difficulté, mais l’augmentation générale de la précarité et la pénurie de logements accessibles les ont encore fragilisées. Plus de 2,7 millions de ménages étaient en attente d’un logement social en 2024. Dans le même temps, seulement 259 000 logements ont été mis en chantier en 2024, dont 82 000 logements sociaux financés.

Si certaines figures du sans-abrisme sont extrêmement visibles, comme les migrantes et migrants dont les campements sont régulièrement montrés dans les médias, d’autres formes d’exclusion sont plus discrètes.

C’est le cas par exemple des personnes en emploi, victimes de l’élargissement de la crise du logement, qui se replient vers les structures d’hébergement institutionnel faute de pouvoir se loger malgré leurs revenus réguliers.

En 2012, près d’un quart des sans-domicile occupaient un emploi. Ce phénomène fait peu de bruit alors même que ces personnes occupent souvent des métiers essentiels au fonctionnement de la société.

De même, les femmes sans domicile sont moins repérables dans l’espace public que leurs homologues masculins, car elles ne ressemblent pas à la figure classique du sans-domicile fixe (SDF). Quand elles y sont présentes, elles ne s’y installent pas et sont beaucoup plus mobiles par crainte d’y subir des violences : elles sont donc très largement sous-estimées dans les opérations de décompte.

À lire aussi : Femmes SDF : de plus en plus nombreuses et pourtant invisibles

Les enquêtes « Sans domicile » montrent qu’entre 2001 et 2012, le nombre de femmes francophones sans domicile a augmenté de 45 %, passant de 17 150 en 2001 à 24 930 femmes en 2012.

Solutions court-termistes

Face à cette précarité résidentielle croissante, quelles solutions apportent les pouvoirs publics ?

L’augmentation du financement de l’hébergement d’urgence qui procure un abri temporaire dans des haltes de nuit ou à l’hôtel apporte certes une solution rapide aux sans-abri qui, du point de vue des édiles, nuisent à l’image des villes, mais ne résout en rien les problèmes de ces personnes.

À lire aussi : Où dormir quand on n’a pas de domicile ?

Reléguant les plus précaires aux marges des villes ou dans des hébergements sans intimité où il est impossible de s’installer dans la durée, ces politiques court-termistes, focalisées sur l’urgence sociale, se doublent de formes de répression (expulsion, arrêtés anti-mendicité, mobiliers urbains inhospitaliers) qui contribuent à la précarisation et à l’invisibilisation des populations étiquetées comme « indésirables ».

L’augmentation massive des expulsions avec le concours de la force publique en 2024, l’hébergement des sans-domicile dans des hôtels de plus en plus éloignés des centres des agglomérations et peu accessibles en transports en commun, ou le déplacement des sans-abri de Paris pendant les Jeux olympiques de 2024 en témoignent.

Prises en charge discontinues

Des changements politiques profonds sont pourtant nécessaires pour résoudre la question de l’exclusion du logement en s’attaquant à ses causes structurelles. Une politique ambitieuse de production et de promotion du logement social à bas niveaux de loyers est indispensable pour permettre aux ménages modestes de se loger sans passer par le long parcours de l’hébergement institutionnel.

La prévention des expulsions doit également être favorisée, de même que la régulation des prix du marché immobilier.