21.01.2026 à 11:36

Géo-ingénierie climatique : de quoi parle-t-on ? Pour quelle efficacité et quels nouveaux risques ?

Texte intégral (3491 mots)

La « géo-ingénierie climatique » recouvre un ensemble de techniques qui visent à manipuler le climat à grande échelle afin d’éviter les risques du changement climatique. Ces techniques sont très variées, depuis les parasols spatiaux pour limiter l’arrivée des rayons du soleil dans l’atmosphère jusqu’à la fertilisation des océans pour que le phytoplancton consomme davantage de CO₂, en passant par la restauration et la conservation de zones humides où le carbone est stocké de façon préférentielle.

En octobre 2025, l’Académie des sciences a publié un rapport qui détaille ce que l’on sait et ce que l’on ignore encore sur les éventuels bénéfices de ces techniques et sur les nouveaux risques qu’elles font surgir.

Elsa Couderc, cheffe de rubrique Sciences et Technologies, explore ici avec Laurent Bopp, climatologue et académicien, les nouveaux risques climatiques que ces techniques pourraient faire émerger. Le second volet de ces « regards croisés » est un entretien avec Manuel Bellanger, qui étudie à l’Ifremer le développement des techniques de géo-ingénierie marine avec un regard d’économiste.

The Conversation : Pourquoi l’Académie des sciences s’empare-t-elle aujourd’hui du sujet de la géo-ingénierie climatique, alors qu’on en parle relativement peu en France ?

Laurent Bopp : Le sujet est de plus en plus présent dans la littérature scientifique, dans le débat scientifique et dans le débat politique qui entoure les discussions sur le changement climatique. On ne s’en rend pas bien compte en France, mais aux États-Unis, en Angleterre, en Allemagne, au Canada, le débat est beaucoup plus présent.

Certains climatologues, y compris de renom, se prononcent pour faire beaucoup plus de recherches sur ces technologies, mais aussi parfois pour envisager leur déploiement à grande échelle afin d’éviter un réchauffement trop important. L’argument est simple : un niveau de réchauffement trop élevé génère des risques importants et pourrait conduire au dépassement de certains points de bascule potentiels dans le système climatique, par exemple une fonte irréversible des calottes glaciaires du Groenland et de l’Antarctique, ce qui pourrait entraîner une élévation du niveau de la mer de plusieurs mètres additionnels.

En France, nous avons besoin collectivement de plus d’informations et de plus de débats autour de ces techniques. Nous avons eu le sentiment que certains de nos représentants se sont retrouvés en partie dépourvus dans des arènes de négociations internationales, face à des représentants d’autres gouvernements qui ont un agenda très agressif sur ces technologies. C’est sans doute une des raisons pour lesquelles l’Académie des sciences s’est emparée du sujet.

L’idée des interventions de géo-ingénierie climatique, c’est de réduire les risques liés au changement climatique. Mais ces interventions pourraient-elles induire de nouveaux risques et lesquels ?

L. B. : Un des intérêts de ce rapport, c’est de mettre la lumière sur ces nouveaux risques.

Mais, avant de rentrer dans le détail, il faut, quand nous parlons de géo-ingénierie climatique, distinguer deux grandes catégories de techniques – ces deux catégories sont fondées sur des approches très différentes et présentent des risques, là aussi, très différents.

Pour la première de ces catégories, il s’agit de modifier de façon assez directe le rayonnement solaire. On parle en anglais de Solar Radiation Management ou SRM. Dans ce cas-là, l’action s’apparente plutôt à une sorte de pansement sur la plaie d’une blessure, sans s’attaquer du tout à la cause du changement climatique : l’idée est de refroidir la Terre de façon artificielle, en utilisant par exemple des particules atmosphériques ou des miroirs spatiaux qui limiteraient la pénétration du rayonnement solaire jusqu’à la surface de la Terre. Ce refroidissement pourrait compenser, en partie au moins, le réchauffement lié aux gaz à effet de serre qui continueraient à augmenter dans l’atmosphère.

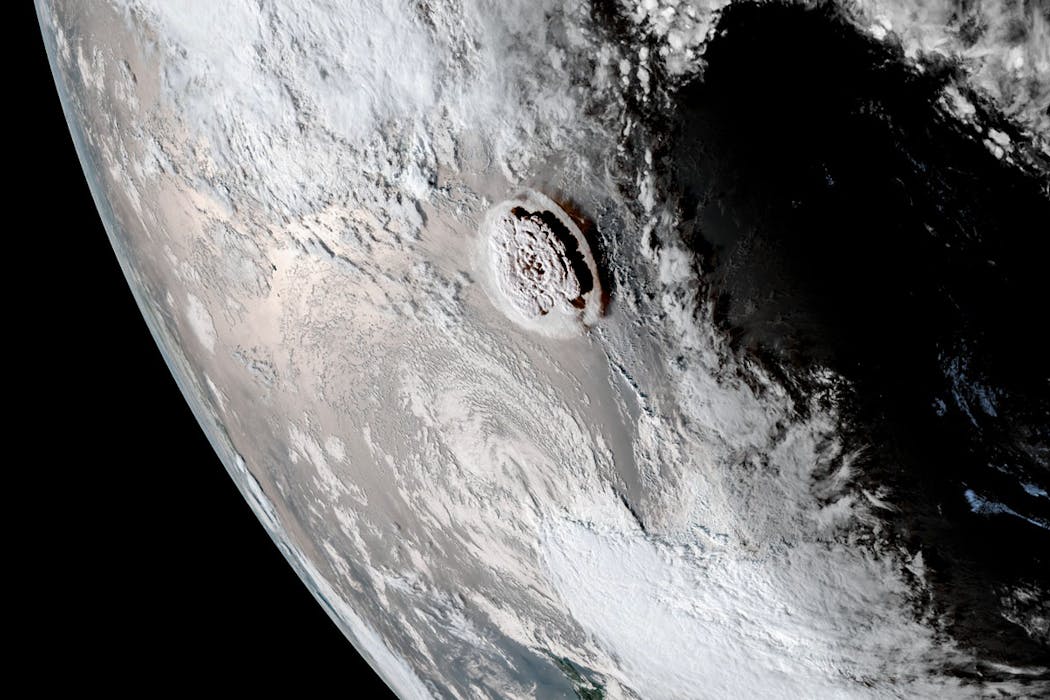

L’injection d’aérosols dans la haute atmosphère vise à imiter des éruptions volcaniques de très grande taille qui, par le passé, ont pu refroidir la Terre. Une des limites premières de cette approche, c’est que cette façon de refroidir la Terre est très différente de la façon dont elle se réchauffe aujourd’hui à cause des gaz à effet de serre : les échelles de temps et les échelles spatiales associées sont très différentes, et cela engendre un certain nombre de conséquences. Les risques sont à lire en fonction de ces deux échelles.

Les aérosols que l’on pourrait injecter dans la haute atmosphère ont une durée de vie courte. Ils vont disparaître de l’atmosphère assez rapidement, tandis que les gaz à effet de serre qui réchauffent le système Terre, le CO₂ en particulier, sont dans l’atmosphère pour très longtemps.

Cette différence majeure entraîne l’un des risques les plus préoccupants : le risque de « choc terminal ». Concrètement, si l’on décidait d’arrêter brutalement l’injection d’aérosols après s’être engagé dans ce type de stratégie

– et les raisons pourraient être multiples, qu’il s’agisse de problèmes de gouvernance, de financement ou de conflits internationaux – le réchauffement climatique jusque-là partiellement masqué réapparaîtrait d’un seul coup. On subirait alors, en très peu de temps, plusieurs années de réchauffement accumulé. On aurait des taux de réchauffement temporels très très rapides, et donc des conséquences sur la biodiversité ou sur les sociétés humaines difficiles à anticiper.

En d’autres termes, si le réchauffement arrive relativement lentement, la mise en place de mesures d’adaptation est possible ; s’il est très rapide, les conséquences sont potentiellement bien plus dévastatrices.

L’autre risque majeur est lié aux échelles spatiales : refroidir avec des aérosols par exemple, ce n’est pas du tout la même chose que ne pas refroidir en émettant moins de CO₂. Les effets régionaux du refroidissement vont être très différents de ce qu’ils auraient été si on avait réchauffé un peu moins. La localisation des précipitations, l’intensité de la mousson notamment ont des conséquences sur l’agriculture, sur la santé. Sur ces effets régionaux, il y a encore beaucoup d’incertitudes aujourd’hui, c’est quelque chose que les modèles décrivent moins bien que les effets temporels dont je parlais tout à l’heure.

À lire aussi : Parasols géants et blanchiment du ciel : de fausses bonnes idées pour le climat

Face à ce risque majeur, l’Académie recommande d’arrêter le déploiement des techniques de modification du rayonnement solaire, et même les recherches sur cette technique de géo-ingénierie…

L. B. : Effectivement, notre rapport recommande de ne pas utiliser ces techniques, et nous allons même jusqu’à suggérer un traité international qui interdirait leur déploiement.

Nous pensons aussi qu’il ne faut pas financer, de façon importante, de la recherche qui soit spécifiquement fléchée sur ces techniques de modification du rayonnement solaire, pour éviter de légitimer ces approches trop dangereuses.

Bien sûr, nous avons besoin de bien plus de recherche sur le climat et sur les processus climatiques importants, donc sur les processus qui lient, par exemple, les aérosols dans la haute atmosphère avec la modification du rayonnement, mais nous pensons vraiment qu’il faut éviter les projets fondamentalement pensés pour pousser l’avènement de ces technologies. Les risques associés sont trop importants.

La géo-ingénierie climatique inclut une deuxième approche, celle qui consiste à augmenter l’efficacité des puits de carbone naturels, par exemple les forêts, les tourbières ou les océans qui absorbent naturellement du carbone. En quoi est-ce fondamentalement différent de la modification du rayonnement solaire ?

L. B. : Il ne s’agit plus de refroidir la Terre pour compenser un réchauffement qui serait lié à l’augmentation des gaz à effet de serre, mais d’éliminer du CO₂ qui est déjà présent dans l’atmosphère. Le terme consacré est celui d’« élimination du dioxyde de carbone », ou Carbon Dioxide Removal (CDR) en anglais.

D’abord, soyons clairs : la priorité des priorités reste de réduire les émissions actuelles de façon drastique. Ces « puits de carbone » additionnels ne doivent intervenir que comme un complément, après la réduction des émissions de façon massive et immédiate.

Pour stabiliser le climat et répondre aux objectifs de l’accord de Paris à 1,5 ou 2 °C de réchauffement par rapport à l’époque préindustrielle, nous avons besoin d’aller collectivement vers des émissions nettes nulles !

Comme il y aura sans doute des secteurs difficiles à décarboner, comme la sidérurgie ou le transport aérien, nous savons qu’il y aura sans doute besoin d’un peu de ces puits de carbone pour compenser ces émissions résiduelles.

On est donc sur une ligne de crête compliquée à tenir : ne pas mettre ces techniques d’élimination du CO₂ en avant, pour ne pas décourager la réduction des émissions – en raison du potentiel de décarbonation limité de ces techniques, nous allons y revenir – et en même temps continuer à soutenir la recherche sur ces technologies parce qu’elles pourraient se révéler utiles, au moins dans une certaine mesure.

En augmentant l’efficacité des puits de carbone naturels, si on reprend l’analogie avec le pansement et la blessure, on ne s’attaque toujours pas à la cause (l’émission de gaz à effet de serre), mais on remonte dans la chaîne de causalité en s’attaquant à quelque chose de plus amont que dans le cas de la modification du rayonnement solaire.

Il existe de nombreux types de méthodes d’élimination du CO₂, à la fois naturelles et technologiques. Présentent-elles toutes le même potentiel et les mêmes risques ?

L. B. : Pour éliminer du CO₂ déjà dans l’atmosphère, il y a une très grande diversité de techniques, en partie parce qu’il existe plusieurs « réservoirs » dans lesquels il serait possible de stocker le CO₂ retiré de l’atmosphère : dans le sous-sol, dans l’océan, dans la biomasse continentale.

Pour simplifier, je dirais qu’il y a une série de techniques qui sont aujourd’hui considérées comme « gagnant-gagnant » : elles permettent de retirer du CO₂ de l’atmosphère et elles ont d’autres bénéfices.

Prenons par exemple la restauration et la conservation des écosystèmes côtiers, comme les mangroves ou les herbiers marins : ces actions permettent un stockage de carbone et, par exemple, de mieux protéger les côtes contre la montée du niveau marin et les épisodes de submersion côtière. D’autres techniques, en foresterie, en agroforesterie ou en stockant le carbone dans les sols, permettent aussi de développer des pratiques agricoles qui sont plus vertueuses.

Malheureusement, comme évoqué dans le rapport, ces approches sont difficiles à mettre à l’échelle, en raison des surfaces souvent limitées et des quantités phénoménales de carbone qu’il faudrait pouvoir stocker dans ces réservoirs naturels pour avoir un effet significatif.

Et puis il y a, à l’autre bout du spectre, des techniques qui sont jugées peu efficaces et dont on sait qu’elles ont sans doute des effets dommageables sur les écosystèmes. Compte tenu des connaissances actuelles, l’Académie des sciences recommande de ne pas poursuivre dans ces directions-là.

L’exemple le mieux documenté est celui de la fertilisation par le fer du plancton marin, car elle a été envisagée il y a déjà longtemps, à la fin des années 1980. L’idée est d’aller en pleine mer, dans des régions où le développement du phytoplancton est limité par la faible abondance d’un nutriment bien particulier : le fer. Dans ces régions, il n’y a pas besoin d’ajouter beaucoup de fer pour fertiliser le plancton, qui va se développer davantage, et pour cela absorber plus de CO₂. Une partie de la matière organique produite coule ensuite vers les profondeurs de l’océan, emportant avec elle le carbone qu’elle contient. Ce carbone est ainsi isolé de l’atmosphère dans l’océan profond, potentiellement pour des centaines d’années.

Plusieurs expériences scientifiques ont été menées en pleine mer dans les années 1990 et 2000. À court terme, elles ont effectivement mis en évidence une augmentation du flux de carbone de l’atmosphère vers l’océan.

Toutefois, des travaux plus récents, notamment fondés sur la modélisation, montrent que cette technique est probablement beaucoup moins efficace qu’on ne l’imaginait initialement. Surtout, en modifiant fortement les écosystèmes marins pour capter du carbone, elle entraîne toute une série d’effets indésirables : l’émission d’autres gaz à effet de serre, une diminution de l’oxygène dans les eaux profondes, ou encore l’épuisement de certains nutriments essentiels, qui ne sont alors plus disponibles pour d’autres écosystèmes.

Ces constats ont conduit la communauté internationale à réagir. En 2008, les États ont amendé le protocole de Londres afin d’y introduire une interdiction de ce type de pratiques en haute mer.

Dans le cas de la fertilisation des océans, les risques sont donc bien documentés – ils ne concernent pas directement le climat mais des dommages collatéraux ?

L. B. : Oui. Malheureusement, on voit en ce moment une résurgence de certains projets poussés par certains chercheurs qui continuent à défendre ce type de techniques, par exemple aux États-Unis. Mais pour nous, il semble clair qu’il ne faut pas recommander ces techniques aux effets collatéraux bien documentés.

À lire aussi : Géo-ingénierie marine : qui développe ces grands projets, et qu’y a-t-il à y gagner ?

Entre les techniques trop risquées, comme la fertilisation des océans, et les techniques de conservation et de restauration, que j’appelais « gagnant-gagnant » tout à l’heure, il y a d’autres techniques, pour lesquelles on a besoin de davantage de recherche – c’est le cas, par exemple, des techniques d’alcalinisation de l’océan.

Il s’agit d’une technique chimique cette fois : on augmente le pouvoir tampon de l’océan en ajoutant du matériel alcalin. Un des points positifs, c’est que cette technique consiste en l’accélération d’un phénomène naturel qui est l’altération des roches sur les continents. Quand les roches s’altèrent, elles apportent de l’alcalinité à l’océan, donc elles augmentent le pouvoir tampon de l’océan qui absorbe plus de CO₂ – c’est un processus très lent, qui a un rôle très important sur les échelles de temps très, très longues et qui régule en partie le cycle du carbone sur les échelles de temps géologiques.

Deuxième avantage : le CO2 ainsi stocké dans l’océan l’est de manière très durable, bien plus que dans des approches reposant sur du carbone organique (comme la fertilisation des océans) où le stockage est beaucoup plus incertain. Troisième point positif, cette augmentation de l’alcalinité permet aussi de réduire partiellement l’acidification des océans.

Mais ces bénéfices s’accompagnent de nombreuses incertitudes et de risques. Ajouter des matériaux alcalins modifie parfois fortement la chimie de l’eau de mer. Quels effets cela pourrait-il avoir sur les écosystèmes marins, le plancton ou les espèces côtières dont dépendent de nombreuses populations humaines ? À ce stade, nous manquons encore de données pour répondre clairement à ces questions.

L’efficacité même de la technique reste également incertaine. Pour qu’elle fonctionne, l’alcalinité ajoutée doit rester dans les couches de surface de l’océan, là où les échanges avec l’atmosphère ont lieu. Si elle est rapidement entraînée vers les profondeurs, son impact sur l’absorption du CO₂ devient très limité.

Enfin, il y a beaucoup de questions sur le coût de ces techniques. En particulier, un certain nombre de start-up et d’entreprises s’orientent vers des méthodes électrochimiques, mais c’est très coûteux d’un point de vue énergétique. Il faut faire le bilan sur l’ensemble du cycle de vie de ces techniques.

En somme, on a une gamme de techniques, parfois appelées abusivement « solutions » : certaines que l’on ne recommande pas aujourd’hui parce que les risques sont énormes ; d’autres qu’il faut prioriser et recommander, mais qui ont une efficacité somme toute limitée. Et puis entre les deux, des méthodes sur lesquelles il faut continuer à travailler.

À l’échelle internationale, où et quand se discutent les nouveaux risques des techniques de géo-ingénierie climatique ?

L. B. : La question des puits de carbone est déjà largement débattue dans le cadre des COP Climat, notamment parce que les gouvernements peuvent les intégrer dans leurs objectifs de réduction des émissions. C’est le cas, par exemple, des stratégies d’afforestation (boisement) et de reforestation. En revanche, il reste encore beaucoup de travail à faire sur les modalités concrètes de mise en œuvre de certaines techniques d’élimination du CO₂ que nous avons évoquées. En particulier, les questions de mesure et de vérification du CO₂ réellement retiré de l’atmosphère sont complexes et loin d’être résolues. Le Giec a d’ailleurs été mandaté par les gouvernements pour produire un rapport méthodologique spécifiquement consacré à ces enjeux.

En ce qui concerne la modification du rayonnement solaire, mon inquiétude est nettement plus forte. Certains pays affichent désormais ouvertement leur intérêt pour un déploiement potentiel de ces techniques.

Dans le prochain rapport du Giec, la géo-ingénierie occupera une place plus importante que dans les précédents. J’espère que cela permettra de documenter de façon précise et convaincante les risques potentiels associés à ces approches.

Propos recueillis par Elsa Couderc.

Bopp Laurent a reçu des financements du CNRS, de l'Agence Nationale de la Recherche, de la Fondation pour la Recherche sur la Biodiversité, du Programme Horizon Europe de la Commission Européenne, et de la Fondation Schmidt Sciences.

20.01.2026 à 16:58

Des planètes errantes, sans étoile, découvertes par le satellite Euclid

Texte intégral (1657 mots)

Sa mission est de cartographier le cosmos pour en dévoiler les mystères. Mais au passage, le satellite Euclid a découvert une quinzaine d’exoplanètes sans étoiles : des planètes errantes. On en connaît peu, mais Euclid et de futurs satellites devraient nous aider à comprendre leur formation.

Lorsque le télescope spatial Euclid de l’Agence spatiale européenne (ESA) a été lancé en 2023, son objectif était d’explorer l’un des plus grands mystères de l’Univers : le côté obscur du cosmos. En cartographiant des milliards de galaxies, Euclid doit aider à révéler la nature de la mystérieuse énergie noire qui serait le moteur de l’évolution du cosmos. Il n’avait pas été conçu pour étudier les régions de formation d’étoiles ni pour traquer des planètes.

Mais quelques mois après son lancement, l’ESA a mis en place le programme d’observations préliminaires d’Euclid (Euclid early release observations, ou ERO). Ce programme vise à démontrer les performances exceptionnelles du télescope à travers une large gamme d’objets astrophysiques, qu’il s’agisse de galaxies et d’amas lointains ou de régions de formation d’étoiles beaucoup plus proches. Cela permet de mettre en lumière la polyvalence et la précision des instruments d’Euclid, et prouver leur valeur bien au-delà de sa mission principale de cosmologie.

Des planètes sans soleil

Par définition, les planètes sont censées orbiter autour d’étoiles. Mais certaines sont solitaires, errant dans l’espace interstellaire sans étoile pour les réchauffer. Ces planètes errantes, comme on les surnomme, sont de véritables orphelines du cosmos. On pense qu’elles peuvent s’être formées comme des mini-étoiles, à partir de l’effondrement de petits nuages de gaz et de poussières.

Une autre hypothèse y voit de vraies planètes, nées autour d’une étoile et ayant été violemment éjectées de leur système d’origine. Les détecter et les étudier permet ainsi aux astronomes de mieux comprendre à la fois la formation des étoiles et la formation et l’évolution précoce (et parfois chaotique) des systèmes planétaires.

Jusqu’à présent, repérer ces corps discrets relevait presque de l’impossible tant la lumière qu’ils émettent est faible. Ils sont aussi très difficiles à distinguer d’autres objets astrophysiques, en particulier de galaxies lointaines. Mais Euclid, grâce à la combinaison unique d’un grand champ de vision, d’une résolution fine et d’une sensibilité allant de la lumière visible à l’infrarouge, a changé la donne.

Euclid prend le Taureau par les cornes

Lorsque l’ESA a proposé à la communauté scientifique de participer au programme ERO, notre équipe a suggéré de pointer Euclid vers une région de formation d’étoiles bien connue : le nuage LDN 1495, au sein de la constellation du Taureau, situé à environ 450 années-lumière. Cette région sombre, où le gaz et la poussière se condensent pour former de jeunes étoiles, est étudiée depuis des décennies, mais ne l’avait jamais été avec la précision et la sensibilité fournie par Euclid.

Les observations d’Euclid ont été combinées à plus de vingt ans d’imagerie au sol accumulée par notre équipe et obtenue avec des télescopes, comme le Canada-France-Hawaii Telescope (CFHT), Subaru ou UKIRT, tous les trois situés sur le sommet du volcan Mauna Kea dans l’archipel hawaiien (États-Unis). Cette longue période d’observation nous a permis de mesurer les mouvements, les luminosités et les couleurs de centaines de milliers de sources faibles dans ces images.

Parmi elles, 15 objets se distinguent. Leur luminosité, leur couleur et leur mouvement correspondent à ceux attendus pour des objets qui se sont formés dans les nuages moléculaires du Taureau. Ces objets partagent certaines propriétés : étant nés à peu près ensemble, ils sont tous jeunes (quelques millions d’années), situés à une distance similaire (celle des nuages, d’environ 425 à 490 années-lumière) et se déplacent ensemble à la même vitesse et dans la même direction dans le ciel, ayant hérité du mouvement du nuage moléculaire où ils sont nés. Neuf de ces quinze objets sont totalement nouveaux, et parmi les plus faibles et les moins massifs jamais détectés dans cette région.

Certains de ces candidats sont incroyablement petits : d’après leur luminosité extrêmement faible, ils pourraient avoir des masses proches ou légèrement supérieures à celle de Jupiter. C’est bien en dessous du seuil de masse d’une étoile ou même d’une naine brune, un astre plus gros qu’une planète, mais trop petit pour être une étoile. Cela les place donc clairement dans la catégorie des objets de masse planétaire. S’ils sont confirmés, ils compteraient parmi les objets les plus légers jamais détectés de manière directe en dehors d’un système solaire.

Une fenêtre sur les origines cosmiques

Cette découverte est bien plus qu’une curiosité : elle ouvre une fenêtre directe sur la façon dont l’Univers fabrique ses étoiles et ses planètes. Ces mondes solitaires se forment-ils de la même manière que les étoiles, à partir de petits fragments de nuages qui s’effondrent sous l’effet de la gravité ? Ou bien sont-ils les orphelins de systèmes planétaires, expulsés par le chaos gravitationnel de leur famille ?

Chacun de ces deux scénarios a des implications différentes pour notre compréhension des premiers stades de la formation stellaire, mais aussi de la formation des planètes. Dans des régions comme la constellation du Taureau, où la densité d’étoiles est faible et les étoiles massives sont rares, ces objets de masse planétaire pourraient se former directement par effondrement gravitationnel, brouillant encore davantage la frontière entre planète et étoile.

Les résultats de notre équipe suggèrent également que ces planètes errantes pourraient ne pas être si rares. En extrapolant nos résultats à l’ensemble du complexe du Taureau, on peut estimer que des dizaines d’entre elles, encore à découvrir, pourraient exister dans cette région.

Un Univers plein de surprises

Ce travail ne constitue qu’une première étape. Euclid a déjà observé d’autres régions de formation d’étoiles dans le cadre du programme ERO, actuellement en cours d’analyse, et pourrait en observer à nouveau à l’avenir, offrant ainsi des mesures de mouvements encore plus précises et des recensements plus complets.

À moyen terme, le futur télescope spatial Nancy-Grace-Roman, dont le lancement est prévu à l’automne 2026, disposera de capacités similaires et complémentaires en grand champ et en infrarouge. Ensemble, ces télescopes ouvriront une ère nouvelle pour l’étude systématique des objets de très faible masse dans les jeunes régions du cosmos.

Enfin, le James-Webb Space Telescope jouera un rôle clé dans le suivi de ces découvertes, en fournissant les observations spectroscopiques indispensables pour confirmer la nature, la masse et la composition des atmosphères de ces mondes errants. Ces missions dessinent un avenir particulièrement prometteur pour l’exploration des origines des étoiles et des planètes errantes.

À lire aussi : Euclid vs James-Webb : le match des télescopes spatiaux ?

Chaque nouveau grand télescope finit par accomplir des découvertes qu’il n’était pas censé faire. Le télescope spatial Hubble a révolutionné la cosmologie, mais il nous a aussi offert des vues spectaculaires des pouponnières d’étoiles. Aujourd’hui, Euclid, construit pour cartographier le squelette invisible du cosmos, révèle de nouveaux mondes en formation flottant dans l’Univers sans attache et sans étoile. Petits, froids et solitaires, ces mondes vagabonds nous rappellent que la frontière entre planète et étoile est mince et que, même dans l’obscurité entre les étoiles, il reste des histoires à découvrir.

Hervé Bouy est membre senior de l'Institut Universitaire de France. Il a reçu des financements du Conseil européen pour la recherche (ERC) et a été employé à l'Agence spatiale européenne (ESA).

19.01.2026 à 16:25

La microscopie de fluorescence à super-résolution : véritable tournant technologique dans l’analyse de la dynamique des mitochondries

Texte intégral (1910 mots)

Explorer l’intérieur de nos cellules et leurs compartiments, tout en identifiant chaque protéine pour les cartographier, préciser leurs interactions et déchiffrer de nouveaux mécanismes biologiques… c’est désormais à notre portée grâce au développement de microscopes de super-résolution. Grâce à ces nouvelles techniques, les mitochondries, composants clés des cellules impliqués dans de nombreuses pathologies, révèlent une partie de leurs mystères.

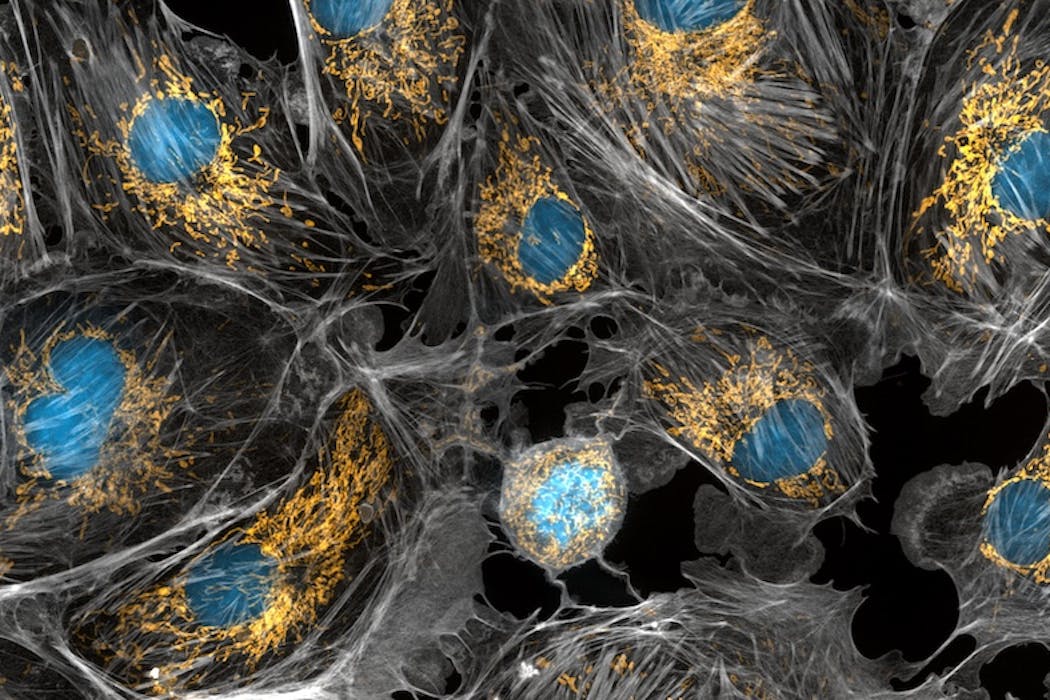

Les mitochondries sont principalement connues pour être les centrales énergétiques de nos cellules, car elles y sont responsables de la production d’énergie et de chaleur. Elles participent également à la synthèse de nombreuses molécules et assurent un contrôle crucial sur la vie et la mort des cellules. Récemment, des microscopes ultrasophistiqués ont permis de mettre à jour l’incroyable vie active des mitochondries, qui se déplacent, fusionnent entre elles et se séparent.

Ces progrès sont cruciaux car les mitochondries sont impliquées dans de nombreuses atteintes neurodégénératives, maladies cardio-vasculaires et cancers. Comprendre comment les mitochondries endommagées contribuent au processus d’une maladie est essentiel pour le développement de traitements.

Les mitochondries, un réseau en reconfiguration perpétuelle

Dans la plupart des cellules et des tissus, les mitochondries ont la forme de tubes, plus ou moins longs. Les mitochondries s’adaptent à la taille et aux besoins énergétiques des cellules, ainsi dans les larges cellules énergivores, il peut y avoir plus de 200 000 mitochondries par cellules tandis que dans d’autres cellules, il y aurait moins de 100 mitochondries. En fonction de l’organe d’origine de la cellule, les mitochondries se répartissent dans la cellule et forment de grands réseaux. Elles changent également sans cesse de formes et leurs attachements avec les autres structures de la cellule.

Dès les années 1950, les données de microscopies électroniques ont révélé la structure de ces petits tubes et précisé leur organisation membranaire. Leur membrane externe est doublée d’une membrane interne, qui s’invagine et forme des poches à l’intérieur des mitochondries. Ces poches sont appelées crêtes et sont le lieu de la synthèse d’énergie.

Pour bien comprendre la fonction des mitochondries, il faut donc s’intéresser à leur structure, leur dynamique et leur distribution. Un axe important de travaux scientifiques porte sur cette relation structure-fonction afin de découvrir de nouveaux moyens de protéger la morphologie mitochondriale et de développer des stratégies thérapeutiques pour lutter contre les maladies mitochondriales ou les atteintes neurodégénératives.

La microscopie de fluorescence, la clé pour le suivi des mitochondries en temps réel

Si la microscopie électronique permet d’obtenir des vues extrêmement détaillées des mitochondries, son utilisation ne permet pas de rendre compte de la complexité de leur organisation au sein des cellules, ni de leur nature dynamique. En effet, ce type de microscopie se limite à des images cellulaires figées dans le temps. C’est ici qu’intervient la microscopie de fluorescence, un domaine en pleine effervescence qui permet de capturer des images ou des vidéos.

La microscopie de fluorescence repose sur le principe d’excitation et d’émission contrôlées de photons, particules composant la lumière, par des molécules présentes dans les cellules. Contrairement aux microscopes à fond clair, qui sont les microscopes les plus simples, comme ceux utilisés en cours de sciences, et où l’image est générée à partir des signaux collectés après le passage de la lumière à travers l’échantillon, les microscopes à fluorescence collectent les signaux lumineux qui proviennent de l’objet biologique lui-même, comme des petites ampoules que l’on allumerait au cœur de la cellule.

Le développement de l’informatique et des capteurs de caméra sensibles et rapides ont également rendu possible le suivi des signaux dans le temps, et la quantification des mouvements de chaque compartiment des mitochondries.

La super-résolution, quand la science éclaire l’invisible

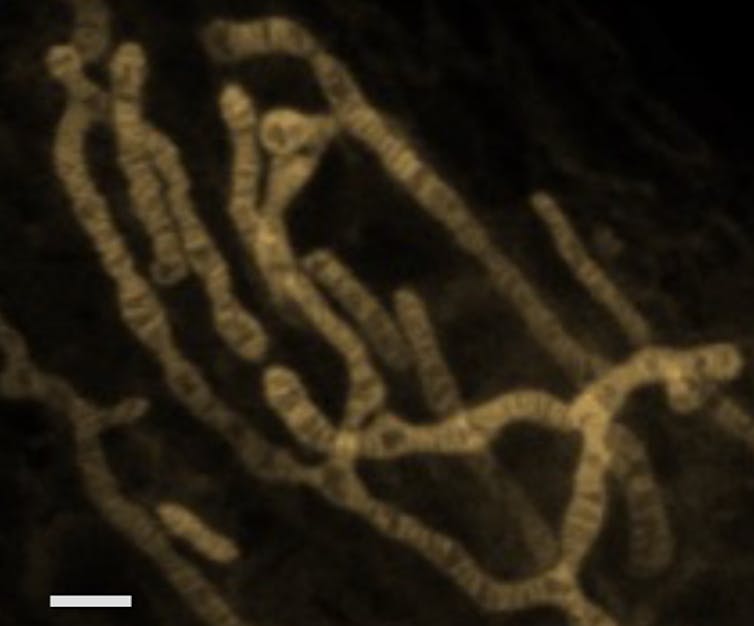

Pour aller plus loin que ces observations déjà fascinantes de réseaux de mitochondries, la microscopie de fluorescence ne suffit pas. En effet, en microscopie optique, les objets plus petits qu’une certaine taille, environ 200-300 nanomètres radialement et 500-700 nanomètres axialement, ne peuvent pas être distingués. En effet, selon un principe physique, la diffraction de la lumière, soit la déviation des rayons lumineux, fait qu’un émetteur unique apparaît comme une tache sur la caméra – on parle de figure de diffraction, et plus précisément ici de « fonction d’étalement du point ».

Cette limitation entrave l’observation précise de structures complexes telles que les mitochondries du fait de leur taille qui est similaire à la limite de diffraction.

La microscopie de fluorescence à super-résolution (microSR) a changé la donne dans le domaine de la recherche biologique depuis les années 2000. Grâce à cette technologie, les scientifiques peuvent pénétrer dans le monde nanoscopique et observer en temps réel les structures complexes et les interactions des composants cellulaires. La microscopie de fluorescence à super-résolution englobe quatre techniques principales, dont l’une a été récompensée par le prix Nobel de chimie en 2014.

Chacune de ces techniques s’attaque à la limite de diffraction d’une manière unique, permettant de séparer des points situés à moins de 200 nanomètres. Cette avancée permet aux chercheurs d’atteindre des résolutions spatiales de quelques nanomètres, dévoilant ainsi les détails les plus fins des structures cellulaires comme jamais auparavant. Restreints il y a encore peu de temps à quelques laboratoires prestigieux dans le monde, ces équipements se démocratisent et se déploient dans les plates-formes de microscopie.

La mitochondrie sous un nouveau jour, dévoilée à l’échelle nanométrique

Nous avons utilisé un type de microscopie de fluorescence à super-résolution, la microscopie de localisation de molécules uniques, qui nous a permis d’identifier les protéines sur les membranes des mitochondries et de les cartographier.

Avec un autre type de microscopie de fluorescence à super-résolution, nous avons visualisé le contour des crêtes, retrouvant ainsi le visuel connu d’une image de microscopie électronique… à ceci près qu’aucun traitement chimique liée à la fixation de l’échantillon n’est venu perturber l’organisation de ces fines membranes et fragiles petites poches. Ceci permet de découvrir la complexité interne des mitochondries et l’hétérogénéité de ses structures, afin de corréler la morphologie des mitochondries à leur activité ou à la présence de défaut génétique.

Ces images donnent accès à deux échelles de temps, c’est-à-dire deux niveaux de cinétique. D’une part, sur quelques minutes durant lesquelles nous pouvons observer, nous voyons que les mitochondries se déplacent, changent de forme, fusionnent entre elles ou se séparent.

D’autre part, toujours avec la microscopie de super résolution, nous pouvons observer sur quelques secondes, toute l’ondulation et le remodelage des structures internes des mitochondries nécessaires à la production d’énergie.

Ainsi, on découvre que les mitochondries ne sont pas de simples centrales énergétiques cellulaires mais des organites dynamiques possédant de nombreuses particularités nanoscopiques. La microscopie de super résolution permet d’envisager une meilleure compréhension de comment les mitochondries endommagées contribuent au processus de nombreuses maladies, ce qui est essentiel pour le développement de traitements.

Arnaud Chevrollier a reçu des financements de l'Université d'Angers, AFM-téléthon

Pauline Teixeira et Solenn Plouzennec ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.