29.01.2026 à 12:14

Quand et comment décide-t-on qu’une espèce est éteinte ?

Texte intégral (4349 mots)

Il est bien plus difficile de prouver une absence que de constater une présence. Il faut donc souvent des années, et un processus minutieux, pour qu’une espèce soit déclarée éteinte. Cela peut-être particulièrement difficile lorsqu’il s’agit d’espèces nocturnes, discrètes ou vivant dans des milieux reculés.

Déclarer une espèce « éteinte », ce n’est pas comme rayer un nom d’une liste. C’est un verdict lourd de sens, prononcé avec une extrême prudence. Car annoncer trop tôt une disparition peut condamner une espèce qui existe peut-être encore quelque part. Alors comment font les scientifiques en pratique ?

Comment les scientifiques tranchent-ils la question de l’extinction ?

Pour en arriver là, les biologistes doivent mener des recherches exhaustives, dans tous les habitats potentiels, aux bonnes périodes (saisons, cycles de reproduction), et sur une durée adaptée à la biologie de l’espèce.

Concrètement, plusieurs indices sont analysés ensemble :

l’absence prolongée d’observations fiables,

des campagnes de recherche répétées et infructueuses,

le temps écoulé depuis la dernière observation confirmée,

et l’état de l’habitat. Si celui-ci a été totalement détruit ou transformé au point d’être incompatible avec la survie de l’espèce, la conclusion devient plus solide.

Autrement dit, on ne déclare pas une espèce éteinte parce qu’on ne l’a pas vue depuis longtemps, mais parce qu’on a tout fait pour la retrouver, sans succès.

Qui décide officiellement de l’extinction ?

À l’échelle mondiale, c’est l’Union internationale pour la conservation de la nature (UICN) qui statue, depuis 1964, via sa célèbre « liste rouge », référence internationale en matière de biodiversité.

La liste rouge classe les espèces selon leur risque d’extinction, en plusieurs catégories allant de « préoccupation mineure » à « éteinte ». Elle est mise à jour régulièrement, accessible en ligne, et donne aujourd’hui le statut de 172 600 espèces.

Bien plus qu’une simple liste d’espèces et de leur statut, elle fournit aussi des informations sur l’aire de répartition, la taille des populations, l’habitat et l’écologie, l’utilisation et/ou le commerce, les menaces ainsi que les mesures de conservation qui aident à éclairer les décisions nécessaires en matière de préservation.

C’est donc un outil indispensable pour informer et stimuler l’action en faveur de la conservation de la biodiversité et des changements de politique. Le processus d’élaboration de la liste rouge implique le personnel de l’équipe d’évaluation et de connaissance de la biodiversité de l’UICN, les organisations partenaires, les scientifiques, les experts de la Commission de la sauvegarde des espèces de l’UICN, ainsi que les réseaux partenaires qui compilent les informations sur les espèces.

L’IUCN déclare une espèce comme « éteinte » quand il n’existe aucun doute raisonnable que le dernier individu a disparu. Des gouvernements ou agences nationales peuvent également déclarer une espèce éteinte localement, sur leur territoire.

Des extinctions bien réelles : quelques exemples récents

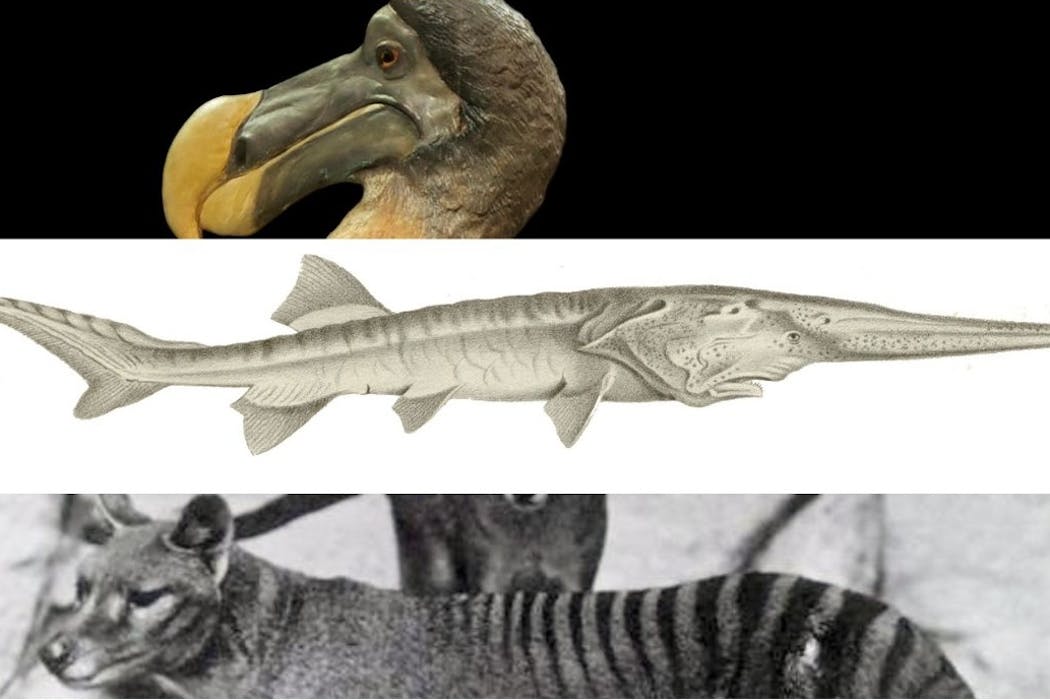

Le dodo (Raphus cucullatus) reste l’icône des extinctions causées par l’humain : découvert à la fin du XVIᵉ siècle lors de l’arrivée des Européens sur l’île Maurice, il disparaît moins de cent ans plus tard, victime de la chasse et des espèces introduites.

Mais il est loin d’être un cas isolé, les extinctions récentes touchent tous les groupes du vivant. Si les espèces insulaires représentent une part disproportionnée des extinctions récentes (les îles, bien qu’elles ne couvrent que 5 % des terres émergées, abritent près de 40 % des espèces menacées), les espèces continentales sont également touchées.

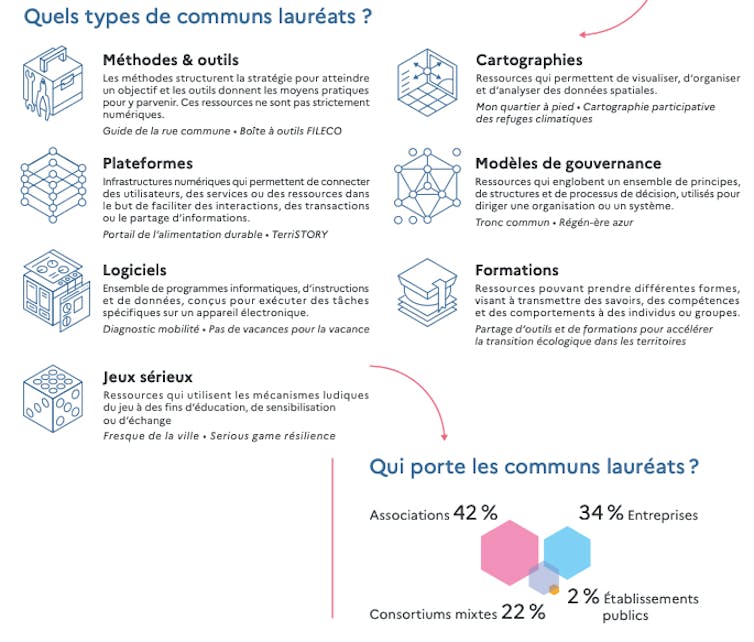

- L’espadon de Chine (Psephurus gladius), une grande espèce de poisson d’eau douce (jusqu’à plusieurs mètres) qui vivait dans le fleuve Yangtsé, a été déclaré éteint en 2022. La surpêche, les barrages bloquant les migrations et la destruction de son habitat ont eu raison de cette espèce spectaculaire qui a été aperçue pour la dernière fois en 2003.

Le courlis à bec grêle (Numenius tenuirostris), un oiseau des zones humides, qui hibernait autour de la Méditerranée avant de rejoindre sa Sibérie natale au printemps, n’a plus été observé de manière certaine depuis 1995. Une étude publiée fin 2024 estime à 96 % la probabilité qu’il soit aujourd’hui éteint, victime de l’agriculture intensive et du drainage des marais.

La musaraigne de l’île Christmas (Crocidura trichura), discrète habitante de l’océan Indien, a été officiellement déclarée éteinte en 2025, après quarante ans sans observation malgré des recherches répétées. Les prédateurs introduits (rats, chats) et les perturbations de l’habitat sont les principaux suspects.

Deux escargots polynésiens (Partula dentifera et P. pearcekellyi) ont été officiellement déclarés éteints en 2024. La cause principale de leur disparition serait l’introduction d’un escargot prédateur invasif (Euglandina rosea), une tragédie silencieuse mais fréquente sur les îles.

Chez les plantes, Amaranthus brownii, une plante herbacée annuelle endémique d’une petite île hawaïenne, a été déclarée éteinte en 2018 après plus de trente-cinq ans sans observation malgré des recherches intensives. La destruction de son habitat et l’arrivée d’espèces invasives ont conduit à sa disparition, sans qu’aucune graine ni plant viable n’ait pu être conservé.

Depuis 2024, la liste rouge de l’IUCN comprend aussi des champignons. En mars 2025 la liste évaluait le statut de 1 300 espèces de champignons. Nous sommes loin des 155 000 espèces connues, mais les premières évaluations restent préoccupantes avec 411 espèces de champignons menacées d’extinction, soit près d’un tiers des espèces recensées.

Peut-on vraiment être sûr ? Entre erreurs, miracles et illusions

L’histoire de la biodiversité peut être pleine de rebondissements.

- L’effet Lazare désigne la redécouverte d’espèces que l’on croyait éteintes. Ce terme fait référence au personnage biblique du Nouveau Testament ressuscité plusieurs jours après sa mort par Jésus. Ce terme est aussi employé en paléontologie pour désigner des groupes d’organismes qui semblent avoir disparu pendant des millions d’années dans le registre fossile avant de réapparaître comme par miracle.

Selon le naturaliste, Brett Scheffers et ses collaborateurs au moins 351 espèces ont ainsi été « ressuscitées » en un peu plus d’un siècle, parfois après des décennies d’absence. La perruche nocturne (Pezoporus occidentalis) ou la rousserolle à grand bec (Acrocephalus orinus) en sont des exemples spectaculaires. Il est important de noter que la majorité de ces redécouvertes concerne des espèces si rares ou difficiles à trouver que leur seule occurrence confirmée provenait de leur description initiale. Ces espèces redécouvertes sont donc pour leur grande majorité toujours considérées comme gravement menacées et pourraient disparaître prochainement.

- L’effet Roméo, au contraire, survient lorsqu’on renonce trop tôt à sauver une espèce en la croyant disparue.

Résultat : on cesse les efforts de conservation… alors qu’il restait peut-être une chance de la sauver. Ce nom fait référence au Roméo de Shakespeare qui renonce à vivre en croyant Juliette morte, alors qu’elle ne l’est pas encore. La conure de Caroline (Conuropsis carolinensis), un perroquet d’Amérique du Nord, pourrait en être un triste exemple. Présumée éteinte au début du XXᵉ siècle cette espèce a probablement survécu plus longtemps comme en atteste les nombreux témoignages locaux (incluant des détails sur son comportement) jusqu’aux années 1950, et peut-être même jusqu’aux années 1960.

- Enfin, l’effet thylacine (du nom du thylacine, plus connu sous le nom de « tigre de Tasmanie ») illustre l’excès inverse : l’espoir persistant qu’une espèce éteinte survit encore, malgré l’absence de preuves solides.

Le thylacine, dont le dernier animal (captif) est officiellement mort en 1936, continue de fait d’alimenter de nombreuses rumeurs et témoignages d’observations non vérifiables. Selon l’étude scientifique la plus complète à ce sujet le dernier animal sauvage entièrement documenté (avec des photographies) a été abattu en 1930, mais il n’y aurait aucune raison de douter de l’authenticité de deux carcasses signalées en 1933, ni de deux autres captures suivies de relâchers en 1935 et en 1937. Par la suite, sur une période de huit décennies, 26 morts et 16 captures supplémentaires ont été rapportées, mais sans être vérifiées, ainsi que 271 observations par des « experts » (anciens piégeurs, chasseurs, scientifiques ou responsables) et 698 signalements par le grand public. En 2005, le magazine australien d’information The Bulletin a offert une récompense de plus d’un million de dollars (soit plus 836 000 euros) à quiconque fournirait une preuve scientifique de l’existence du thylacine, en vain. Entre 2014 et 2020, 3 225 sites équipés de pièges photographiques en Tasmanie, totalisant plus de 315 000 nuits de surveillance, n’ont révélé aucune détection pouvant être attribuée à un thylacine.

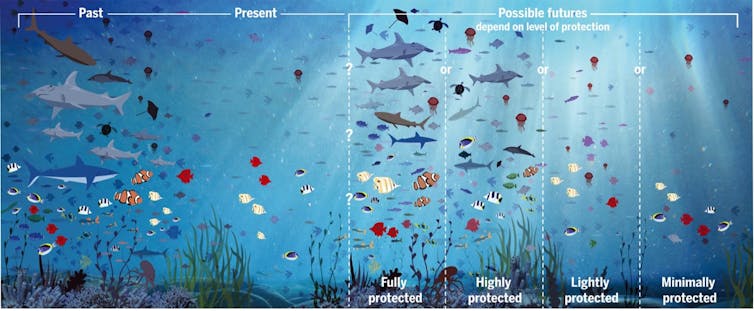

Pourquoi est-ce si compliqué de mesurer les extinctions ?

Prouver une absence est bien plus compliqué que constater une présence. L’UICN préfère donc l’extrême prudence et ne classe une espèce « éteinte » que lorsqu’elle peut l’affirmer avec certitude. En effet, comme nous l’avons vu, officialiser une extinction est un acte lourd de conséquences car cela conduit à clôturer les éventuelles mesures de protection. Ainsi, le requin perdu (Carcharhinus obsoletus) est estimé comme « gravement menacé d’extinction – possiblement éteint » par la dernière publication de la liste rouge de l’UICN en 2020, alors qu’il n’a plus été vu dans ses eaux de la mer de Chine depuis 1934. La liste rouge ne déclarant éteintes que des espèces pour lesquelles il n’y a aucun doute, les extinctions enregistrées sont largement sous-estimées.

De plus, notre vision est biaisée : les vertébrés (en particulier les oiseaux et les mammifères) sont relativement bien suivis, mais l’immense majorité des espèces – insectes, invertébrés, champignons, microorganismes – restent très mal connues et leur taux d’extinction est sous-estimé. Beaucoup d’espèces sont discrètes, minuscules, nocturnes ou vivent dans des milieux difficiles d’accès. Pour la majorité d’entre elles, les données sont quasi inexistantes et elles peuvent disparaître sans que personne ne s’en aperçoive.

Pourquoi est-ce si important de savoir ?

Savoir si une espèce a réellement disparu permet de choisir les bonnes stratégies de conservation. Beaucoup d’espèces peuvent encore être sauvées lorsque quelques individus subsistent. C’est par exemple le cas du condor de Californie (Gymnogyps californianus) pour lequel il restait seulement 22 individus à l’état sauvage dans les années 1980. Un programme de capture de ces spécimens, puis d’élevage en captivité et de réintroduction progressive a permis à la population sauvage de réaugmenter progressivement et d’atteindre 369 individus en 2024.

À l’inverse, un diagnostic erroné – trop optimiste ou trop pessimiste – peut détourner les efforts au mauvais moment.

L’extinction est un fait biologique, mais c’est aussi un défi méthodologique. Entre prudence scientifique, incertitudes du terrain et illusions collectives, établir la frontière entre « menacée » et « éteinte » reste l’un des exercices les plus sensibles de la conservation moderne.

Violaine Nicolas Colin a reçu des financements de l'ANR

28.01.2026 à 16:12

Face aux aléas climatiques, les îles du Pacifique mobilisent les savoirs locaux

Texte intégral (3129 mots)

Les îles du Pacifique sont parmi les plus exposées aux aléas climatiques. Leur histoire les rend aussi particulièrement dépendantes des importations pour se nourrir. Mobiliser les savoirs locaux pour renforcer la souveraineté alimentaire et la résilience des territoires insulaires face au changement climatique est donc crucial.

« Depuis deux ans, peut-être, on ressent quand même qu’il y a un changement au niveau climatique, au niveau de la pluie. Avant, c’était assez fixe. On sait que juillet, c’est [la] saison fraîche […]. Mais l’année dernière, on était en sécheresse depuis juin jusqu’à novembre », constate un homme sur la presqu’île de Taravao, en Polynésie.

Sur l’île de Moorea, à 70 km de là, une femme renchérit.

« C’est vrai qu’on a remarqué les changements climatiques, quand on était plus petit, tu voyais bien les saisons […]. Maintenant, même sur les abeilles, on le voit. Normalement, là, ça y est, on est en période d’hiver austral, de juin jusqu’à septembre, on n’a plus de [miel]. Là, elles continuent encore à produire. Même les abeilles, elles sentent qu’il y a eu un changement. »

Les îles du Pacifique ont régulièrement été confrontées à des événements météorologiques parfois violents : fortes chaleurs, sécheresses, cyclones… L’une des premières conséquences du changement climatique est l’augmentation de la fréquence et/ou de l’intensité de ces évènements, auxquels sont particulièrement exposées les îles du Pacifique.

En effet, de par leur nature insulaire, ces phénomènes affectent l’intégralité des terres, qui sont également plus sensibles à la montée du niveau des océans.

L’agriculture est un secteur important pour ces îles. C’est à la fois une source de nourriture et de revenus pour les agriculteurs comme pour les personnes qui cultivent un jardin océanien. Ces jardins, qui regroupent une grande diversité d’espèces végétales (fruits, légumes, tubercules, plantes aromatiques et parfois médicinales), favorisant la biodiversité dans son ensemble, sont largement répandus dans les îles du Pacifique et particulièrement en Polynésie où ils constituent une part significative de l’identité polynésienne. Les surplus de productions sont régulièrement vendus au bord des routes.

Les impacts du changement climatique présents et à venir sur l’agriculture sont considérables et risquent d’affecter la sécurité alimentaire des îles du Pacifique, fragilisées entre autres par leur dépendance aux importations alimentaires. Les habitants s’y préparent déjà et ont déployé une culture du risque, nourrie de savoirs et de savoir-faire sans cesse renouvelés pour y faire face.

La place des savoirs autochtones et traditionnels dans l’agriculture en Polynésie française

Si les savoirs autochtones et locaux sont depuis longtemps identifiés par leurs détenteurs et par les chercheurs en sciences humaines et sociales pour leur potentiel d’adaptation à l’environnement, une attention particulière leur est portée depuis les accords de Paris en 2015. Ils sont depuis internationalement reconnus comme ressource pour comprendre le changement climatique et ses effets et également pour mettre au point des actions pertinentes pour l’adaptation.

Dans le cadre du projet CLIPSSA, notre équipe a mené des entretiens auprès des cultivateurs et cultivatrices des îles du Pacifique pour comprendre comment se construisent leurs cultures du risque, leurs savoirs et pratiques agricoles pour faire face aux effets du changement climatique.

Face aux fortes chaleurs ou aux fortes pluies qui comptent parmi les effets marquants du changement climatique dans la région, les cultivateurs du Pacifique combinent par exemple différentes techniques comme le paillage (protéger un sol avec de la paille, du fumier, ou de la bâche plastique), la diversification et l’adaptation des types de cultures et de plantations…

Ces différents savoirs et techniques sont parfois transmis par les aînés, parfois expérimentés par soi-même, parfois observés chez d’autres cultivateurs. À Tahiti et à Moorea, deux îles proches de l’archipel de la Société, en Polynésie française, les jardins océaniens (faaapu en tahitien) sont des lieux clés où ces savoirs circulent, s’échangent, s’expérimentent et s’hybrident.

Ces savoirs autochtones, locaux sont avant tout ancrés dans un territoire et adaptés à leur environnement et à ses changements : à ce titre, ils sont en constante évolution. Pourtant, on les désigne souvent comme des savoirs traditionnels ou ancestraux, ce qui peut sous-entendre qu’ils sont transmis à l’identique, de génération en génération. Mais comment ces savoirs ancestraux habitent et nourrissent les savoirs locaux aujourd’hui ?

La figure des Anciens (tupuna) est importante en Polynésie ; particulièrement en agriculture. En effet, le secteur agricole a connu d’importants changements dans les années 1970, avec l’arrivée du Centre d’expérimentation du Pacifique : la mise en œuvre des essais nucléaires a eu de nombreuses conséquences sanitaires, mais aussi économiques (tertiarisation de l’économie polynésienne), et agricoles (développement des importations, notamment alimentaires).

Si le secteur agricole n’a pas pour autant disparu, il a été marginalisé pendant cette période, créant ainsi une rupture dans la transmission des savoirs. Cette rupture a contribué à renforcer l’estime portée aux savoirs agricoles des Anciens qui ont commencé à cultiver avant cette période de changements et s’inscrit dans la continuité de la réappropriation culturelle de l’identité polynésienne, matérialisée, entre autres, par les liens et références à ses ancêtres.

Ainsi, la transmission des connaissances et pratiques des Anciens reste importante, dotée d’une valeur symbolique forte et largement citée par les Polynésiens ; au point où nous pouvons parler d’un socle de savoirs ancestraux.

Mais l’on ne cultive plus aujourd’hui en Polynésie comme l’on cultivait dans les années 1950 ; l’agriculture s’est modernisée, ouverte aux intrants et à de nouvelles cultures. Ce socle s’est donc enrichi de nombreuses influences (modernisation de l’enseignement agricole, tutoriels issus des réseaux sociaux…).

Observer la diversité des savoirs et les pratiques agricoles dans les jardins océaniens

C’est ce que tâche de faire Thierry, qui s’occupe d’un faaapu depuis une quarantaine d’années sur la presqu’île de Tahiti. Cet habitant cultive sur quelques hectares plusieurs dizaines de variétés de bananes, tubercules, coco, agrumes, avocats, destinées à l’autoconsommation mais aussi à la vente.

Le socle de connaissances (savoirs et pratiques) principalement mobilisé par Thierry est celui des savoirs ancestraux, considérés comme une base de savoirs auxquels se référer. Par exemple, il mobilise des indicateurs environnementaux pour planifier ses activités, comme la floraison d’une Zingiberacée qui annonce une période d’abondance pour la pêche, signifiant aux agriculteurs qu’ils doivent se préparer à laisser leurs cultures quelques semaines pour se concentrer sur une activité complémentaire.

Sa parcelle est traversée par une rivière, principale source d’irrigation de ses cultures. Mais pour faire face aux périodes de fortes sécheresses qui peuvent assécher la rivière, ce qu’il observe depuis 2008, il utilise également des bidons en plastique dans lesquels il stocke de l’eau à proximité de ses cultures.

Il utilise aussi le paillage, une technique de recouvrement des sols pour les protéger et garder l’humidité, en disposant des palmes de cocotiers, des troncs de bananiers qu’il complète avec des cartons depuis qu’il a constaté l’assèchement annuel de la rivière :

« Alors, moi, je ne vais pas aller par quatre chemins, nous raconte-t-il. Je vais mettre des cartons par autour. Je vais aller chez les commerçants, leur demander des cartons vides. Je vais mettre par autour parce que je n’ai pas envie de passer mon temps courbé. Après, tu lèves, tu retires. »

Plus globalement, d’une année sur l’autre, Thierry adapte ses cultures en fonction de l’évolution du climat qu’il ressent et décrit ; par exemple en plantant des tubercules, comme le taro, un tubercule tropical adapté au milieu humide.

« Avant, il n’y a jamais d’eau qui coulait ici. Jamais. Et depuis deux-trois ans… Avec cette pluie qui tombe à partir de février-mars, je veux planter des taros, là. Comme ça, je m’adapte, je tire pour le prix de cette eau qui tombe gratuitement. »

À travers l’exemple du faaapu de Thierry, nous pouvons observer que si les savoirs ancestraux restent le socle de références mobilisé pour cultiver, pour faire face aux aléas du changement climatique, il n’hésite pas à adapter ses pratiques, introduire des matériaux ou changer certaines de ses cultures.

Des « faisceaux de savoirs ordinaires » plutôt que des « savoirs ancestraux extra-ordinaires »

Évoquer les savoirs autochtones et locaux renvoie généralement aux notions de « savoirs traditionnels », de « savoirs ancestraux ». Ces savoirs peuvent effectivement avoir un ancrage temporel, beaucoup sont transmis depuis plusieurs générations par exemple. Mais il s’agit d’abord de savoirs ancrés localement, adaptés à leur environnement, qui, à ce titre, ont la capacité de se transformer, de s’hybrider avec d’autres types de savoirs mais aussi de se cumuler, comme nous avons pu le voir dans l’étude de cas présentée.

Face à l’urgence du changement climatique et de ses impacts en milieu insulaire, les politiques publiques locales, nationales ou globales recherchent souvent des solutions d’atténuation ou d’adaptation efficaces et radicales, en misant sur les innovations technologiques, l’ingénierie climatique, les énergies renouvelables…

Au-delà des changements importants et à grande échelle, qui peuvent aussi être complexes, longs et coûteux à mettre en place, les stratégies locales d’adaptation doivent également être envisagées comme des solutions. En revanche, ces solutions locales sont rarement des pratiques délimitées et liées à des savoirs « extraordinaires » (c’est-à-dire en dehors du cours ordinaire des règles et normes attendues). L’adaptation au changement climatique se fait plutôt par succession de petites adaptations, parfois invisibles, dont la configuration est presque unique à chaque agriculteur ou jardinier.

En Polynésie, c’est l’articulation d’un socle de savoirs ancestraux, combiné avec de nombreuses autres ressources, qui fait aujourd’hui la richesse des savoirs agricoles locaux et permet de s’adapter à certains effets du changement climatique. Ces savoirs sont une ressource précieuse à étudier et à mobiliser pour faire face aux risques systémiques du changement climatique qui pèsent sur les petits territoires du Pacifique et notamment sur l’agriculture et la souveraineté alimentaire.

Nous tenons à remercier à Alexi Payssan (anthropologue, Tahiti) pour les échanges inspirants concernant cet article.

Cet article est publié dans le cadre de la Fête de la science (qui a eu lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Le postdoctorat de Maya Leclercq dans le cadre duquel cette recherche a été menée est financé par le projet CLIPSSA (dont les fonds proviennent de l'AFD, de l'IRD et de Météo-France).

Catherine Sabinot a reçu des financements de l'AFD pour réaliser le programme de recherche qui a permis de produire les résultats présentés dans l'article.

27.01.2026 à 16:24

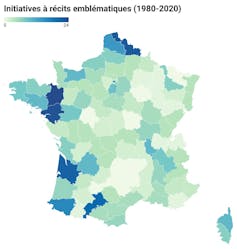

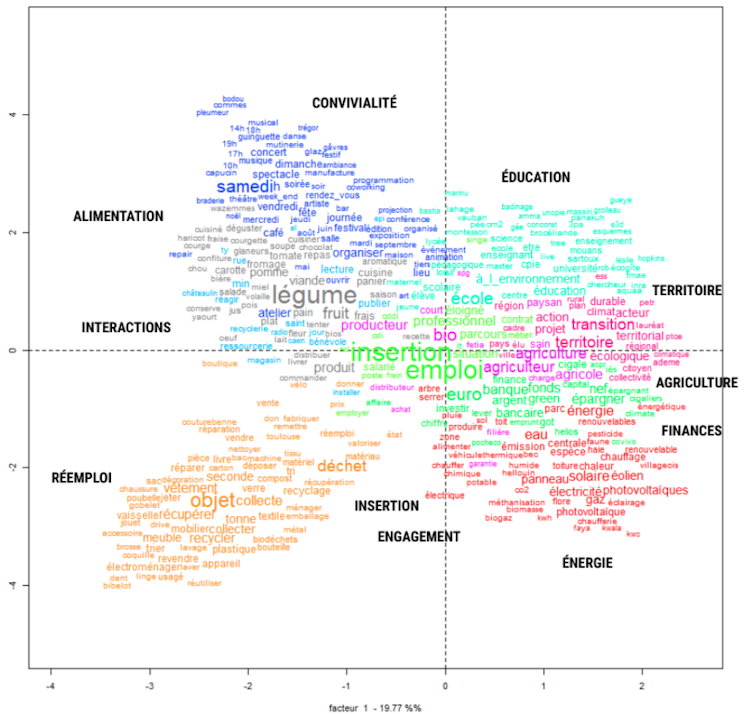

En quoi les communs peuvent-ils répondre aux enjeux de la transition écologique ?

Texte intégral (2152 mots)

De nombreuses initiatives promeuvent aujourd’hui le retour des communs, c’est-à-dire des formes de gestion collective des ressources dont les communautés humaines ont besoin. Pertinente pour répondre à une multitude d’enjeux, cette approche, de par son caractère coopératif, innovant et transversal, apparaît particulièrement prometteuse pour accompagner la transition écologique.

La notion de « communs » revient depuis quelques années sur le devant de la scène, déclinée à des domaines aussi variés que les transports, la santé, l’éducation ou le numérique. Qu’est-ce que les communs ? On peut les définir comme des ressources matérielles (jardins partagés, boîte à livres…) ou immatérielles (Wikipédia, OpenStreetMap…) gérées collectivement par une communauté qui établit des règles de gouvernance dans le but de les préserver et de les pérenniser.

Leur théorisation est récente, mais le principe des communs est en réalité très ancien, beaucoup plus d’ailleurs que la construction juridique et politique, plus récente, de la propriété privée. L’exploitation et l’entretien des ressources, en particulier naturelles, ont très longtemps été organisés collectivement par les communautés humaines… jusqu’à ce que différents processus, dont la construction des États-nations et l’essor du commerce international, contribuent à démanteler ces communs.

Ces dernières décennies, plusieurs facteurs ont entraîné leur regain :

D’une part, la prise de conscience, des effets néfastes de la privatisation des terres sur l’équilibre alimentaire des pays du Sud.

De l’autre, l’essor d’internet et de l’open source, mouvement qui s’oppose au modèle du logiciel propriétaire.

Les travaux d’Elinor Ostrom, qui a reçu en 2009 le Nobel d’économie pour ses travaux démontrant l’efficacité économique des communs, ont largement contribué à imposer le terme dans la sphère médiatique.

À lire aussi : « L’envers des mots » : Biens communs

La collaboration plutôt que la concurrence

Aujourd’hui, l’idée des communs prend d’autant plus d’importance dans le contexte de la transition écologique. En effet, la prise de conscience d’un monde aux ressources finies implique de repenser leur gestion collective. Or, les communs sont particulièrement propices aux démarches d’intérêt général. Leur logique, fondée sur la coopération, va à rebours de celle, dominante, de la concurrence. Dans un cadre de ressources contraintes, une telle logique est précieuse.

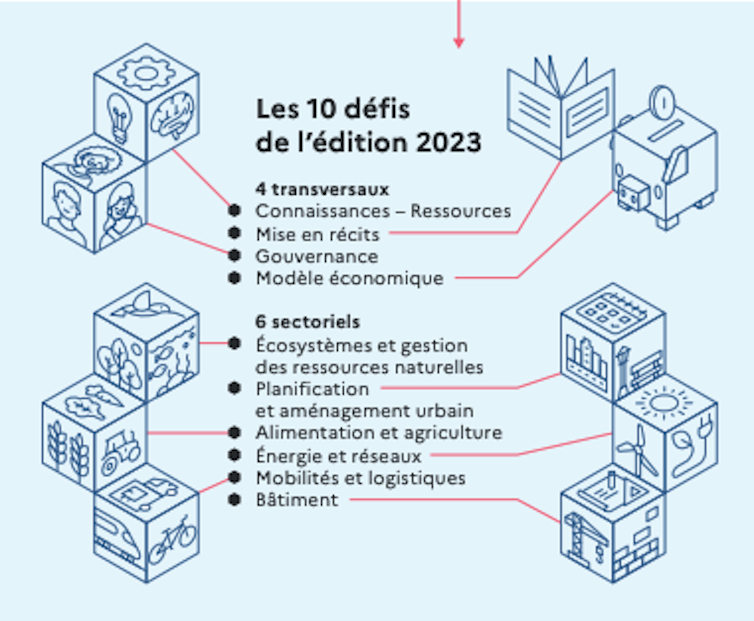

C’est pourquoi de nombreux acteurs, pouvoirs publics comme acteurs privés, commencent à s’en emparer. En France, l’Agence de la transition écologique (Ademe) a déjà accompagné 50 projets de communs depuis quatre ans, à travers un appel à communs (AAC) inédit consacré à la sobriété et la résilience des territoires.

Les porteurs de projets (associations, entreprises, collectivités…) ayant bénéficié d’un soutien technique et financier dans ce cadre doivent ainsi respecter un certain nombre de critères en matière de coopération et de transparence.

Toutes les ressources produites doivent, par exemple, être encadrées par des licences ouvertes. Les porteurs doivent également s’inscrire dans une posture collaborative : s’organiser pour diffuser au maximum les ressources, intégrer les retours utilisateurs et se connecter aux communautés déjà formées dans le domaine.

D’autres acteurs participent à la transformation de l’action publique et se mobilisent sur les communs : la Fondation Macif, l’IGN, France Tiers-Lieux (partenaires de l’AAC de l’Ademe), l’Agence nationale de la cohésion des territoires (ANCT), le ministère de l’éducation nationale, la direction interministérielle du numérique (Dinum)…

Des enjeux transversaux

En favorisant les synergies entre acteurs, les communs apportent des réponses moins cloisonnées.

La 3e édition de l’Appel à communs de l’Ademe traite cinq thématiques sous forme de défis (alimentation et forêt, aménagement et bâtiment, mobilité et logistique, recyclage matière et numérique) qui peuvent être abordés de manière transversale.

Autre spécificité, les candidatures sont rendues publiques avant le dépôt et la sélection des projets, ce qui encourage les postulants à créer des synergies, voire des fusions de projets, des échanges de briques techniques. Les moyens humains et financiers nécessaires au développement des communs sont alors mutualisés, ce qui, à moyen et long terme, permet de réduire les dépenses et de multiplier les impacts.

Parmi les projets de communs que l’Ademe a accompagnés, on peut citer La rue commune. Cette méthode pour repenser les rues en tant que premier bien commun urbain prend en compte des enjeux de différentes natures selon cinq principes :

le lien social,

la priorité au piéton pour favoriser la santé et le bien-être,

la biodiversité,

le rafraîchissement urbain,

et la valorisation des eaux pluviales.

Un autre exemple, Le logement social paysan, entend promouvoir la réhabilitation des fermes pour en faire des logements sociaux paysans, en organisant la rencontre entre paysans et bailleurs sociaux. Ici se croisent les enjeux du bâtiment et ceux de l’agriculture.

Le potentiel des communs numériques

Un intérêt croissant est porté aujourd’hui aux communs numériques, qui constituent à la fois un outil très puissant pour croiser des données complexes et les mettre en commun au service de la transition.

Parmi les projets que l’Ademe a déjà soutenus, citons Pas de vacances pour la vacance, un outil de datavisualisation construit à partir de données publiques qui permet d’observer, à différentes échelles du territoire, la part de logements vacants. L’intérêt : permettre de les revaloriser dans une logique d’urbanisme circulaire et de mieux exploiter ce levier pour répondre aux besoins de logements.

Même principe pour le commun Diagnostic mobilité. Cet outil permet, par datavisualisation, un prédiagnostic pour les collectivités rurales des flux de déplacement majoritaires sur leur territoire, afin de les guider dans les choix de leur politique de transport.

Les communs constituent aujourd’hui un cadre d’action stratégique pour mobiliser l’intelligence collective, dans une logique d’innovation ouverte au service de la transition écologique, en décloisonnant les approches et en mutualisant les savoirs.

À lire aussi : Aux sources de la démocratie : penser le « commun » avec Alcméon, Héraclite et Démocrite

Héloïse Calvier ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

26.01.2026 à 14:58

L’agriculture verticale peut-elle nourrir les villes ? Comment dépasser le mirage technologique

Texte intégral (1520 mots)

L’agriculture verticale a longtemps été présentée comme une solution miracle pour nourrir les mégapoles tout en réduisant leur empreinte environnementale. Mais derrière les promesses high-tech, la réalité est contrastée. Entre des succès spectaculaires en Asie et des faillites retentissantes en Europe et aux États-Unis, le modèle cherche encore sa voie.

L’agriculture verticale repose sur une idée simple : produire en intérieur et hors-sol, dans des milieux totalement contrôlés, y compris la lumière, la température, l’humidité et les nutriments, sur de vastes étagères en hauteur, au cœur des villes. À première vue, ses avantages paraissent irrésistibles. Sans pesticides, ce mode de culture consomme jusqu’à 90 % d’eau en moins grâce au recyclage – notamment l’hydroponie – et peut fonctionner 365 jours par an, avec un rendement élevé, sans dépendre des caprices du climat. Il offre ainsi la promesse d’une production fraîche et locale, directement connectée aux circuits courts.

Cet horizon a suscité un engouement mondial. Le Japon, avec la société Spread, a automatisé la production de salades indoor sur de vastes étagères, dans des univers aseptisés, à l’échelle industrielle. Singapour a inscrit les fermes verticales au cœur de son objectif « 30 by 30 », visant à couvrir localement 30 % de ses besoins alimentaires d’ici à 2030. Les pays du Golfe, comme les Émirats arabes unis et le Koweït, confrontés à la rareté des terres arables, y voient un outil stratégique alors que, aux États-Unis, des start-up ont levé des centaines de millions de dollars sur la base d’une vision d’un futur alimentaire ultratechnologique. Mais des échecs cuisants mettent aussi en évidence les limites du modèle, qui peu à peu tente de se réinventer pour y répondre.

Les ingrédients du succès

Les fermes verticales qui fonctionnent vraiment partagent un point commun : elles naissent dans des contextes où elles répondent à un besoin structurel. Dans les régions où la terre est rare, chère ou aride, la production en hauteur – ou à la verticale – répond efficacement aux contraintes géographiques.

À Singapour ou à Dubaï, par exemple, l’État joue un rôle déterminant en soutenant financièrement les infrastructures, en réduisant les risques d’investissement et en intégrant ces technologies dans les stratégies alimentaires nationales.

La réussite de ces modèles tient aussi à leur insertion dans les dynamiques locales. En effet, à Dubaï, les fermes verticales ne se contentent pas de produire, mais contribuent également à la sécurité alimentaire, à la formation technique, à l’emploi qualifié et à la sensibilisation des citoyens.

L’île-ville de Singapour s’appuie par ailleurs sur des technologies hydroponiques et aéroponiques avancées, avec des tours agricoles intégrés au bâti urbain. Ceci illustre l’adaptation de l’agriculture aux contraintes foncières et urbaines. Les progrès technologiques, notamment l’éclairage LED à haut rendement, l’automatisation poussée et l’IA permettant d’optimiser la croissance des plantes, améliorent la performance des modèles les mieux conçus.

Malgré des défis (coûts énergétiques, fragilité économique), ces fermes continuent aujourd’hui d’être considérées comme un « modèle d’avenir » pour des villes-États densément peuplées, ce qui montre que l’initiative s’inscrit dans une politique de long terme plutôt qu’à titre de simple effet de mode.

Coût, énergie et dépendance au capital-risque

Malgré ces succès, de nombreux projets ont échoué et révélé les fragilités d’un modèle bien moins robuste qu’il y paraît.

Le premier obstacle est énergétique. Éclairer, climatiser et faire fonctionner une installation entièrement contrôlée demande une quantité importante d’électricité, ce qui rend l’activité coûteuse et parfois peu écologique lorsque l’énergie n’est pas décarbonée.

Le second obstacle est économique : les marges sur les herbes aromatiques ou les salades sont faibles, et le modèle dépend souvent du capital-risque plutôt que de revenus stables. C’est ce qui a précipité les difficultés d’Infarm en Europe et d’AeroFarms aux États-Unis.

Certaines fermes se sont également retrouvées déconnectées des besoins alimentaires locaux, produisant des volumes ou des produits qui ne répondaient pas aux attentes des territoires. Le modèle, mal ancré localement, devient alors vulnérable à la moindre fluctuation des marchés financiers ou énergétiques.

De nouveaux modèles en développement

Face à ces limites, une nouvelle génération de projets émerge, cherchant à combiner technologie, intégration et demande urbaine au moyen de modèles de microfermes verticales adossées à des supermarchés, garantissant la fraîcheur, la visibilité et une réduction des coûts logistiques.

D’autres initiatives explorent les synergies énergétiques, en couplant production alimentaire et récupération de chaleur de data centers, en développant des serres photovoltaïques ou en utilisant des réseaux de chaleur urbains.

Les fermes verticales évoluent aussi vers des fonctions plus pédagogiques et démonstratives : même après sa faillite, une partie du modèle Infarm continue d’inspirer des fermes urbaines où la production sert autant à sensibiliser les citoyens qu’à fournir des produits frais. Ces approches hybrides témoignent d’une maturité croissante du secteur, qui privilégie moins la production de masse que la pertinence territoriale.

Vers une agriculture verticale plus durable ?

Pour devenir un levier crédible de la transition alimentaire, l’agriculture verticale doit clarifier sa finalité. Produire davantage ne suffit pas : il s’agit de contribuer à la résilience alimentaire des villes, d’offrir une complémentarité avec les agricultures urbaines plus « horizontales », telles que les toits productifs, les ceintures maraîchères ou les jardins partagés, et de s’inscrire dans les politiques alimentaires territoriales.

En particulier, les projets alimentaires territoriaux (PAT) peuvent, par leur ambition, fédérer les différents acteurs du territoire autour de l’alimentation. Ils jouent un rôle clé pour intégrer ces dispositifs de manière cohérente, en les articulant avec les enjeux de nutrition, d’accessibilité, de distribution et d’éducation. L’agriculture verticale ne deviendra durable que si elle est pensée dans une logique systémique, sobre sur le plan énergétique, ancrée localement et compatible avec les objectifs climatiques.

Loin d’être la panacée, elle est en revanche un laboratoire d’innovation. Là où elle réussit, c’est parce qu’elle s’inscrit dans une vision systémique de la transition alimentaire, combinant technologie, gouvernance territoriale et sobriété énergétique. Son avenir dépendra moins de la hauteur des tours que de la manière dont elle s’imbrique dans les territoires et contribue à renforcer la capacité des villes à se nourrir face aux crises climatiques et géopolitiques.

Marie Asma Ben-Othmen ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

22.01.2026 à 12:29

En Moselle, on dépollue les sols d’une friche sidérurgique grâce aux plantes

Texte intégral (2895 mots)

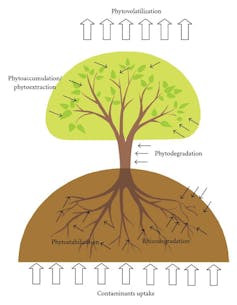

La phytoremédiation est une technique de dépollution naturelle fondée sur l’utilisation de plantes pour gérer différents polluants présents dans les sols. Prometteuse, mais encore expérimentale, cette méthode est testée sous plusieurs modalités par des scientifiques à Uckange, en Moselle, sur la friche d’une ancienne usine sidérurgique.

À l’échelle de l’Europe, 62 % des sols sont aujourd’hui considérés comme dégradés, selon l’Observatoire européen des sols – EUSO. L’enjeu est de taille : les sols, que nous avons longtemps réduits à un rôle de simple support, jouent en réalité de très nombreuses fonctions pour le vivant. Celles-ci sont traduites en services écosystémiques rendus à l’humain : fourniture d’aliments, de fibres, de combustibles, pollinisation, régulation du climat ou encore la purification de l’eau, etc.

Ces biens et services, que nos sols dégradés ne fournissent plus correctement, engendrent notamment une baisse de la production agricole et de la qualité des aliments et de l’eau. Parmi les causes de cette dégradation figurent en bonne place les pollutions d’origine anthropique. Par exemple, l’utilisation de produits phytosanitaires, d’hydrocarbures (stations-service) ou encore pollutions industrielles.

Les polluants peuvent engendrer des problématiques de santé publique et tendent à se propager dans l’environnement, dans les sols, mais aussi, sous certaines conditions, vers les eaux et dans la chaîne alimentaire. Leur élimination est donc cruciale. Pour agir au niveau du sol, il existe trois grandes catégories de traitements : physiques, chimiques et biologiques. La sélection s’opère en fonction de différents paramètres, comme l’hétérogénéité et les teneurs en contaminants, l’étendue de la pollution, l’encombrement du site, les contraintes de temps, le bilan carbone de l’opération ou encore l’acceptabilité du projet par les riverains.

De plus en plus de projets de recherche explorent les traitements biologiques fondés sur la phytoremédiation : la dépollution par des plantes.

C’est notamment le cas à Uckange, en Moselle, où un ancien site sidérurgique est devenu un laboratoire à ciel ouvert permettant de tester ces méthodes, à travers une initiative portée par la Communauté d’agglomération du Val de Fensch en partenariat avec l’Université de Lorraine, l’Inrae et le Groupement d’intérêt scientifique requalification des territoires dégradés : interdisciplinarité et innovation (Gifsi).

Les vertus de la phytoremédiation

Commençons par expliquer ce que l’on entend par « phytoremédiation ».

Il s’agit de sélectionner des végétaux appropriés qui vont, via leurs systèmes racinaires et parfois leurs parties aériennes, permettre de dégrader les polluants organiques (phyto et/ou rhizodégradation), d’extraire les polluants minéraux (phytoextraction), de les stabiliser dans les sols afin d’éviter une mobilité et/ou une biodisponibilité (phytostabilisation) ou même de les volatiliser pour certains d’entre eux (phytovolatilisation).

Le choix des espèces végétales va dépendre, entre autres, des caractéristiques physico-chimiques du sol (potentiel agronomique, contaminant ciblé et teneur), du climat et de leurs capacités à être maîtrisées (non envahissante). Pour ce projet, leurs potentiels de valorisation à la suite de l’action de dépollution ont également été pris en compte.

Certaines plantes sont par ailleurs particulièrement intéressantes pour leur capacité à dépolluer le sol de plusieurs éléments à la fois : le tabouret bleu (Noccaea caerulescens), par exemple, peut extraire d’importantes quantités de zinc, mais aussi de cadmium et de nickel.

Le miscanthus géant (Miscanthus x giganteus) stimule, quant à lui, la microflore du sol pour dégrader les hydrocarbures totaux ou les hydrocarbures aromatiques polycycliques.

L’association de la luzerne (Medicago sativa) à la fétuque élevée (Festuca arundinacea) permet en parallèle, grâce à la microflore du sol, l’élimination de plusieurs molécules de polychlorobiphényles

À lire aussi : La phytoremédiation : quand les plantes dépolluent les sols

La friche d’Uckange, laboratoire à ciel ouvert

Le parc U4, à Uckange, est un ancien site sidérurgique multicontaminé. Il est également classé à l’inventaire supplémentaire des monuments historiques.

Depuis quelques années, une initiative baptisée les jardins de transformation – accessible au public lors de visites guidées – a pour objectif de tester différentes modalités de phytoremédiation. Sur deux hectares de ce site qui en compte douze – les scientifiques explorent la dépollution par les plantes, en association avec des microorganismes présents dans les sols et qui participent également à ce processus de décontamination.

Quand cela était possible, une première phase d’essai en laboratoire a été menée avant l’implantation sur site. Il s’agissait d’expérimentations sous conditions contrôlées (température, humidité, luminosité avec des cycles jour-nuit). L’objectif était de sélectionner les espèces végétales potentielles candidates à un usage pour la phytoremédiation. Après la validation de cette phase en laboratoire, des essais en conditions réelles ont été mis en place.

Depuis 2022, différentes modalités de phytoremédiation sont testées au travers des jardins de transformation. Ce site, qui est contaminé à la fois en éléments traces métalliques (cuivre, zinc, nickel, chrome…) et en polluants organiques (hydrocarbures totaux, hydrocarbures aromatiques polycycliques), accueille, pour le moment, 7 modalités, toutes en co-culture.

Par exemple, des jardins-forêts ont été installés sur trois parcelles du site, représentant environ 750 m2. Une vingtaine d’espèces végétales comestibles de différentes strates (arbres, arbustes, herbacées, légumes racines, lianes) ont été installées afin de tester la capacité de ces associations végétales à dépolluer les sols. De quoi récolter des informations précieuses à l’avenir sur l’éventuel transfert des polluants du sol vers les parties comestibles de ces plantes, qui n’a pas encore été étudié.

Les espèces végétales présentes naturellement sur le site sont également suivies afin de comprendre le mode de recolonisation de ces espaces dégradés et estimer l’implication des 200 plantes identifiées dans l’amélioration de la qualité des sols et la dépollution.

À lire aussi : Peut-on rendre la forêt « nourricière » ? La proposition du jardin-forêt

Associer plantes d’extraction et de dégradation

Une autre originalité du projet est d’associer, pour la première fois, des procédés de phytoextraction et de phyto/rhizodégradation. Jusqu’à présent, seule une espèce végétale capable de traiter un contaminant était mise en place sur un sol. Ici, nous misons sur des co-cultures de végétaux. L’enjeu est d’améliorer l’efficacité de dépollution, mais aussi les fonctions du sol (qualité agronomique, biodiversité, stockage carbone).

L’innovation réside, ici, dans l’association de Miscanthus x giganteus, qui favorise la dégradation des molécules organiques, avec des espèces de la famille des Brassicaceae capables d’extraire les éléments traces métalliques.

Pour chacune des phases et pour tester l’efficience des processus en conditions réelles, des analyses sur le sol, en amont et après les cycles de cultures, sont réalisées dans le but d’évaluer :

la diminution des teneurs en contaminants,

l’amélioration de la qualité agronomique,

et l’augmentation de la biodiversité microbienne.

La biomasse végétale produite sur site est également caractérisée afin d’estimer son application dans les processus de dépollution (notamment la phytoextraction) et d’évaluer la possibilité de valorisation de cette matière première produite sur site dégradé.

Les premiers résultats seront publiés dans les prochains mois.

Bénéfices collatéraux de la phytoremédiation

Notre approche va au-delà de la remédiation des sols : la présence de ces différents organismes vivants aura d’autres effets bénéfiques.

Ces multiples espèces permettent d’améliorer la qualité des sols. En effet, cela augmente sa teneur en matière organique et fournit davantage d’éléments nutritifs, en améliorant l’efficacité du recyclage dans les cycles biogéochimiques. Cela participe aussi à la modification de la structure du sol et à la réduction de l’érosion, et in fini à l’amélioration des rendements et de la qualité des biomasses produites. On peut également noter l’augmentation de la taille des communautés microbienne et de la diversité des microorganismes.

Ceci a déjà été démontré en système agricole, l’idée est désormais de déterminer si les mêmes effets seront détectés sur des sols dégradés. Cette démarche participe également à la lutte contre le changement climatique car elle améliore le stockage du carbone par les sols, ainsi qu’à la régulation des ravageurs et à la pollinisation des cultures sur site, par l’augmentation de la biodiversité animale.

En outre, ce laboratoire à ciel ouvert permet non seulement de tester différentes modalités de phytoremédiation sans être soumis à des contraintes de temps, mais aussi d’obtenir, grâce à ses surfaces importantes, suffisamment de biomasse végétale pour vérifier la possibilité de valoriser les plantes cultivées pour d’autres usages (par exemple, paillage, compost, production d’énergie, produits biosourcés…), une fois leur action dépolluante terminée.

Sonia Henry a reçu des financements de la Communauté d'Agglomération du Val de Fensch et de l'Institut Carnot Icéel

22.01.2026 à 12:16

Comment dépolluer les friches industrielles face à la défiance des habitants ?

Texte intégral (2086 mots)

Près de huit Français sur dix vivent à proximité d’une friche polluée. Malgré les opérations de dépollution, les politiques de reconversion et l’objectif zéro artificialisation nette (ZAN), plusieurs milliers de sites restent à l’abandon. Entre incertitudes techniques, coûts de dépollution cachés et mémoire collective, la confiance des habitants reste difficile à restaurer.

Vous vivez peut-être, sans le savoir, à proximité d’une friche polluée : c’est le cas de près de huit Français sur dix. Malgré les politiques de reconversion engagées ces dernières années, notamment dans le cadre de France Relance (2020-2022) et des dispositifs mis en place par l’Agence de la transition écologique (Ademe), ces friches existent toujours. Selon les données de l’inventaire national Cartofriches, plus de 9 000 friches sont encore en attente de projets de reconversion en France en 2026.

Anciennes usines, décharges, casernes militaires, zones portuaires ou ferroviaires, mais aussi hôpitaux, écoles ou équipements de services… Les friches sont, par nature, très diverses. Elles sont majoritairement héritées de notre passé industriel. Mais certaines concernent des activités de services actuelles qui ont été implantées sur d’anciens terrains industriels déjà contaminés, comme l’illustre l’ancien site Kodak à Vincennes (Val-de-Marne).

Au-delà de leur emprise physique, certaines friches ont marqué durablement les territoires et les mémoires collectives. Certains noms sont aujourd’hui associés à des pollutions persistantes, voire à des crises sociales, comme Métaleurop, Péchiney, Florange ou encore AZF.

Ces sites abandonnés, bâtis ou non, mais nécessitant des travaux avant toute réutilisation font l’objet de transformations variées : logements, jardins, bureaux, centres commerciaux ou espaces culturels, à l’instar de la friche de la Belle-de-Mai dans le 3ᵉ arrondissement de Marseille. À l’heure où la France s’est engagée vers l’objectif zéro artificialisation nette (ZAN), la reconversion des friches est un enjeu majeur pour les territoires afin de limiter l’étalement urbain et promouvoir l’attractivité des territoires.

Pourtant, malgré les opérations de dépollution, beaucoup peinent à retrouver un usage. Pourquoi ? Parce que dépolluer un sol ne suffit pas à effacer un passé ni à restaurer la confiance des habitants.

Dépolluer : une étape indispensable mais complexe

Avant d’être réaménagée, une friche polluée fait l’objet de diagnostics des sols qui débouchent le plus souvent sur l’élaboration d’un plan de gestion. Ce document définit les mesures nécessaires pour rendre le site compatible avec l’usage envisagé : excavations des terres polluées, confinement sous des dalles ou des enrobés, gestion des eaux, surveillance dans le temps, ou encore restrictions d’usage.

Son contenu dépend de l’usage futur. Transformer une friche en entrepôt logistique n’implique pas les mêmes exigences que la création d’une école. Plus l’usage est dit « sensible » et plus les exigences sanitaires sont élevées. En France, la dépollution ne vise donc pas à un retour à un sol totalement exempt de pollution. Elle repose sur un arbitrage entre pollution résiduelle, exposition potentielle et usages futurs.

À cela s’ajoute une réalité souvent sous-estimée : le coût de la dépollution est très variable et est rarement connu avec précision dès le départ.

Selon les caractéristiques du site, les polluants, leur profondeur et les usages envisagés, les coûts peuvent devenir exponentiels. En cas de découvertes fortuites (amiante caché dans des remblais ou concentrations en métaux lourds plus élevées que prévu), le plan de gestion est modifié. Autrement dit, dépolluer est souvent simple sur le papier, mais beaucoup plus incertain dans la réalité, avec potentiellement des coûts cachés.

À lire aussi : En Moselle, on dépollue les sols d’une friche sidérurgique grâce aux plantes

Le stigmate, angle mort de la reconversion

Cette incertitude technique n’est pas sans effet sur la perception des habitants, qui voient parfois ressurgir au fil des travaux les traces d’un passé que l’on pensait maîtriser. Même après des travaux conformes aux normes, de nombreuses friches peinent à attirer habitants, usagers ou investisseurs.

C’est ce que l’on appelle « l’effet de stigmate ». Un site reste associé à son passé, à des pollutions médiatisées ou à des crises sanitaires et sociales qui ont marqué les esprits.

Autrement dit le passé continue de se conjuguer au présent. Le sol est assaini, mais la mémoire collective, elle, ne l’est pas. Pour filer la métaphore, la friche devient un présent imparfait : juridiquement réhabilitée, mais symboliquement suspecte. Ce stigmate a des effets concrets : inoccupations ou sous-utilisations prolongées et oppositions locales, par exemple.

Pour objectiver cette défiance, nous avons mené une enquête auprès de 803 habitants vivant à proximité d’une friche polluée, répartis dans 503 communes françaises. Les résultats sont sans appel : près de 80 % des personnes interrogées se déclarent insatisfaites de la manière dont sont gérées et reconverties les friches polluées en France.

Cette insatisfaction est plus forte parmi les personnes percevant les sols comme fortement contaminés ayant déjà été confrontées à des situations de pollution ou exprimant une faible confiance dans les actions de l’État. Elles se déclarent également plus réticentes à utiliser ou à investir les sites une fois réhabilités.

À lire aussi : Comment redonner une nouvelle vie aux friches industrielles en ville ?

Un décalage entre gestion technique et perceptions

Ces résultats révèlent un décalage entre la gestion technique des friches et la manière dont elles sont perçues par les habitants. Sur le plan réglementaire, un site peut être déclaré compatible avec l’usage prévu, mais sur le plan social, il peut rester perçu comme risqué.

Plusieurs mécanismes expliquent ce décalage.

Le premier tient à l’invisibilité de la pollution des sols. Contrairement à un bâtiment délabré, un sol dépollué ne se voit pas, ce qui peut alimenter le doute.

La mémoire collective joue également un rôle central. Les friches polluées sont souvent associées à un passé industriel lourd, parfois marqué par des scandales sanitaires ou des crises sociales qui laissent des traces durables dans les représentations.

Enfin, le manque d’information peut renforcer la suspicion. Les notions de pollution résiduelle ou de plan de gestion peuvent en effet être difficiles à appréhender pour les non-spécialistes. Or, lorsqu’une pollution n’est pas totalement supprimée, le message peut être mal compris et perçu comme un danger dissimulé.

Ainsi, même si les solutions techniques sont solides, le stigmate persiste. Pourtant, sans confiance des populations, point de reconversion durable.

Ces résultats soulignent un point essentiel : la reconversion des friches polluées ne repose pas uniquement sur la qualité des travaux de dépollution. Elle dépend tout autant de la capacité à instaurer un climat de confiance. Cela suppose une information claire, transparente et accessible, expliquant non seulement ce qui a été fait, mais aussi ce qui reste en place et pourquoi. Cela implique d’associer les riverains aux projets, en amont, afin qu’ils ne découvrent pas les transformations une fois les décisions prises. Enfin, cela nécessite de reconnaître le poids du passé et de la mémoire locale, plutôt que de chercher à l’effacer.

Dans un contexte de zéro artificialisation nette (ZAN), les friches polluées constituent une opportunité foncière. Mais sans prise en compte des dimensions sociales et symboliques, les solutions techniques, aussi performantes soient-elles, risquent fort de rester insuffisantes. Dépolluer les sols est indispensable. Instaurer ou restaurer la confiance des habitants l’est tout autant.

À lire aussi : Sur les terrils miniers du Nord-Pas-de-Calais, la naissance d’une niche écologique inédite

L'enquête détaillée dans l'article a été financée par l'Université de Montpellier.

Marjorie Tendero a reçu un co-financement de sa thèse en sciences économiques par l'ADEME et la Région Pays de la Loire (2014-2017).

21.01.2026 à 16:44

Transition énergétique : développer les bioénergies, oui mais avec quelles biomasses ?

Texte intégral (2250 mots)

En matière de transition énergétique, les débats sur la production et la consommation électrique tendent à occuper le devant de la scène politico-médiatique et à occulter le rôle des bioénergies. Ces dernières font pourtant partie intégrante de la programmation énergétique du pays. Leur production peut avoir des impacts majeurs tant sur les modes de production agricole que sur nos habitudes alimentaires.

Dans les prospectives énergétiques telles que la stratégie nationale bas carbone (SNBC), les scénarios négaWatt ou encore ceux de l’Agence de la transition écologique Ademe… les bioénergies sont régulièrement présentées comme un levier incontournable de la transition, en complément de l’électrification du système énergétique.

Pour rappel, ces énergies, qui peuvent être de différentes natures (chaleur, électricité, carburant…), se distinguent des autres par leur provenance. Elles sont issues de gisements de biomasses tels que le bois, les végétaux et résidus associés, les déchets et les effluents organiques.

L’électrification met en scène de nombreuses controverses politiques et sociétales dans le débat public et médiatique. Par exemple : compétition entre renouvelable et nucléaire, arrêt des moteurs thermiques… À l’inverse, les discussions sur les bioénergies se cantonnent encore aux milieux scientifiques et académiques.

Pourtant, leur déploiement implique des évolutions importantes. Et ceci à la fois dans les modes de production agricole et les habitudes alimentaires, en tout cas si nous le voulons durable.

Il est donc essentiel que le sujet bénéficie d’une meilleure visibilité et d’une plus grande appropriation par la société pour que puissent naître des politiques publiques cohérentes.

Les bioénergies, levier de la transition énergétique

La transition énergétique, qui consiste à réduire drastiquement le recours aux énergies fossiles, est centrale dans la lutte contre le changement climatique. À l’horizon 2050, elle s’appuie sur deux piliers :

d’une part l’augmentation de la production d’électricité « bas carbone », associée à une forte électrification des usages, notamment pour la mobilité.

de l’autre, une hausse conséquente de la production de bioénergies pour compléter l’offre électrique, en particulier pour les usages difficilement « électrifiables » (par exemple dans l’industrie).

Actuellement, au niveau national, les bioénergies représentent de 150 à 170 térawattheures (TWh) par an, soit un peu plus de 10 % de l’énergie finale consommée. Ce chiffre concerne principalement la filière bois, à laquelle s’ajoutent les biocarburants et la filière biogaz. À l’horizon 2050, les prospectives énergétiques prévoient une consommation de plus de 300 de bioénergies, avec une forte croissance dans les secteurs du biométhane (injection du biogaz dans le réseau de gaz après épuration du biométhane) et, dans une moindre mesure, des biocarburants.

La programmation pluriannuelle de l’énergie n°3 (PPE3), qui est en cours de consultation, constitue la feuille de route de la France pour sa transition énergétique, avec des objectifs chiffrés. Pour la filière biométhane, la cible est fixée à 44 TWh/an dès l’horizon 2030 puis jusqu’à 80 TWh/an en 2035, contre une production actuelle de l’ordre de 12 TWh/an. Concernant les biocarburants, la PPE3 prévoit une légère augmentation pour atteindre 50 TWh/an en 2030-2035.

À lire aussi : Avenir énergétique de la France : le texte du gouvernement est-il à la hauteur des enjeux ?

La nécessité d’une biomasse « durable »

L’optimisme quant à nos capacités à cultiver de manière durable les biomasses nécessaires à la production de ces bioénergies n’est cependant plus de mise.

Alors que la deuxième Stratégie nationale bas carbone (SNBC) tablait sur une production de 370 TWh/an de bioénergies en 2050, la nouvelle version SNBC 3 revoit ce chiffre à la baisse à 305 TWh/an. En mai 2025, le rapport des académies d’agriculture et des technologies réduisait ce chiffre à 250 TWh/an.

L’évolution à la baisse de ces chiffres met en lumière l’inadéquation entre les besoins de biomasse pour la transition énergétique, telle qu’elle est actuellement envisagée, et les capacités de production du système agricole actuel.

En novembre 2023, le Secrétariat général à la planification écologique lançait l’alerte, à travers cette formule relayée par le Monde :

« Il y a un problème de bouclage sur la biomasse. »

Ces questionnements ont donné lieu à des échanges entre le ministère de l’agriculture et de la souveraineté alimentaire et l’Inrae autour des enjeux agronomiques, techniques et économiques d’une mobilisation accrue des différents gisements de biomasse et de leur transformation en bioénergies. Ils ont confirmé les difficultés de faire correspondre les besoins pour la transition énergétique et la capacité de production.

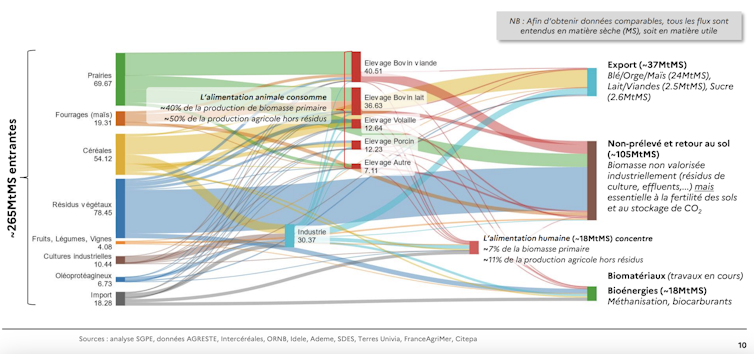

Les flux de biomasse en France

Pour y voir plus clair sur les enjeux et les leviers disponibles, il convient d’analyser plus globalement les flux de biomasses agricoles à l’échelle nationale.

Environ 245 millions de tonnes de matière sèche (MtMS) sont produits chaque année pour des usages primaires (directs) et secondaires (indirects). Ces usages se répartissent comme suit :

Environ 100-110 MtMS sont mobilisés pour l’alimentation animale et finalement la production de denrées alimentaires telles que le lait, la viande, les œufs.

Quelque 70-80 MtMS/an retournent directement au sol (résidus de cultures, fourrages et prairies), auxquels s’ajoutent environ 30 MtMS/an de flux secondaires principalement issus de l’élevage sous forme d’effluents (lisier, fumier, digestat…).

Environ 50-55 MtMS/an sont utilisés directement pour la production de denrées alimentaires humaines (dont plus de la moitié est exportée).

Et 9 MtMS/an servent à la production d’énergie (biocarburant et biogaz) auxquels s’agrègent environ 9MtMS/an de flux secondaires provenant de l’élevage et de l’industrie agroalimentaire (lisier, fumier, biodéchets…).

À échéance 2050, les besoins supplémentaires en biomasses pour les bioénergies s’établissent entre 30 et 60 MtMS/an.

Les dilemmes pour répondre à ces besoins accrus

Tous les acteurs s’accordent sur le fait qu’il n’est pas concevable de rediriger des ressources utilisables – et actuellement utilisées pour l’alimentation humaine – vers des usages énergétiques.

Il apparaît dès lors tentant de rediriger la biomasse qui retourne actuellement au sol. Pourtant, ces flux de biomasse sont essentiels à la santé, qualité et à la fertilité des sols. Ils participent à la lutte contre le changement climatique à travers leur contribution au stockage (ou à la limitation du déstockage) de carbone dans les sols.

Une autre piste, pour répondre à ces besoins croissants, serait d’augmenter la production primaire de biomasse à travers le développement et la récolte de cultures intermédiaires appelées « cultures intermédiaires à vocation énergétique » (CIVE). Celles-ci sont cultivées entre deux cultures principales.

Toutefois, une telle production supplémentaire de biomasse implique l’utilisation de ressources supplémentaires (nutriments, eau, produits phytosanitaires). Elle tend aussi à accroître les risques de transferts de pollution vers la biosphère.

Mobiliser trop fortement ces leviers pourrait donc s’avérer contreproductif. Les alertes s’accumulent à ce sujet. Ces leviers sont donc à actionner avec parcimonie.

Une autre piste, conceptualisée dans plusieurs scénarios de transition, serait de rediriger une partie de la biomasse actuellement utilisée pour nourrir les animaux d’élevage vers la production énergétique.

Ceci impliquerait à la fois une diminution des cheptels et une extensification des élevages afin de préserver leurs services écosystémiques rendus, tout en minimisant leur consommation de biomasse. Cela répondrait à l’enjeu de réduction des émissions de gaz à effet de serre de l’agriculture et serait donc le plus cohérent pour affronter les enjeux écologiques.

Ce scénario requiert toutefois des changements d’envergure dans nos habitudes alimentaires, avec une réduction de notre consommation de produits animaux pour éviter une augmentation des importations.

Vers des politiques publiques coordonnées et cohérentes ?

Après deux ans de retard et de blocages dans les ministères, la stratégie nationale pour l’alimentation, la nutrition et le climat ne semble malheureusement pas à la hauteur de cette problématique. En témoigne l’absence d’objectif chiffré sur la réduction de la consommation de produits animaux, voire la disparition du terme de réduction dans les dernières versions.

De même, les lois récentes d’orientation agricole et Duplomb renforcent l’orientation productiviste de l’agriculture, tout en minimisant les enjeux de transition. Ceci va à l’encontre (au moins partiellement) des orientations nécessaires pour la transition énergétique et la SNBC 3, sans parler des antagonismes avec la stratégie nationale biodiversité.

La France ne manque donc pas de stratégies, mais d’une cohérence globale entre elles. C’est bien cela qui conduit à un découragement des responsables de l’élaboration et la mise en œuvre des politiques publiques et à une adhésion insuffisante des citoyens à ces stratégies.

Il y a donc urgence à développer une vision et des politiques publiques intersectorielles cohérentes et complémentaires englobant l’énergie, l’agriculture, l’environnement, l’alimentation et la santé.

Fabrice Beline a reçu des financements de l’Ademe (projet ABMC) et de GRDF (projet MethaEau).

21.01.2026 à 16:19

Quel textile choisir pour avoir chaud tout en limitant l’impact environnemental ?

Texte intégral (2773 mots)

Au cœur de l’hiver, la quête du pull-over parfait peut parfois sembler bien compliquée. Trouver un textile chaud, qui n’endommage pas l’environnement, qui soit confortable… Les critères s’accumulent. Tâchons d’y voir plus clair.

Avoir chaud en hiver tout en limitant son impact environnemental peut sembler un défi. Chercher à avoir des vêtements nous protégeant au mieux du froid est certes un levier efficace pour réduire sa consommation d’énergie, comme le montrent des initiatives telles que le mouvement Slow Heat et d’autres expérimentations récentes.

Toutefois, cette démarche se heurte à une contradiction de taille : le secteur textile reste parmi les plus polluants au monde, avec des émissions de gaz à effet de serre importantes et une contribution notable aux microplastiques marins.

Alors, quelles matières tiennent vraiment chaud tout en respectant davantage l’environnement ? Si les fibres naturelles sont souvent mises en avant pour leur bonne isolation et leur fin de vie plus respectueuse de l’environnement, leur impact réel dépend largement de la manière dont elles sont produites et utilisées. Pour y voir plus clair, commençons par comprendre ce qui fait qu’un textile tient chaud.

La fabrication du textile tout aussi importante que la fibre

La capacité d’un textile à tenir chaud dépend moins de la fibre utilisée que de l’air qu’elle parvient à enfermer. En restant immobile dans de minuscules espaces au cœur du tissu, cet air limite les échanges de chaleur, un peu comme dans une couette ou un double vitrage. Plus un tissu est épais, duveteux ou poreux, plus il limite les échanges de chaleur.

Cette capacité dépend beaucoup de la structure des fibres et de la manière dont le textile est fabriqué. Les fibres frisées ou ondulées comme la laine de mouton créent des poches où l’air reste piégé. D’autres fibres comme l’alpaga (un camélidé des Andes proche du lama) ou le duvet synthétique sont partiellement creuses, augmentant encore la capacité isolante. De même, les tricots et mailles, plus lâches, isolent mieux que les tissages serrés. Ainsi, la chaleur d’un vêtement dépend autant de sa construction que de sa matière.

C’est sur ces mêmes principes physiques que reposent les fibres synthétiques. En effet, le polyester, l’acrylique, le polaire imitent en partie la laine par leur structure volumineuse et leur capacité à emprisonner de l’air, soit grâce à des fibres frisées, soit grâce à des fibres creuses ou texturées.

Ainsi, ces textiles offrent une bonne isolation thermique, sont légers et sèchent rapidement, ce qui les rend très populaires pour le sport et l’outdoor. En revanche, leur faible respirabilité intrinsèque et leur capacité limitée à absorber l’humidité peuvent favoriser la transpiration et la sensation d’humidité lors d’efforts prolongés. D’autre part, contrairement aux fibres naturelles, ces matériaux sont inflammables, un aspect souvent négligé, mais qui constitue un enjeu réel de sécurité.

Elles ont également un coût environnemental élevé. Issues du pétrole, non biodégradables et fortement consommatrices d’énergie, ces fibres libèrent à chaque lavage des microfibres plastiques dans l’eau, contribuant à la pollution marine. On estime qu’entre 16 % et 35 % des microplastiques marins proviennent de ces textiles, soit de 200 000 à 500 000 tonnes par an. Ces impacts surpassent largement ceux des fibres naturelles, ce qui constitue un vrai défi pour une mode plus durable.

Les bénéfices de la laine de mouton mérinos et de l’alpaga

Face à ces limites, les fibres naturelles apparaissent donc souvent comme des alternatives intéressantes, à commencer par la laine de mouton, longtemps considérée comme une référence en matière d’isolation thermique.

La laine possède en effet une structure complexe et écailleuse : chaque fibre est frisée et forme de multiples micro-poches d’air, réduisant ainsi la perte de chaleur corporelle. Même lorsqu’elle absorbe un peu d’humidité, l’air reste piégé dans sa structure, ce qui lui permet de continuer à isoler efficacement. Cette organisation particulière explique aussi pourquoi la laine est respirante et capable de réguler l’humidité sans donner une sensation de froid. Cependant, ces mêmes fibres peuvent parfois provoquer une sensation de « grattage » pour certaines personnes : plus les fibres sont épaisses, plus elles stimulent les récepteurs de la peau et provoquent des picotements. Il s’agit d’un phénomène purement sensoriel, et non d’une allergie.

Parmi les différents types de laines, la laine de mouton mérinos, issue d’une race d’ovin originaire d’Espagne se distingue par la finesse de ses fibres, nettement plus fines que celles de la laine classique (de 11 à 24 microns pour le mérinos et de 25 à 40 microns pour la laine classique) . Cette caractéristique réduit fortement les sensations d’irritation au contact de la peau et améliore le confort.

Elle favorise également la formation de nombreuses micro-poches d’air isolantes, tout en maintenant une excellente respirabilité. Ces qualités expliquent son usage croissant dans les sous-couches et vêtements techniques, aussi bien pour le sport que pour le quotidien.

Pour autant, la laine n’est pas exempte d’impact environnemental. Bien qu’elle soit renouvelable et biodégradable, son élevage contribue aux émissions de gaz à effet de serre, principalement via le méthane produit par les moutons et la gestion des pâturages. On estime qu’entre 15 et 35 kg de CO₂ équivalent sont émis pour produire 1 kg de laine brute, et qu’environ 10 000 litres d’eau sont nécessaires, selon le mode d’élevage. Le bien-être animal et les pratiques agricoles, comme le mulesing ou l’intensification des pâturages, jouent également un rôle déterminant dans l’empreinte globale de cette fibre.

D’autres fibres animales, comme l’alpaga, suscitent un intérêt croissant en raison de propriétés thermiques comparables, voire supérieures, associées à un meilleur confort. Les fibres d’alpaga sont en effet partiellement creuses, ce qui leur permet de piéger efficacement l’air et de limiter les pertes de chaleur, tout en restant légères. Contrairement à certaines laines plus grossières, elles ne grattent pas, ce qui les rend agréables à porter directement sur la peau.

Elles sont également plus longues et plus fines que la laine classique, avec une bonne capacité de régulation de l’humidité et un séchage plus rapide. Ces caractéristiques expliquent l’essor de l’alpaga dans les vêtements techniques comme dans les pièces haut de gamme, des sous-couches aux manteaux. Sur le plan environnemental, l’alpaga présente aussi certains avantages. En effet, l’élevage d’alpagas exerce généralement une pression moindre sur les écosystèmes : animaux plus légers, consommation alimentaire plus faible, émissions de méthane réduites et dégradation limitée des sols comparativement à l’élevage ovin. Là encore, la durabilité dépend largement du respect de systèmes extensifs et adaptés aux milieux locaux.

Le succès des fibres synthétiques

Malgré les nombreux atouts de ces textiles naturels, les fibres synthétiques restent donc très utilisées, notamment pour leurs performances techniques. Mais leur succès est aussi lié à des facteurs économiques et pratiques : elles sont généralement moins coûteuses, très abondantes dans le commerce, et faciles à transformer en vêtements de masse. Ces aspects rendent le synthétique accessible et pratique pour une large partie des consommateurs, ce qui explique en partie sa prédominance dans l’industrie textile, indépendamment des préférences individuelles.

Polaire, duvet synthétique ou fibres techniques offrent une isolation thermique efficace, tout en étant légères et rapides à sécher, des qualités particulièrement recherchées dans les vêtements de sport et d’outdoor. La conductivité thermique est une mesure de la capacité d’un matériau à conduire la chaleur : plus cette valeur est faible, moins la chaleur passe facilement à travers le matériau, ce qui signifie une meilleure capacité à retenir la chaleur dans un textile donné.

Des mesures de conductivité thermique montrent par exemple que certains isolants synthétiques comme la polaire présentent des valeurs très basses (0,035-0,05 watt par mètre-kelvin (W/m·K)), indiquant une excellente capacité à retenir la chaleur. Pour comparaison, la laine, lorsqu’elle est compacte ou densifiée, peut atteindre 0,16 W/m·K, mais dans les textiles isolants volumineux, elle reste faible (0,033–0,045 W/m·K).

Toutefois, l’origine fossile, la non-biodégradabilité, la libération de microplastiques et un recyclage encore très limité font des textiles synthétiques des matériaux à fort impact environnemental.

Le pull en laine qui gratte, un préjugé qui colle à la peau

À l’inverse, si les fibres naturelles sont parfois boudées, ce n’est pas toujours pour des raisons environnementales, mais souvent pour des questions de confort. Une personne ayant déjà porté un vêtement en fibres naturelles qui lui a paru inconfortable ou irritant peut développer un rejet global de ces fibres, au profit du synthétique, même lorsque des alternatives plus douces existent.

Or, des solutions sont disponibles : privilégier des fibres fines comme la laine mérinos, l’alpaga ou le cachemire, recourir à des traitements mécaniques ou enzymatiques pour adoucir les fibres, ou encore combiner différentes fibres naturelles. Le choix doit aussi tenir compte de l’usage du vêtement et de son contact direct avec la peau.

En pratique, choisir un textile chaud et moins polluant relève donc d’un compromis, qui dépend autant de la matière que de l’usage. Une sous-couche portée à même la peau bénéficiera de fibres fines et respirantes, comme la laine mérinos, tandis qu’une couche intermédiaire privilégiera l’isolation et un vêtement extérieur la protection contre l’humidité et le vent.

Enfin, plutôt que de rechercher une matière « parfaite », il est essentiel de raisonner en cycle de vie. Sa durabilité (combien de temps il est porté), sa réparabilité, la fréquence et la manière de le laver, ainsi que sa fin de vie (recyclage, réutilisation, compostage pour les fibres naturelles) influencent largement son impact environnemental total. Un vêtement bien entretenu et durable peut avoir un impact bien moindre qu’un textile « écologique », mais rapidement jeté.

Au final, les matières textiles les plus chaudes et les moins polluantes sont majoritairement naturelles, mais aucune n’est totalement exempte d’impact. La laine mérinos et l’alpaga offrent aujourd’hui un compromis intéressant entre chaleur, confort et fin de vie environnementale. Le rejet des fibres naturelles pour des raisons de grattage mérite d’être nuancé : la qualité et la finesse des fibres font toute la différence. Mieux informer sur ces aspects pourrait encourager des choix plus durables. En textile comme ailleurs, le meilleur choix reste souvent celui que l’on garde longtemps.

Coralie Thieulin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

20.01.2026 à 19:01

Le monde est désormais en « faillite hydrique », selon un rapport de l’ONU

Texte intégral (4581 mots)

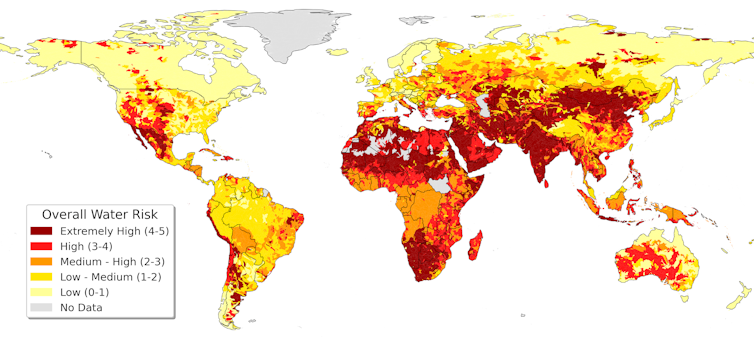

De Téhéran au fleuve Colorado, les signes d’un effondrement durable des ressources en eau se multiplient. La planète consomme aujourd’hui plus d’eau douce qu’elle n’est capable d’en renouveler. Sous l’effet du changement climatique et de décennies de surexploitation, de nombreuses régions du monde ne parviennent plus à se remettre des périodes de manque d’eau. Cette situation, que nous qualifions de « faillite hydrique », est omniprésente : elle touche déjà des milliards de personnes avec des conséquences déjà visibles sur les sociétés, l’agriculture et les écosystèmes.

Le monde utilise aujourd’hui tellement d’eau douce, dans un contexte de changement climatique, qu’il est désormais en situation de « faillite hydrique ». Par là, il faut comprendre que nombreuses régions ne sont plus en mesure de se remettre des pénuries d’eau à mesure que celles-ci deviennent de plus en plus fréquentes.

Environ 4 milliards de personnes, soit près de la moitié de la population mondiale, vivent dans des conditions de grave pénurie d’eau (c’est-à-dire sans accès à une quantité d’eau suffisante pour répondre à tous leurs besoins) pendant au moins un mois par an.

En réalité, beaucoup plus de personnes subissent les conséquences du déficit hydrique : réservoirs asséchés, villes englouties, mauvaises récoltes, rationnement de l’eau, incendies de forêt et tempêtes de poussière dans les régions touchées par la sécheresse.

Les signes de faillite hydrique sont partout, de Téhéran, où les sécheresses et l’utilisation non durable de l’eau ont épuisé les réservoirs dont dépend la capitale iranienne, alimentant les tensions politiques, jusqu’aux États-Unis, où la demande en eau a dépassé les capacités du fleuve Colorado, une source cruciale d’eau potable et d’irrigation pour sept États.

La faillite hydrique n’est pas seulement une métaphore du manque d’eau. Il s’agit d’une situation chronique qui se développe lorsqu’un endroit utilise plus d’eau que la nature ne peut en remplacer de façon fiable, et lorsque les dommages causés aux ressources naturelles qui stockent et filtrent cette eau, comme les aquifères et les zones humides, deviennent difficiles à réparer.